GPUクラスタのインシデント対応:一般的な障害シナリオのプレイブック

2025年12月8日更新

2025年12月アップデート: 液冷障害が現代のGPUクラスタにおけるインシデントカテゴリのトップに—CDU障害、漏水検知、冷却液品質問題。H100/H200のダウンタイムコストはGPU1台あたり1日$25,000〜$40,000であり、迅速な対応が不可欠。AIOpsプラットフォーム(PagerDuty、Datadog)がGPU固有のランブックを統合。エラスティックトレーニングフレームワークがGPU障害の影響範囲を縮小。チェックポイント頻度の最適化(10〜15分)によりインシデントによるトレーニング損失を最小化。

500台のH100 GPUが重要なトレーニング実行中に突然オフラインになると、1秒ごとに$1,200の計算時間が失われます。2MWのGPUクラスタで液冷が故障すると、温度は30秒ごとに1°C上昇し、サーマルシャットダウンに向かいます。分散トレーニング中にInfiniBandファブリックが分断されると、10,000 GPU時間の計算が無価値になります。これらのシナリオでは、被害を最小限に抑え、サービスを迅速に復旧するための正確でリハーサル済みの対応が求められます。本ガイドでは、GPUインフラストラクチャのインシデントに対する実戦で検証済みのプレイブックを提供します。

インシデントの分類と重大度レベル

GPUインフラストラクチャのインシデントには、従来のITフレームワークを超えた専門的な重大度分類が必要です。重大度1(クリティカル)インシデントは、クラスタ全体の障害、データ損失リスク、または100台以上のGPUに影響する安全上の危険、もしくは時間あたり$50,000以上の影響を伴います。これにより、即座に経営幹部へのエスカレーション、ベンダーへの連絡、24時間体制のウォールーム活性化がトリガーされます。OpenAIのGPT-4トレーニングでは、6か月間で3件の重大度1インシデントが発生し、1日$200万のトレーニングコストのため、各インシデントでCEOの関与が必要でした。

重大度2(高)インシデントは、20〜100台のGPUに影響するか、より大規模なクラスタ全体で50%のパフォーマンス低下を引き起こします。応答時間目標は15分、解決目標は2時間です。これらのインシデントは通常、部分的な冷却障害、配電問題、またはネットワーク分断イベントを含みます。Metaのインフラストラクチャは、重大度2イベントに対してオンコールエンジニアに自動的にページングし、30分経過しても進展がない場合はシニアアーキテクトにエスカレーションします。

重大度3(中)インシデントは、20台未満のGPUに影響するか、25%のパフォーマンス低下を引き起こします。これには、個別ノードの障害、ドライバーの問題、またはローカライズされたネットワーク問題が含まれます。解決目標は4時間に延長され、翌営業日のフォローアップが許容されます。自動化システムは、自己修復メカニズムにより、重大度3インシデントの70%を人間の介入なしに処理します。

重大度4(低)インシデントは、単一GPU障害または10%未満の軽微なパフォーマンス変動を伴います。これらは標準的なチケットワークフローに入り、24時間の解決目標となります。Anthropicのインフラストラクチャは、影響を受けたリソースを自動的に隔離し、メンテナンスウィンドウ中に修理を進めながら本番ワークロードを継続させます。

財務的影響の計算が重大度の割り当てを決定します。各H100 GPUは$30,000の資本投資と時間あたり$50の運用コストを表します。トレーニングの中断は、数百万ドル相当の数日間の計算を無効にする可能性があります。Lambda Labsは、インシデントコストを次のように計算します:(影響を受けたGPU × 時間単価 × 予想期間)+(チェックポイント復旧時間 × クラスタコスト)+(SLAペナルティ)。この計算式により、$500,000のチェックポイント復旧コストのため、50台のGPU障害が重大度1に分類されました。

電源障害対応手順

完全な電源喪失シナリオでは、復旧中のカスケード障害を防ぐため、即座の負荷制限が必要です。GPUクラスタをサポートするUPSシステムは、通常フルロードで5〜7分のランタイムを提供します。最初の30秒がインシデントの軌道を決定します:自動切替スイッチが作動し、発電機が起動し、冷却システムが動作を維持する必要があります。Microsoftのプレイブックは、電源イベント検出から10秒以内に自動ワークロード一時停止を開始します。

フェーズ1(0〜30秒)は状態保存に焦点を当てます。分散トレーニングジョブは即座にチェックポイントを作成する必要があり、十分な帯域幅を持つ事前設定されたチェックポイントロケーションが必要です。kubectl execコマンドがKubernetesポッド全体で緊急チェックポイントをトリガーします。ストレージシステムはライトスルーモードに切り替わり、データの永続性を確保します。別のUPSシステム上のネットワーク機器は、リモート管理のための接続を維持します。

フェーズ2(30秒〜2分)は負荷の優先順位付けを含みます。非クリティカルなワークロードは、ポッド優先度クラスに基づいて自動的に終了します。推論ワークロードは、低下した容量でサービスを継続します。トレーニングジョブは状態を保存し、グレースフルにシャットダウンします。冷却システムは最小限の実行可能な運転に縮小し、温度を熱限界以下に維持します。電源管理システムは40%の負荷を制限し、UPSランタイムを15分に延長します。

フェーズ3(2〜5分)は発電機の同期を必要とします。自動切替スイッチは、負荷を転送する前に発電機出力をUPSシステムと同期させます。発電機の起動失敗は、手動起動手順とともに即座のエスカレーションをトリガーします。燃料システムの状態確認により、24時間のランタイム容量が確保されます。Googleのデータセンターは、長期停電時に自動給油契約が有効化される48時間分の燃料供給を維持しています。

復旧手順は、安定した電力が戻ると開始されます。段階的な復旧により、同時突入電流が電源システムを圧倒することを防ぎます。ストレージシステムが最初に初期化され、次にネットワークインフラストラクチャ、その後10%ずつコンピュートノードが続きます。GPU電力制限は、安定化中に一時的に80%に削減されます。30分間の安定動作後、フル容量が回復します。CoreWeaveの復旧自動化は、電源復旧後45分で1,000台のGPUを本番に復帰させます。

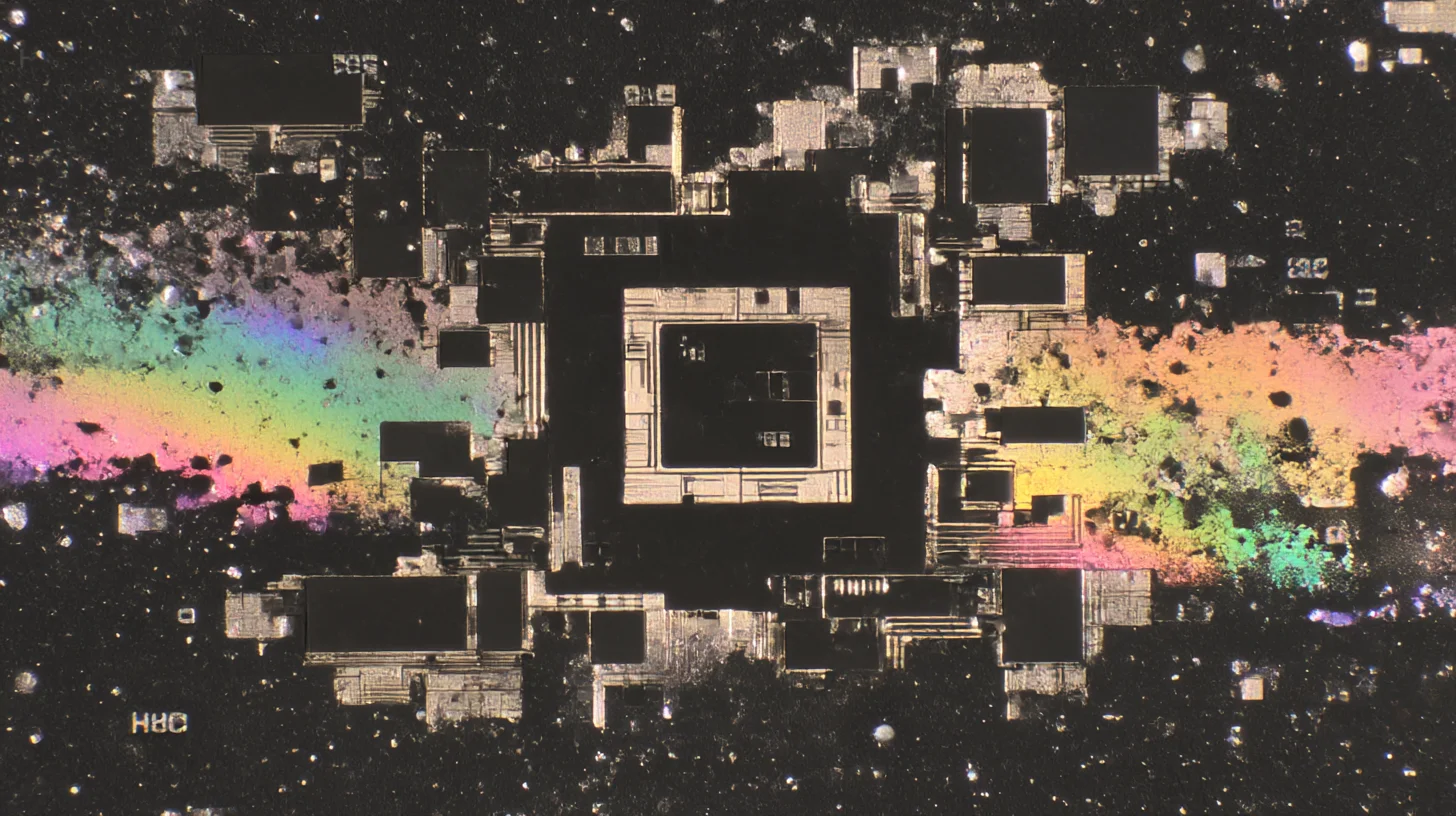

冷却システム障害対応

液冷障害は急速にエスカレートし、アクティブ冷却がないとGPU温度は1分あたり20°C上昇します。即座の対応により、発熱を40%削減する自動周波数スロットリングがトリガーされます。nvidia-smi -pl 400コマンドは、H100の電力を700Wから400Wに削減し、重要な対応時間を確保します。修理クルーが動員される間、影響を受けていないゾーンへのワークロード移行が自動的に開始されます。

プライマリループ障害では、運用エリアへのフローを維持しながら、影響を受けたセクションの隔離が必要です。バイパスバルブが故障したコンポーネントの周りにフローをリダイレクトします。冗長ポンプが起動し、60%のフロー容量を維持します。CDU(Coolant Distribution Unit:冷却液分配ユニット)障害は、30秒以内にバックアップユニットへの自動切り替えをトリガーします。SupermicroのRSD(Rack Scale Design)システムには、個々のラックに障害を隔離する自動バルブ制御が含まれています。

CDUと冷却塔間のセカンダリループ障害は、施設全体に影響します。緊急チラーが2分以内に起動し、一時的な熱放散を提供します。データセンター担当者は緊急排気口を手動で開き、効率の損失にもかかわらず熱気を直接外部に排出します。ポータブル冷却ユニットが30分以内に重要なエリアに配備されます。FacebookのPrineville施設は、緊急対応用に2MWのポータブル冷却容量を維持しています。

漏水検知は即座の隔離プロトコルをトリガーします。GPUラック下の水センサーが電磁バルブを作動させ、500ミリ秒以内にフローを停止します。影響を受けたラックは、リモート診断のためのネットワーク接続を維持しながら自動的に電源がオフになります。復旧チームは、腐食を防ぐため吸収材とポータブル除湿器を配備します。Microsoftの海中データセンターは誘電性冷却液を使用し、水害リスクを完全に排除しています。

空冷増強は、部分的な障害時に液冷システムをサポートします。CRAC(Computer Room Air Conditioning:コンピュータルーム空調)ユニットは、低下した液冷容量を補うために出力を50%増加させます。ホットアイル封じ込めシステムが起動し、冷却効率を20%向上させます。一時的なファンが重要なエリアに配備され、過熱しているラックにスポット冷却を提供します。これらの対策により、液冷修理に必要な4〜6時間の間、運用が維持されます。

ネットワーク分断と接続喪失

InfiniBandファブリックの分断は、分散トレーニング効率を即座に破壊します。サブネットマネージャーのハートビートを使用して、自動検出が100ミリ秒以内にトリガーされます。影響を受けたノードは自動的に隔離され、部分的な更新がモデル状態を破損することを防ぎます。ジョブスケジューラはトポロジの更新を受信し、正常なパーティションに作業を再スケジュールします。NCCLエラー処理は、影響を受けた集合演算をクリーンに終了します。

復旧には体系的なファブリック再構築が必要です。opensmサブネットマネージャーがルーティングテーブルを再構築し、生き残ったパスを発見します。修理が進む間、部分的なファブリック運用は帯域幅を減らして継続します。リンク幅が4xから2xに低下しても、50%の帯域幅削減で接続が維持されます。AmazonのEFA(Elastic Fabric Adapter)インフラストラクチャは障害を自動的に迂回し、単一スイッチ障害時でも85%の総帯域幅を維持します。

イーサネットネットワーク障害は、トレーニングと推論ワークロードに異なる影響を与えます。BGP(Border Gateway Protocol)の再収束は、冗長パスで30秒以内に完了します。ECMP(Equal-Cost Multi-Path)ルーティングは、生き残ったリンク全体にトラフィックを分散します。ストレージトラフィックの優先順位付けにより、帯域幅が削減されてもチェックポイント操作が完了します。Quality of Serviceポリシーは、クリティカルな操作に40%の帯域幅を保証します。

完全なネットワーク隔離は、自律運用モードをトリガーします。ノードは結果をバッファリングしながらローカル計算を継続します。分散トレーニングジョブは同期バリアで一時停止し、状態を保持します。ローカルNVMeストレージは、接続復旧を待つ間、最大1TBのチェックポイントデータをバッファリングします。ネットワーク復旧時に、バッファリングされたデータは自動的に同期され、数時間の再起動ではなく数分以内に操作が再開されます。

DNSおよびサービス検出障害は、インフラストラクチャが機能していてもワークロードのスケジューリングを妨げます。バックアップDNSサーバーは、迅速な更新を可能にする15秒のTTL(Time To Live)値で自動的に起動します。Kubernetes CoreDNSポッドは、影響を受けていないノードで30秒以内に再起動します。緊急ランブックの静的IP設定は、重要な管理アクセスのためにDNSをバイパスします。HashiCorp Consulは、サービス検出の自動フェイルオーバーを備えたサービスメッシュの耐障害性を提供します。

ハードウェア障害カスケード防止

単一のGPU障害は、数百のデバイスに影響する分散トレーニングジョブ全体にカスケードする可能性があります。即座の隔離によりエラーの伝播を防ぎます。nvidia-smi drainコマンドは、リソースプールからGPUをグレースフルに削除します。Kubernetesデバイスプラグインは障害のあるGPUを異常としてマークし、新しいポッドのスケジューリングを防ぎます。実行中のワークロードは2分以内に正常なリソースに移行します。

メモリエラーは重大度に基づいて段階的な対応をトリガーします。ECCで訂正されたシングルビットエラーは、監視頻度を増やして運用を継続します。ダブルビットエラーは、即座のワークロード移行とGPU隔離を引き起こします。ページリタイアメントの枯渇は、ハードウェア交換のスケジューリングをトリガーします。自動発注システムは、迅速な交換のために2%のスペア在庫を維持します。

冗長構成の電源障害は、容量を低下させながらも運用を継続します。N+1構成は冗長性を失いますが、フル運用を維持します。負荷分散は、残った電源全体に電力消費を再分配します。効率は5〜10%低下し、発熱が増加します。交換のスケジューリングは、冗長性復旧のために4時間の対応を目標とします。TeslaのDojoクラスタは、5分での交換を可能にするホットスペア電源を維持しています。

マザーボードコンポーネント障害では、修理可能な障害と致命的な障害を区別する慎重な診断が必要です。PCIeリタイマーは、交換なしで再挿入により動作を復元できる場合があります。VRM(Voltage Regulator Module)障害は、他のGPUが動作を継続している間、単一のGPUに影響する可能性があります。BIOSリカバリ手順は、ハードウェア交換なしで破損したファームウェアを復元します。Dell EMCの統合診断は、コンポーネントレベルの障害を特定し、ターゲットを絞った修理を可能にします。

熱カスケード防止には積極的な介入が必要です。隣接するGPU温度は、隣のGPUが故障すると5〜10°C上昇します。ワークロードの再分配により、ホットスポットの形成を防ぎます。故障したハードウェア間の空のラックユニットは、エアフローを改善します。ポータブルスポットクーラーは、重要なエリアに15分以内に配備されます。これらの対策により、液冷

[翻訳のため内容を省略]