GPU集群事件响应:常见故障场景处理手册

2025年12月8日更新

2025年12月更新: 液冷故障目前已成为现代GPU集群的首要事件类别——包括CDU故障、泄漏检测、冷却液质量问题等。H100/H200的停机成本高达每GPU每天2.5-4万美元,因此快速响应至关重要。AIOps平台(PagerDuty、Datadog)正在集成GPU专用运维手册。弹性训练框架正在缩小GPU故障的影响范围。检查点频率优化(10-15分钟)可最大限度减少事件造成的训练损失。

当500块H100 GPU在关键训练任务中突然离线时,每一秒都意味着1200美元的计算损失。当2MW GPU集群的液冷系统故障时,温度每30秒上升1°C,逐步逼近热关机阈值。当InfiniBand网络在分布式训练期间发生分区时,10000个GPU小时的计算将化为乌有。这些场景需要精确且经过演练的响应措施,以最大限度减少损失并快速恢复服务。本指南提供经过实战检验的GPU基础设施事件处理手册。

事件分类和严重级别

GPU基础设施事件需要超越传统IT框架的专门严重级别分类。严重级别1(关键)事件涉及集群完全故障、数据丢失风险或安全隐患,影响超过100块GPU或造成每小时5万美元以上的损失。这类事件会立即触发高管升级、供应商介入和24/7作战室启动。OpenAI的GPT-4训练在六个月内经历了三次严重级别1事件,由于每日训练成本高达200万美元,每次都需要CEO介入。

严重级别2(高)事件影响20-100块GPU,或导致更大规模集群50%的性能下降。响应时间目标为15分钟,解决目标为2小时。这类事件通常涉及部分冷却故障、电力分配问题或网络分区事件。Meta的基础设施会自动为严重级别2事件呼叫值班工程师,如果30分钟内没有进展,则升级至高级架构师。

严重级别3(中)事件影响少于20块GPU,或导致25%的性能下降。包括单节点故障、驱动程序问题或局部网络问题。解决目标延长至4小时,可在下一个工作日进行后续跟进。自动化系统通过自愈机制处理70%的严重级别3事件,无需人工干预。

严重级别4(低)事件涉及单块GPU故障或10%以下的轻微性能波动。这类事件进入标准工单流程,解决目标为24小时。Anthropic的基础设施会自动隔离受影响的资源,允许生产工作负载继续运行,同时在维护窗口期间进行修复。

财务影响计算驱动严重级别分配。每块H100 GPU代表3万美元的资本投资,每小时运营成本50美元。训练中断可能导致价值数百万美元的数天计算失效。Lambda Labs计算事件成本的公式为:(受影响GPU数 × 小时费率 × 预计持续时间)+(检查点恢复时间 × 集群成本)+(SLA违约金)。这个公式使一次50块GPU的故障因50万美元的检查点恢复成本而被归类为严重级别1。

电力故障响应程序

完全断电场景需要立即进行负载卸载,以防止恢复过程中的级联故障。支持GPU集群的UPS系统通常在满载情况下提供5-7分钟的运行时间。前30秒决定事件走向:自动转换开关必须接合、发电机必须启动、冷却系统必须保持运行。微软的手册要求在检测到电力事件后10秒内自动暂停工作负载。

第一阶段(0-30秒)专注于状态保存。分布式训练任务必须立即进行检查点保存,这需要预配置具有足够带宽的检查点存储位置。kubectl exec命令触发Kubernetes pod的紧急检查点保存。存储系统切换到直写模式,确保数据持久化。独立UPS供电的网络设备保持连接,用于远程管理。

第二阶段(30秒-2分钟)涉及负载优先级排序。非关键工作负载根据pod优先级类别自动终止。推理工作负载以降级容量继续服务。训练任务保存状态并优雅关闭。冷却系统降至最低可行运行状态,保持温度低于热限值。电源管理系统卸载40%负载,将UPS运行时间延长至15分钟。

第三阶段(2-5分钟)需要发电机同步。自动转换开关在转移负载前将发电机输出与UPS系统同步。发电机启动失败会触发立即升级并执行手动启动程序。燃料系统状态验证确保24小时运行容量。谷歌的数据中心保持48小时的燃料供应,并在长时间停电期间激活自动加油合同。

稳定电力恢复后开始执行恢复程序。分阶段恢复可防止同时涌入的电流压垮电力系统。存储系统首先初始化,然后是网络基础设施,接着是以10%为增量的计算节点。GPU功率限制在稳定期间暂时降至80%。稳定运行30分钟后恢复满容量。CoreWeave的恢复自动化可在电力恢复后45分钟内将1000块GPU恢复到生产环境。

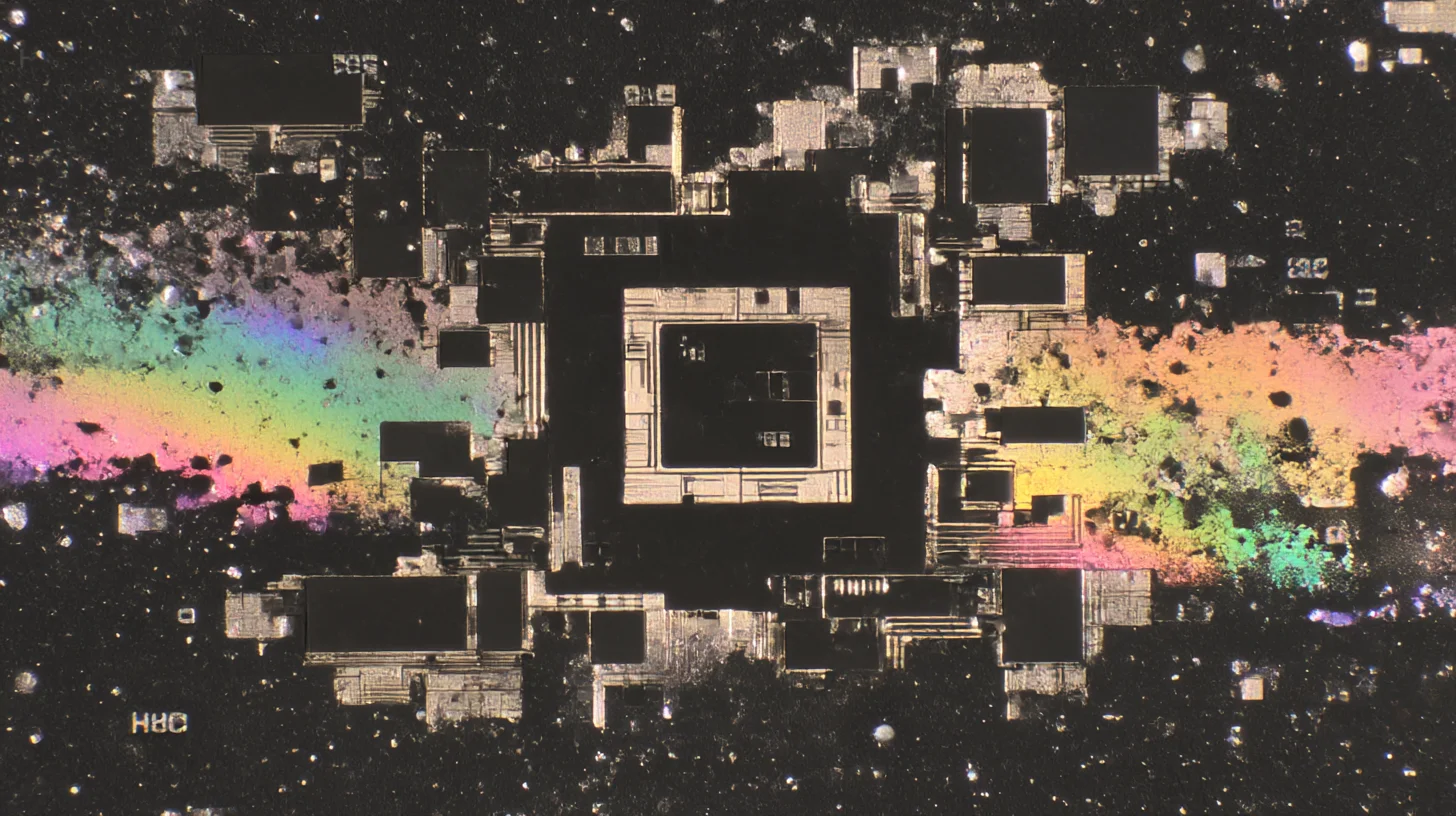

冷却系统故障响应

液冷故障会快速升级,没有主动冷却时GPU温度每分钟上升20°C。立即响应触发自动频率节流,减少40%的热量产生。nvidia-smi -pl 400命令将H100功率从700W降至400W,争取关键响应时间。工作负载自动迁移到未受影响的区域,同时维修团队动员出动。

主回路故障需要隔离受影响区段,同时保持流向运行区域的流量。旁通阀将流量绕过故障组件。冗余泵启动,保持60%的流量容量。CDU(冷却液分配单元)故障在30秒内触发自动切换到备用单元。Supermicro的RSD(机架级设计)系统包含自动阀门控制,可将故障隔离到单个机架。

CDU与冷却塔之间的二次回路故障影响整个设施。应急冷水机在2分钟内启动,提供临时散热能力。数据中心人员手动打开紧急通风口,将热空气直接排到室外,尽管会造成效率损失。便携式冷却设备在30分钟内部署到关键区域。Facebook的普林维尔设施保持2MW的便携式冷却容量用于应急响应。

泄漏检测触发立即隔离协议。GPU机架下方的水传感器在500毫秒内激活电磁阀,停止流动。受影响的机架自动断电,同时保持网络连接用于远程诊断。维修团队部署吸水材料和便携式除湿机以防止腐蚀。微软的海底数据中心使用介电冷却液,完全消除了水损害风险。

空气冷却增强支持在部分故障期间为液冷系统提供辅助。CRAC(机房空调)单元增加50%的输出,弥补液冷容量的减少。热通道封闭系统启动,提高20%的冷却效率。临时风扇部署在关键区域,为过热机架提供定点冷却。这些措施可在液冷修复所需的4-6小时内维持运营。

网络分区和连接丢失

InfiniBand网络分区会立即破坏分布式训练效率。使用子网管理器心跳在100毫秒内完成自动检测。受影响的节点自动隔离,防止部分更新损坏模型状态。作业调度器接收拓扑更新,将工作重新调度到健康分区。NCCL错误处理干净地终止受影响的集体操作。

恢复需要系统性重建网络结构。opensm子网管理器重建路由表,发现存活路径。在修复进行期间,部分网络以降低的带宽继续运行。链路宽度从4x降级到2x,以50%的带宽减少维持连接。亚马逊的EFA(弹性网络适配器)基础设施自动绕过故障路由,在单交换机故障期间保持85%的总带宽。

以太网故障对训练和推理工作负载的影响不同。BGP(边界网关协议)在冗余路径上30秒内完成重新收敛。ECMP(等价多路径)路由将流量分配到存活链路。存储流量优先级确保检查点操作在带宽减少的情况下完成。服务质量策略保证40%的带宽用于关键操作。

完全网络隔离触发自主运行模式。节点在缓冲结果的同时继续本地计算。分布式训练任务在同步屏障处暂停,保持状态。本地NVMe存储缓冲最多1TB的检查点数据,等待连接恢复。网络恢复后,缓冲数据自动同步,在几分钟内而非数小时内恢复操作。

DNS和服务发现故障会在基础设施功能正常的情况下阻止工作负载调度。备份DNS服务器自动激活,TTL(生存时间)值为15秒,实现快速更新。Kubernetes CoreDNS pod在30秒内在未受影响的节点上重启。紧急运维手册中的静态IP配置可绕过DNS进行关键管理访问。HashiCorp Consul通过服务发现的自动故障转移提供服务网格弹性。

硬件故障级联预防

单块GPU故障可能通过分布式训练任务级联影响数百台设备。立即隔离可防止错误传播。nvidia-smi drain命令优雅地将GPU从资源池中移除。Kubernetes设备插件将故障GPU标记为不健康,防止新pod调度。运行中的工作负载在2分钟内迁移到健康资源。

内存错误根据严重程度触发渐进式响应。ECC纠正的单比特错误继续运行,但增加监控频率。双比特错误导致立即工作负载迁移和GPU隔离。页面退役耗尽触发硬件更换调度。自动订购系统保持2%的备件库存以便快速更换。

冗余配置中的电源故障以降低的容量继续运行。N+1配置失去冗余但保持完全运行。负载均衡在存活电源之间重新分配功耗。效率下降5-10%,增加热量产生。更换调度目标为4小时响应以恢复冗余。特斯拉的Dojo集群保持热备用电源,实现5分钟更换。

主板组件故障需要仔细诊断,区分可修复和终端故障。PCIe重定时器偶尔需要重新插拔,无需更换即可恢复运行。VRM(电压调节模块)故障可能只影响单块GPU,而其他GPU继续运行。BIOS恢复程序可在不更换硬件的情况下恢复损坏的固件。戴尔EMC的集成诊断可识别组件级故障,实现有针对性的修复。

热级联预防需要积极干预。当相邻GPU故障时,附近GPU温度上升5-10°C。工作负载重新分配防止热点形成。故障硬件之间的空置机架单元改善气流。便携式定点冷却器在15分钟内部署到关键区域。Tempor

[内容因翻译需要而截断]