El CEO de NVIDIA, Jensen Huang, lanzó una bomba en GTC 2025, haciendo que los equipos de infraestructura corrieran por sus calculadoras: la plataforma Vera Rubin llevará los racks de centros de datos a 600 kilovatios para 2027.¹ El anuncio marca un cambio fundamental en cómo operan los centros de datos, forzando una reconceptualización completa de la distribución de energía, sistemas de refrigeración e infraestructura física que ha permanecido esencialmente sin cambios durante décadas.

La plataforma Vera Rubin representa el salto más ambicioso de NVIDIA hasta ahora. Este sistema multicomponente combina el CPU personalizado Vera, la GPU de próxima generación Rubin y el acelerador especializado Rubin CPX (Context Processing eXtension), diseñado específicamente para cargas de trabajo de AI de un millón de tokens.² A diferencia de las mejoras incrementales típicas de las generaciones de GPU, la variante Vera Rubin NVL144 CPX ofrece 7.5x el rendimiento de AI de los sistemas actuales Blackwell GB300, mientras cambia fundamentalmente cómo se empaquetan, refrigeran y despliegan las GPU.³

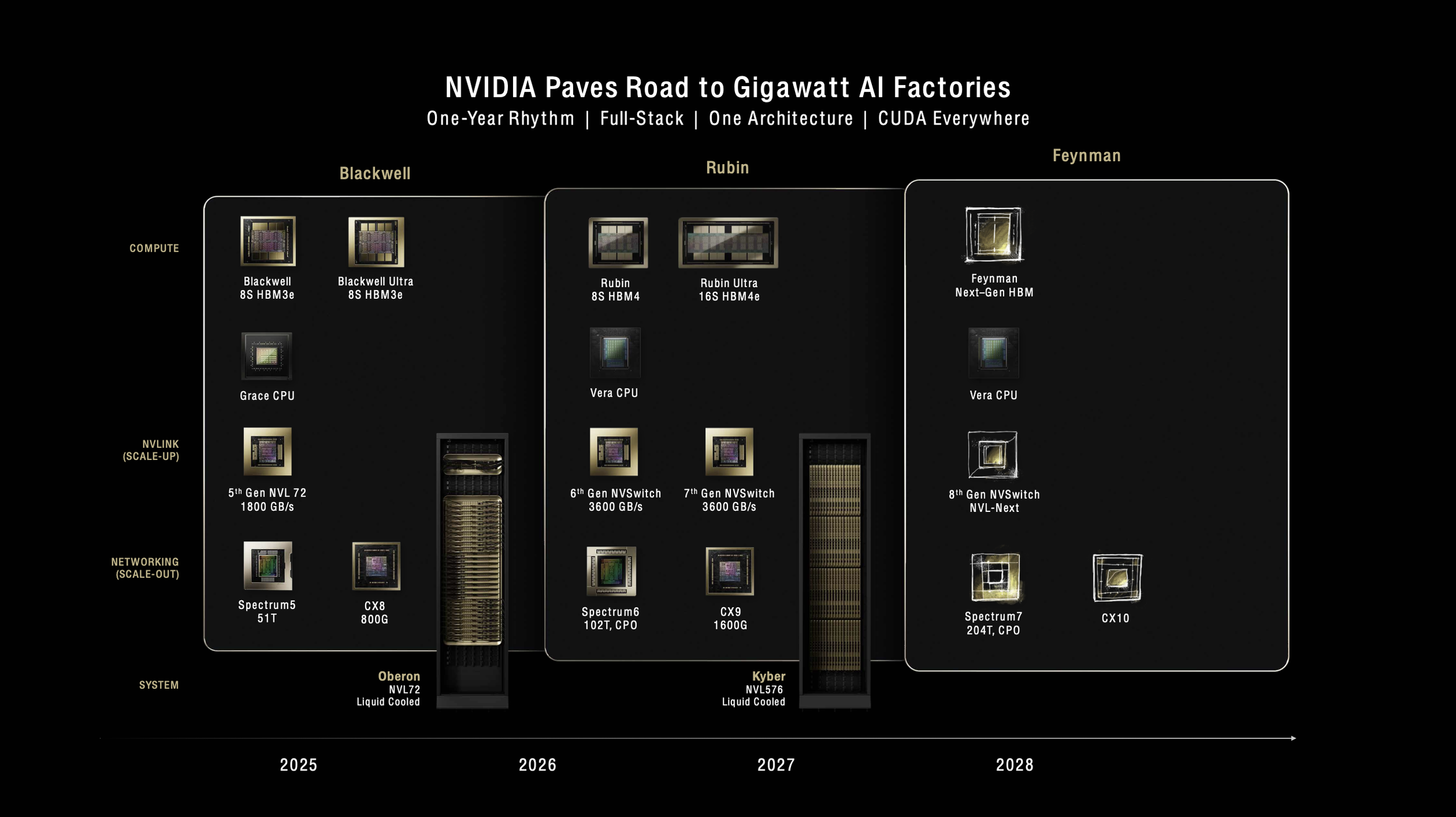

"Somos la primera empresa tecnológica en la historia que anunció cuatro generaciones de algo", explicó Huang a Data Center Dynamics, presentando la hoja de ruta de NVIDIA hasta 2028.⁴ La transparencia cumple un propósito crítico: dar a los proveedores de infraestructura, operadores de centros de datos el tiempo necesario para prepararse para lo que equivale a una reimaginación completa de la infraestructura de AI.

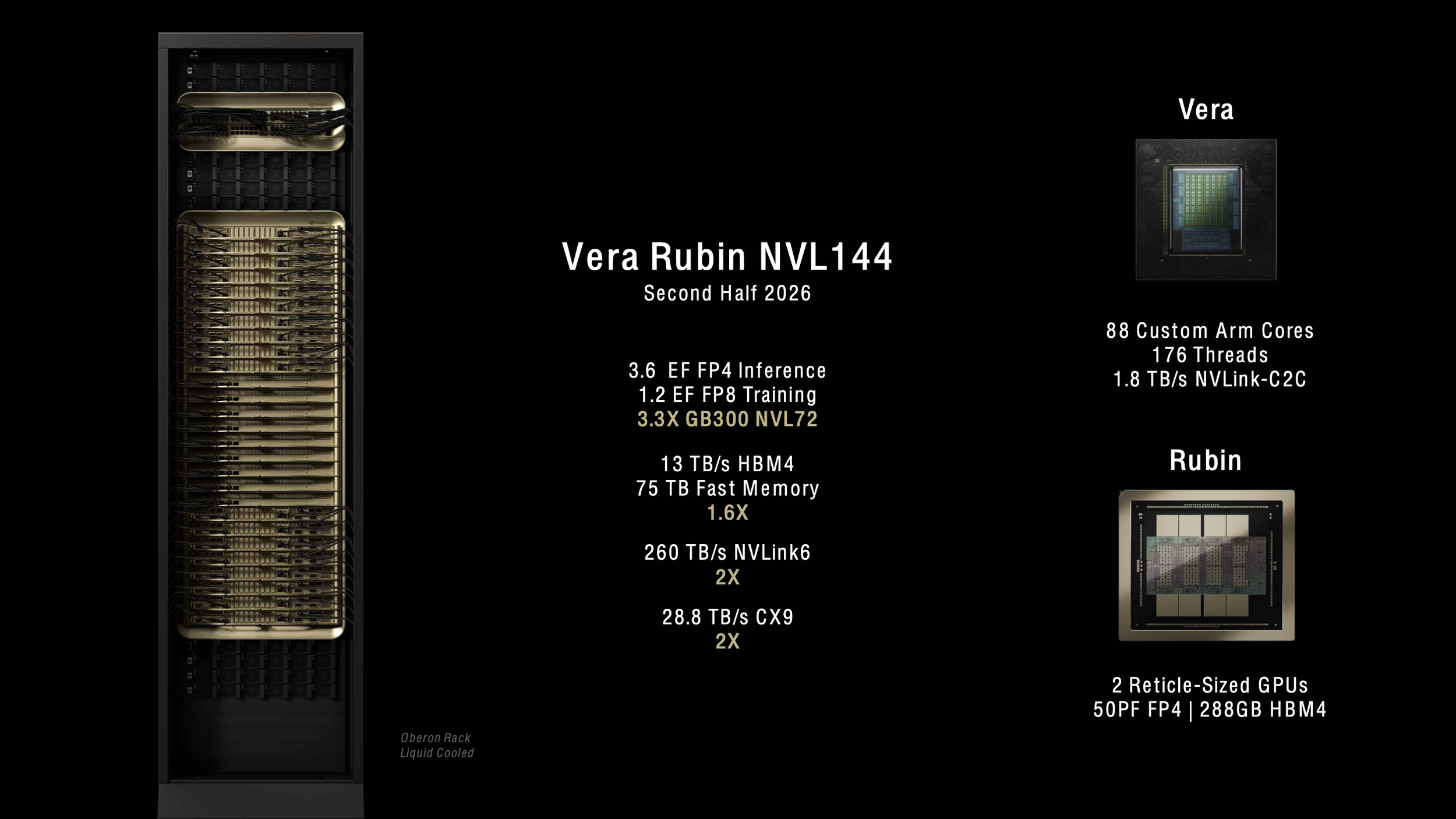

[caption id="" align="alignnone" width="2522"] Las especificaciones de la plataforma NVIDIA Vera Rubin NVL144 muestran 3.6 exaflops de rendimiento de inferencia FP4 y una mejora de 3.3x sobre GB300 NVL72, llegando en la segunda mitad de 2026. [/caption]

Las especificaciones de la plataforma NVIDIA Vera Rubin NVL144 muestran 3.6 exaflops de rendimiento de inferencia FP4 y una mejora de 3.3x sobre GB300 NVL72, llegando en la segunda mitad de 2026. [/caption]

La revolución de la arquitectura comienza con silicio personalizado.

[caption id="" align="alignnone" width="2520"] La hoja de ruta completa de NVIDIA desde Blackwell hasta Feynman, mostrando la evolución desde Oberon hasta las arquitecturas de rack Kyber que soportan hasta 600kW de consumo de energía. [/caption]

La hoja de ruta completa de NVIDIA desde Blackwell hasta Feynman, mostrando la evolución desde Oberon hasta las arquitecturas de rack Kyber que soportan hasta 600kW de consumo de energía. [/caption]

El CPU Vera marca la salida de NVIDIA de los diseños ARM estándar, presentando 88 núcleos ARM personalizados con multithreading simultáneo, que habilita 176 procesadores lógicos.⁵ NVIDIA llama a los núcleos personalizados "Olympus", y el diseño ofrece el doble del rendimiento del CPU Grace usado en los sistemas Blackwell actuales.⁶ Cada CPU Vera se conecta a las GPU Rubin a través de una interfaz NVLink C2C de 1.8 TB/s, permitiendo un ancho de banda sin precedentes entre elementos de cómputo.⁷

La GPU Rubin estándar empuja los límites con 288GB de memoria HBM4 por paquete, manteniendo la misma capacidad que el Blackwell Ultra B300 pero incrementando de 8 TB/s a 13 TB/s de ancho de banda de memoria.⁸ Cada paquete Rubin contiene dos dies de GPU limitados por retícula, aunque NVIDIA ha cambiado su metodología de conteo—lo que Blackwell llamaba una GPU (dos dies), Rubin lo llama dos GPU.⁹ El cambio refleja la creciente complejidad de las arquitecturas multi-die y ayuda a los clientes a entender mejor los recursos de cómputo reales en cada sistema.

El elemento más innovador llega en forma del Rubin CPX, un acelerador construido específicamente para procesamiento de contexto masivo. El diseño monolítico ofrece 30 petaFLOPs de cómputo NVFP4 con 128GB de memoria GDDR7 eficiente en costos, optimizada específicamente para mecanismos de atención en modelos transformer.¹⁰ El CPX logra capacidades de atención 3x más rápidas comparado con sistemas GB300 NVL72, permitiendo que los modelos de AI procesen contextos de millones de tokens—equivalente a una hora de video o bases de código completas—sin degradación del rendimiento.¹¹

El despliegue demanda una revisión completa de la infraestructura.

El sistema estándar Vera Rubin NVL144, programado para llegar en la segunda mitad de 2026, mantiene compatibilidad con la infraestructura existente GB200/GB300, utilizando la arquitectura de rack Oberon familiar.¹² El sistema empaqueta 144 dies de GPU (72 paquetes), 36 CPU Vera, y ofrece 3.6 exaFLOPS de rendimiento de inferencia FP4—una mejora de 3.3x sobre Blackwell Ultra.¹³ El consumo de energía se mantiene manejable en aproximadamente 120-130kW por rack, similar a los despliegues actuales.

La variante Vera Rubin NVL144 CPX lleva el rendimiento más lejos, integrando 144 GPU Rubin CPX junto con 144 GPU Rubin estándar y 36 CPU Vera para ofrecer ocho exaFLOPs de cómputo NVFP4—esa mejora de 7.5x sobre GB300 NVL72—con 100TB de memoria de alta velocidad y 1.7 PB/s de ancho de banda de memoria en un solo rack.¹⁴

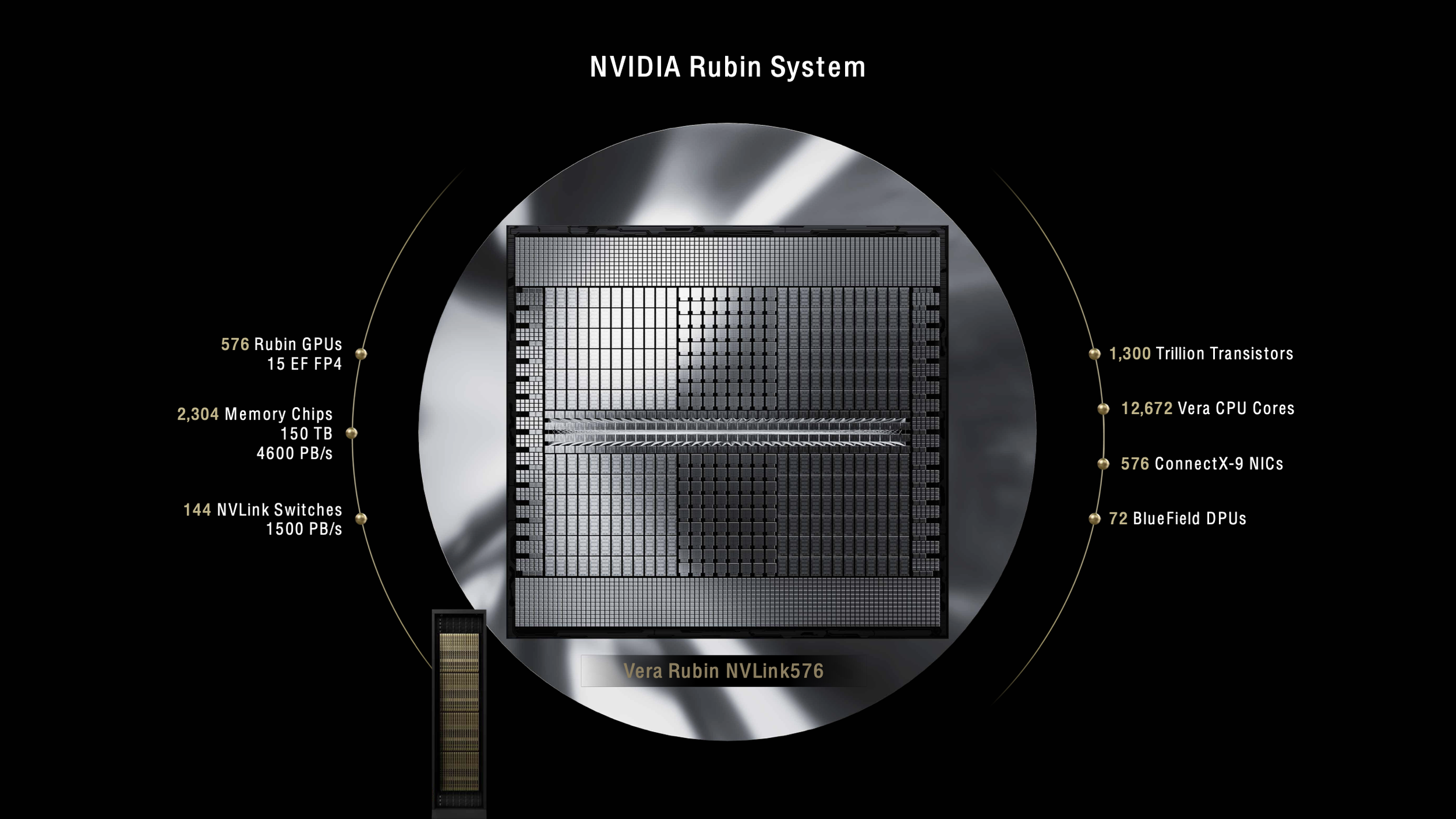

Todo cambia con Rubin Ultra y la arquitectura de rack Kyber en 2027. El sistema NVL576 empaqueta 576 dies de GPU en un solo rack, consumiendo 600kW de energía—cinco veces los sistemas actuales.¹⁵ El diseño Kyber rota las placas de cómputo 90 grados en una orientación vertical, empaquetando cuatro pods de 18 placas cada uno en el rack.¹⁶ Cada placa aloja ocho GPU Rubin Ultra junto con CPU Vera, logrando densidades que parecían imposibles hace apenas unos años.

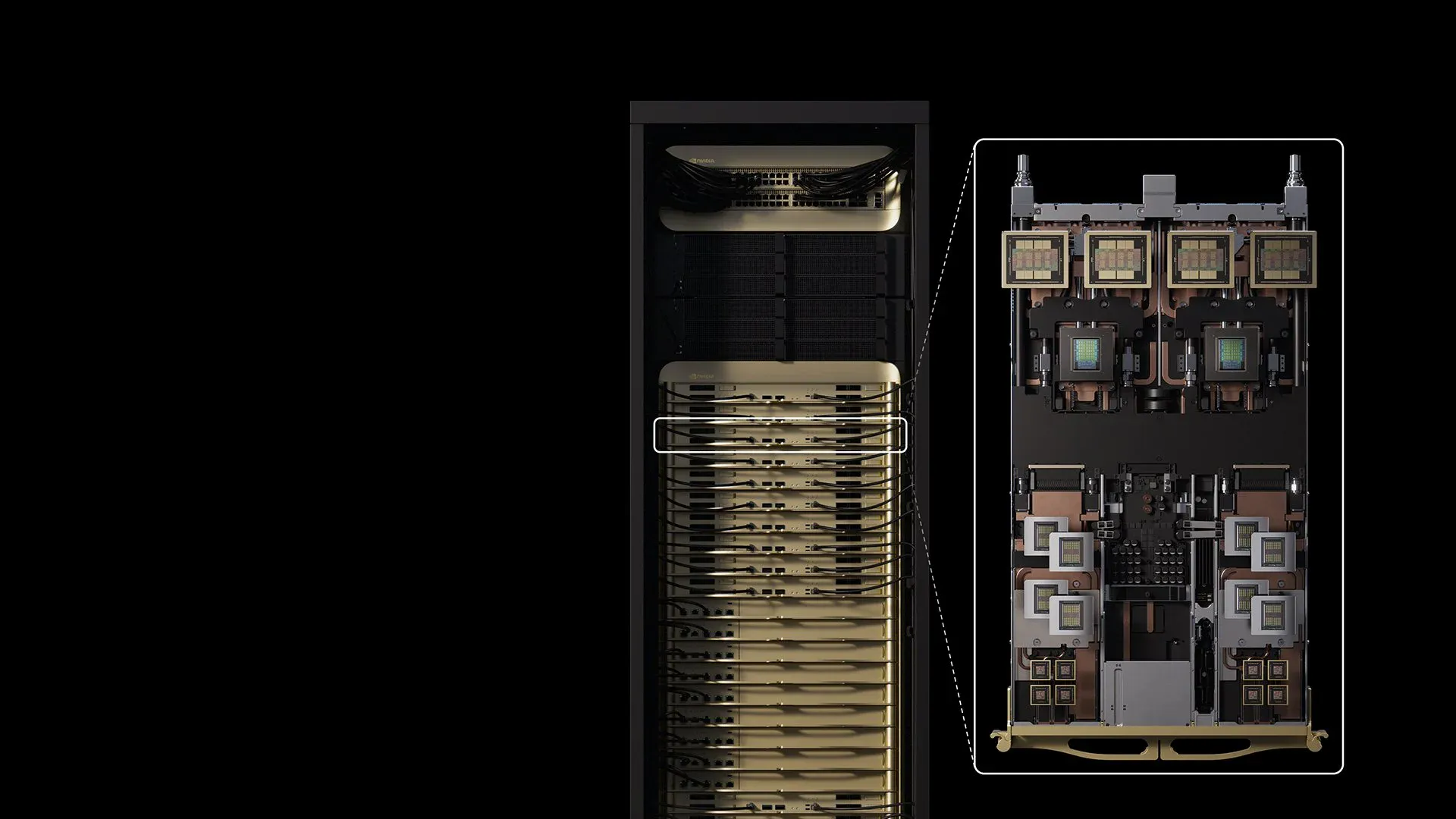

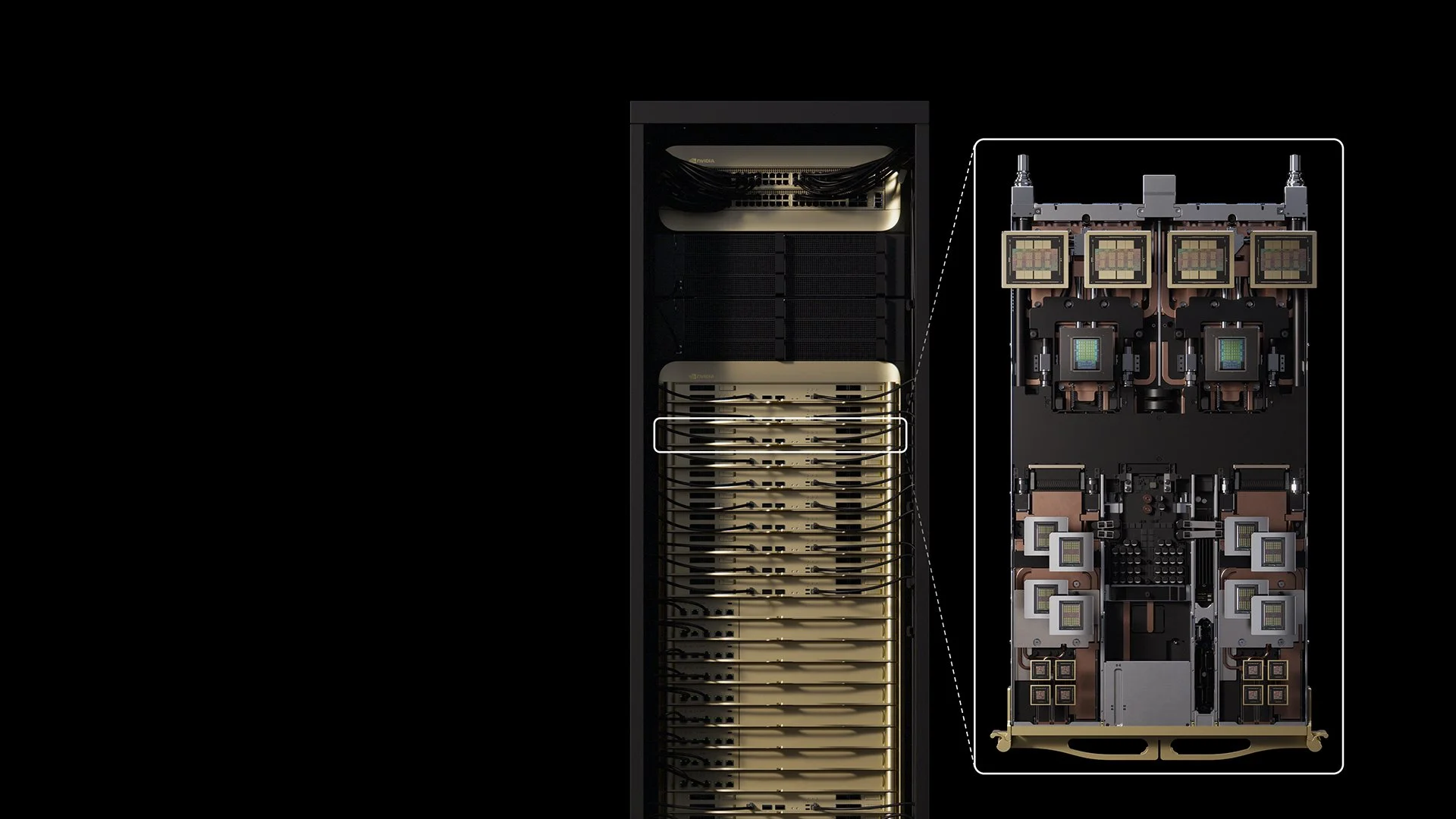

[caption id="" align="alignnone" width="2522"] Sistema NVIDIA Blackwell actual con 72 GPU ofreciendo 1.1 exaflops [/caption]

Sistema NVIDIA Blackwell actual con 72 GPU ofreciendo 1.1 exaflops [/caption]

[caption id="" align="alignnone" width="2524"] Sistema NVIDIA Rubin futuro escalando a 576 GPU y 15 exaflops en un solo rack de 600kW [/caption]

Sistema NVIDIA Rubin futuro escalando a 576 GPU y 15 exaflops en un solo rack de 600kW [/caption]

Refrigerar estos sistemas requiere inmersión líquida completa con cero ventiladores—una salida de los sistemas actuales que aún usan algo de refrigeración por aire para componentes auxiliares.¹⁷ CoolIT Systems y Accelsius ya han demostrado soluciones de refrigeración capaces de manejar racks de 250kW con temperaturas de entrada de agua de 40°C, validando el camino tecnológico hacia despliegues de 600kW.¹⁸ El rack Kyber incluye un sidecar dedicado para infraestructura de energía y refrigeración, requiriendo efectivamente dos espacios de rack para cada sistema de 600kW.¹⁹

La evolución de la arquitectura de energía habilita cómputo de escala megavatio.

La transición de NVIDIA a distribución de energía de 800 VDC aborda limitaciones fundamentales de la física de la infraestructura actual. La distribución tradicional de 54V en rack requeriría 64U de estantes de energía para sistemas de escala Kyber, no dejando espacio para cómputo real.²⁰ La arquitectura de 800V elimina la conversión AC/DC a nivel de rack, mejora la eficiencia de extremo a extremo hasta en 5%, y reduce los costos de mantenimiento hasta en 70%.²¹

La nueva infraestructura de energía soporta racks que van desde 100kW hasta más de 1MW, usando la misma estructura, y proporciona la escalabilidad necesaria para generaciones futuras.²² Las empresas que desplieguen Vera Rubin deben planear actualizaciones eléctricas masivas—un solo rack NVL576 consume tanta energía como 400 hogares típicos. Los centros de datos que planean para despliegues de 2027 deberían comenzar las actualizaciones de infraestructura ahora, incluyendo conexiones de energía de escala de servicios públicos y potencialmente generación en sitio.

Las ganancias de rendimiento justifican la inversión en infraestructura.

La variante Vera Rubin NVL144 CPX demuestra el potencial de la plataforma con sus ocho exaFLOPS de cómputo NVFP4, junto con 100TB de memoria de alta velocidad y 1.7 PB/s de ancho de banda de memoria, todo en un solo rack.²⁴ NVIDIA afirma que las organizaciones pueden lograr un retorno de inversión de 30x a 50x, traduciéndose a $5 mil millones en ingresos de una inversión de capital de $100 millones.²⁵

Los adoptadores tempranos incluyen el Centro de Supercomputación Leibniz de Alemania, que está desplegando la supercomputadora Blue Lion con Vera Rubin para lograr 30 veces más poder computacional que su sistema actual.²⁶ El sistema Doudna de Lawrence Berkeley National Lab también funcionará en Vera Rubin, combinando simulación, datos y AI en una sola plataforma para computación científica.²⁷

La especialización del Rubin CPX para procesamiento de contexto aborda un cuello de botella crítico en los sistemas de AI actuales. Empresas como Cursor, Runway y Magic ya están explorando cómo CPX puede acelerar asistentes de codificación y aplicaciones de generación de video que requieren procesar millones de tokens simultáneamente.²⁸ La capacidad de mantener bases de código completas o horas de video en memoria activa cambia fundamentalmente lo que las aplicaciones de AI pueden lograr.

Los desafíos de infraestructura crean oportunidades de mercado.

El salto a racks de 600kW expone realidades duras sobre las capacidades actuales de centros de datos. La mayoría de las instalaciones luchan con racks de 40kW; incluso los centros de datos de AI de vanguardia raramente exceden 120kW. La transición requiere no solo nuevos sistemas de refrigeración sino rediseños completos de instalaciones, desde pisos de concreto capaces de soportar cargas de peso masivas hasta subestaciones eléctricas dimensionadas para operaciones industriales.

"La pregunta permanece sobre cuántas instalaciones de centros de datos existentes podrán soportar tal configuración densa", nota The Register, destacando que la naturaleza personalizada de los racks Kyber significa que las instalaciones necesitan infraestructura construida específicamente.²⁹ Los desarrollos greenfield en regiones con exceso de energía renovable o nuclear—Escandinavia, Quebec y los EAU—probablemente liderarán la adopción.³⁰

La línea de tiempo le da a la industria espacio para respirar pero demanda acción inmediata. Las organizaciones que planean infraestructura de AI para 2027 y más allá deben tomar decisiones ahora sobre ubicaciones de instalaciones, adquisición de energía y arquitectura de refrigeración. El tiempo de anticipación de tres años refleja la complejidad de desplegar infraestructura que opera en el límite de lo que es físicamente posible.

El camino más allá de Vera Rubin

La hoja de ruta de NVIDIA se extiende más allá de Vera Rubin a la arquitectura Feynman en 2028, probablemente empujando hacia racks de 1-megavatio.³¹ El CEO de Vertiv, Giordano Albertazzi, sugiere que lograr densidad de escala MW requerirá "una revolución adicional en la refrigeración líquida, y un cambio de paradigma en el lado de energía".³² La trayectoria parece inevitable—las cargas de trabajo de AI demandan incrementos exponenciales en densidad de cómputo, y la economía favorece la concentración sobre la distribución.

El cambio de mejoras incrementales a cambios revolucionarios en infraestructura de GPU refleja la transformación más amplia de AI. Así como los modelos de lenguaje grandes saltaron de miles de millones a billones de parámetros, la infraestructura que los soporta debe hacer saltos similares. Vera Rubin representa no solo GPU más rápidas sino un replanteamiento fundamental de cómo funciona la infraestructura de cómputo.

Conclusión

La plataforma Vera Rubin de NVIDIA fuerza a la industria de centros de datos a confrontar verdades incómodas sobre limitaciones de infraestructura mientras ofrece capacidades computacionales sin precedentes. Los racks de 600kW de 2027 representan más que solo mayor consumo de energía—marcan una transformación completa en cómo se construye, refrigera y opera la infraestructura de AI. Las organizaciones que comiencen a planear ahora, asociándose con especialistas en infraestructura experimentados que entienden las complejidades de despliegues de próxima generación, estarán mejor posicionadas para aprovechar las capacidades revolucionarias que Vera Rubin habilita.

La llegada de la plataforma en 2026-2027 le da tiempo a la industria para prepararse, pero el reloj está corriendo. Los centros de datos diseñados hoy deben anticipar los requisitos de mañana, y Vera Rubin deja claro que mañana demanda salidas radicales del pensamiento convencional. Las empresas que abracen esta transformación alimentarán la próxima generación de avances de AI, desde modelos de lenguaje de millones de tokens hasta sistemas de generación de video en tiempo real que parecen ciencia ficción hoy.

Referencias

¹ The Register. "Nvidia's Vera Rubin CPU, GPUs chart course for 600kW racks." March 19, 2025. https://www.theregister.com/2025/03/19/nvidia_charts_course_for_600kw.

² NVIDIA Newsroom. "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference." 2025. https://nvidianews.nvidia.com/news/nvidia-unveils-rubin-cpx-a-new-class-of-gpu-designed-for-massive-context-inference.

³ Ibid.

⁴ Data Center Dynamics. "GTC: Nvidia's Jensen Huang, Ian Buck, and Charlie Boyle on the future of data center rack density." March 21, 2025. https://www.datacenterdynamics.com/en/analysis/nvidia-gtc-jensen-huang-data-center-rack-density/.

⁵ TechPowerUp. "NVIDIA Unveils Vera CPU and Rubin Ultra AI GPU, Announces Feynman Architecture." 2025. https://www.techpowerup.com/334334/nvidia-unveils-vera-cpu-and-rubin-ultra-ai-gpu-announces-feynman-architecture.

⁶ CNBC. "Nvidia announces Blackwell Ultra and Vera Rubin AI chips." March 18, 2025. https://www.cnbc.com/2025/03/18/nvidia-announces-blackwell-ultra-and-vera-rubin-ai-chips-.html.

⁷ Yahoo Finance. "Nvidia debuts next-generation Vera Rubin superchip at GTC 2025." March 18, 2025. https://finance.yahoo.com/news/nvidia-debuts-next-generation-vera-rubin-superchip-at-gtc-2025-184305222.html.

⁸ Next Platform. "Nvidia Draws GPU System Roadmap Out To 2028." June 5, 2025. https://www.nextplatform.com/2025/03/19/nvidia-draws-gpu-system-roadmap-out-to-2028/.

⁹ SemiAnalysis. "NVIDIA GTC 2025 – Built For Reasoning, Vera Rubin, Kyber, CPO, Dynamo Inference, Jensen Math, Feynman." August 4, 2025. https://semianalysis.com/2025/03/19/nvidia-gtc-2025-built-for-reasoning-vera-rubin-kyber-cpo-dynamo-inference-jensen-math-feynman/.

¹⁰ NVIDIA Newsroom. "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference."

¹¹ Ibid.

¹² Tom's Hardware. "Nvidia announces Rubin GPUs in 2026, Rubin Ultra in 2027, Feynman also added to roadmap." March 18, 2025. https://www.tomshardware.com/pc-components/gpus/nvidia-announces-rubin-gpus-in-2026-rubin-ultra-in-2027-feynam-after.

¹³ The New Stack. "NVIDIA Unveils Next-Gen Rubin and Feynman Architectures, Pushing AI Power Limits." April 14, 2025. https://thenewstack.io/nvidia-unveils-next-gen-rubin-and-feynman-architectures-pushing-ai-power-limits/.

¹⁴ NVIDIA Newsroom. "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference."

¹⁵ Data Center Dynamics. "Nvidia's Rubin Ultra NVL576 rack expected to be 600kW, coming second half of 2027." March 18, 2025. https://www.datacenterdynamics.com/en/news/nvidias-rubin-ultra-nvl576-rack-expected-to-be-600kw-coming-second-half-of-2027/.

¹⁶ Tom's Hardware. "Nvidia shows off Rubin Ultra with 600,000-Watt Kyber racks and infrastructure, coming in 2027." March 19, 2025. https://www.tomshardware.com/pc-components/gpus/nvidia-shows-off-rubin-ultra-with-600-000-watt-kyber-racks-and-infrastructure-coming-in-2027.

¹⁷ Data Center Dynamics. "GTC: Nvidia's Jensen Huang, Ian Buck, and Charlie Boyle on the future of data center rack density."

¹⁸ Data Center Frontier. "CoolIT and Accelsius Push Data Center Liquid Cooling Limits Amid Soaring Rack Densities." 2025. https://www.datacenterfrontier.com/cooling/article/55281394/coolit-and-accelsius-push-data-center-liquid-cooling-limits-amid-soaring-rack-densities.

¹⁹ Data Center Dynamics. "GTC: Nvidia's Jensen Huang, Ian Buck, and Charlie Boyle on the future of data center rack density."

²⁰ NVIDIA Technical Blog. "NVIDIA 800 VDC Architecture Will Power the Next Generation of AI Factories." May 20, 2025. https://developer.nvidia.com/blog/nvidia-800-v-hvdc-architecture-will-power-the-next-generation-of-ai-factories/.

²¹ Ibid.

²² Ibid.

²⁴ NVIDIA Newsroom. "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference."

²⁵ Ibid.

²⁶ NVIDIA Blog. "Blue Lion Supercomputer Will Run on NVIDIA Vera Rubin." June 10, 2025. https://blogs.nvidia.com/blog/blue-lion-vera-rubin/.

²⁷ Ibid.

²⁸ NVIDIA Newsroom. "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference."

²⁹ The Register. "Nvidia's Vera Rubin CPU, GPUs chart course for 600kW racks."

³⁰ Global Data Center Hub. "Nvidia's 600kW Racks Are Here (Is Your Infrastructure Ready?)." March 23, 2025. https://www.globaldatacenterhub.com/p/issue-8-nvidias-600kw-racks-are-hereis.

³¹ TechPowerUp. "NVIDIA Unveils Vera CPU and Rubin Ultra AI GPU, Announces Feynman Architecture."

³² Data Center Dynamics. "GTC: Nvidia's Jensen Huang, Ian Buck, and Charlie Boyle on the future of data center rack density."