NVIDIA CEO Jensen Huang ließ auf der GTC 2025 eine Bombe platzen und schickte Infrastruktur-Teams zu ihren Taschenrechnern: Die Vera Rubin-Plattform wird Rechenzentrum-Racks bis 2027 auf 600 Kilowatt bringen.¹ Die Ankündigung markiert einen fundamentalen Wandel in der Funktionsweise von Rechenzentren und erzwingt ein komplettes Überdenken von Stromversorgung, Kühlsystemen und physischer Infrastruktur, die jahrzehntelang im Wesentlichen unverändert geblieben ist.

Die Vera Rubin-Plattform stellt NVIDIAs bisher ambitioniertesten Sprung dar. Dieses Multi-Component-System kombiniert die maßgeschneiderte Vera CPU, die nächste Generation der Rubin GPU und den spezialisierten Rubin CPX (Context Processing eXtension) Beschleuniger, der speziell für Million-Token-AI-Workloads entwickelt wurde.² Im Gegensatz zu den schrittweisen Verbesserungen, die für GPU-Generationen typisch sind, liefert die Vera Rubin NVL144 CPX-Variante die 7,5-fache AI-Performance der aktuellen Blackwell GB300-Systeme und verändert gleichzeitig grundlegend, wie GPUs verpackt, gekühlt und eingesetzt werden.³

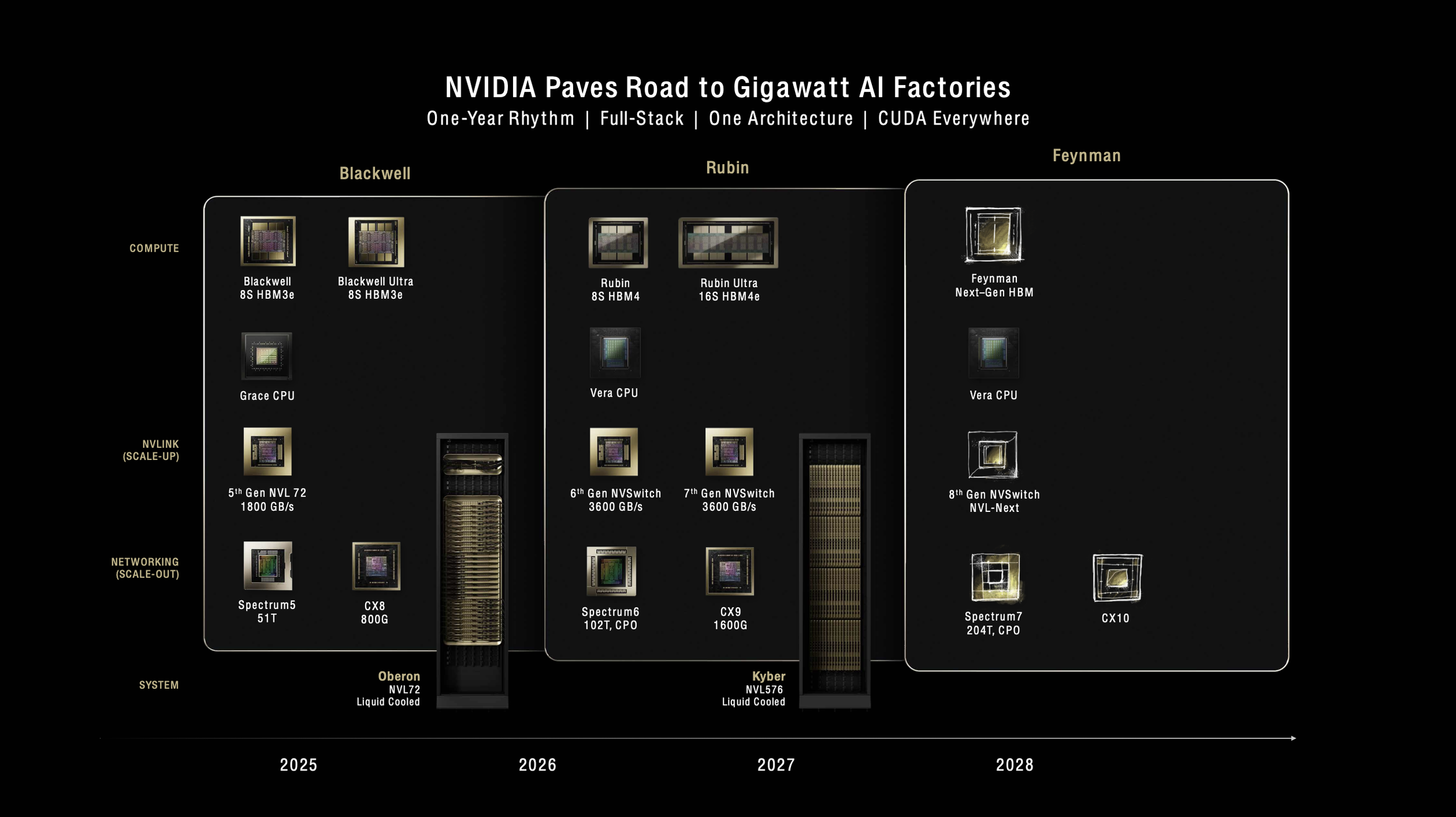

"Wir sind das erste Technologieunternehmen der Geschichte, das vier Generationen von etwas angekündigt hat", erklärte Huang gegenüber Data Center Dynamics und legte NVIDIAs Roadmap bis 2028 dar.⁴ Die Transparenz dient einem kritischen Zweck: Infrastrukturanbieter, Rechenzentrum-Betreiber erhalten die nötige Vorlaufzeit, um sich auf das vorzubereiten, was einer kompletten Neuerfindung der AI-Infrastruktur gleichkommt.

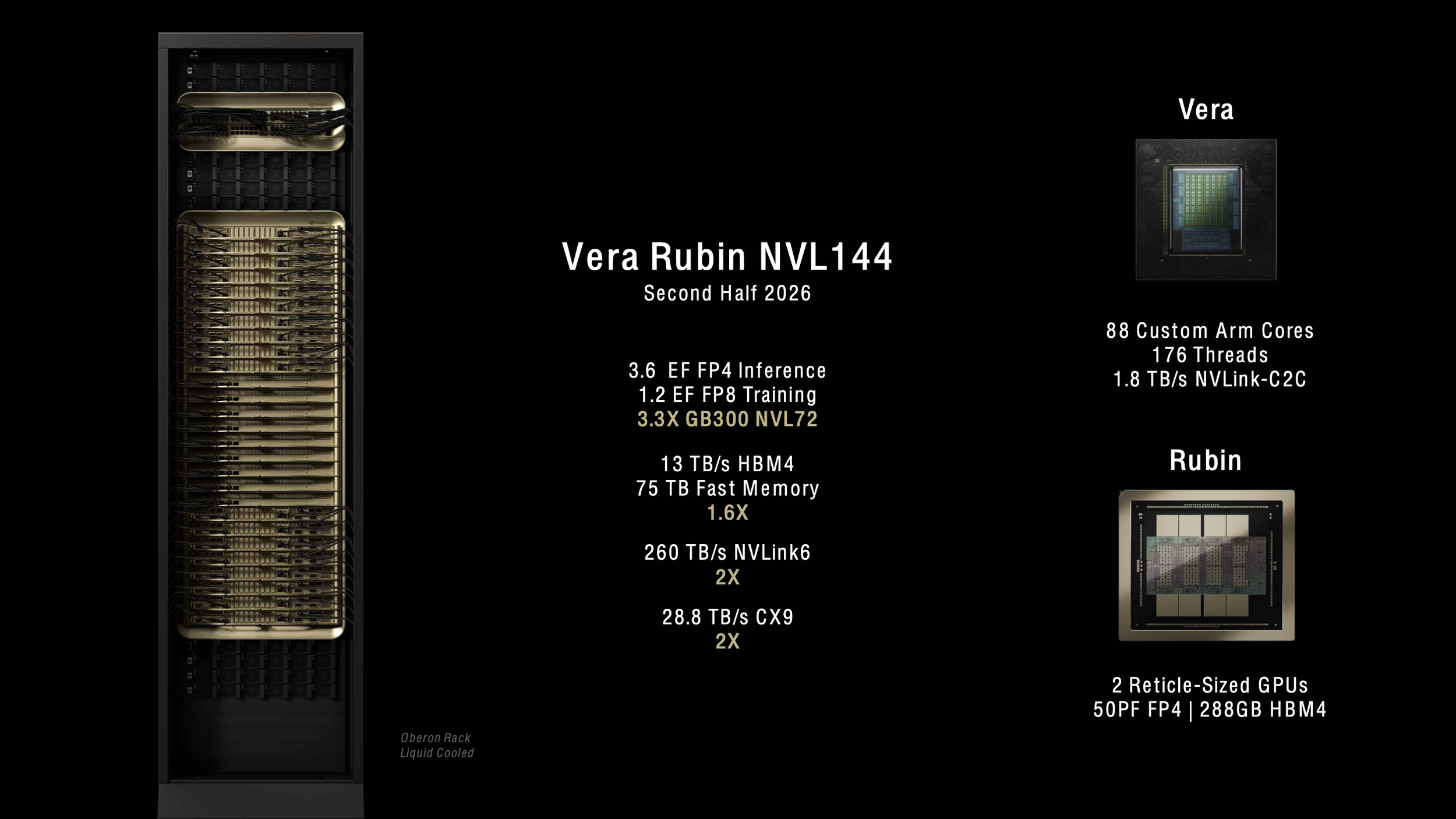

[caption id="" align="alignnone" width="2522"] NVIDIA Vera Rubin NVL144-Plattform-Spezifikationen zeigen 3,6 Exaflops FP4-Inferenz-Performance und 3,3x Verbesserung gegenüber GB300 NVL72, verfügbar zweite Hälfte 2026. [/caption]

NVIDIA Vera Rubin NVL144-Plattform-Spezifikationen zeigen 3,6 Exaflops FP4-Inferenz-Performance und 3,3x Verbesserung gegenüber GB300 NVL72, verfügbar zweite Hälfte 2026. [/caption]

Die Architektur-Revolution beginnt mit maßgeschneidertem Silizium.

[caption id="" align="alignnone" width="2520"] NVIDIAs komplette Roadmap von Blackwell bis Feynman, zeigt die Entwicklung von Oberon- zu Kyber-Rack-Architekturen mit bis zu 600kW Stromverbrauch. [/caption]

NVIDIAs komplette Roadmap von Blackwell bis Feynman, zeigt die Entwicklung von Oberon- zu Kyber-Rack-Architekturen mit bis zu 600kW Stromverbrauch. [/caption]

Die Vera CPU markiert NVIDIAs Abkehr von Standard-ARM-Designs und verfügt über 88 maßgeschneiderte ARM-Kerne mit Simultaneous Multithreading, was 176 logische Prozessoren ermöglicht.⁵ NVIDIA nennt die maßgeschneiderten Kerne "Olympus", und das Design liefert die doppelte Performance der Grace CPU, die in aktuellen Blackwell-Systemen verwendet wird.⁶ Jede Vera CPU verbindet sich mit Rubin GPUs über ein 1,8 TB/s NVLink C2C Interface und ermöglicht beispiellose Bandbreite zwischen Compute-Elementen.⁷

Die Standard-Rubin GPU sprengt Grenzen mit 288GB HBM4-Speicher pro Package, behält die gleiche Kapazität wie die Blackwell Ultra B300 bei, erhöht aber die Speicherbandbreite von 8 TB/s auf 13 TB/s.⁸ Jedes Rubin-Package enthält zwei reticle-limitierte GPU-Dies, obwohl NVIDIA seine Zählmethodik geändert hat - was Blackwell eine GPU (zwei Dies) nannte, nennt Rubin zwei GPUs.⁹ Die Änderung spiegelt die zunehmende Komplexität von Multi-Die-Architekturen wider und hilft Kunden, die tatsächlichen Compute-Ressourcen in jedem System besser zu verstehen.

Das innovativste Element kommt in Form des Rubin CPX, einem zweckgebauten Beschleuniger für massive Context-Verarbeitung. Das monolithische Design liefert 30 PetaFLOPs NVFP4-Compute mit 128GB kosteneffizientem GDDR7-Speicher, speziell optimiert für Attention-Mechanismen in Transformer-Modellen.¹⁰ Der CPX erreicht 3x schnellere Attention-Fähigkeiten im Vergleich zu GB300 NVL72-Systemen und ermöglicht AI-Modellen die Verarbeitung von Million-Token-Kontexten - entsprechend einer Stunde Video oder ganzen Codebasen - ohne Performance-Degradation.¹¹

Deployment erfordert eine komplette Infrastruktur-Überholung.

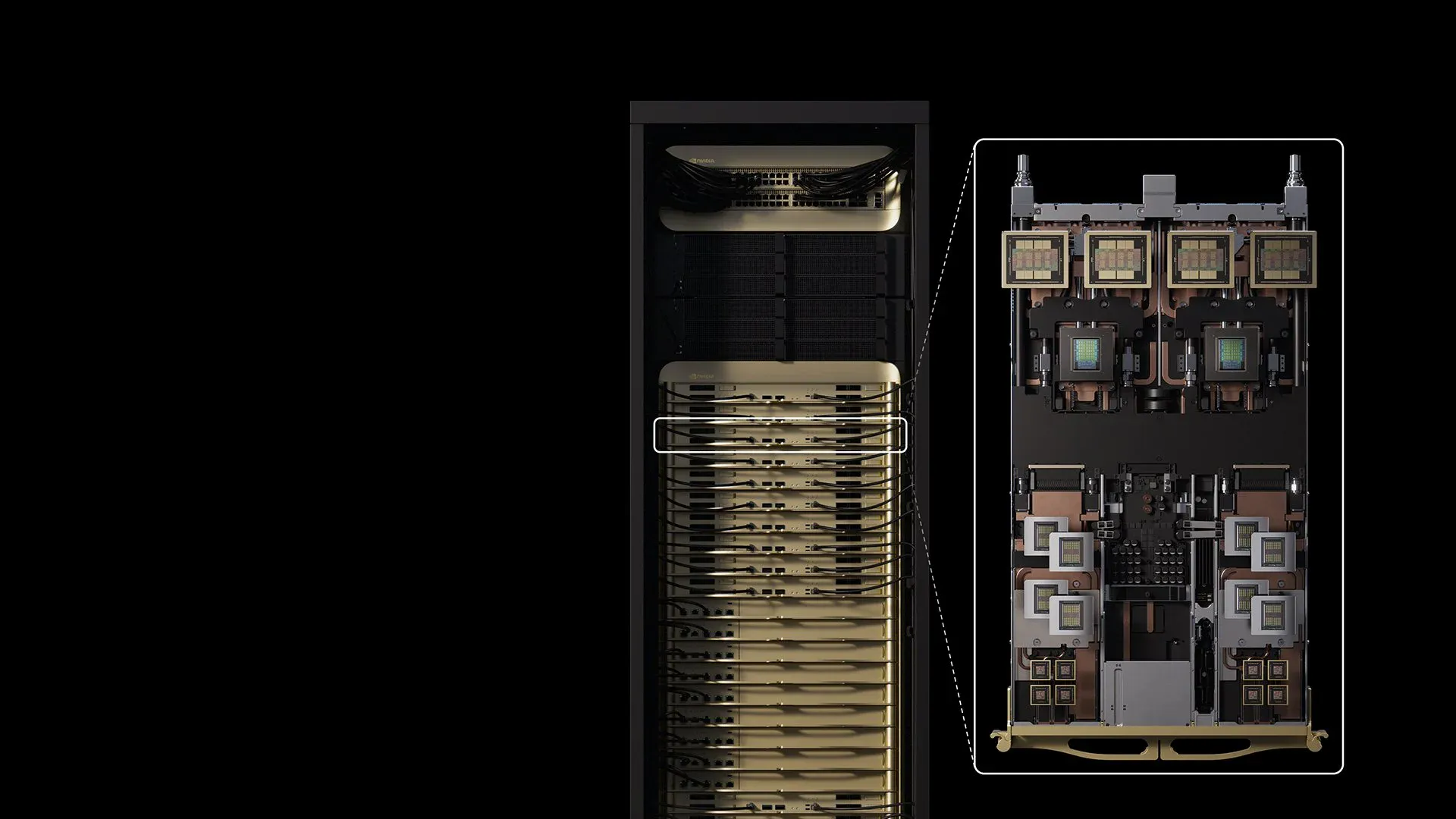

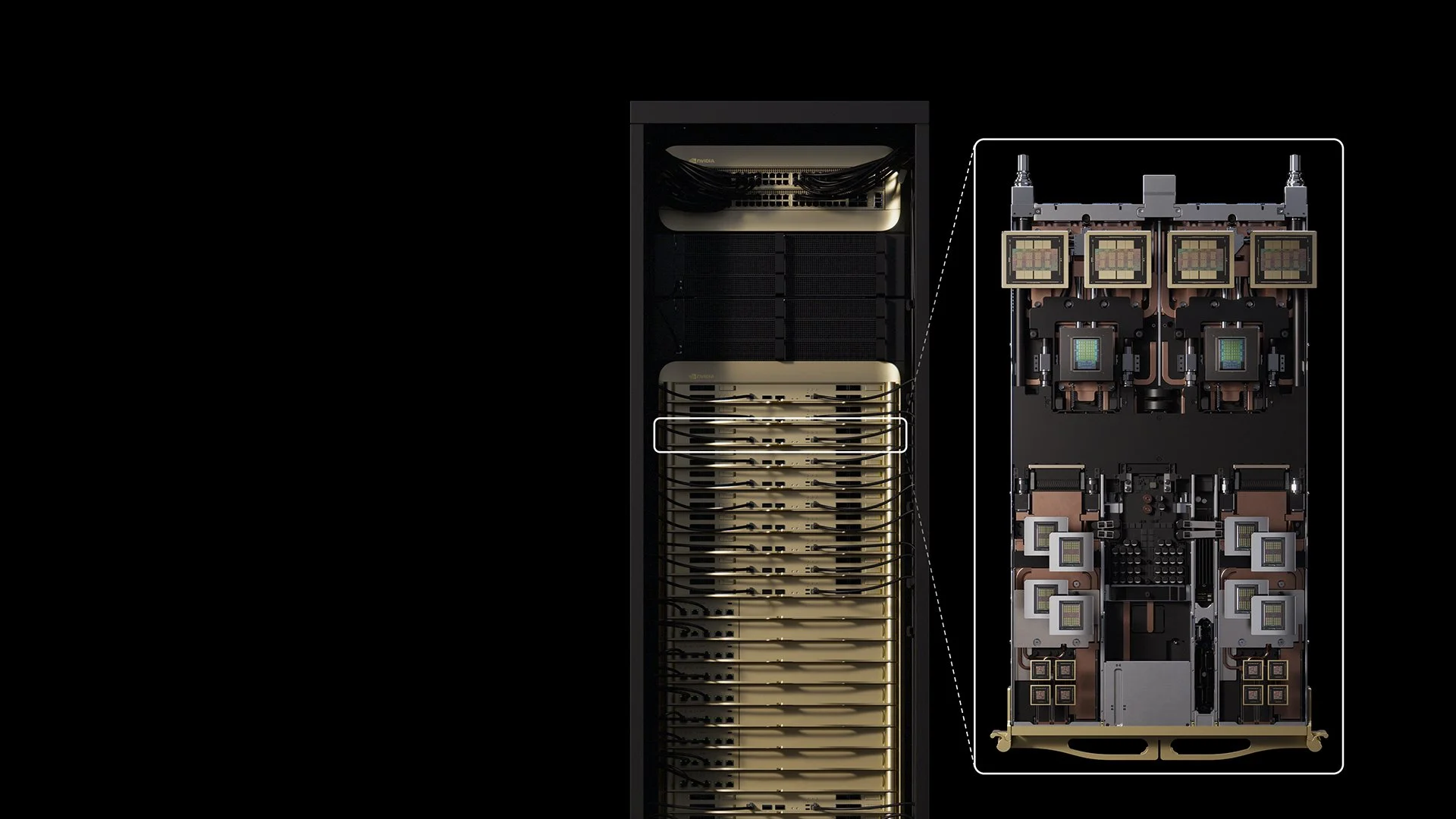

Das Standard-Vera Rubin NVL144-System, geplant für die zweite Hälfte 2026, behält die Kompatibilität mit bestehender GB200/GB300-Infrastruktur bei und nutzt die vertraute Oberon-Rack-Architektur.¹² Das System packt 144 GPU-Dies (72 Packages), 36 Vera CPUs und liefert 3,6 ExaFLOPS FP4-Inferenz-Performance - eine 3,3x Verbesserung gegenüber Blackwell Ultra.¹³ Der Stromverbrauch bleibt handhabbar bei etwa 120-130kW pro Rack, ähnlich aktuellen Deployments.

Die Vera Rubin NVL144 CPX-Variante treibt die Performance weiter voran, integriert 144 Rubin CPX GPUs neben 144 Standard-Rubin GPUs und 36 Vera CPUs, um acht ExaFLOPS NVFP4-Compute zu liefern - diese 7,5x Verbesserung gegenüber GB300 NVL72 - mit 100TB Hochgeschwindigkeitsspeicher und 1,7 PB/s Speicherbandbreite in einem einzigen Rack.¹⁴

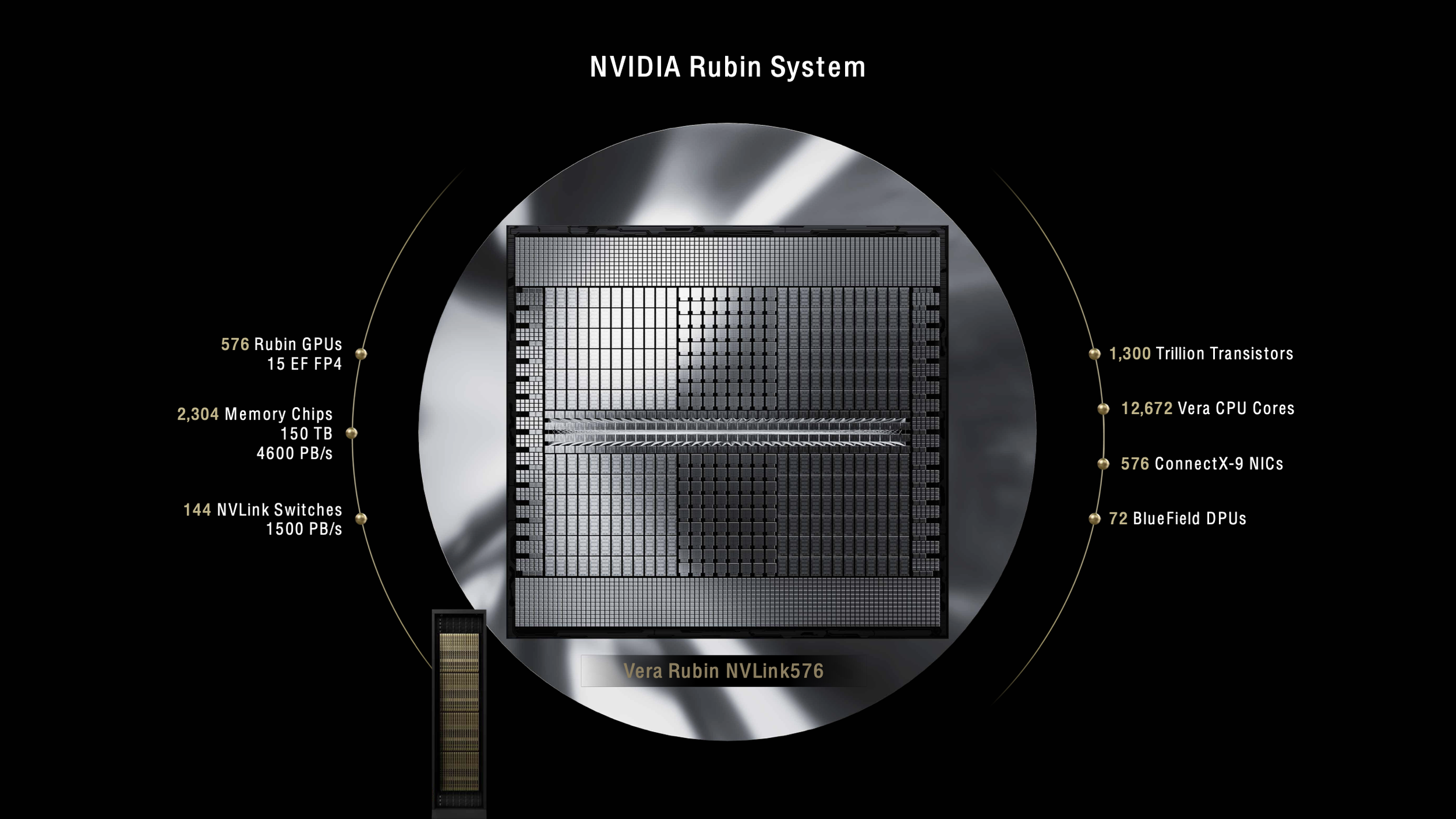

Alles ändert sich mit Rubin Ultra und der Kyber-Rack-Architektur 2027. Das NVL576-System packt 576 GPU-Dies in ein einziges Rack und verbraucht 600kW Strom - fünfmal mehr als aktuelle Systeme.¹⁵ Das Kyber-Design dreht Compute-Blades um 90 Grad in eine vertikale Ausrichtung und packt vier Pods mit je 18 Blades in das Rack.¹⁶ Jedes Blade beherbergt acht Rubin Ultra GPUs neben Vera CPUs und erreicht Dichten, die noch vor Jahren unmöglich schienen.

[caption id="" align="alignnone" width="2522"] Aktuelles NVIDIA Blackwell System mit 72 GPUs liefert 1,1 Exaflops [/caption]

Aktuelles NVIDIA Blackwell System mit 72 GPUs liefert 1,1 Exaflops [/caption]

[caption id="" align="alignnone" width="2524"] Zukünftiges NVIDIA Rubin System skaliert auf 576 GPUs und 15 Exaflops in einem einzigen 600kW Rack [/caption]

Zukünftiges NVIDIA Rubin System skaliert auf 576 GPUs und 15 Exaflops in einem einzigen 600kW Rack [/caption]

Die Kühlung dieser Systeme erfordert komplette Flüssigkeitsimmersion mit null Lüftern - eine Abkehr von aktuellen Systemen, die noch immer etwas Luftkühlung für Hilfskomponenten verwenden.¹⁷ CoolIT Systems und Accelsius haben bereits Kühlösungen demonstriert, die 250kW-Racks mit 40°C Eingangs-Wassertemperaturen bewältigen können und den Technologiepfad zu 600kW-Deployments validieren.¹⁸ Das Kyber-Rack beinhaltet einen dedizierten Sidecar für Strom- und Kühlinfrastruktur, was effektiv zwei Rack-Stellflächen für jedes 600kW-System erfordert.¹⁹

Power-Architektur-Evolution ermöglicht Megawatt-Scale-Computing.

NVIDIAs Übergang zur 800 VDC Stromverteilung adressiert fundamentale Physik-Limitierungen aktueller Infrastruktur. Traditionelle 54V In-Rack-Verteilung würde 64U Power-Shelves für Kyber-Scale-Systeme benötigen und keinen Raum für tatsächliche Compute lassen.²⁰ Die 800V-Architektur eliminiert Rack-Level-AC/DC-Wandlung, verbessert End-to-End-Effizienz um bis zu 5% und reduziert Wartungskosten um bis zu 70%.²¹

Die neue Strom-Infrastruktur unterstützt Racks von 100kW bis über 1MW mit dem gleichen Backbone und bietet die für zukünftige Generationen benötigte Skalierbarkeit.²² Unternehmen, die Vera Rubin deployen, müssen massive elektrische Upgrades planen - ein einziges NVL576-Rack zieht so viel Strom wie 400 typische Haushalte. Rechenzentren, die für 2027-Deployments planen, sollten jetzt mit Infrastruktur-Upgrades beginnen, einschließlich Utility-Scale-Stromanschlüssen und möglicherweise Vor-Ort-Erzeugung.

Performance-Gewinne rechtfertigen Infrastruktur-Investment.

Die Vera Rubin NVL144 CPX-Variante zeigt das Potenzial der Plattform mit ihren acht ExaFLOPS NVFP4-Compute, neben 100TB Hochgeschwindigkeitsspeicher und 1,7 PB/s Speicherbandbreite, alles in einem einzigen Rack.²⁴ NVIDIA behauptet, Organisationen können 30x bis 50x Return on Investment erreichen, was sich in 5 Milliarden Dollar Umsatz aus einer 100 Millionen Dollar Kapitalinvestition übersetzt.²⁵

Frühe Adopter umfassen Deutschlands Leibniz Supercomputing Centre, das den Blue Lion Supercomputer mit Vera Rubin deployt, um 30-mal mehr Rechenleistung als ihr aktuelles System zu erreichen.²⁶ Lawrence Berkeley National Labs Doudna-System wird ebenfalls auf Vera Rubin laufen und Simulation, Daten und AI in einer einzigen Plattform für wissenschaftliches Computing kombinieren.²⁷

Die Spezialisierung des Rubin CPX für Context-Verarbeitung adressiert einen kritischen Engpass in aktuellen AI-Systemen. Unternehmen wie Cursor, Runway und Magic erforschen bereits, wie CPX Coding-Assistenten und Video-Generierungsanwendungen beschleunigen kann, die die simultane Verarbeitung von Millionen von Tokens erfordern.²⁸ Die Fähigkeit, ganze Codebasen oder Stunden von Video im aktiven Speicher zu halten, verändert grundlegend, was AI-Anwendungen erreichen können.

Infrastruktur-Herausforderungen schaffen Marktchancen.

Der Sprung zu 600kW-Racks offenbart harte Realitäten über aktuelle Rechenzentrum-Fähigkeiten. Die meisten Einrichtungen kämpfen mit 40kW-Racks; selbst hochmoderne AI-Rechenzentren überschreiten selten 120kW. Der Übergang erfordert nicht nur neue Kühlsysteme, sondern komplette Facility-Redesigns, von Betonböden, die massive Gewichtslasten tragen können, bis zu Elektro-Umspannwerken in industrieller Größe.

"Die Frage bleibt, wie viele bestehende Rechenzentrum-Einrichtungen eine so dichte Konfiguration unterstützen können werden", bemerkt The Register und betont, dass die maßgeschneiderte Natur der Kyber-Racks bedeutet, dass Einrichtungen zweckgebaute Infrastruktur benötigen.²⁹ Greenfield-Entwicklungen in Regionen mit überschüssiger erneuerbarer oder Nuklearenergie - Skandinavien, Quebec und die VAE - werden wahrscheinlich bei der Adoption führen.³⁰

Die Timeline gibt der Industrie Atemraum, erfordert aber sofortige Maßnahmen. Organisationen, die AI-Infrastruktur für 2027 und darüber hinaus planen, müssen jetzt Entscheidungen über Standorte, Strombeschaffung und Kühl-Architektur treffen. Die dreijährige Vorlaufzeit spiegelt die Komplexität des Deployments von Infrastruktur wider, die am Rande des physikalisch Möglichen operiert.

Der Weg jenseits von Vera Rubin

NVIDIAs Roadmap erstreckt sich über Vera Rubin hinaus zur Feynman-Architektur 2028, die wahrscheinlich Richtung 1-Megawatt-Racks drängt.³¹ Vertiv CEO Giordano Albertazzi schlägt vor, dass das Erreichen von MW-Scale-Dichte "eine weitere Revolution in der Flüssigkeitskühlung und einen Paradigmenwechsel auf der Stromseite" erfordern wird.³² Die Trajektorie scheint unvermeidlich - AI-Workloads erfordern exponentielle Steigerungen der Compute-Dichte, und die Ökonomie favorisiert Konzentration über Verteilung.

Der Wandel von schrittweisen Verbesserungen zu revolutionären Änderungen in der GPU-Infrastruktur spiegelt die breitere AI-Transformation wider. Genau wie große Sprachmodelle von Milliarden zu Billionen von Parametern sprangen, muss die sie unterstützende Infrastruktur ähnliche Sprünge machen. Vera Rubin repräsentiert nicht nur schnellere GPUs, sondern ein fundamentales Überdenken der Funktionsweise von Compute-Infrastruktur.

Fazit

NVIDIAs Vera Rubin-Plattform zwingt die Rechenzentrum-Industrie dazu, unbequeme Wahrheiten über Infrastruktur-Limitierungen zu konfrontieren, während sie beispiellose Compute-Fähigkeiten bietet. Die 600kW-Racks von 2027 repräsentieren mehr als nur höheren Stromverbrauch - sie markieren eine komplette Transformation, wie AI-Infrastruktur gebaut, gekühlt und betrieben wird. Organisationen, die jetzt mit der Planung beginnen und mit erfahrenen Infrastruktur-Spezialisten partnern, die die Komplexitäten von Next-Generation-Deployments verstehen, werden am besten positioniert sein, um die revolutionären Fähigkeiten zu nutzen, die Vera Rubin ermöglicht.

Die Ankunft der Plattform 2026-2027 gibt der Industrie Zeit zur Vorbereitung, aber die Zeit läuft ab. Heute entworfene Rechenzentren müssen morgige Anforderungen antizipieren, und Vera Rubin macht klar, dass morgen radikale Abkehr von konventionellem Denken erfordert. Die Unternehmen, die diese Transformation annehmen, werden die nächste Generation von AI-Durchbrüchen antreiben, von Million-Token-Sprachmodellen bis zu Echtzeit-Video-Generierungssystemen, die heute wie Science Fiction erscheinen.

Referenzen

¹ The Register. "Nvidia's Vera Rubin CPU, GPUs chart course for 600kW racks." March 19, 2025. https://www.theregister.com/2025/03/19/nvidia_charts_course_for_600kw.

² NVIDIA Newsroom. "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference." 2025. https://nvidianews.nvidia.com/news/nvidia-unveils-rubin-cpx-a-new-class-of-gpu-designed-for-massive-context-inference.

³ Ibid.

⁴ Data Center Dynamics. "GTC: Nvidia's Jensen Huang, Ian Buck, and Charlie Boyle on the future of data center rack density." March 21, 2025. https://www.datacenterdynamics.com/en/analysis/nvidia-gtc-jensen-huang-data-center-rack-density/.

⁵ TechPowerUp. "NVIDIA Unveils Vera CPU and Rubin Ultra AI GPU, Announces Feynman Architecture." 2025. https://www.techpowerup.com/334334/nvidia-unveils-vera-cpu-and-rubin-ultra-ai-gpu-announces-feynman-architecture.

⁶ CNBC. "Nvidia announces Blackwell Ultra and Vera Rubin AI chips." March 18, 2025. https://www.cnbc.com/2025/03/18/nvidia-announces-blackwell-ultra-and-vera-rubin-ai-chips-.html.

⁷ Yahoo Finance. "Nvidia debuts next-generation Vera Rubin superchip at GTC 2025." March 18, 2025. https://finance.yahoo.com/news/nvidia-debuts-next-generation-vera-rubin-superchip-at-gtc-2025-184305222.html.

⁸ Next Platform. "Nvidia Draws GPU System Roadmap Out To 2028." June 5, 2025. https://www.nextplatform.com/2025/03/19/nvidia-draws-gpu-system-roadmap-out-to-2028/.

⁹ SemiAnalysis. "NVIDIA GTC 2025 – Built For Reasoning, Vera Rubin, Kyber, CPO, Dynamo Inference, Jensen Math, Feynman." August 4, 2025. https://semianalysis.com/2025/03/19/nvidia-gtc-2025-built-for-reasoning-vera-rubin-kyber-cpo-dynamo-inference-jensen-math-feynman/.

¹⁰ NVIDIA Newsroom. "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference."

¹¹ Ibid.

¹² Tom's Hardware. "Nvidia announces Rubin GPUs in 2026, Rubin Ultra in 2027, Feynman also added to roadmap." March 18, 2025. https://www.tomshardware.com/pc-components/gpus/nvidia-announces-rubin-gpus-in-2026-rubin-ultra-in-2027-feynam-after.

¹³ The New Stack. "NVIDIA Unveils Next-Gen Rubin and Feynman Architectures, Pushing AI Power Limits." April 14, 2025. https://thenewstack.io/nvidia-unveils-next-gen-rubin-and-feynman-architectures-pushing-ai-power-limits/.

¹⁴ NVIDIA Newsroom. "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference."

¹⁵ Data Center Dynamics. "Nvidia's Rubin Ultra NVL576 rack expected to be 600kW, coming second half of 2027." March 18, 2025. https://www.datacenterdynamics.com/en/news/nvidias-rubin-ultra-nvl576-rack-expected-to-be-600kw-coming-second-half-of-2027/.

¹⁶ Tom's Hardware. "Nvidia shows off Rubin Ultra with 600,000-Watt Kyber racks and infrastructure, coming in 2027." March 19, 2025. https://www.tomshardware.com/pc-components/gpus/nvidia-shows-off-rubin-ultra-with-600-000-watt-kyber-racks-and-infrastructure-coming-in-2027.

¹⁷ Data Center Dynamics. "GTC: Nvidia's Jensen Huang, Ian Buck, and Charlie Boyle on the future of data center rack density."

¹⁸ Data Center Frontier. "CoolIT and Accelsius Push Data Center Liquid Cooling Limits Amid Soaring Rack Densities." 2025. https://www.datacenterfrontier.com/cooling/article/55281394/coolit-and-accelsius-push-data-center-liquid-cooling-limits-amid-soaring-rack-densities.

¹⁹ Data Center Dynamics. "GTC: Nvidia's Jensen Huang, Ian Buck, and Charlie Boyle on the future of data center rack density."

²⁰ NVIDIA Technical Blog. "NVIDIA 800 VDC Architecture Will Power the Next Generation of AI Factories." May 20, 2025. https://developer.nvidia.com/blog/nvidia-800-v-hvdc-architecture-will-power-the-next-generation-of-ai-factories/.

²¹ Ibid.

²² Ibid.

²⁴ NVIDIA Newsroom. "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference."

²⁵ Ibid.

²⁶ NVIDIA Blog. "Blue Lion Supercomputer Will Run on NVIDIA Vera Rubin." June 10, 2025. https://blogs.nvidia.com/blog/blue-lion-vera-rubin/.

²⁷ Ibid.

²⁸ NVIDIA Newsroom. "NVIDIA Unveils Rubin CPX: A New Class of GPU Designed for Massive-Context Inference."

²⁹ The Register. "Nvidia's Vera Rubin CPU, GPUs chart course for 600kW racks."

³⁰ Global Data Center Hub. "Nvidia's 600kW Racks Are Here (Is Your Infrastructure Ready?)." March 23, 2025. https://www.globaldatacenterhub.com/p/issue-8-nvidias-600kw-racks-are-hereis.

³¹ TechPowerUp. "NVIDIA Unveils Vera CPU and Rubin Ultra AI GPU, Announces Feynman Architecture."

³² Data Center Dynamics. "GTC: Nvidia's Jensen Huang, Ian Buck, and Charlie Boyle on the future of data center rack density."