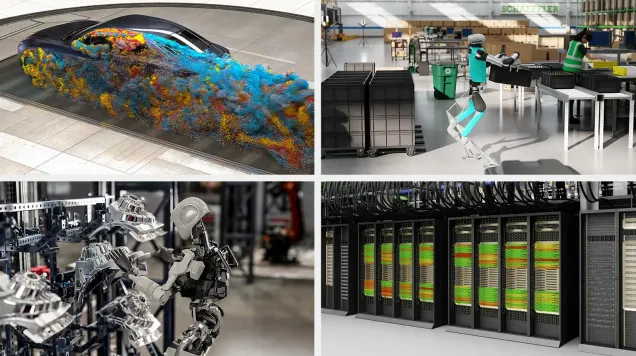

NVIDIA Omniverse : Le système d'exploitation de l'IA physique à 50 000 milliards de dollars

NVIDIA Omniverse équipe plus de 252 entreprises avec des gains d'efficacité de 30 à 70 %. Ce système d'exploitation d'IA physique à 50 000 milliards de dollars transforme la fabrication, la robotique ...