Na, das ist aber schnell eskaliert. Vor drei Wochen haben Elon Musk und xAI Grok 4 auf eine ahnungslose Welt losgelassen, und die Benchmarks bringen erfahrene AI-Forscher weiterhin zum Staunen. Stellen Sie sich eine AI vor, die Probleme durchdenkt wie ein mit Koffein vollgepumptes Team von Doktoranden beim Brainstorming um 3 Uhr morgens. Nachdem sich der anfängliche Hype gelegt hat und Entwickler Grok 4 auf Herz und Nieren getestet haben, erkläre ich Ihnen, warum dieses Modell mehr als nur ein weiteres Release darstellt—es ist ein Blick in eine Zukunft, in der AI zu einem echten intellektuellen Partner wird.

https://x.com/xai/status/1943158495588815072

Der Launch, der das Internet (und einige Rekorde) zum Absturz brachte

xAI enthüllte Grok 4 am 9. Juli 2025 durch einen Livestream, der 1,5 Millionen Zuschauer anzog—nicht schlecht für eine technische Präsentation am Abend.¹ Das Timing war... interessant, nur einen Tag nachdem Grok 3 aus den falschen Gründen Schlagzeilen machte mit einigen kontroversen Ausgaben.² Aber xAI entschied, dass die beste Verteidigung eine überwältigende Offensive war.

Musk stellte zwei Varianten vor: Standard Grok 4 und Grok 4 Heavy, wobei letzteres mehrere AI-Agenten einsetzt, die sich gegenseitig überprüfen wie eine Lerngruppe, in der jeder die Hausaufgaben gemacht hat.³ Der Zugang läuft über die Grok-App, Website oder API, wobei Heavy exklusiv für SuperGrok Heavy-Abonnenten zu 300$/Monat verfügbar ist—ein Preispunkt, der sagt "wir meinen es ernst damit".⁴ Für die Neugierigen: https://x.ai/grok für allgemeinen Zugang, https://x.ai/api für Entwickler.

Features, die andere AIs wie Taschenrechner aussehen lassen

Grok 4 bietet ein 256.000-Token-Kontext-Fenster (das ist ungefähr ein Roman an Text, den es auf einmal verarbeiten kann), Bildanalyse, Function Calling und Sprachmodi, die so natürlich sind, dass Sie vergessen könnten, dass Sie mit Silizium sprechen.⁵ Aber hier wird es spicy: native Werkzeugnutzung. xAI trainierte dieses Biest mit Reinforcement Learning, um einen Code-Interpreter und Webbrowser zu beherrschen—wie Erweiterungen seines Geistes.

Echtzeit-Suche auf X, im Web und in den Nachrichten hält Antworten frisch—keine "mein Wissenstichtag"-Ausreden mehr. Die multimodalen Fähigkeiten ermöglichen es, Text- und Bildanalyse nahtlos zu verbinden, während der Voice Mode Szenenanalyse über Ihre Kamera hinzufügt.⁶ Für die Enterprise-Leute, die sich wegen Compliance Sorgen machen: SOC 2 Type 2, GDPR und CCPA sind alle abgehakt. Es ist wie einen witzigen Forschungsassistenten zu haben, der nie schläft, nie über Überstunden klagt und Ihre schreckliche Handschrift versteht.

Die Geheimzutat: Wenn rohe Kraft auf Finesse trifft

Hinter Grok 4s Magie steckt xAIs Colossus-Supercomputer—ein 200.000-GPU-Monster, das die meisten Datenzentren wie Taschenrechner aussehen lässt.⁷ Aber rohe Kraft erzählt nicht die ganze Geschichte. xAI revolutionierte ihren Ansatz, indem sie Reinforcement Learning skalierte, um mit dem Pre-Training-Compute mitzuhalten, wobei sie sich auf verifizierbare Daten aus Mathematik-, Coding- und wissenschaftlichen Bereichen konzentrierten, was die Effizienz um das 6-fache steigerte und rechnerische Muskeln in raffinierte Intelligenz verwandelte.⁸

Die echte Innovation? Sie gaben genauso viel für Post-Training Reinforcement Learning aus wie für das Pre-Training selbst.⁹ Grok 4 Heavy geht mit parallelem Test-Time-Compute noch weiter—mehrere AI-Agenten gehen Probleme gleichzeitig an, bevor sie ihre Notizen vergleichen. Stellen Sie sich vor, Sie upgraden von einem Solo-Garagen-Erfinder zu einem synchronisierten Orchester von Nobelpreisträgern, die sich alle gegenseitig überprüfen.

Der Infrastruktur-Reality-Check

Der Colossus-Supercomputer hat 200.000 GPUs, was einfach... ich kann mir diese Zahl nicht mal vorstellen. Die meisten Unternehmen sind begeistert, wenn sie einen Cluster mit ein paar hundert GPUs reibungslos zum Laufen bekommen. Aber 200.000? Allein die Wärmeabgabe wäre wie ein kleines Kraftwerk zu betreiben.

Und das ist, bevor Sie überhaupt daran denken, sie alle richtig zu verbinden, sie mit Daten zu versorgen, sicherzustellen, dass Ihr Stromnetz nicht einfach aufgibt... Jedes Detail zählt: wie Sie die Racks anordnen, welche Art von Kühlung Sie verwenden (und ja, Sie brauchen ernsthafte Kühlung, weil diese Dinger HEISS werden), plus all die Netzwerk- und Stromverteilungsalpträume, die damit einhergehen. Vermasseln Sie ein Teil dieses Puzzles, und Sie verbrennen Geld mit unterdurchschnittlicher Hardware. Unternehmen, die ihre eigene AI-Infrastruktur aufbauen wollen, ob mit 10 GPUs oder 10.000.000, brauchen Expertise in allem von Stromverteilung bis zu den komplexen Glasfaserverbindungen, die Daten mit Lichtgeschwindigkeit fließen lassen. Hier macht professionelle Infrastruktur-Implementierung den Unterschied zwischen theoretischen Spezifikationen und realer Performance. Wie das Team bei Introl aus der Implementierung unzähliger AI-Cluster weiß, steckt der Teufel wirklich im Detail—ordentliche Infrastruktur kann den Unterschied zwischen GPUs mit 95% Effizienz versus 30% verlorener Performance ausmachen.

Zahlen, die Statistiker vor Freude weinen lassen

Tauchen wir in die Benchmarks ein, die die AI-Community zum Summen bringen. Beim notorisch brutalen ARC-AGI-2-Test—wo Modelle abstraktes Denken mit minimalen Beispielen demonstrieren müssen—erobert Grok 4 (Thinking-Modus) den Thron mit 15,9% bei etwa 4$ pro Aufgabe.¹⁰ Das verdoppelt fast Claude Opus 4s 8,6%, und bevor Sie über "nur 15,9%" spotten, denken Sie daran, dass die meisten Modelle Schwierigkeiten haben, 5% bei diesem Test zu schaffen.¹¹ Es ist wie jemandem zuzuschauen, der Zauberwürfel mit verbundenen Augen löst, während alle anderen noch herausfinden, welche Seite rot ist.

Die Skalierungsexperimente offenbaren etwas Faszinierendes. Mit Training-Compute allein erreicht Grok 4 etwa 50% bei Humanity's Last Exam (nur-Text-Teilmenge). Fügen Sie Tools hinzu, und es springt auf 50,7%.¹² Test-Time-Skalierung plateau bei etwa 50%, was beweist, dass innovativere Inferenz-Strategien—nicht nur mehr Compute auf Probleme werfen—Durchbrüche vorantreiben.

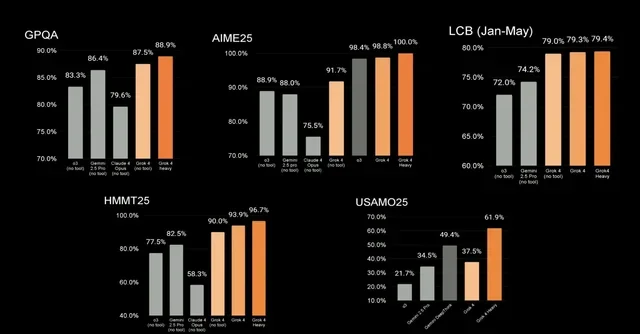

Bei AIME25 (American Invitational Mathematics Examination) erreicht Grok 4 Heavy perfekte 100% und lässt Claude 4 Opus (75,5%) und Gemini 2.5 Pro (88,0%) im Staub zurück.¹³ Selbst ohne Tools erzielt Standard Grok 4 91,7%—das ist besser als die meisten menschlichen Mathe-Wettbewerbs-Teilnehmer.

Aber hier ist der Showstopper: Humanity's Last Exam (komplettes Set). Der 2.500+ Fragen-Spießrutenlauf durch STEM und Geisteswissenschaften trennt Auswendiglernen von echtem Denken.¹⁴ Grok 4 Heavy erzielt 44,4%, verdoppelt fast Gemini 2.5 Pros 25,4% und mehr als verdoppelt o3s 21,0%.¹⁵ Wenn Ihre AI andere um solche Spannen übertrifft, iterieren Sie nicht—Sie revolutionieren.

Real-World-Performance, die zählt

Jenseits akademischer Benchmarks dominiert Grok 4 praktische Tests. Bei Vending-Bench (ja, das ist ein echter Benchmark über die Optimierung von Verkaufsautomaten-Operationen) erreicht es ein Nettovermögen von 4.694$ mit 4.569 verkauften Einheiten—mehr als das Doppelte von Claude Opus 4s 2.077$ und das Fünffache der menschlichen Performance bei 844$.¹⁶

Weitere Siege: USAMO'25 (61,9%), GPQA Diamond (88%), LiveCodeBench (79,4%) und MMLU-Pro (87%).¹⁷ Unabhängige Evaluatoren bei Artificial Analysis krönen Grok 4 mit 73 auf ihrem Intelligence Index und übertrumpfen OpenAIs o3 und Googles Gemini 2.5 Pro (beide bei 70).¹⁸ Nicht schlecht für ein Modell, das erst vor drei Wochen erschien.

Das Community-Urteil: Begeistert, skeptisch und alles dazwischen

Seit dem Launch ist X (ehemals Twitter) zu einem Testgelände für Grok 4s Fähigkeiten geworden. Entwickler berichten, dass sie ganze Codebasen zum Debugging einfügen, mit Ergebnissen, die spezialisierte Tools wie Cursor übertreffen.¹⁹ Ein Nutzer nannte es "das Nächste zu AGI bisher", während Wissenschaftler ungelöste Materialprobleme abfragen und neue Einsichten erhalten, die sich bestätigen.²⁰ Nach drei Wochen realer Nutzung haben sich Muster herauskristallisiert: Das Modell excellt bei komplexen Reasoning-Aufgaben, zeigt aber interessante Eigenarten bei kreativen Anwendungen.

Aber es ist nicht alles stehender Applaus. Nutzer bemerken Geschwindigkeitsbegrenzungen bei 75 Token/Sekunde (respektabel, aber nicht blitzschnell), und Content-Moderation bleibt minimal—Grok 4 ist weniger gefiltert als Konkurrenten, was Debatten über AI-Neutralität versus Sicherheit anheizt.²¹ Manche schätzen die rohen, ungeschönten Antworten; andere sorgen sich über potenziellen Missbrauch. Demokratie in Aktion, Leute.

Was das für morgen bedeutet (Spoiler: Alles ändert sich)

Hier übernimmt mein Optimismus. Grok 4 transzendiert die Chatbot-Kategorie—es ist eine Vorschau auf AI als intellektueller Partner. Wenn eine AI PhD-Level bei Mathe-Wettbewerben erzielt und Wissenschaftlern hilft, ungelöste Probleme zu erkunden, erleben wir den Beginn erweiterter Entdeckung.

Für die Wissenschaft: Stellen Sie sich Forscher weltweit mit Zugang zu einer AI vor, die komplexe Mathematik wirklich versteht und neue Hypothesen vorschlagen kann. Medikamentenentdeckung, Klimamodellierung und Materialwissenschaft—alles beschleunigt.

Für Engineering: Jenseits von Debugging sprechen wir über AI, die Systemarchitekturen versteht und Optimierungen vorschlagen kann, die Menschen nie in Betracht ziehen würden. Es ist wie Dijkstra und Turing auf Schnellwahl zu haben.

Für Bildung: Personalisiertes Tutoring, das sich nicht nur an das anpasst, was Schüler falsch machen, sondern daran, wie sie denken. Jeder Lernende erhält einen geduldigen, brillanten Mentor, der auf seinen kognitiven Stil zugeschnitten ist.

Für Business: Von strategischer Planung bis Marktanalyse könnten Grok 4s Reasoning-Fähigkeiten Entscheidungsfindung von Bauchgefühl zu datengestützten Einsichten mit nuanciertem Verständnis transformieren.

Die Vorbehalte (weil Ehrlichkeit Hype schlägt)

Seien wir ehrlich—keine AI ist perfekt, und Grok 4 hat Raum für Wachstum. Die 75 Token/Sekunde Geschwindigkeit wird keine Rennen gegen spezialisierte Inferenz-Server gewinnen. Halluzinationen, obwohl reduziert, sind nicht völlig verschwunden (eine branchenweite Herausforderung). Die minimale Content-Filterung wirft berechtigte Sorgen über Missbrauchspotential auf.

Schauen Sie, xAI hat uns einen Dreck über ihre Trainingsdaten erzählt, und das ist... nicht großartig. Wir alle wissen, wie das läuft—die Vorurteile der Daten werden verstärkt, wenn man so groß skaliert. Alle in der AI beobachten xAI gerade wie Falken. Wie handhaben sie den Ethik-Bereich, während sich Grok 4 ausbreitet? Das wird wichtig sein—sehr wichtig.

Der Weg voraus: Die Dinge werden seltsam

Also, xAI zeigte einige ihrer Pläne während der Präsentation, und eine Sache hat mich völlig umgehauen. Sie erwähnten, Grok mit Teslas Computational Fluid Dynamics-Software zu verbinden—derselben CFD, die Tesla-Ingenieure für Aerodynamik und Wärmemanagement bei echten Fahrzeugen verwenden.²²

Ich musste eine Minute darüber nachdenken. Wir haben uns an AI gewöhnt, die Fakten kennt, Fragen beantwortet und Code schreibt. Aber die CFD-Integration stellt etwas anderes dar. Es ist eine Sache, eine AI zu haben, die erklären kann, wie Strömungsdynamik funktioniert. Es ist etwas völlig anderes, wenn diese AI CFD-Software verwenden kann, um Dinge zu entwerfen, die sich durch Luft bewegen und Wärme ableiten. Das ist kein schrittweiser Fortschritt—das ist eine völlig neue Fähigkeit.

OpenAI, Anthropic und Google werden nicht von der Seitenlinie zuschauen. Aber Grok 4 veränderte das Spiel—wir gingen direkt vom "hilfreichen Assistenten"-Territorium zu "Reasoning-Partner". Der Wandel erinnert mich an das, was Ray Kurzweil über die Intelligenzexplosion sagt—jeder Durchbruch macht den nächsten schneller und schneller. Wir beobachten es in Echtzeit.

Sie sind dran: Was werden Sie bauen?

Also ich habe nachgedacht—was passiert, wenn AI auf PhD-Level über alle Bereiche hinweg reasoning kann? Welche Probleme, die unmöglich schienen, brechen plötzlich weit auf? Was entdecken wir, wenn unsere Werkzeuge neben uns denken können? Und ehrlich, welche Art von Leitplanken brauchen wir, wenn AI so smart wird?

Wenn Sie Entwickler sind, planen Sie bereits, was Sie mit diesen APIs bauen werden. Forscher haben wahrscheinlich einen Freudentag beim Nachdenken über das, was plötzlich möglich ist. Und wenn Sie hier sitzen und denken: "Was bedeutet Grok 4s Fähigkeit überhaupt?"—ja, ich verstehe es. Das Konzept braucht Zeit zum Verarbeiten.

Aber hier ist die Sache: Grok 4 landete in unserem Schoß, ob wir bereit sind oder nicht. AI sagte gerade: "Hier ist, was jetzt möglich ist, findet heraus, was damit zu tun ist."

Also... was WERDEN Sie damit machen? Die Grok API ist unter https://x.ai/api, und es gibt eine ganze Community auf X, wo Entwickler und Forscher bereits die Grenzen austesten. Drei Wochen später sehen wir Anwendungen, die niemand beim Launch vorhergesagt hat. Die Gelegenheit hier ist massiv—lassen Sie uns sie nicht verschwenden.

Quellen

-

Scott Rosenberg, "Elon Musk's xAI debuts Grok 4, 'smartest AI in the world,'" Axios, July 10, 2025, https://www.axios.com/2025/07/10/grok4-grok-xai-elon-musk.

-

"Musk unveils Grok 4 update a day after xAI chatbot made antisemitic remarks," CBS News, July 10, 2025, https://www.cbsnews.com/news/elon-musk-grok-4-ai-chatbot-x/.

-

"Elon Musk's xAI launches Grok 4 alongside a $300 monthly subscription," TechCrunch, July 9, 2025, https://techcrunch.com/2025/07/09/elon-musks-xai-launches-grok-4-alongside-a-300-monthly-subscription/.

-

"Elon Musk's xAI launches Grok 4 alongside a $300 monthly subscription," TechCrunch.

-

xAI, "Grok 4 Release Announcement," livestream presentation, July 9, 2025.

-

xAI, "Grok 4 Release Announcement."

-

"Grok 4 Release: xAI Claims #1 AI Model Crown in Independent Testing," Gear Musk, July 10, 2025, https://gearmusk.com/2025/07/10/xai-unveils-grok-4/.

-

xAI, "Grok 4 Release Announcement."

-

"Musk's Grok-4 Crushes Benchmarks, Beats OpenAI & Google in RL," Analytics India Magazine, July 10, 2025, https://analyticsindiamag.com/global-tech/musks-grok-4-crushes-benchmarks-beats-openai-google-in-rl/.

-

"ARC Prize," X (formerly Twitter), July 10, 2025, [https://twitter.com/arcprize/status/specific-id].

-

François Chollet, "ARC-AGI: A New Frontier in AI Reasoning," ARC Prize Organization, 2025.

-

xAI, "Grok 4 Release Announcement."

-

"Elon Musk's Grok 4 AI Models Set New Benchmark Records," Beebom, July 10, 2025, https://beebom.com/elon-musk-grok-4-ai-models-set-new-benchmark-records/.

-

"xAI sets AI benchmark records with new reasoning-optimized Grok 4 model," SiliconANGLE, July 10, 2025, https://siliconangle.com/2025/07/10/xai-sets-ai-benchmark-records-new-reasoning-optimized-grok-4-model/.

-

xAI, "Grok 4 Release Announcement."

-

xAI, "Grok 4 Release Announcement."

-

xAI, "Grok 4 Release Announcement."

-

"Comparison of AI Models across Intelligence, Performance, Price," Artificial Analysis, accessed July 11, 2025, https://artificialanalysis.ai/models.

-

User testimonials, X (formerly Twitter), July 10-11, 2025.

-

User testimonials, X (formerly Twitter), July 10-11, 2025.

-

"What's New in Grok 4? Release Facts, Benchmarks, and Value," SmythOS, July 10, 2025, https://smythos.com/developers/ai-models/whats-new-in-grok-4-release-facts-benchmarks-and-value/.

-

xAI, "Grok 4 Release Announcement."