Wenn Rechenzentren Actionfilme wären, dann wären heiße und kalte Gang-Einhaususngen die verkannten Helden, die den Tag retten, ohne den Ruhm zu ernten. Während alle von Prozessoren, Speicher und Speicherkapazitäten besessen sind, passiert die Magie oft in diesen sorgfältig konstruierten Luftkorridoren.

Ihre hochmoderne Serverfarm ist ohne ordnungsgemäße Kühlung nur ein Raum voller teurer Elektroheizungen. Als jemand, der die Hitzewand aus einem unoptimierten Serverraum gespürt hat (und möglicherweise ein- oder zweimal einen zum Wiederaufwärmen von Pizza verwendet hat), kann ich Ihnen sagen, dass Luftstrommanagement nicht nur schön zu haben ist – es ist missionskritisch.

Die Geschichte zweier Gänge

Stellen Sie sich Ihr Rechenzentrum als thermisches Schlachtfeld vor. Die Kaltluft-Armee steht auf einer Seite, bereit, Ihre kostbare Ausrüstung zu kühlen. Auf der anderen Seite stehen die heißen Abluft-Rebellen, entschlossen, sich zu vermischen und Chaos zu verursachen. Ohne Einhaususngssysteme kollidieren diese beiden Kräfte in einem ineffizienten thermischen Durcheinander, das Energie verschwendet und Ausrüstung bedroht.

Heiße/kalte Gang-Einhaususng bedeutet im Wesentlichen, befestigte Grenzen in diesem Kampf zu errichten und die Armeen zu trennen, damit jede ihre Arbeit effektiv erledigen kann. Und wie bei der Wahl zwischen Marvel und DC müssen Sie sich für eine Seite entscheiden: Hot Aisle Containment (HAC) oder Cold Aisle Containment (CAC).

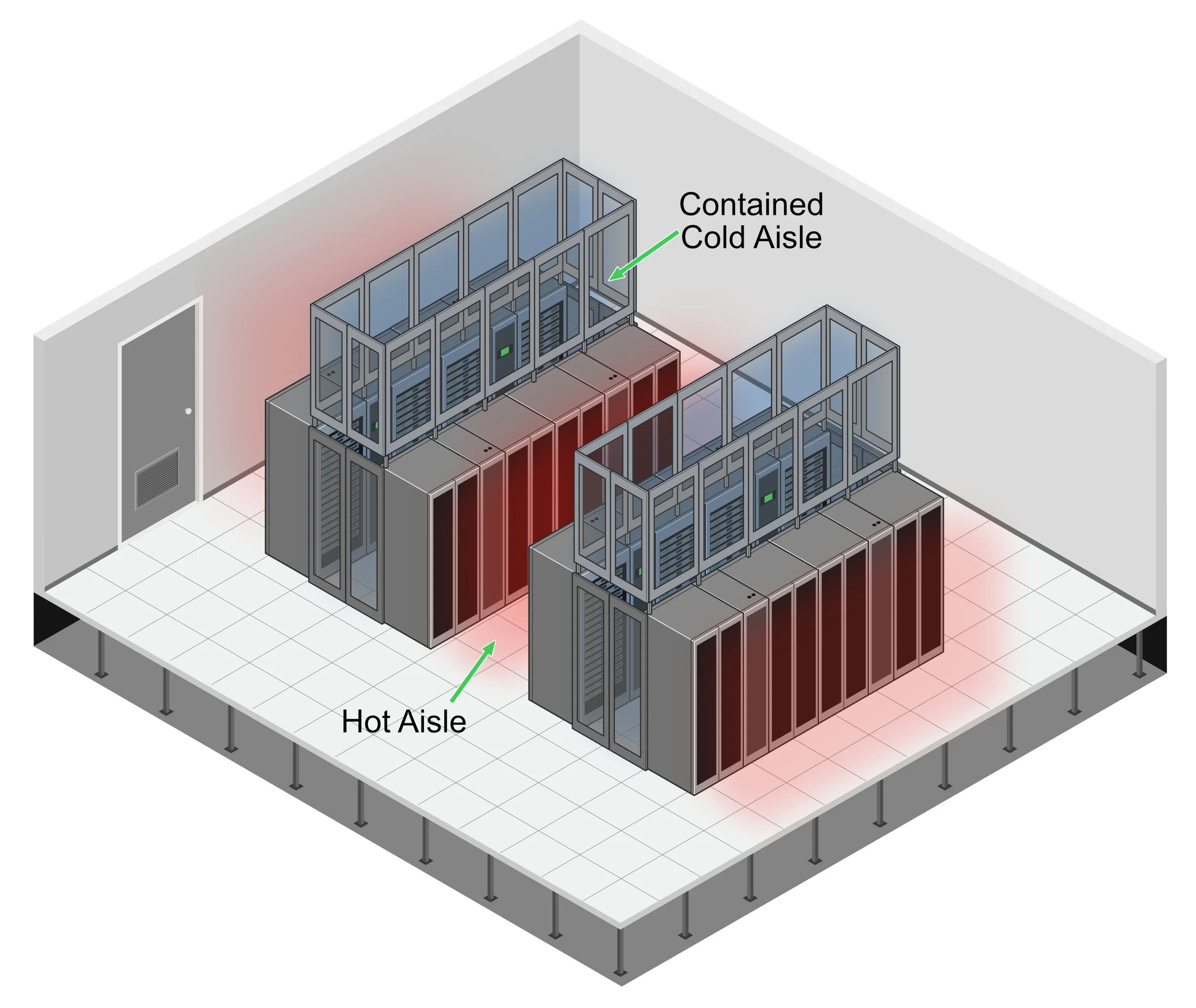

Hot Aisle Containment: Der Schwergewichts-Champion

Hot Aisle Containment funktioniert wie Ihre Küchenabzugshaube – es erfasst Wärme an ihrer Quelle und leitet sie weg. Durch die Umschließung der heißen Gänge (wo Server-Abluft austritt) enthalten HAC-Systeme diesen Hochofen erhitzter Luft und leiten ihn direkt zu den Kühlgeräten zurück, ohne dass er sich mit der kalten Zuluft vermischen kann.

Warum HAC rockt:

-

Schafft eine komfortable Arbeitsplatztemperatur (im Gegensatz zur Alternative, die Ihr Rechenzentrum im Wesentlichen in eine Sauna mit teuren Computern verwandelt)

-

Liefert überlegene Effizienz für hochdichte Racks (wir sprechen von 15kW+ pro Rack – die Ferraris der Serverkonfigurationen)

-

Bietet bessere Kühleffizienz und Ausfallresilienz (gibt Ihnen kostbare zusätzliche Minuten, um Kernschmelzen-Szenarien zu vermeiden, wenn die Kühlung ausfällt)

Die physische Einrichtung umfasst versiegelte Türen an Gang-Enden, Dachsysteme über dem heißen Gang und vertikale Barrieren zur Vervollständigung der Einhaususng. Denken Sie daran als Bau eines Gewächshauses für die Wärme, die Sie erfassen, anstatt erzeugen möchten.

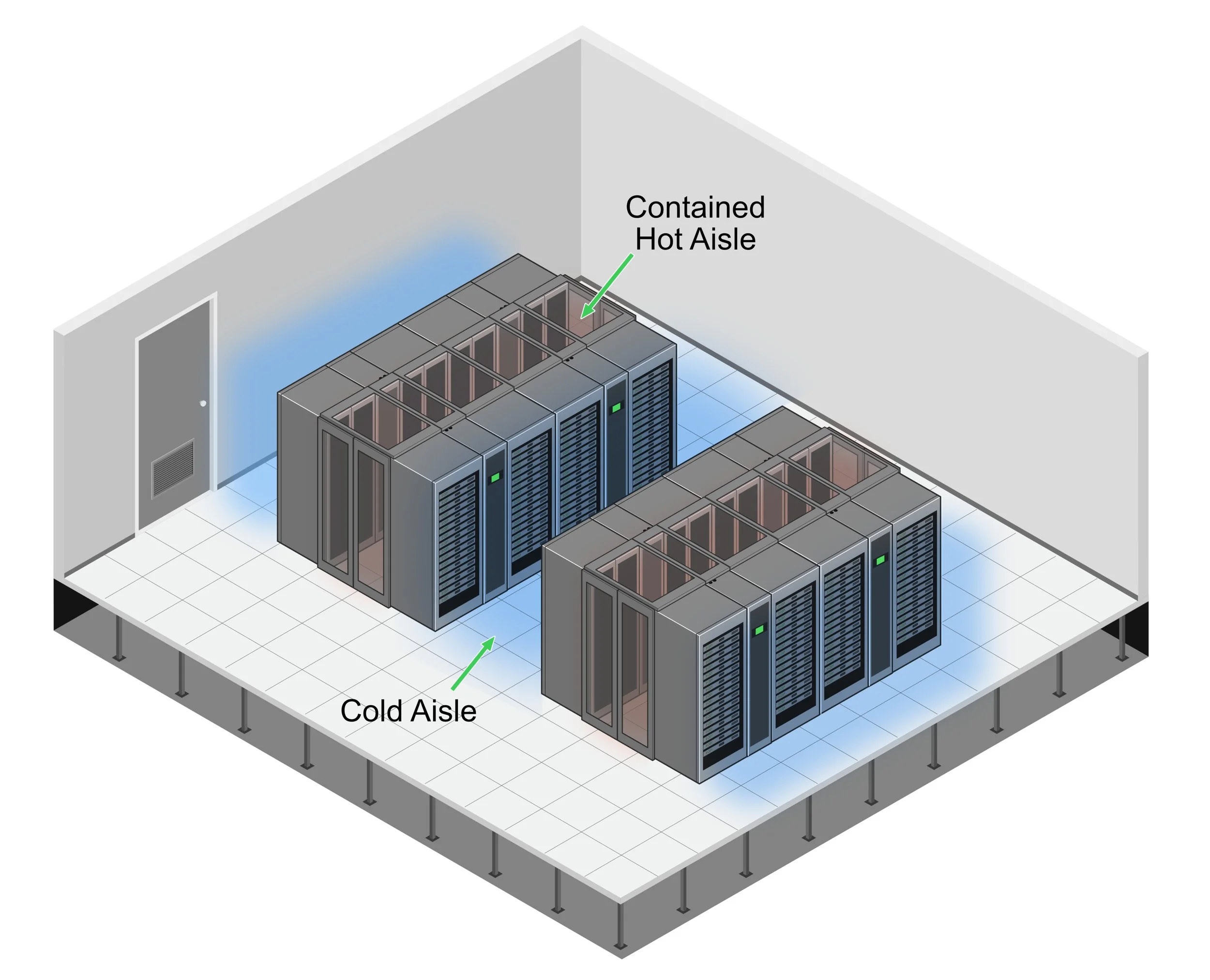

Cold Aisle Containment: Der wendige Herausforderer

Cold Aisle Containment dreht das Skript um – anstatt die heiße Luft einzupferchen, schützt es die Kaltzuluft durch die Schaffung eingehauuster kalter Gänge, wo die Fronten der Server einander zugewandt sind. Der Rest des Raums wird zu einem großen Heißluft-Rückführbereich, während Ihre kostbare Kaltluft genau dort bleibt, wo sie benötigt wird.

Warum CAC glänzt:

-

Allgemein einfacher in bestehende Rechenzentren nachzurüsten (weniger "Wir müssen alles neu aufbauen!"-Drama)

-

Kostet typischerweise weniger in der Umsetzung (Ihr Finanzteam wird Ihnen ein High-Five geben)

-

Funktioniert wunderbar mit traditioneller Doppelbodenküslung (kein Rad neu erfinden nötig)

ASHRAEs neuester Plot Twist

Die American Society of Heating, Refrigerating and Air-Conditioning Engineers (ASHRAE) Technical Committee 9.9 veröffentlichte 2021 ihre 5. Ausgabe der thermischen Richtlinien, und sie sind so spannend wie jedes Staffelfinale (zumindest für Kühlungsnerds wie mich).

Wichtige Updates umfassen:

-

Eine neue Geräteklasse (H1) für hochdichte Computer mit strengeren Temperaturanforderungen: 18°C bis 22°C (64,4°F bis 71,6°F)

-

Überarbeitete Feuchtigkeitsrichtlinien, die von gasförmigen Kontaminationsgraden abhängen

-

Eine Empfehlung zur Implementierung von Silber- und Kupfer-"Reaktivitätscoupons" zur Überwachung von Korrosionsraten

Es ist, als hätte ASHRAE gesagt: "Gerade als Sie dachten, Sie verstünden Rechenzentrumsküslung, hier ist eine völlig neue Herausforderung!" Aber sie liegen nicht falsch – da Computerdichte zunimmt und Hardware fortschreitet, entwickeln sich Kühlungsanforderungen im Gleichschritt.

Die Ärmel hochkrempeln: Die Umsetzung in der realen Welt

Sie sind also überzeugt, dass es nicht die beste Strategie ist, heiße und kalte Luft in Ihrem Rechenzentrum kämpfen zu lassen. Kluge Entscheidung! Ich ging einmal in den Serverraum eines Kunden, wo sie kleine Papierwindräder von der Decke gehängt hatten, um zu "sehen, wohin die Luft ging." Niedlich, aber nicht gerade wissenschaftlich.

Lassen Sie uns mit der echten Arbeit die Hände schmutzig machen:

Schritt 1: Werden Sie ein Luftstrom-Detektiv

Bevor Sie ausgefallene Einhaususngs-Hardware bestellen, müssen Sie verstehen, was in Ihrem Rechenzentrum passiert. Diese Lektion lernte ich auf die harte Tour, nachdem ich enthusiastisch Einhaususng in einer kleinen Einrichtung installierte, nur um zu entdecken, dass wir gerade effizient die falschen Luftstromuster eingehaust hatten. Ups.

Schnappen Sie sich diese Wärmebildkameras (sie lassen Sie sich wie Predator fühlen, der Server-Wärmesignaturen jagt) und beginnen Sie mit der Kartierung. Wo verstecken sich Ihre Hotspots? Welche Racks betreiben heimlich ihr eigenes Sauna-Geschäft? Ich habe Racks gesehen, die auf dem Papier gut aussahen, aber heiße Luft in Mustern rezirkulierten, die einen Meteorologen schwindelig machen würden.

Der coolste Teil? Wärmekarten zu erstellen, die so dramatisch aussehen, dass Sie sie als moderne Kunst rahmen könnten. Meine Lieblingskarte war eine besonders chaotische Einrichtung, wo wir das Wärmebild "Dantes Inferno: Die Server-Edition" nannten. Ihr Finanzteam schätzt vielleicht nicht den künstlerischen Wert, aber sie werden die Visualisierung ihrer Kühlungsdollars verstehen, die in dünner Luft verschwinden.

Schritt 2: Design & Planung (Zeichnen Sie Ihre Schlachtpläne)

Wählen Sie Ihren Einhaususngstyp basierend auf Ihren spezifischen Umständen. Berücksichtigen Sie:

-

Wärmedichte (HAC für die Hot-Rod-Server, CAC für die bescheideneren Setups)

-

Bestehende Infrastruktur (mit dem arbeiten, was Sie haben)

-

Ihr Budget (denn selbst die coolsten Lösungen brauchen finanzielle Genehmigung)

Führen Sie Computational Fluid Dynamics (CFD) Modellierung durch, um Luftstrommuster zu simulieren. Es ist wie eine Kristallkugel für Luftbewegung zu haben – Sie können Probleme vorhersagen, bevor sie auftreten.

Schritt 3: Installation (Bauen Sie Ihre Festung)

Zeit, körperlich zu werden! Installieren Sie Ihre Einhaususngs-Komponenten:

-

Montieren Sie Türen, die einen U-Boot-Kapitän stolz machen würden (luftdicht ist das Ziel)

-

Installieren Sie Dachsysteme, die Brandschutz-Integration handhaben können

-

Versiegeln Sie jede Lücke, als würden Sie sich auf eine thermische Apokalypse vorbereiten

Das Ziel ist ein System mit weniger als 2% Luftleckage. Denken Sie daran: Lecks sind Ihr Feind bei der Einhaususng, wie bei der Raumfahrt.

Schritt 4: Optimierung (Feinabstimmung Ihrer Maschine)

Sobald Ihr Einhaususngs-System läuft:

-

Implementieren Sie 100% Blanking-Panel-Abdeckung (diese leeren Rack-Räume sind nicht nur Schandflecken – sie sind Effizienz-Killer)

-

Verwalten Sie Ihre Kabel wie ein Perfektionist (Luftstrom-Hindernisse sind Kühlungs-Saboteure)

-

Erhöhen Sie schrittweise die Kühlungstemperatur-Sollwerte, um die Effizienz zu maximieren, während Sie innerhalb der ASHRAE-Richtlinien bleiben.

Der ROI-Rechner: Ihren Gewinn messen

Sprechen wir über Zahlen, denn irgendwann wird jemand fragen, ob all diese Einhaususng es wert war:

-

Implementierungskosten: 400-1.500 $ pro Rack-Position (je nachdem, ob Sie HAC oder CAC wählen und wie ausgefallen Ihre Materialien sind)

-

Energieeinsparungen: 20-40% der Kühlungskosten (das sind viele Nullen über die Zeit)

-

Amortisationszeit: So kurz wie 6-18 Monate für einfachere Lösungen

Außerdem verlängern konstantere Temperaturen die Gerätelebensdauer. Es ist, als würden Sie Ihren Servern eine Gesundheitsspa-Behandlung geben – sie werden es Ihnen mit weniger Ausfällen und längerem Service danken.

Ihren Kämpfer wählen: HAC vs. CAC Showdown

Können Sie sich noch nicht entscheiden, welches Einhaususngs-System Ihre Liebe verdient? Hier ist eine schnelle Entscheidungsmatrix, die durch die Verwirrung schneidet:

Die Zukunft weht (vorsichtig) herein

Die Einhaususngs-Welt steht nicht still. Aufkommende Trends umfassen:

-

Hybrid-Kühlungsansätze: Kombination von Gang-Einhaususng mit Flüssigkühlung für diese Server-Racks, die heißer laufen als die Merkuroberfläche

-

Modulare, vorgefertigte Einhaususng: Denken Sie an LEGO-Sets für Rechenzentren – Zusammensteck-Lösungen für schnelle Bereitstellung

-

Smart Einhaususngs-Systeme: AI-gesteuerte, dynamisch anpassbare Einhaususng, die auf sich ändernde Kühlungsbedürfnisse schneller reagiert, als Sie "Temperaturspitze" sagen können

Das Fazit

Ordnungsgemäße Gang-Einhaususng ist nicht nur ein Effizienz-Spielzug – sie wird zu einem Grundpfeiler für jeden ernsten Rechenzentrumsbeirieb. Da Computerdichte zunimmt und Nachhaltigkeitsdruck steigt, müssen moderne Rechenzentren das freie Vermischen von heißer und kalter Luft eliminieren.

Ob Sie HAC oder CAC wählen, hängt von Ihren spezifischen Umständen ab, aber die Entscheidung, irgendeine Form der Einhaususng zu implementieren, sollte überhaupt keine Frage sein. Ihre Server, Energierechnung und der Planet werden Ihnen alle danken.

Also gehen Sie hinaus und hausen Sie ein! Das thermische Schlachtfeld Ihres Rechenzentrums wartet auf seinen General, und diese Luftströme trennen sich nicht von selbst.

Bereit, den Luftstrom Ihres Rechenzentrums zu optimieren?

Lassen Sie Ihre Server nicht weiterhin ihren thermischen Tauziehen-Krieg fortsetzen. Unser Expertenteam entwirft und implementiert maßgeschneiderte Einhaususngs-Lösungen, die Kühlungskosten drastisch senken und gleichzeitig die Gerätelebensdauer verlängern.

Holen Sie sich eine Einhaususngs-Beratung →

Referenzen

-

ASHRAE TC 9.9, "Thermal Guidelines for Data Processing Environments," 5. Ausgabe, 2021. ASHRAE Datacom Encyclopedia

-

ANSI/TIA-942, "Telecommunications Infrastructure Standard for Data Centers." TechTarget Definition

-

Uptime Institute, "New ASHRAE Guidelines Challenge Efficiency Drive," 2021. Uptime Institute Blog

-

Energy Star, "Move to a Hot Aisle/Cold Aisle Layout." Energy Star

-

DataBank, "Optimizing Data Center Cooling: The Power Of Hot And Cold Aisle Containment," 2024. DataBank Blog

-

Upsite Technologies, "Hot Aisle Containment vs. Cold Aisle Containment: Benefits and Challenges," 2025. Upsite Blog

-

Subzero Engineering, "Hot Aisle Containment in Data Centers." Subzero Engineering

-

Subzero Engineering, "Cold Aisle Containment in Data Centers." Subzero Engineering

-

Data Centre Magazine, "Hot Aisle Containment – Keeping Data Centres Cool," 2022. Data Centre Magazine

-

AnD Cable Management, "Hot and Cold Aisle Containment in Data Centers," 2024. AnD Cable Blog

-

Upsite Technologies, "What You Need to Know About ASHRAE's Fifth Edition of Thermal Guidelines," 2021. Upsite Blog