## なぜAIデータセンターは2年前とは全く異なる姿になったのか

NVIDIA の電力平滑化技術により、グリッド需要が30%削減されています。液体冷却により1,600WのGPUに対応可能です。賢明な企業は350%のROIを実現している一方で、他社は80%の失敗率に直面しています。

GPU インフラストラクチャ、AI、データセンターに関する知見。

NVIDIA の電力平滑化技術により、グリッド需要が30%削減されています。液体冷却により1,600WのGPUに対応可能です。賢明な企業は350%のROIを実現している一方で、他社は80%の失敗率に直面しています。

AIワークロードがラック密度を100kWを超えて押し上げる中、データセンターはデータフロー用の構造化配線と熱除去用の液冷の両方をマスターしなければなりません。GPUを最高のパフォーマンスで稼働させ続けるインフラストラクチャを設計する方法を学びましょう。

データセンターは私たちのデジタル世界を支えていますが、膨大なリソースを消費します。液体冷却や節水からスマートなサイト選定、グリーン建設まで、ESG目標を達成しながらコストを削減する持続可能な設計の実証された戦略を学びましょう。

NVIDIAのGB300 NVL72は、72基のBlackwell Ultra GPU、GPU当たり288 GBメモリ、130 TB/sのNVLinkバンド幅により、GB200の1.5倍のAI性能を提供します。これらの120 kW AIデータセンターキャビネットの電力、冷却、ケーブリングについて、導入エンジニアが知るべき情報をお伝えします。

AIブームがデータセンターインフラへの前例のない需要を牽引していますが、オペレーターの半数以上がキャパシティ成長を脅かす深刻な人材不足に直面しています。Introlのワークフォース・アズ・ア・サービスモデルは、認定技術者を数ヶ月ではなく数日で提供し、ハイパースケールサイトを最高速度で立ち上げることを可能にします。

シンガポール時間の午前3時に50,000基のGPUクラスターがクラッシュした時、4時間対応と24時間対応の違いは、数ヶ月分の研究に相当します。Introlの257のグローバル拠点が、地理的カバレッジをAIインフラ展開の競争優位性に変える方法をご覧ください。

NVIDIAのH100、H200、B200 GPUは、それぞれ異なるAIインフラのニーズに対応します—実績のあるH100の主力機種から、メモリ豊富なH200、そして画期的なB200まで。実世界でのパフォーマンス、コスト、電力要件を詳しく解説し、お客様の特定のワークロードと予算に適したGPUの選択をサポートします

予測故障解析とリモートハンズ契約により、企業がダウンタイムコストを1時間あたり最大$500,000削減する方法を学びましょう。20%のリターンを示す詳細なケーススタディとともに、AIとHPC投資を保護するROI戦略をご紹介します。

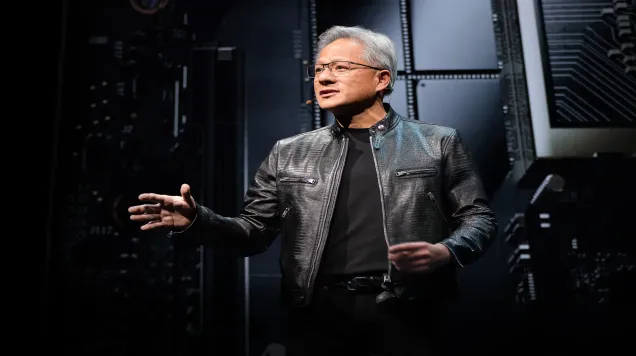

NVIDIA CEOのジェンセン・ファン氏によるComputex 2025の基調講演は、単なる製品発表ではありませんでした。それは、コンピューティングにおける第3の大きな革命への設計図だったのです。データセンターがトークンを生成する「AI工場」へと変貌を遂げる中、NVIDIAのネットワーキング、エンタープライズAI、ロボティクスにおける最新イノベーションが舞台を設定しています

HPCデータセンターの廃止は単にサーバーのプラグを抜くだけではありません。外科手術のような精度と軍事レベルの計画が必要な重要な作業です。ミッションクリティカルなデータの完全消去から、高級車よりも価値のあるコンポーネントの取り出しまで、このガイドでは廃止プロセス全体を順を追って説明します

国際ネットワークインフラを運用していますか?それぞれの国が異なるデッキからカードを配る、ハイステークスな規制ポーカーゲームをプレイしているのです。このストレートな解説ガイドでは、国境を越えた矛盾する規制要件の混乱を整理し、ネットワークアーキテクトのための実戦で検証された戦略を提供します

AI が世界中でデータセンターへの前例のない需要を牽引する中、革新的な「グリーンスワップ」コンセプトが、技術の進歩と気候目標のバランスを取るソリューションを提供しています。この画期的な金融商品は、発展途上国のクリーンエネルギープロジェクトへの資本の流れを変革し、cr

プロジェクトについてお聞かせください。72時間以内にご回答いたします。

お問い合わせありがとうございます。弊社チームがリクエストを確認し、72時間以内に回答いたします。