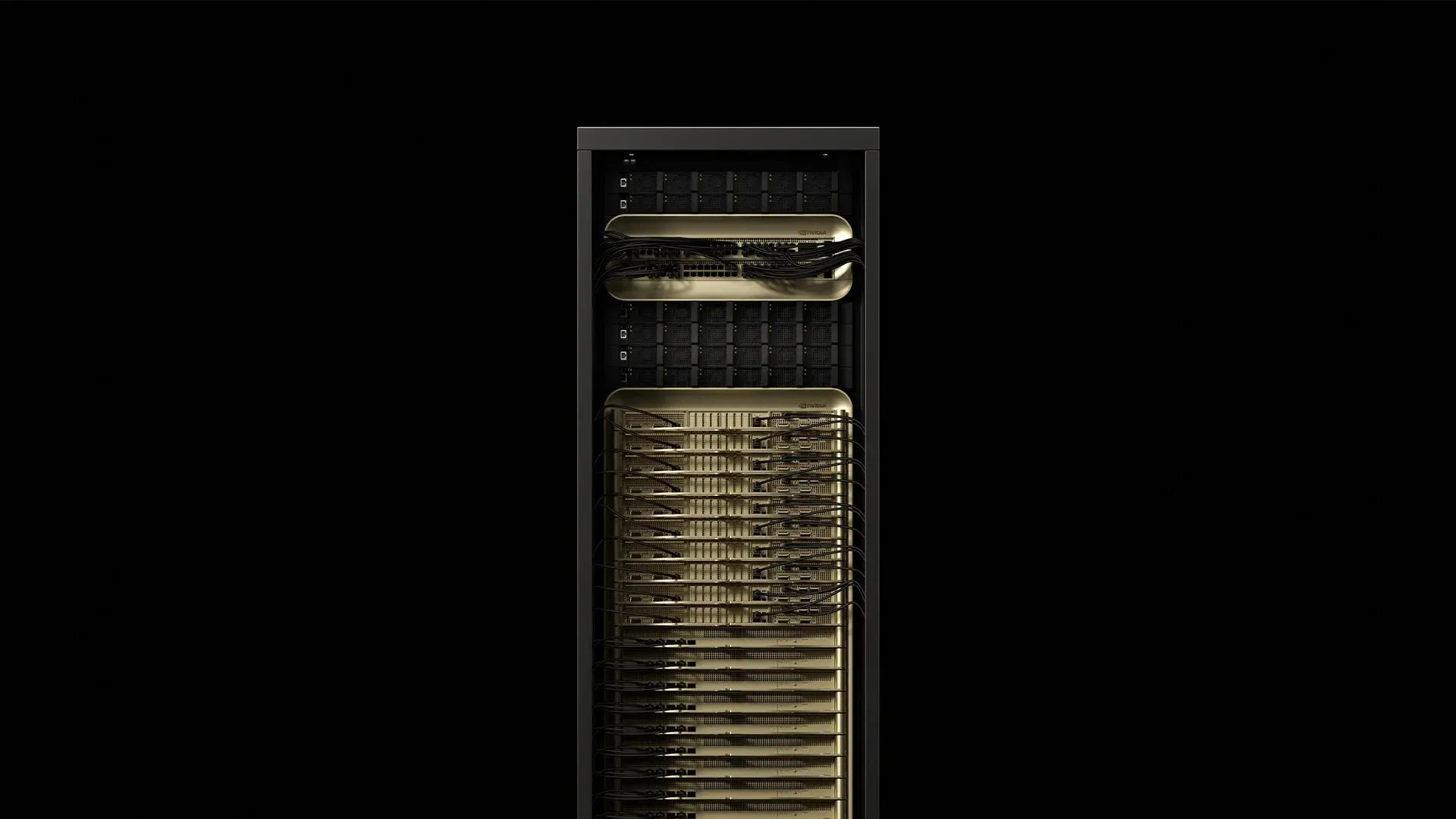

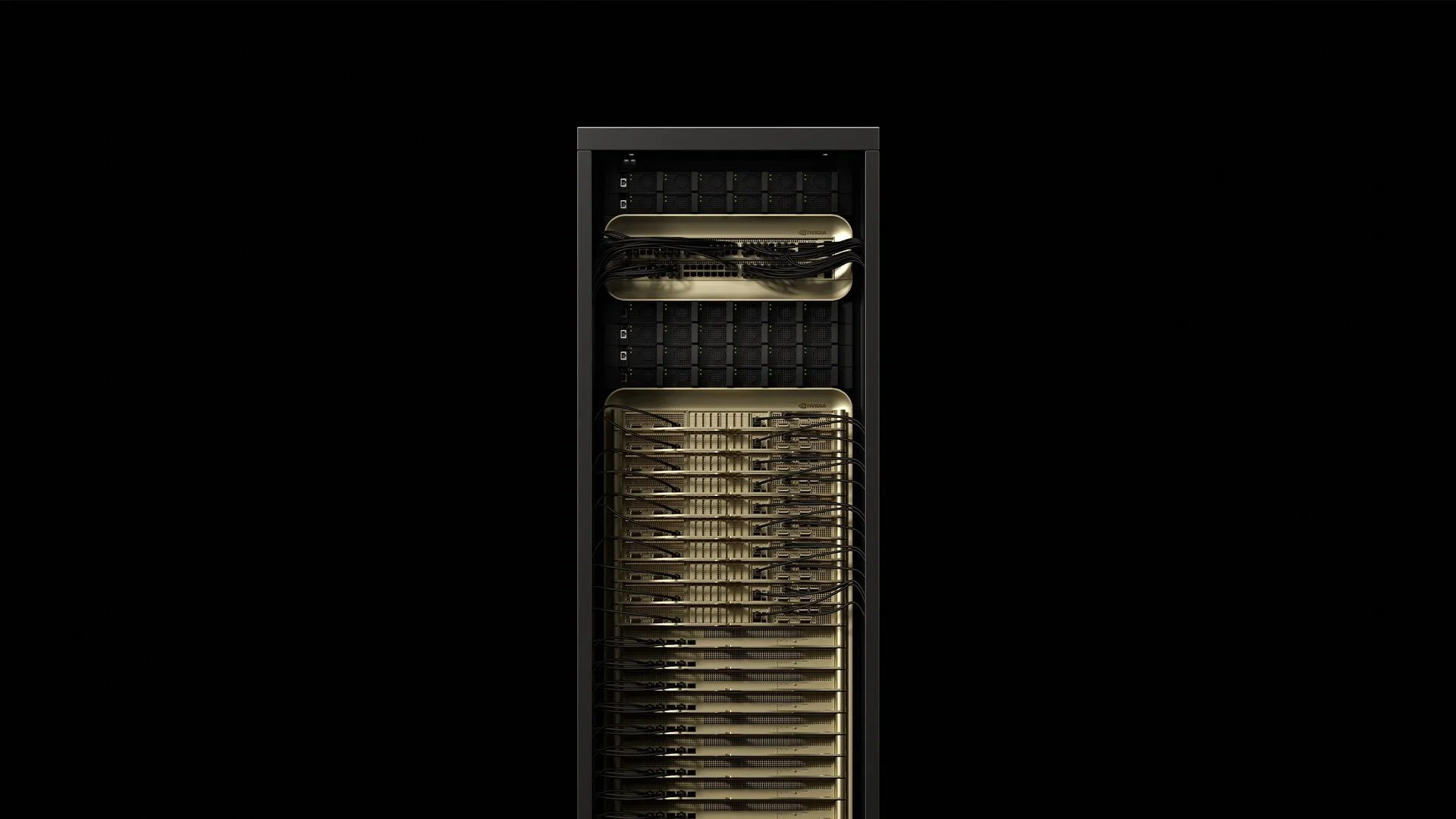

NVIDIAは72基のBlackwell Ultra GPUと36基のGrace CPUを液冷ラックスケールユニットに統合し、約120 kWを消費し、1.1 exaFLOPSのFP4計算性能を提供するGB300 NVL72を開発しました。これは元のGB200 NVL72より1.5倍高いAI性能を実現しています[^2025]。この単一キャビネットは、現代のデータセンター内の電力、冷却、ケーブリングに関するすべての前提を覆します。導入エンジニアが初回本格的なGB300 NVL72導入の準備をする中で得られた知見をご紹介します。

1. ラックの詳細

[caption id="" align="alignnone" width="1292"] コンポーネント数量主要仕様消費電力ソースGrace‑Blackwell演算トレイ181台当たり~6.5 kW合計117 kWSupermicro 2025NVLink‑5スイッチトレイ9アグリゲート130 TB/sファブリック合計3.6 kWSupermicro 2025電源シェルフ8合計DC出力132 kWオーバーヘッド0.8 kWSupermicro 2025Bluefield‑3 DPU18ストレージ・セキュリティオフロード演算に含まれるThe Register 2024 [/caption]

コンポーネント数量主要仕様消費電力ソースGrace‑Blackwell演算トレイ181台当たり~6.5 kW合計117 kWSupermicro 2025NVLink‑5スイッチトレイ9アグリゲート130 TB/sファブリック合計3.6 kWSupermicro 2025電源シェルフ8合計DC出力132 kWオーバーヘッド0.8 kWSupermicro 2025Bluefield‑3 DPU18ストレージ・セキュリティオフロード演算に含まれるThe Register 2024 [/caption]

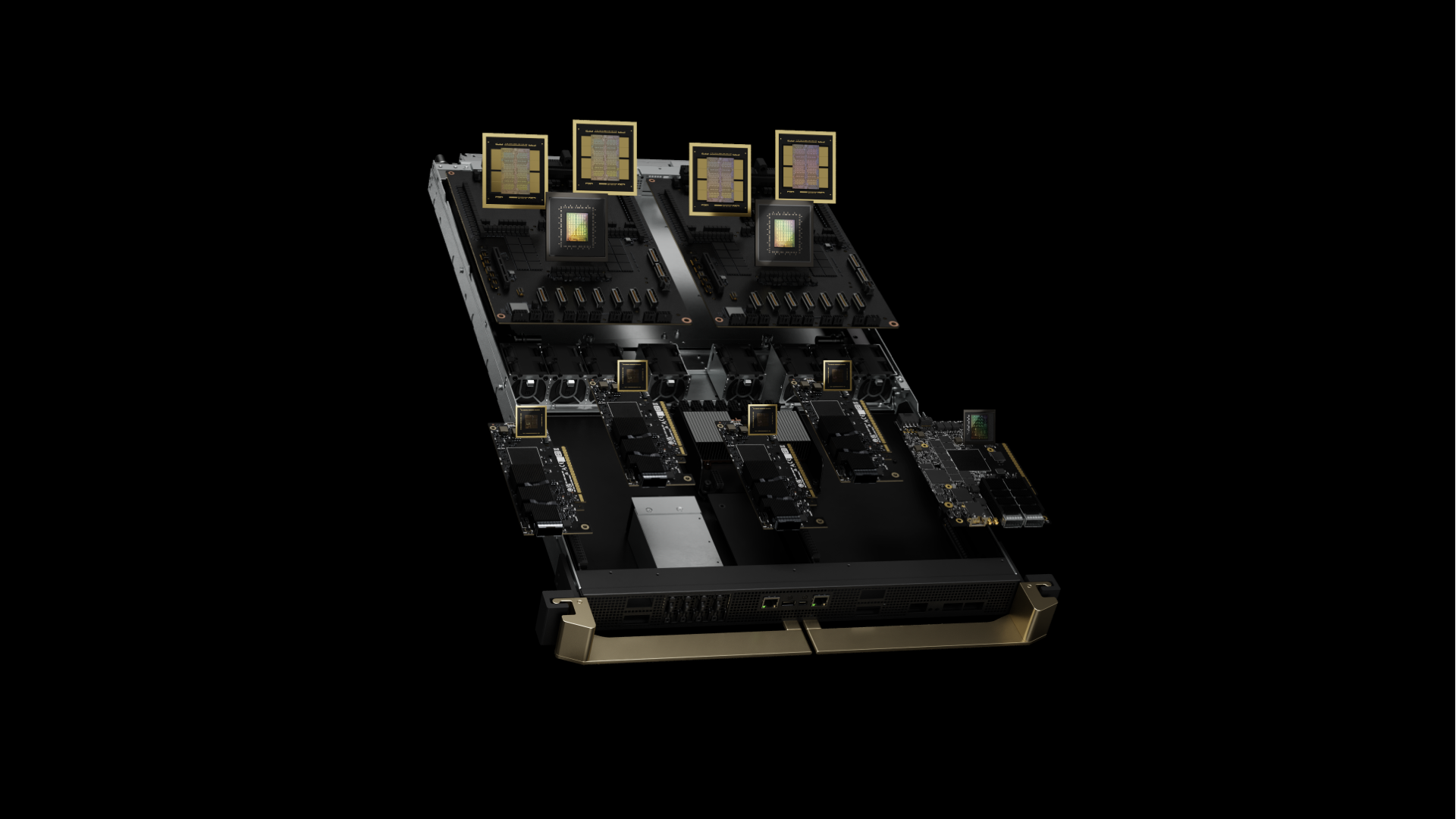

キャビネットの重量は約1.36 t(3,000 lb)で、従来の42Uラックと同じ設置面積を占有します[^2024]。GB300 NVL72はBlackwell Ultraを搭載し、従来のB200の192 GBと比べて50%増となる、GPU当たり288 GB HBM3eメモリを持つ強化されたB300 GPUを特徴としています。これは8-highではなく12-high HBM3eスタックによって実現されています。各スーパーチップは、従来の2-GPU構成と比べ、4基のB300 GPUと2基のGrace CPUをペアリングしています。各Grace‑Blackwellスーパーチップは、2.6 GHzで動作する72基のBlackwell Ultra GPUコアと、ベース周波数3.1 GHzで動作する72コアArm Neoverse V2 CPUをペアリングしています。統合されたHBM3eメモリは、GPU当たり8 TB/sの帯域幅と288 GBの容量を提供します。

現場の知見: 演算リソースが上部トレイに密集配置されているため、ラックの重心は標準サーバーより18%高くなっています。フルロード動作時に観測される微振動に対処するため、標準のケージナットではなくM12ボルトでマウンティングレールを固定することがベストプラクティスとなっています。

2. 電力供給の要件

GB300 NVL72ラックには内蔵PSUシェルフが付属し、フルロード時に94.5%の効率を実現します。混合精度トレーニングワークロード時のピーク消費電力は120.8 kWに達し、電力品質アナライザーでは通常0.97の力率が記録されます。

電圧トポロジーの比較:

-

208V/60Hz:335Aライン電流、4/0 AWG銅線(107mm²)が必要

-

415V/50‑60Hz:168Aライン電流、70mm²銅線のみ必要

-

480V/60Hz:145Aライン電流、北米での導入は最小限

業界のベストプラクティスでは、160A IEC 60309コネクタ経由でラック当たり415V三相デュアル給電をプロビジョニングします。この選択により、208Vと比較してI²R損失が75%削減され、ヨーロッパの設備標準との互換性が維持されます。現場測定では、22°C室内でブレーカーパネルが通常85%温度ディレーティング以下に保たれることが示されています。

高調波緩和: GB300 NVL72ラックは、典型的なAIトレーニング負荷下で4.8%の全高調波歪みを示します。8ラックを超える導入では、IEEE 519準拠を維持するため、専用トランス上の12パルス整流器が通常必要となります。

3. 冷却プレイブック:熱工学の現実

各Blackwell Ultra GPUダイは744 mm²の大きさで、コールドプレートインターフェースを通じて最大1,000 Wを放熱します。Grace CPUは72コア全体でさらに500Wを追加します。DellのIR7000プログラムでは、Blackwellクラス機器のデフォルトパスとして液冷を位置づけ、密閉型リアドア熱交換器でラック当たり最大480 kWの容量を主張しています[^2024]。

推奨される熱階層:

-

≤80 kW/ラック:リアドア熱交換器、18°C供給水、35 L/min流量

-

80–132 kW/ラック:ダイレクト・トゥ・チップ(DTC)ループが必須、15°C供給、最小30 L/min

-

132 kW/ラック:浸漬冷却またはスプリットラック構成が必要

現場導入からのDTC仕様:

-

コールドプレートΔT:フルロード時12–15°C(GPU接合部温度83–87°C)

-

圧力降下:30%プロピレングリコールでの完全ループを通じて2.1 bar

-

流量分配:全72 GPU コールドプレート間で±3%の変動

-

漏れ率:

重要な知見: Blackwell Ultraの電力供給ネットワークは、勾配同期中に定常状態電力の1.4倍に達するマイクロ秒スケールの過渡現象を示します。業界のプラクティスでは、GPUスロットリングなしにこれらの熱スパイクを処理するため、定格TDPの110%で冷却をサイジングすることを推奨しています。

4. ネットワークファブリック:NVLink 5.0と強化された接続性の管理

各GB300 NVL72には、NVLink 5.0を搭載した72基のBlackwell Ultra GPUが含まれ、GPU当たり1.8 TB/sの帯域幅と、システム全体で130 TB/sの総NVLink帯域幅を提供します。第5世代NVLinkは、リンク当たり200 Gbpsのシグナリングレートで動作し、GPU当たり18リンクを持ちます。9基のNVSwitchチップが300ナノ秒のスイッチ遅延でこのトラフィックをルーティングし、576-way GPU-to-GPU通信パターンをサポートします。

ラック間接続には、従来世代の400 Gb/sの2倍となる、GPU当たり800 Gb/sのネットワーク接続を提供するConnectX-8 SuperNICが採用され、NVIDIA Quantum-X800 InfiniBandとSpectrum-X Ethernetプラットフォームの両方をサポートします。

ケーブリング アーキテクチャ:

-

ラック内:1,728本の銅Twinaxケーブル(100Ω差動インピーダンス、

-

ラック間:OM4 MMF上800Gトランシーバー経由90ポートのQSFP112

-

ストレージ/管理:18基のBluefield‑3 DPU、それぞれ2本の800Gリンク

現場測定:

-

光学バジェット:150m OM4スパンで1.5 dB挿入損失バジェット

-

BER性能:

-

コネクタ密度:ラック当たり1,908個の終端(電源を含む)

ベストプラクティスでは、APC研磨の事前終端144ファイバートランクアセンブリを出荷し、すべてのコネクタをTIA-568標準に従って挿入損失/反射損失テストで検証します。経験豊富な2人のクルーは、平均2.8時間でGB300 NVL72ファイバー設置を完了できます。これは技術者が現場でケーブルを構築する場合の7.5時間から短縮されています。

信号完全性の知見: NVLink‑5は25 GBd PAM‑4シグナリングで動作します。一般的な設置では、Twinax接続当たり2.1 dBの挿入損失バジェットを維持し、

5. 現場検証済み導入チェックリスト

構造要件:

-

床荷重:分散荷重≥21 kN/m²(~440 psf)を認定;0.64 m²フットプリント上の1,360 kgラックから計算。注:NVIDIAは公式の床荷重仕様を公開していません。特定の設置については構造エンジニアに確認してください。

-

耐震ブレーシング:Zone 4設置では、IBC 2021に従って追加のX-ブレーシングが必要

-

振動絶縁:

電力インフラ:

-

Schneider PM8000分岐回路監視付きデュアル415V給電、160Aずつ

-

UPSサイジング:ラック当たり150 kVA(125%安全マージン)、オンライン二重変換トポロジー

-

接地:機器接地の分離、

冷却仕様:

-

冷却剤品質:

-

フィルター交換:5 µmプリーツ1,000時間毎、1 µm最終2,000時間毎

-

漏れ検出:すべてのQDCフィッティングで0.1 mL感度の導電性流体センサー

スペアパーツ在庫:

-

NVSwitchトレイ1個(リードタイム:6週間)

-

CDUポンプカートリッジ2個(MTBF:8,760時間)

-

QSFP112トランシーバー20個(現場故障率:年間0.02%)

-

緊急熱界面材料(Honeywell PTM7950、5gチューブ)

リモートハンドSLA:4時間オンサイト対応が業界標準となりつつあり、主要導入パートナーは複数国でこの目標を>99%のアップタイムで維持しています。

6. 本格運用負荷下での性能特性

AI推論ベンチマーク(初期導入レポートから):

-

DeepSeek R1-671Bモデル:最大1,000 tokens/second持続スループット

-

GPT‑3 175Bパラメータモデル:GPU平均847 tokens/second

-

Stable Diffusion 2.1:1024×1024解像度で14.2 images/second

-

ResNet‑50 ImageNetトレーニング:持続スループット2,340 samples/second

電力効率スケーリング:

-

単一ラック利用:95% GPU利用時1.42 GFLOPS/Watt

-

10ラッククラスター:1.38 GFLOPS/Watt(冷却オーバーヘッドが効率を低下)

-

ネットワークアイドル電力:ラック当たり3.2 kW(NVSwitch + トランシーバー)

AI推論性能向上: GB300 NVL72は、ユーザー当たりトークン/秒で10倍の向上、Hopperと比較してTPS per megawattで5倍の改善を実現し、AI工場出力性能の潜在的50倍増加をもたらします。

熱サイクル効果:本格運用2,000時間後、初期導入では熱界面材料のポンプアウトによる0.3%の性能劣化が報告されています。18ヶ月間隔でのTIM交換によりピーク性能が維持されます。

7. クラウド対オンプレミス TCO分析

Lambdaは複数年コミットメントでB200 GPUを最安GPU時間当たり2.99ドルで提供しています(Lambda 2025)。業界導入からの実際の施設コストを組み込んだ財務モデリングでは以下を示しています:

36ヶ月間のラック当たりコスト内訳:

-

ハードウェアCapEx:GB300 NVL72で370-400万ドル(スペアとツールを含む)

-

設備電力:平均85%利用で$0.08/kWhで31万ドル

-

冷却インフラ:18万ドル(CDU、配管、制御)

-

運用スタッフ:24万ドル(0.25 FTE完全負荷コスト)

-

総計:443-473万ドル対470万ドルクラウド相当

償却、融資、機会費用を考慮して、18ヶ月間で平均67%利用率で損益分岐点を迎えます。企業CFOは、クラウドベンダーロックインを回避しながら予算予測可能性を獲得します。

8. GB300 対 GB200:Blackwell Ultraの理解

[caption id="" align="alignnone" width="1920"] 前世代GB200の写真 [/caption]

前世代GB200の写真 [/caption]

GB300 NVL72(Blackwell Ultra)は、元のGB200 NVL72からの大幅な進化を表しています。主要な改良点には、1.5倍のAI計算性能、GPU当たり288 GB HBM3eメモリ(対192 GB)、AI推論アプリケーションのテスト時スケーリング推論への強化されたフォーカスが含まれます。

新しいアーキテクチャは、ユーザー当たりトークン/秒で10倍の向上、Hopperと比較してTPS per megawattで5倍の改善を実現し、AI工場出力の潜在的50倍増加をもたらします。これにより、GB300 NVL72は、DeepSeek R1のようなモデルが精度向上のために推論時に大幅により多くの計算を必要とするAI推論の新時代に特化して最適化されています。

可用性タイムライン: GB300 NVL72システムは2025年後半にパートナーから提供予定で、現在利用可能なGB200 NVL72と比較されます。

9. Fortune 500企業が専門導入パートナーを選ぶ理由

主要な導入スペシャリストは、850以上のデータセンターに10万基を超えるGPUを設置し、広範囲なフィールドエンジニアリングチームを通じて4時間のグローバルサービスレベル合意(SLA)を維持しています。業界は2022年以来、何千マイルものファイバーと数メガワットの専用AIインフラを稼働させています。

最近の導入メトリクス:

-

平均サイト準備タイムライン:6.2週間(業界平均11週間から短縮)

-

初回成功率:電源投入テストで97.3%

-

導入後問題:最初の90日間で0.08%のコンポーネント故障率

OEMはハードウェアを出荷し、専門パートナーはハードウェアを本格インフラに変換します。計画段階で経験豊富な導入チームと協力することで、プリファブ電力ハーネス、事前ステージ冷却ループ、工場終端ファイバーバンドルの使用により、タイムラインを45%短縮できます。

結論

GB300 NVL72キャビネットは、「ラック内のサーバー」から「キャビネット内のデータセンター」への根本的シフトを表しています。物理学は容赦ありません:120 kWの計算密度は、すべての電力接続、冷却ループ、ファイバー終端の精密さを要求します。初日にエンジニアリングの基礎をマスターすれば、Blackwell Ultraは今後数年間にわたって変革的なAI推論性能を提供します。

2,000語に収まりきらなかった技術的詳細について話し合いたいですか?私たちの導入エンジニアはこのような会話を歓迎します。solutions@introl.comで技術的深掘りをスケジュールしてください。

参考文献

Dell Technologies. 2024. "Dell AI Factory Transforms Data Centers with Advanced Cooling, High-Density Compute and AI Storage Innovations." Press release, October 15. Dell Technologies Newsroom

Introl. 2025. "GPU Infrastructure Deployments and Global Field Engineers." Accessed June 23. introl.com

Lambda. 2025. "AI Cloud Pricing - NVIDIA B200 Clusters." Accessed June 23. Lambda Labs Pricing

NVIDIA. 2025. "GB300 NVL72 Product Page." Accessed June 23. NVIDIA Data Center

NVIDIA. 2025. "NVIDIA Blackwell Ultra AI Factory Platform Paves Way for Age of AI Reasoning." Press release, March 18. NVIDIA News

Supermicro. 2025. "NVIDIA GB300 NVL72 SuperCluster Datasheet." February. Supermicro Datasheet

The Register. 2024. Mann, Tobias. "One Rack, 120 kW of Compute: A Closer Look at NVIDIA's DGX GB200 NVL72 Beast." March 21. The Register

訂正(2026年1月9日):床荷重仕様を「14 kN/m²(2,030 psf)」から「21 kN/m²(~440 psf)」に訂正しました。元の記述には単位変換エラーが含まれていました。また、これがラック重量とフットプリントに基づく計算値であり、NVIDIAの公式仕様ではないことを明確にしました。Twinaxインピーダンスを75Ωから100Ω差動に訂正しました。床荷重エラーを指摘してくれたDianaに感謝します。