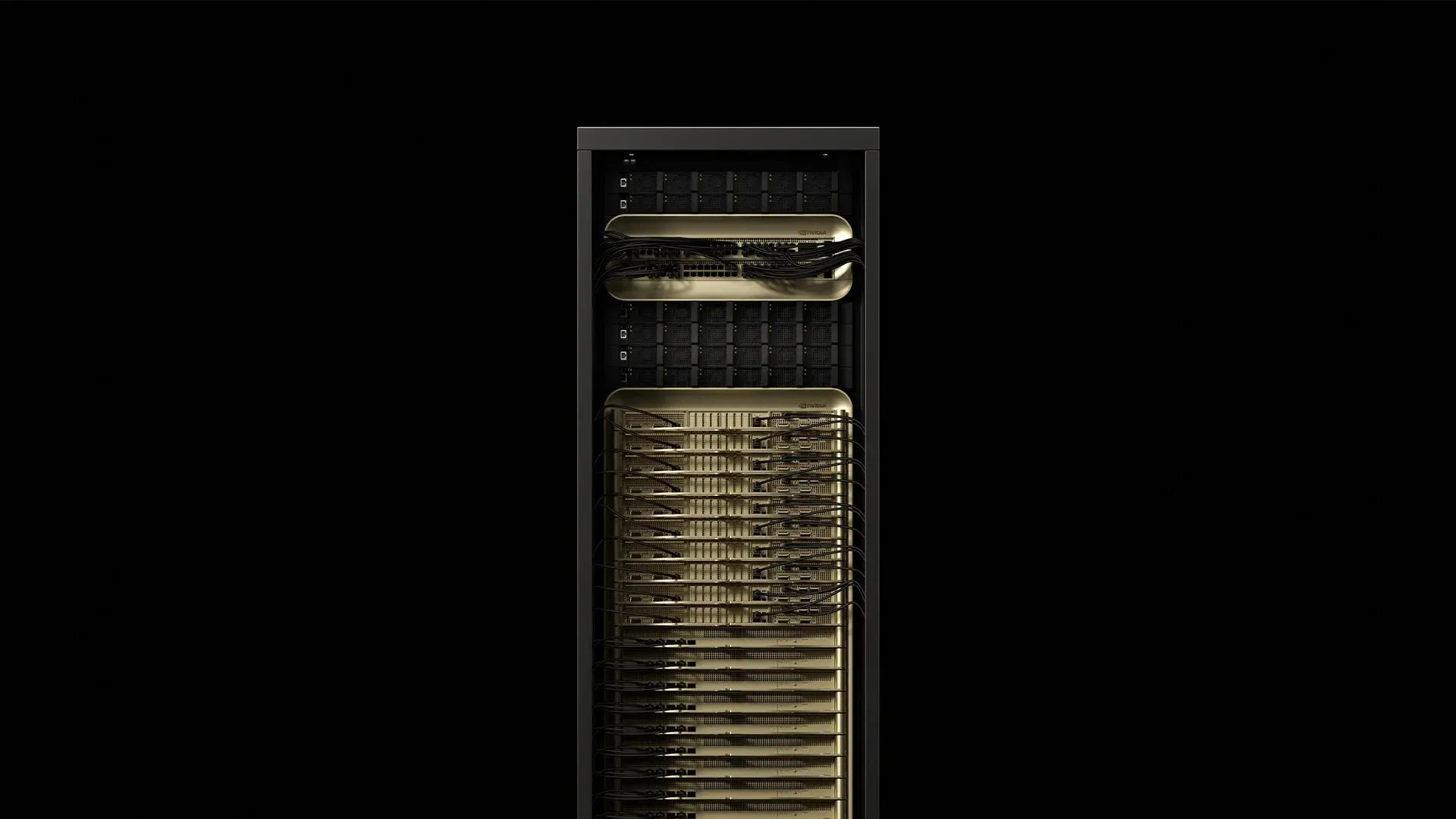

NVIDIA đã kết hợp 72 GPU Blackwell Ultra và 36 CPU Grace thành một đơn vị cấp rack làm mát bằng chất lỏng tiêu thụ khoảng 120 kW và cung cấp 1.1 exaFLOPS sức mạnh tính toán FP4 với GB300 NVL72—hiệu suất AI cao gấp 1.5 lần so với GB200 NVL72 ban đầu [^2025]. Chiếc tủ rack đó thay đổi mọi giả định về nguồn điện, làm mát và cáp mạng bên trong các trung tâm dữ liệu hiện đại. Đây là những gì các kỹ sư triển khai đang học hỏi khi họ chuẩn bị các địa điểm cho việc giao hàng sản xuất GB300 NVL72 đầu tiên.

1. Phân tích tủ rack

[caption id="" align="alignnone" width="1292"] ComponentCountKey specPower drawSourceGrace‑Blackwell compute trays18~6.5 kW each117 kW totalSupermicro 2025NVLink‑5 switch trays9130 TB/s aggregate fabric3.6 kW totalSupermicro 2025Power shelves8132 kW total DC output0.8 kW overheadSupermicro 2025Bluefield‑3 DPUs18Storage & security offloadIncluded in computeThe Register 2024 [/caption]

ComponentCountKey specPower drawSourceGrace‑Blackwell compute trays18~6.5 kW each117 kW totalSupermicro 2025NVLink‑5 switch trays9130 TB/s aggregate fabric3.6 kW totalSupermicro 2025Power shelves8132 kW total DC output0.8 kW overheadSupermicro 2025Bluefield‑3 DPUs18Storage & security offloadIncluded in computeThe Register 2024 [/caption]

Tủ rack nặng khoảng 1.36 t (3,000 lb) và chiếm cùng diện tích với một rack 42U thông thường [^2024]. GB300 NVL72 đại diện cho Blackwell Ultra, có tính năng nâng cao với GPU B300 với 288 GB bộ nhớ HBM3e trên mỗi GPU (nhiều hơn 50% so với 192 GB của B200 ban đầu) đạt được thông qua các stack HBM3e 12-high thay vì 8-high. Mỗi superchip hiện ghép nối bốn GPU B300 với hai CPU Grace, so với cấu hình hai GPU ban đầu. Mỗi superchip Grace‑Blackwell ghép nối 72 lõi GPU Blackwell Ultra ở 2.6 GHz với CPU Arm Neoverse V2 72 lõi chạy ở tần số cơ bản 3.1 GHz. Bộ nhớ HBM3e tích hợp cung cấp 8 TB/s trên mỗi GPU với dung lượng 288 GB.

Thông tin thực tế: Trọng tâm của rack nằm cao hơn 18% so với các máy chủ tiêu chuẩn do việc đặt dày đặc các tài nguyên tính toán trong các khay trên. Thực hành tốt nhất hiện khuyến nghị neo các ray lắp đặt bằng bu-lông M12, thay vì cage nuts tiêu chuẩn, để giải quyết các rung động nhỏ quan sát được trong quá trình vận hành full-load.

2. Cấp nguồn điện cho hệ thống

Một rack GB300 NVL72 được vận chuyển với các kệ PSU tích hợp, cung cấp hiệu suất 94.5% ở full load. Tiêu thụ đỉnh đạt 120.8 kW trong các workload đào tạo mixed‑precision—các bộ phân tích chất lượng điện thường ghi nhận hệ số công suất 0.97

So sánh topology điện áp:

-

208V/60Hz: Dòng điện 335A, yêu cầu dây đồng 4/0 AWG (107mm²)

-

415V/50‑60Hz: Dòng điện 168A, chỉ cần dây đồng 70mm²

-

480V/60Hz: Dòng điện 145A, triển khai tối thiểu ở Bắc Mỹ

Thực hành tốt nhất trong ngành liên quan đến việc cung cấp nguồn ba pha 415V kép mỗi rack qua các connector IEC 60309 160A. Lựa chọn này cắt giảm tổn thất I²R 75% so với 208V trong khi duy trì khả năng tương thích với các tiêu chuẩn cơ sở hạ tầng châu Âu. Các phép đo thực tế cho thấy các bảng cầu dao thường duy trì dưới 85% thermal derating trong phòng 22°C.

Giảm thiểu sóng hài: Các rack GB300 NVL72 thể hiện tổng độ méo sóng hài 4.8% dưới các tải đào tạo AI điển hình. Các triển khai vượt quá tám rack thường yêu cầu bộ chỉnh lưu 12‑pulse trên các máy biến áp chuyên dụng để duy trì tuân thủ IEEE 519.

3. Kỹ thuật làm mát: Thực tế kỹ thuật nhiệt

Mỗi die GPU Blackwell Ultra có kích thước 744 mm² và tỏa nhiệt lên đến 1,000 W thông qua giao diện cold plate. CPU Grace thêm 500W nữa trên 72 lõi của nó. Chương trình IR7000 của Dell định vị chất lỏng như con đường mặc định cho thiết bị loại Blackwell, tuyên bố khả năng mỗi rack lên đến 480 kW với các bộ trao đổi nhiệt cửa sau kín [^2024].

Hệ thống phân cấp nhiệt được khuyến nghị:

-

≤80 kW/rack: Bộ trao đổi nhiệt cửa sau với nước cung cấp 18°C, lưu lượng 35 L/min

-

80–132 kW/rack: Vòng lặp Direct‑to‑chip (DTC) bắt buộc, cung cấp 15°C, tối thiểu 30 L/min

-

132 kW/rack: Yêu cầu làm mát ngập hoặc cấu hình split‑rack

Đặc tả DTC từ các triển khai thực tế:

-

Cold plate ΔT: 12–15°C ở full load (nhiệt độ junction GPU 83–87°C)

-

Độ giảm áp suất: 2.1 bar trên toàn bộ vòng lặp với 30% propylene glycol

-

Phân phối lưu lượng: ±3% biến thiên trên tất cả 72 cold plates GPU

-

Tốc độ rò rỉ:

Thông tin quan trọng: Mạng cung cấp điện của Blackwell Ultra thể hiện các tín hiệu tạm thời ở quy mô microsecond, đạt 1.4 lần công suất steady-state trong quá trình đồng bộ hóa gradient. Thực hành trong ngành khuyến nghị thiết kế làm mát cho 110% TDP định mức để xử lý các đột biến nhiệt này mà không cần GPU throttling.

4. Mạng fabric: quản lý NVLink 5.0 và kết nối nâng cao

Mỗi GB300 NVL72 chứa 72 GPU Blackwell Ultra với NVLink 5.0, cung cấp băng thông 1.8 TB/s trên mỗi GPU và tổng băng thông NVLink 130 TB/s trên toàn hệ thống. NVLink thế hệ thứ năm hoạt động ở tốc độ tín hiệu 200 Gbps trên mỗi liên kết, với 18 liên kết trên mỗi GPU. Chín chip NVSwitch định tuyến lưu lượng này với độ trễ switch 300 nanosecond và hỗ trợ các mô hình truyền thông GPU-to-GPU 576-way.

Kết nối inter-rack hiện có SuperNICs ConnectX-8 cung cấp kết nối mạng 800 Gb/s trên mỗi GPU (gấp đôi 400 Gb/s của thế hệ trước), hỗ trợ cả nền tảng NVIDIA Quantum-X800 InfiniBand và Spectrum-X Ethernet.

Kiến trúc cáp mạng:

-

Intra‑rack: 1,728 cáp đồng Twinax (trở kháng vi sai 100‑ohm,

-

Inter‑rack: 90 cổng QSFP112 qua bộ thu phát 800G trên OM4 MMF

-

Storage/management: 18 DPU Bluefield‑3 với dual 800G links mỗi cái

Phép đo thực tế:

-

Ngân sách quang: Ngân sách tổn thất chèn 1.5 dB trên khoảng cách OM4 150m

-

Hiệu suất BER:

-

Mật độ connector: 1,908 đầu nối trên mỗi rack (bao gồm nguồn điện)

Thực hành tốt nhất liên quan đến việc vận chuyển các cụm trunk 144-fiber pre-terminated với polish APC và kiểm tra mọi connector với kiểm tra insertion-loss/return-loss theo tiêu chuẩn TIA-568. Các đội hai người có kinh nghiệm có thể hoàn thành việc lắp đặt fiber GB300 NVL72 trung bình trong 2.8 giờ—giảm từ 7.5 giờ khi kỹ thuật viên xây dựng cáp tại chỗ.

Thông tin về tính toàn vẹn tín hiệu: NVLink‑5 hoạt động với tín hiệu PAM‑4 25 GBd. Các lắp đặt điển hình duy trì ngân sách tổn thất chèn 2.1 dB trên mỗi kết nối Twinax và

5. Danh sách kiểm tra triển khai đã kiểm tra thực tế

Yêu cầu cấu trúc:

-

Tải sàn: chứng nhận ≥21 kN/m² (~440 psf) cho tải phân tán; tính toán từ rack 1,360 kg trên diện tích 0.64 m². Lưu ý: NVIDIA không công bố thông số tải sàn chính thức—xác minh với kỹ sư cấu trúc cho lắp đặt cụ thể của bạn.

-

Giằng chống động đất: Lắp đặt Zone 4 yêu cầu X‑bracing bổ sung theo IBC 2021

-

Cách ly rung động:

Cơ sở hạ tầng điện:

-

Nguồn 415V kép, mỗi cái 160A, với giám sát mạch nhánh Schneider PM8000

-

Kích thước UPS: 150 kVA trên mỗi rack (biên độ an toàn 125%) với topology double‑conversion online

-

Nối đất: Đất thiết bị cách ly với

Đặc tả làm mát:

-

Chất lượng chất làm mát:

-

Thay thế bộ lọc: 5 µm pleated mỗi 1,000 giờ, 1 µm cuối cùng mỗi 2,000 giờ

-

Phát hiện rò rỉ: Cảm biến chất lỏng dẫn điện tại tất cả các fitting QDC với độ nhạy 0.1 mL

Kho dự phòng phụ tùng:

-

Một khay NVSwitch (thời gian giao hàng: 6 tuần)

-

Hai cartridge bơm CDU (MTBF: 8,760 giờ)

-

20 bộ thu phát QSFP112 (tỷ lệ lỗi thực tế: 0.02% hàng năm)

-

Vật liệu giao diện nhiệt khẩn cấp (Honeywell PTM7950, ống 5g)

SLA remote‑hands: Phản hồi tại chỗ 4 giờ đang trở thành tiêu chuẩn ngành—các đối tác triển khai hàng đầu duy trì mục tiêu này trên nhiều quốc gia với >99% uptime.

6. Đặc tính hiệu suất dưới tải sản xuất

Benchmark AI reasoning (từ báo cáo triển khai sớm):

-

Mô hình DeepSeek R1-671B: Lên đến 1,000 tokens/giây throughput bền vững

-

Mô hình GPT‑3 175B parameter: Trung bình 847 tokens/giây/GPU

-

Stable Diffusion 2.1: 14.2 hình ảnh/giây ở độ phân giải 1024×1024

-

Đào tạo ResNet‑50 ImageNet: 2,340 mẫu/giây throughput bền vững

Tỷ lệ hiệu suất năng lượng:

-

Sử dụng rack đơn: 1.42 GFLOPS/Watt ở 95% sử dụng GPU

-

Cluster 10‑rack: 1.38 GFLOPS/Watt (overhead làm mát giảm hiệu suất)

-

Công suất mạng idle: 3.2 kW trên mỗi rack (NVSwitch + thu phát)

Cải thiện hiệu suất AI reasoning: GB300 NVL72 cung cấp tăng 10x tokens per second per user và cải thiện 5x TPS per megawatt so với Hopper, mang lại tăng tiềm năng 50x kết hợp trong hiệu suất đầu ra AI factory.

Tác động chu kỳ nhiệt: Sau 2,000 giờ vận hành sản xuất, các triển khai sớm báo cáo suy giảm hiệu suất 0.3% do pump‑out vật liệu giao diện nhiệt. Thay thế TIM định kỳ sau 18 tháng duy trì hiệu suất đỉnh.

7. Phân tích TCO cloud so với on‑prem

Lambda cung cấp GPU B200 với giá chỉ $2.99 mỗi giờ GPU với cam kết nhiều năm (Lambda 2025). Mô hình tài chính kết hợp chi phí cơ sở hạ tầng thực từ các triển khai ngành cho thấy:

Phân tích chi phí trên mỗi rack trong 36 tháng:

-

CapEx phần cứng: $3.7-4.0M (bao gồm phụ tùng và công cụ) cho GB300 NVL72

-

Điện cơ sở hạ tầng: $310K @ $0.08/kWh với 85% sử dụng trung bình

-

Cơ sở hạ tầng làm mát: $180K (CDU, đường ống, điều khiển)

-

Nhân viên vận hành: $240K (0.25 FTE chi phí đầy đủ)

-

Tổng: $4.43-4.73M vs $4.7M tương đương cloud

Breakeven xảy ra ở tỷ lệ sử dụng trung bình 67% trong 18 tháng, tính đến khấu hao, tài chính và chi phí cơ hội. CFO doanh nghiệp có được khả năng dự đoán ngân sách trong khi tránh vendor lock‑in cloud.

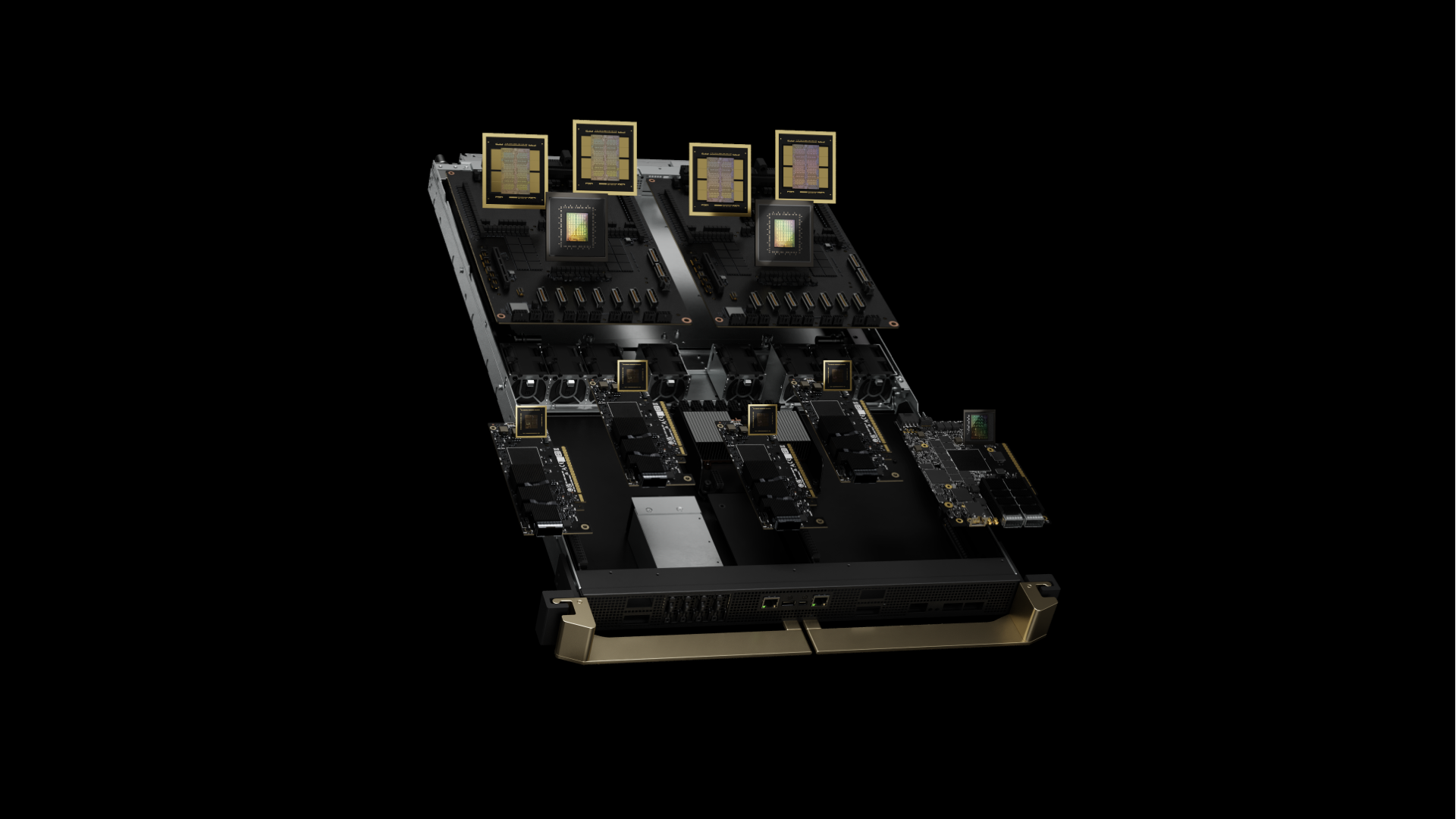

8. GB300 vs GB200: Hiểu về Blackwell Ultra

[caption id="" align="alignnone" width="1920"] GB200 thế hệ trước được mô tả [/caption]

GB200 thế hệ trước được mô tả [/caption]

GB300 NVL72 (Blackwell Ultra) đại diện cho sự phát triển đáng kể từ GB200 NVL72 ban đầu. Các cải tiến chính bao gồm hiệu suất tính toán AI gấp 1.5 lần, 288 GB bộ nhớ HBM3e trên mỗi GPU (vs 192 GB), và tập trung nâng cao vào test-time scaling inference cho các ứng dụng AI reasoning.

Kiến trúc mới cung cấp tăng 10x tokens per second per user và cải thiện 5x TPS per megawatt so với Hopper, mang lại tăng tiềm năng 50x kết hợp trong đầu ra AI factory. Điều này làm cho GB300 NVL72 được tối ưu hóa cụ thể cho kỷ nguyên AI reasoning mới nổi, nơi các mô hình như DeepSeek R1 yêu cầu nhiều tính toán hơn đáng kể trong inference để cải thiện độ chính xác.

Lịch trình có sẵn: Các hệ thống GB300 NVL72 được mong đợi từ các đối tác vào nửa cuối năm 2025, so với GB200 NVL72 có sẵn ngay bây giờ.

9. Tại sao Fortune 500 chọn các đối tác triển khai chuyên biệt

Các chuyên gia triển khai hàng đầu đã lắp đặt hơn 100,000 GPU trên hơn 850 trung tâm dữ liệu, duy trì thỏa thuận mức độ dịch vụ (SLA) toàn cầu 4 giờ thông qua các đội kỹ thuật hiện trường rộng lớn. Ngành đã đưa vào vận hành hàng nghìn dặm cáp quang và nhiều megawatt cơ sở hạ tầng AI chuyên dụng kể từ năm 2022.

Số liệu triển khai gần đây:

-

Timeline chuẩn bị địa điểm trung bình: 6.2 tuần (giảm từ 11 tuần trung bình ngành)

-

Tỷ lệ thành công lần đầu: 97.3% cho kiểm tra power‑on

-

Vấn đề sau triển khai: Tỷ lệ lỗi thành phần 0.08% trong 90 ngày đầu

OEM vận chuyển phần cứng; các đối tác chuyên biệt chuyển đổi phần cứng thành cơ sở hạ tầng sản xuất. Kết hợp các đội triển khai có kinh nghiệm trong giai đoạn lập kế hoạch có thể giảm timeline 45% thông qua việc sử dụng dây nối nguồn điện prefabricated, vòng lặp làm mát pre-staged và gói cáp quang terminated tại nhà máy.

Suy nghĩ cuối

Một tủ GB300 NVL72 đại diện cho sự thay đổi cơ bản từ "máy chủ trong rack" sang "trung tâm dữ liệu trong tủ". Vật lý là không khoan nhượng: mật độ tính toán 120 kW đòi hỏi độ chính xác trong mọi kết nối nguồn điện, vòng lặp làm mát và đầu nối cáp quang. Nắm vững các nguyên tắc cơ bản kỹ thuật từ Ngày 0, và Blackwell Ultra sẽ cung cấp hiệu suất AI reasoning chuyển đổi trong nhiều năm tới.

Sẵn sàng thảo luận về các chi tiết kỹ thuật mà chúng tôi không thể đưa vào 2,000 từ? Các kỹ sư triển khai của chúng tôi phát triển mạnh với những cuộc trò chuyện này—lên lịch deep dive kỹ thuật tại solutions@introl.com.

Tài liệu tham khảo

Dell Technologies. 2024. "Dell AI Factory Transforms Data Centers with Advanced Cooling, High-Density Compute and AI Storage Innovations." Thông cáo báo chí, 15 tháng 10. Dell Technologies Newsroom

Introl. 2025. "GPU Infrastructure Deployments and Global Field Engineers." Truy cập 23 tháng 6. introl.com

Lambda. 2025. "AI Cloud Pricing - NVIDIA B200 Clusters." Truy cập 23 tháng 6. Lambda Labs Pricing

NVIDIA. 2025. "GB300 NVL72 Product Page." Truy cập 23 tháng 6. NVIDIA Data Center

NVIDIA. 2025. "NVIDIA Blackwell Ultra AI Factory Platform Paves Way for Age of AI Reasoning." Thông cáo báo chí, 18 tháng 3. NVIDIA News

Supermicro. 2025. "NVIDIA GB300 NVL72 SuperCluster Datasheet." Tháng 2. Supermicro Datasheet

The Register. 2024. Mann, Tobias. "One Rack, 120 kW of Compute: A Closer Look at NVIDIA's DGX GB200 NVL72 Beast." 21 tháng 3. The Register

Hiệu chính (9 tháng 1, 2026): Đặc tả tải sàn được hiệu chính từ "14 kN/m² (2,030 psf)" thành "21 kN/m² ~440 psf)" — bản gốc có lỗi chuyển đổi đơn vị. Cũng làm rõ rằng đây là giá trị tính toán dựa trên trọng lượng rack và diện tích, không phải thông số chính thức của NVIDIA. Trở kháng Twinax được hiệu chính từ 75-ohm thành 100-ohm vi sai. Cảm ơn Diana đã phát hiện lỗi tải sàn.