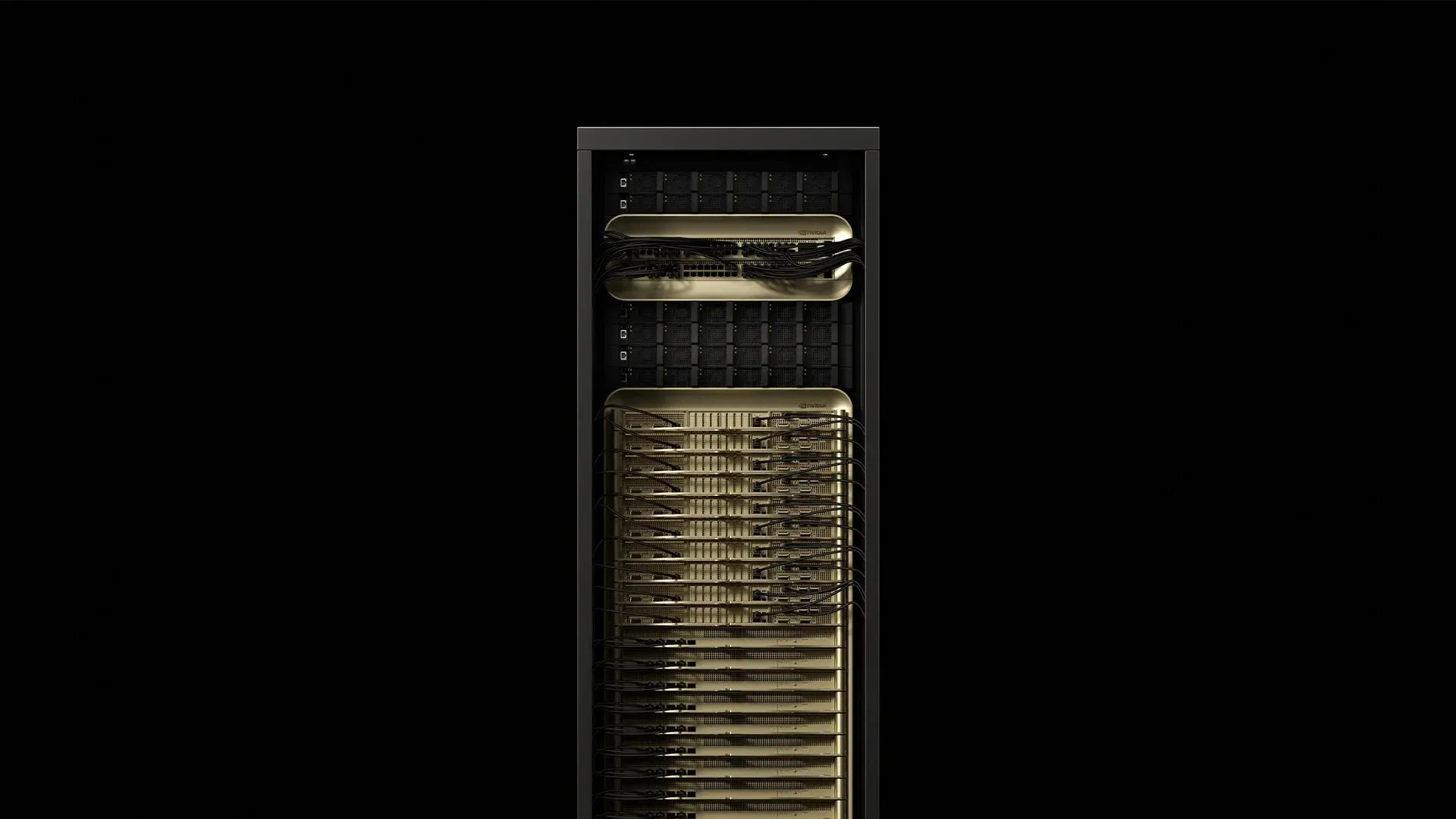

A NVIDIA conectou 72 GPUs Blackwell Ultra e 36 CPUs Grace em uma unidade resfriada a líquido de escala de rack que consome aproximadamente 120 kW e entrega 1,1 exaFLOPS de computação FP4 com o GB300 NVL72—1,5x mais performance de IA que o GB200 NVL72 original [^2025]. Esse único gabinete muda todas as premissas sobre energia, refrigeração e cabeamento dentro de data centers modernos. Aqui está o que os engenheiros de implementação estão aprendendo enquanto preparam locais para as primeiras entregas de produção do GB300 NVL72.

1. Dissecando o rack

[caption id="" align="alignnone" width="1292"] ComponenteQuantidadeEspecificação principalConsumo de energiaFonteBandejas de computação Grace‑Blackwell18~6,5 kW cada117 kW totalSupermicro 2025Bandejas de switch NVLink‑5913 TB/s de fabric agregado3,6 kW totalSupermicro 2025Prateleiras de energia8132 kW de saída DC total0,8 kW de sobrecargaSupermicro 2025DPUs Bluefield‑318Offload de armazenamento e segurançaIncluído na computaçãoThe Register 2024 [/caption]

ComponenteQuantidadeEspecificação principalConsumo de energiaFonteBandejas de computação Grace‑Blackwell18~6,5 kW cada117 kW totalSupermicro 2025Bandejas de switch NVLink‑5913 TB/s de fabric agregado3,6 kW totalSupermicro 2025Prateleiras de energia8132 kW de saída DC total0,8 kW de sobrecargaSupermicro 2025DPUs Bluefield‑318Offload de armazenamento e segurançaIncluído na computaçãoThe Register 2024 [/caption]

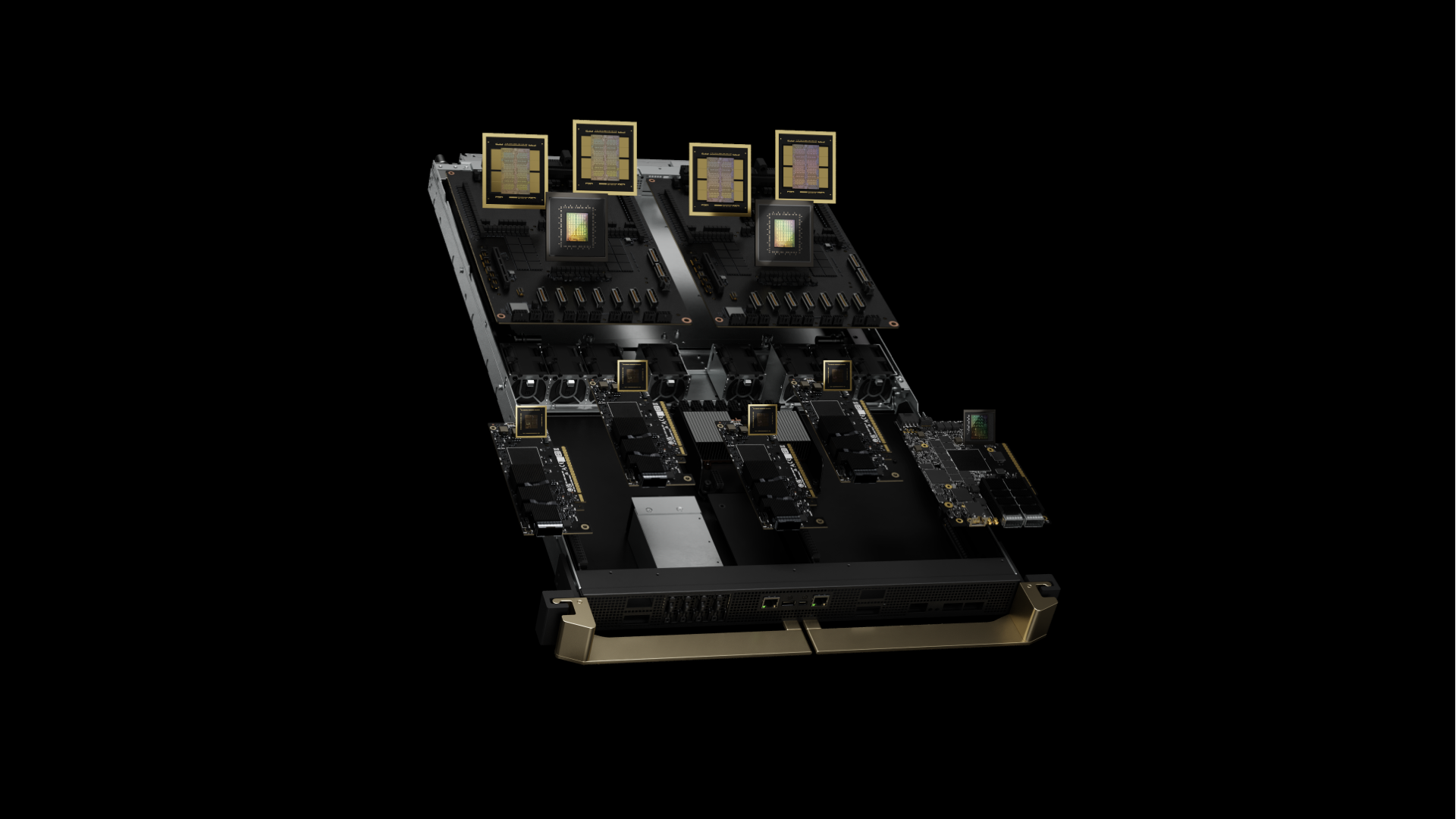

O gabinete pesa aproximadamente 1,36 t (3.000 lb) e ocupa a mesma área de um rack convencional de 42U [^2024]. O GB300 NVL72 representa o Blackwell Ultra, apresentando GPUs B300 aprimoradas com 288 GB de memória HBM3e por GPU (50% mais que os 192 GB originais do B200) conseguido através de pilhas HBM3e de 12 alturas em vez de 8 alturas. Cada superchip agora emparelha quatro GPUs B300 com duas CPUs Grace, comparado à configuração original de duas GPUs. Cada superchip Grace‑Blackwell emparelha 72 núcleos GPU Blackwell Ultra a 2,6 GHz com uma CPU de 72 núcleos Arm Neoverse V2 rodando a uma frequência base de 3,1 GHz. A memória HBM3e integrada entrega 8 TB/s por GPU com capacidade de 288 GB.

Insight de campo: O centro de gravidade do rack fica 18% mais alto que o de servidores padrão devido ao posicionamento denso de recursos computacionais nas bandejas superiores. As melhores práticas agora recomendam fixar os trilhos de montagem com parafusos M12, em vez de porcas de gaiola padrão, para lidar com micro-vibrações observadas durante operação a carga completa.

2. Alimentando a fera: fornecimento de energia

Um rack GB300 NVL72 vem com prateleiras PSU integradas, entregando 94,5% de eficiência a carga completa. O consumo de pico atinge 120,8 kW durante cargas de trabalho de treinamento de precisão mista—analisadores de qualidade de energia tipicamente registram fator de potência de 0,97 com

Comparação de topologia de tensão:

-

208V/60Hz: Corrente de linha de 335A, requer cobre AWG 4/0 (107mm²)

-

415V/50‑60Hz: Corrente de linha de 168A, precisa apenas de cobre de 70mm²

-

480V/60Hz: Corrente de linha de 145A, implementação norte-americana mínima

A melhor prática da indústria envolve prover alimentação dupla trifásica de 415V por rack via conectores IEC 60309 de 160A. Esta escolha reduz perdas I²R em 75% comparado a 208V mantendo compatibilidade com padrões de instalações europeias. Medições de campo indicam que painéis de disjuntores tipicamente permanecem abaixo de 85% de derateamento térmico em salas de 22°C.

Mitigação de harmônicos: Racks GB300 NVL72 exibem distorção harmônica total de 4,8% sob cargas típicas de treinamento de IA. Implementações excedendo oito racks tipicamente requerem retificadores de 12 pulsos em transformadores dedicados para manter conformidade IEEE 519.

3. Manual de refrigeração: Realidade de Engenharia Térmica

Cada die de GPU Blackwell Ultra mede 744 mm² e dissipa até 1.000 W através de sua interface de placa fria. A CPU Grace adiciona outros 500W através de seus 72 núcleos. O programa IR7000 da Dell posiciona líquido como o caminho padrão para equipamentos da classe Blackwell, alegando capacidades por rack de até 480 kW com trocadores de calor de porta traseira fechada [^2024].

Hierarquia térmica recomendada:

-

≤80 kW/rack: Trocadores de calor de porta traseira com água de fornecimento de 18°C, taxa de fluxo de 35 L/min

-

80–132 kW/rack: Loops direto-ao-chip (DTC) obrigatórios, fornecimento de 15°C, mínimo de 30 L/min

-

132 kW/rack: Refrigeração por imersão ou configurações de rack dividido necessárias

Especificações DTC de implementações de campo:

-

ΔT da placa fria: 12–15°C a carga completa (temperaturas de junção da GPU 83–87°C)

-

Queda de pressão: 2,1 bar através do loop completo com 30% de glicol propileno

-

Distribuição de fluxo: Variância de ±3% em todas as 72 placas frias de GPU

-

Taxa de vazamento:

Insight crítico: A rede de fornecimento de energia do Blackwell Ultra exibe transientes de escala de microssegundo, atingindo 1,4 vezes a potência de estado estável durante sincronização de gradiente. A prática da indústria recomenda dimensionar refrigeração para 110% do TDP nominal para lidar com esses picos térmicos sem throttling da GPU.

4. Fabric de rede: gerenciando NVLink 5.0 e conectividade aprimorada

Cada GB300 NVL72 contém 72 GPUs Blackwell Ultra com NVLink 5.0, fornecendo largura de banda de 1,8 TB/s por GPU e 130 TB/s de largura de banda NVLink total no sistema. O NVLink de quinta geração opera a taxa de sinalização de 200 Gbps por link, com 18 links por GPU. Os nove chips NVSwitch roteiam esse tráfego com latência de switch de 300 nanossegundos e suportam padrões de comunicação GPU-para-GPU de 576 vias.

Conectividade entre racks agora apresenta SuperNICs ConnectX-8 fornecendo conectividade de rede de 800 Gb/s por GPU (dobro dos 400 Gb/s da geração anterior), suportando tanto plataformas NVIDIA Quantum-X800 InfiniBand quanto Spectrum-X Ethernet.

Arquitetura de cabeamento:

-

Intra‑rack: 1.728 cabos Twinax de cobre (impedância diferencial de 100-ohm,

-

Inter‑rack: 90 portas QSFP112 via transceivers de 800G sobre MMF OM4

-

Armazenamento/gerenciamento: 18 DPUs Bluefield‑3 com links duplos de 800G cada

Medições de campo:

-

Orçamento óptico: Orçamento de perda de inserção de 1,5 dB sobre spans OM4 de 150m

-

Performance BER:

-

Densidade de conectores: 1.908 terminações por rack (incluindo energia)

Melhores práticas envolvem envio de conjuntos trunk pré-terminados de 144 fibras com polimento APC e verificação de cada conector com testes de perda de inserção/perda de retorno aos padrões TIA-568. Equipes experientes de duas pessoas podem completar uma instalação de fibra GB300 NVL72 em 2,8 horas em média—redução de 7,5 horas quando técnicos constroem cabos no local.

Insight de integridade de sinal: NVLink‑5 opera com sinalização PAM‑4 de 25 GBd. Instalações típicas mantêm um orçamento de perda de inserção de 2,1 dB por conexão Twinax e

5. Lista de verificação de implementação testada em campo

Requisitos estruturais:

-

Carregamento de piso: certificar ≥21 kN/m² (~440 psf) para carga distribuída; calculado de rack de 1.360 kg em área de 0,64 m². Nota: NVIDIA não publica especificações oficiais de carregamento de piso—verifique com engenheiro estrutural para sua instalação específica.

-

Contraventamento sísmico: Instalações Zona 4 requerem contraventamento X adicional por IBC 2021

-

Isolamento de vibração:

Infraestrutura de energia:

-

Alimentação dupla 415V, 160A cada, com monitoramento de circuito ramal Schneider PM8000

-

Dimensionamento UPS: 150 kVA por rack (margem de segurança 125%) com topologia online de dupla conversão

-

Aterramento: Terra de equipamento isolado com

Especificações de refrigeração:

-

Qualidade do refrigerante:

-

Substituição de filtro: Pleated de 5 µm a cada 1.000 horas, final de 1 µm a cada 2.000 horas

-

Detecção de vazamento: Sensores de fluido condutivo em todas as conexões QDC com sensibilidade de 0,1 mL

Inventário de peças de reposição:

-

Uma bandeja NVSwitch (prazo de entrega: 6 semanas)

-

Dois cartuchos de bomba CDU (MTBF: 8.760 horas)

-

20 transceivers QSFP112 (taxa de falha de campo: 0,02% anualmente)

-

Material de interface térmica de emergência (Honeywell PTM7950, tubos de 5g)

SLA de mãos remotas: Resposta no local de 4 horas está se tornando padrão da indústria—parceiros de implementação líderes mantêm esta meta em múltiplos países com >99% de uptime.

6. Caracterização de performance sob cargas de produção

Benchmarks de raciocínio de IA (de relatórios de implementação inicial):

-

Modelo DeepSeek R1-671B: Até 1.000 tokens/segundo de throughput sustentado

-

Modelo GPT‑3 de 175B parâmetros: 847 tokens/segundo/GPU em média

-

Stable Diffusion 2.1: 14,2 imagens/segundo em resolução 1024×1024

-

Treinamento ResNet‑50 ImageNet: 2.340 amostras/segundo de throughput sustentado

Escalonamento de eficiência energética:

-

Utilização de rack único: 1,42 GFLOPS/Watt a 95% de utilização da GPU

-

Cluster de 10 racks: 1,38 GFLOPS/Watt (sobrecarga de refrigeração reduz eficiência)

-

Energia ociosa da rede: 3,2 kW por rack (NVSwitch + transceivers)

Melhorias de performance de raciocínio de IA: GB300 NVL72 entrega aumento de 10x em tokens por segundo por usuário e melhoria de 5x em TPS por megawatt comparado ao Hopper, resultando em um aumento potencial combinado de 50x na performance de saída da fábrica de IA.

Efeitos de ciclagem térmica: Após 2.000 horas de operação de produção, implementações iniciais reportam degradação de performance de 0,3% devido ao pump-out do material de interface térmica. Substituição agendada de TIM em intervalos de 18 meses mantém performance de pico.

7. Análise de TCO cloud versus on-prem

Lambda oferece GPUs B200 por apenas $2,99 por hora de GPU com compromissos multi-ano (Lambda 2025). Modelagem financeira incorporando custos reais de instalações de implementações da indústria mostra:

Breakdown de custo por rack ao longo de 36 meses:

-

CapEx de hardware: $3,7-4,0M (incluindo sobressalentes e ferramentas) para GB300 NVL72

-

Energia da instalação: $310K @ $0,08/kWh com 85% de utilização média

-

Infraestrutura de refrigeração: $180K (CDU, encanamento, controles)

-

Pessoal de operações: $240K (custo totalmente carregado de 0,25 FTE)

-

Total: $4,43-4,73M vs $4,7M equivalente em cloud

Ponto de equilíbrio ocorre a 67% de taxa de utilização média ao longo de 18 meses, levando em conta depreciação, financiamento e custos de oportunidade. CFOs empresariais ganham previsibilidade orçamentária enquanto evitam vendor lock-in de cloud.

8. GB300 vs GB200: Entendendo o Blackwell Ultra

[caption id="" align="alignnone" width="1920"] Geração anterior GB200 ilustrada [/caption]

Geração anterior GB200 ilustrada [/caption]

O GB300 NVL72 (Blackwell Ultra) representa uma evolução significativa do GB200 NVL72 original. Melhorias chave incluem 1,5x mais performance de computação de IA, 288 GB de memória HBM3e por GPU (vs 192 GB), e foco aprimorado em inferência de escalonamento de tempo de teste para aplicações de raciocínio de IA.

A nova arquitetura entrega aumento de 10x em tokens por segundo por usuário e melhoria de 5x em TPS por megawatt comparado ao Hopper, resultando em um aumento potencial combinado de 50x na saída da fábrica de IA. Isso torna o GB300 NVL72 especificamente otimizado para a era emergente de raciocínio de IA, onde modelos como DeepSeek R1 requerem substancialmente mais computação durante inferência para melhorar precisão.

Cronograma de disponibilidade: Sistemas GB300 NVL72 são esperados de parceiros no segundo semestre de 2025, comparado ao GB200 NVL72 que está disponível agora.

9. Por que Fortune 500s Escolhem Parceiros de Implementação Especializados

Especialistas de implementação líderes instalaram mais de 100.000 GPUs em mais de 850 data centers, mantendo acordos de nível de serviço (SLAs) globais de 4 horas através de extensas equipes de engenharia de campo. A indústria comissionou milhares de milhas de fibra e múltiplos megawatts de infraestrutura de IA dedicada desde 2022.

Métricas de implementação recentes:

-

Cronograma médio de preparação do local: 6,2 semanas (redução de 11 semanas da média da indústria)

-

Taxa de sucesso na primeira tentativa: 97,3% para testes de energização

-

Problemas pós-implementação: 0,08% de taxa de falha de componentes nos primeiros 90 dias

OEMs enviam hardware; parceiros especializados transformam hardware em infraestrutura de produção. Engajar equipes de implementação experientes durante fases de planejamento pode reduzir cronogramas em 45% através do uso de chicotes de energia pré-fabricados, loops de refrigeração pré-posicionados e conjuntos de fibra terminados em fábrica.

Reflexão final

Um gabinete GB300 NVL72 representa uma mudança fundamental de "servidores em racks" para "data centers em gabinetes". A física é implacável: 120 kW de densidade computacional demanda precisão em cada conexão de energia, loop de refrigeração e terminação de fibra. Domine os fundamentos de engenharia no Dia 0, e o Blackwell Ultra entregará performance transformacional de raciocínio de IA por anos.

Pronto para discutir os detalhes técnicos que não couberam em 2.000 palavras? Nossos engenheiros de implementação prosperam nessas conversas—agende um mergulho técnico profundo em solutions@introl.com.

Referências

Dell Technologies. 2024. "Dell AI Factory Transforms Data Centers with Advanced Cooling, High-Density Compute and AI Storage Innovations." Comunicado de imprensa, 15 de outubro. Dell Technologies Newsroom

Introl. 2025. "GPU Infrastructure Deployments and Global Field Engineers." Acessado em 23 de junho. introl.com

Lambda. 2025. "AI Cloud Pricing - NVIDIA B200 Clusters." Acessado em 23 de junho. Lambda Labs Pricing

NVIDIA. 2025. "GB300 NVL72 Product Page." Acessado em 23 de junho. NVIDIA Data Center

NVIDIA. 2025. "NVIDIA Blackwell Ultra AI Factory Platform Paves Way for Age of AI Reasoning." Comunicado de imprensa, 18 de março. NVIDIA News

Supermicro. 2025. "NVIDIA GB300 NVL72 SuperCluster Datasheet." Fevereiro. Supermicro Datasheet

The Register. 2024. Mann, Tobias. "One Rack, 120 kW of Compute: A Closer Look at NVIDIA's DGX GB200 NVL72 Beast." 21 de março. The Register

Correção (9 de janeiro de 2026): Especificação de carregamento de piso corrigida de "14 kN/m² (2.030 psf)" para "21 kN/m² (~440 psf)" — o original continha um erro de conversão de unidade. Também esclarecido que este é um valor calculado baseado no peso do rack e área, não uma especificação oficial da NVIDIA. Impedância Twinax corrigida de 75-ohm para 100-ohm diferencial. Obrigado à Diana por detectar o erro de carregamento de piso.