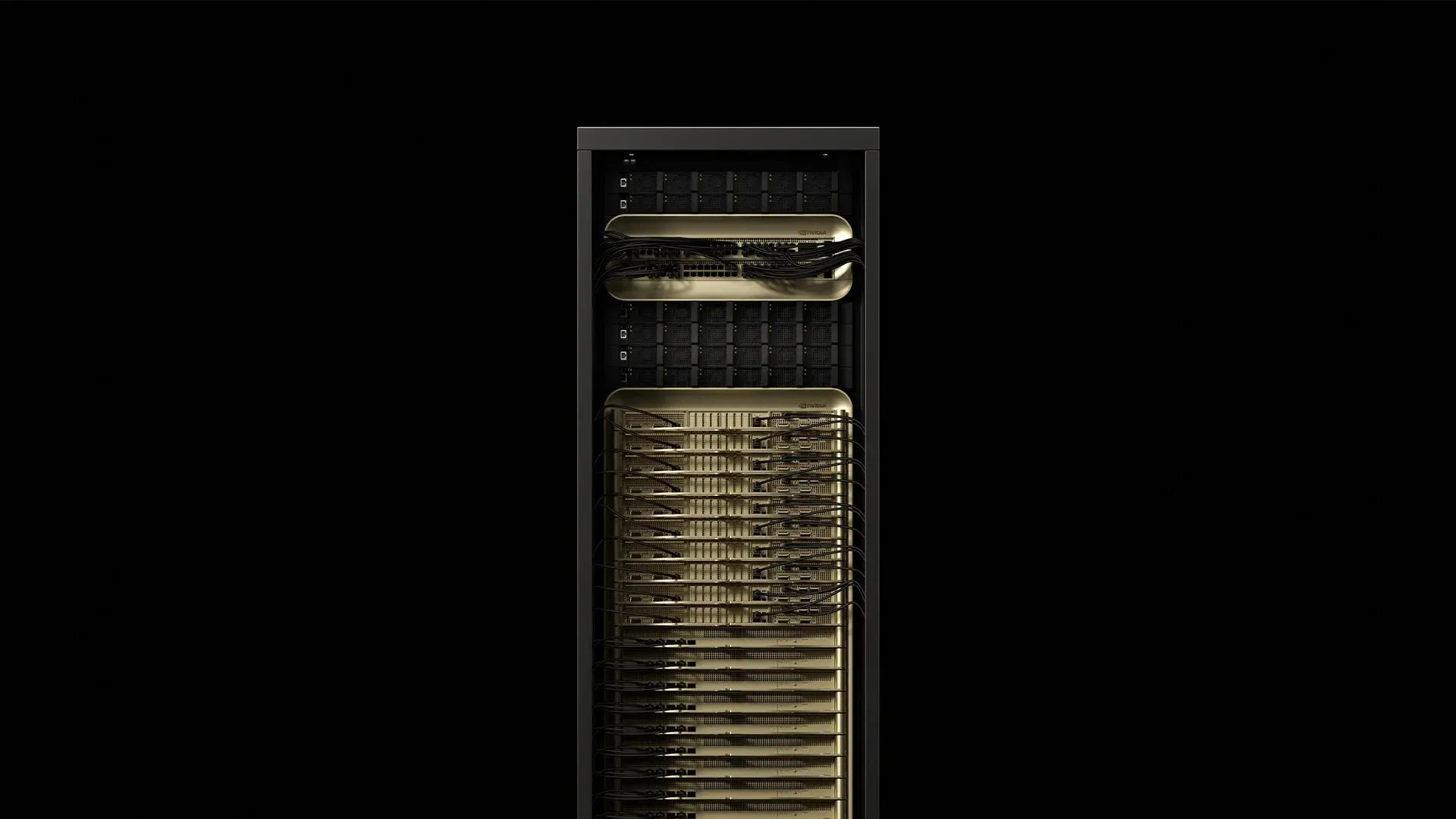

NVIDIA ได้รวม GPU Blackwell Ultra 72 ตัวและ CPU Grace 36 ตัวเข้าด้วยกันในระบบหล่อเย็นด้วยของเหลวขนาดระดับแร็คที่ใช้พลังงานประมาณ 120 kW และให้ประสิทธิภาพการคำนวณ FP4 1.1 exaFLOPS ด้วย GB300 NVL72—มีประสิทธิภาพ AI มากกว่า GB200 NVL72 เดิม 1.5 เท่า [^2025] ตู้เดียวนั้นเปลี่ยนแปลงทุกสมมติฐานเกี่ยวกับพลังงาน การระบายความร้อน และการเดินสายภายใน data center สมัยใหม่ นี่คือสิ่งที่วิศวกรการติดตั้งกำลังเรียนรู้ขณะเตรียมไซต์สำหรับการส่งมอบ GB300 NVL72 ในการผลิตครั้งแรก

1. การวิเคราะห์แร็ค

[caption id="" align="alignnone" width="1292"] ComponentCountKey specPower drawSourceGrace‑Blackwell compute trays18~6.5 kW each117 kW totalSupermicro 2025NVLink‑5 switch trays9130 TB/s aggregate fabric3.6 kW totalSupermicro 2025Power shelves8132 kW total DC output0.8 kW overheadSupermicro 2025Bluefield‑3 DPUs18Storage & security offloadIncluded in computeThe Register 2024 [/caption]

ComponentCountKey specPower drawSourceGrace‑Blackwell compute trays18~6.5 kW each117 kW totalSupermicro 2025NVLink‑5 switch trays9130 TB/s aggregate fabric3.6 kW totalSupermicro 2025Power shelves8132 kW total DC output0.8 kW overheadSupermicro 2025Bluefield‑3 DPUs18Storage & security offloadIncluded in computeThe Register 2024 [/caption]

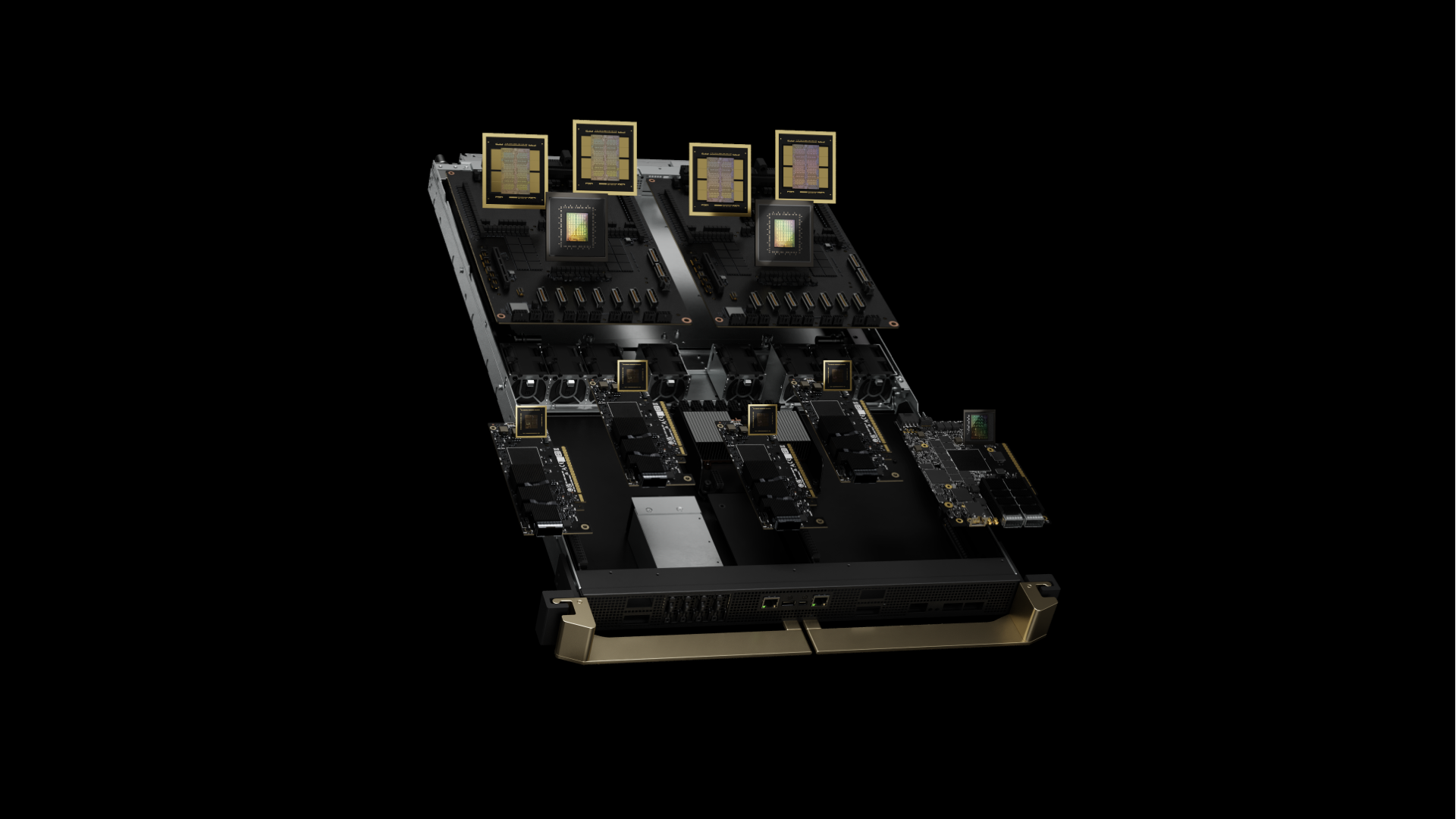

ตู้มีน้ำหนักประมาณ 1.36 t (3,000 lb) และใช้พื้นที่เท่ากับแร็ค 42U มาตรฐาน [^2024] GB300 NVL72 เป็นตัวแทนของ Blackwell Ultra ที่มี GPU B300 ปรับปรุงใหม่พร้อมหน่วยความจำ HBM3e 288 GB ต่อ GPU (มากกว่า B200 เดิมที่มี 192 GB ถึง 50%) ที่ได้จาก HBM3e stack สูง 12 ชั้นแทนที่จะเป็น 8 ชั้น แต่ละ superchip ตอนนี้จับคู่ GPU B300 สี่ตัวกับ CPU Grace สองตัว เทียบกับการกำหนดค่าสอง GPU เดิม แต่ละ Grace‑Blackwell superchip จับคู่ GPU Blackwell Ultra 72 core ที่ 2.6 GHz กับ CPU Arm Neoverse V2 72 core ที่ทำงานที่ความถี่ฐาน 3.1 GHz หน่วยความจำ HBM3e แบบรวมให้ 8 TB/s ต่อ GPU ด้วยความจุ 288 GB

ข้อมูลเชิงลึกจากสนาม: จุดศูนย์ถ่วงของแร็คอยู่สูงกว่าเซิร์ฟเวอร์มาตรฐาน 18% เนื่องจากการจัดวางทรัพยากรการคำนวณที่หนาแน่นในถาดด้านบน แนวปฏิบัติที่ดีที่สุดในปัจจุบันแนะนำให้ยึดราง mounting ด้วยสลัก M12 แทนที่จะใช้ cage nuts มาตรฐาน เพื่อจัดการกับการสั่นสะเทือนเล็กน้อยที่สังเกตพบระหว่างการทำงานเต็มโหลด

2. การจ่ายพลังงาน: เลี้ยงสัตว์ร้าย

แร็ค GB300 NVL72 จัดส่งพร้อมกับชั้น PSU ในตัว ให้ประสิทธิภาพ 94.5% ที่โหลดเต็ม การใช้พลังงานสูงสุดถึง 120.8 kW ระหว่าง mixed‑precision training workloads—เครื่องวิเคราะห์คุณภาพพลังงานโดยทั่วไปบันทึก power factor 0.97 ด้วย

การเปรียบเทียบ Voltage topology:

-

208V/60Hz: กระแส 335A ต้องใช้ทองแดง 4/0 AWG (107mm²)

-

415V/50‑60Hz: กระแส 168A ต้องใช้ทองแดง 70mm² เท่านั้น

-

480V/60Hz: กระแส 145A การติดตั้งในอเมริกาเหนือน้อยที่สุด

แนวปฏิบัติที่ดีที่สุดของอุตสาหกรรมเกี่ยวข้องกับการจัดเตรียม 415V three‑phase feeds คู่ต่อแร็คผ่านตัวเชื่อมต่อ IEC 60309 160A ตัวเลือกนี้ลดการสูญเสีย I²R ลง 75% เมื่อเปรียบเทียบกับ 208V พร้อมทั้งรักษาความเข้ากันได้กับมาตรฐานสิ่งอำนวยความสะดวกของยุโรป การวัดในสนามแสดงให้เห็นว่าแผง breaker โดยทั่วไปยังคงอยู่ต่ำกว่า thermal derating 85% ในห้อง 22°C

การลดการรบกวนฮาร์โมนิก: แร็ค GB300 NVL72 แสดง total harmonic distortion 4.8% ภายใใต้โหลด AI training ทั่วไป การติดตั้งที่เกินแปดแร็คโดยทั่วไปต้องใช้ 12‑pulse rectifiers บนหม้อแปลงเฉพาะเพื่อรักษาการปฏิบัติตาม IEEE 519

3. คู่มือการระบายความร้อน: ความเป็นจริงของวิศวกรรมความร้อน

แต่ละ die GPU Blackwell Ultra วัด 744 mm² และกระจายความร้อนสูงสุด 1,000 W ผ่านอินเทอร์เฟซ cold plate CPU Grace เพิ่มอีก 500W ข้าม 72 core โปรแกรม IR7000 ของ Dell วางตำแหน่งของเหลวเป็นเส้นทางเริ่มต้นสำหรับอุปกรณ์คลาส Blackwell อ้างว่ามีความจุต่อแร็คสูงสุด 480 kW ด้วยเครื่องแลกเปลี่ยนความร้อนประตูหลังแบบปิด [^2024]

ลำดับชั้นความร้อนที่แนะนำ:

-

≤80 kW/rack: เครื่องแลกเปลี่ยนความร้อนประตูหลังพร้อมน้ำจ่าย 18°C อัตราการไหล 35 L/min

-

80–132 kW/rack: ลูป Direct‑to‑chip (DTC) จำเป็น จ่าย 15°C ขั้นต่ำ 30 L/min

-

132 kW/rack: ต้องใช้ immersion cooling หรือการกำหนดค่า split‑rack

ข้อมูลจำเพาะ DTC จากการติดตั้งในสนาม:

-

Cold plate ΔT: 12–15°C ที่โหลดเต็ม (อุณหภูมิ junction GPU 83–87°C)

-

ความดันตก: 2.1 bar ข้ามลูปที่สมบูรณ์ด้วย propylene glycol 30%

-

การกระจายการไหล: ความแปรปรวน ±3% ข้าม cold plate GPU ทั้ง 72 ตัว

-

อัตราการรั่ว:

ข้อมูลเชิงลึกที่สำคัญ: เครือข่ายการจ่ายพลังงานของ Blackwell Ultra แสดงการเปลี่ยนแปลงระดับ microsecond ถึง 1.4 เท่าของพลังงานสถานะคงที่ระหว่างการซิงโครไนซ์ gradient แนวปฏิบัติของอุตสาหกรรมแนะนำให้ปรับขนาดการระบายความร้อนสำหรับ 110% ของ TDP ที่กำหนดเพื่อจัดการกับการเพิ่มความร้อนเหล่านี้โดยไม่มีการลด GPU throttling

4. Network fabric: การจัดการ NVLink 5.0 และการเชื่อมต่อที่ปรับปรุงแล้ว

แต่ละ GB300 NVL72 มี GPU Blackwell Ultra 72 ตัวด้วย NVLink 5.0 ให้แบนด์วิดท์ 1.8 TB/s ต่อ GPU และแบนด์วิดท์ NVLink รวม 130 TB/s ทั่วทั้งระบบ NVLink รุ่นที่ห้าทำงานที่อัตรา signaling 200 Gbps ต่อลิงก์ พร้อม 18 ลิงก์ต่อ GPU ชิป NVSwitch เก้าตัว route traffic นี้ด้วยความล่าช้าของสวิตช์ 300 nanosecond และสนับสนุนรูปแบบการสื่อสาร GPU-to-GPU แบบ 576-way

การเชื่อมต่อระหว่างแร็คตอนนี้มี ConnectX-8 SuperNICs ที่ให้การเชื่อมต่อเครือข่าย 800 Gb/s ต่อ GPU (เป็นสองเท่าของ 400 Gb/s รุ่นก่อนหน้า) รองรับทั้งแพลตฟอร์ม NVIDIA Quantum-X800 InfiniBand และ Spectrum-X Ethernet

สถาปัตยกรรมการเดินสาย:

-

Intra‑rack: สาย copper Twinax 1,728 เส้น (อิมพีแดนซ์ differential 100‑ohm

-

Inter‑rack: พอร์ต QSFP112 90 พอร์ตผ่าน transceiver 800G บน OM4 MMF

-

Storage/management: Bluefield‑3 DPUs 18 ตัวพร้อมลิงก์ 800G คู่แต่ละตัว

การวัดในสนาม:

-

งบประมาณ Optical: งบประมาณการสูญเสีย insertion 1.5 dB บน OM4 spans 150m

-

ประสิทธิภาพ BER:

-

ความหนาแน่นของตัวเชื่อมต่อ: 1,908 terminations ต่อแร็ค (รวมพลังงาน)

แนวปฏิบัติที่ดีที่สุดเกี่ยวข้องกับการจัดส่ง trunk assemblies ไฟเบอร์ 144 เส้นที่ terminated ล่วงหน้าด้วยการขัด APC และตรวจสอบทุกตัวเชื่อมต่อด้วยการทดสอบ insertion-loss/return-loss ตามมาตรฐาน TIA-568 ทีมงานสองคนที่มีประสบการณ์สามารถติดตั้งไฟเบอร์ GB300 NVL72 ได้ในเวลาเฉลี่ย 2.8 ชั่วโมง—ลดลงจาก 7.5 ชั่วโมงเมื่อช่างเทคนิคสร้างสายใน‑site

ข้อมูลเชิงลึก Signal integrity: NVLink‑5 ทำงานด้วยการส่งสัญญาณ PAM‑4 25 GBd การติดตั้งทั่วไปรักษางบประมาณการสูญเสีย insertion 2.1 dB ต่อการเชื่อมต่อ Twinax และ

5. รายการตรวจสอบการติดตั้งที่ทดสอบในสนาม

ข้อกำหนดโครงสร้าง:

-

การโหลดพื้น: รับรอง ≥21 kN/m² (~440 psf) สำหรับโหลดกระจาย; คำนวณจากแร็ค 1,360 kg บน footprint 0.64 m² หมายเหตุ: NVIDIA ไม่ได้เผยแพร่ข้อมูลจำเพาะการโหลดพื้นอย่างเป็นทางการ—ตรวจสอบกับวิศวกรโครงสร้างสำหรับการติดตั้งเฉพาะของคุณ

-

การยึด Seismic: การติดตั้ง Zone 4 ต้องใช้ X‑bracing เพิ่มเติมตาม IBC 2021

-

การแยกการสั่นสะเทือน:

โครงสร้างพื้นฐานพลังงาน:

-

Dual 415V feeds, 160A แต่ละตัว ด้วยการติดตาม branch‑circuit ของ Schneider PM8000

-

ขนาด UPS: 150 kVA ต่อแร็ค (ขอบความปลอดภัย 125%) ด้วย topology online double‑conversion

-

การต่อสายดิน: อุปกรณ์ ground แยกด้วย

ข้อกำหนดการระบายความร้อน:

-

คุณภาพสารหล่อเย็น:

-

การเปลี่ยนตัวกรอง: pleated 5 µm ทุก 1,000 ชั่วโมง ขั้นสุดท้าย 1 µm ทุก 2,000 ชั่วโมง

-

การตรวจจับการรั่ว: เซนเซอร์ของเหลวนำไฟฟ้าที่ QDC fittings ทั้งหมดด้วยความไวขรรี 0.1 mL

คลังสินค้าอะไหล่:

-

NVSwitch tray หนึ่งอัน (เวลานำ: 6 สัปดาห์)

-

CDU pump cartridges สองอัน (MTBF: 8,760 ชั่วโมง)

-

QSFP112 transceivers 20 ตัว (อัตราความล้มเหลวในสนาม: 0.02% ต่อปี)

-

วัสดุอินเทอร์เฟซความร้อนฉุกเฉิน (Honeywell PTM7950, หลอด 5g)

SLA Remote‑hands: การตอบสนอง on‑site 4 ชั่วโมงกำลังกลายเป็นมาตรฐานอุตสาหกรรม—พันธมิตรการติดตั้งชั้นนำรักษาเป้าหมายนี้ในหลายประเทศด้วย uptime >99%

6. การจำแนกลักษณะประสิทธิภาพภายใต้โหลดการผลิต

เกณฑ์มาตรฐาน AI reasoning (จากรายงานการติดตั้งช่วงแรก):

-

โมเดล DeepSeek R1-671B: throughput ที่ยั่งยืนสูงสุด 1,000 tokens/second

-

โมเดล GPT‑3 175B parameter: เฉลี่ย 847 tokens/second/GPU

-

Stable Diffusion 2.1: 14.2 images/second ที่ความละเอียด 1024×1024

-

ResNet‑50 ImageNet training: throughput ที่ยั่งยืน 2,340 samples/second

การปรับขนาดประสิทธิภาพพลังงาน:

-

การใช้งานแร็คเดี่ยว: 1.42 GFLOPS/Watt ที่การใช้งาน GPU 95%

-

คลัสเตอร์ 10‑rack: 1.38 GFLOPS/Watt (overhead การระบายความร้อนลดประสิทธิภาพ)

-

พลังงาน Network idle: 3.2 kW ต่อแร็ค (NVSwitch + transceivers)

การปรับปรุงประสิทธิภาพ AI reasoning: GB300 NVL72 ให้การเพิ่มขึ้น 10 เท่าใน tokens per second per user และการปรับปรุง 5 เท่าใน TPS per megawatt เมื่อเปรียบเทียบกับ Hopper ให้การเพิ่มขึ้นที่อาจเป็นไปได้ 50 เท่ารวมในประสิทธิภาพเอาต์พุต AI factory

ผลกระทบ Thermal cycling: หลังจากการทำงานการผลิต 2,000 ชั่วโมง การติดตั้งช่วงแรกรายงานการเสื่อมสภาพประสิทธิภาพ 0.3% เนื่องจาก thermal interface material pump‑out การเปลี่ยน TIM ตามกำหนดที่ช่วงเวลา 18 เดือนรักษาประสิทธิภาพสูงสุด

7. การวิเคราะห์ TCO ของ Cloud เทียบกับ on‑prem

Lambda เสนอ GPU B200 ในราคาต่ำสุด $2.99 ต่อ GPU ชั่วโมงด้วยการผูกมัดหลายปี (Lambda 2025) การสร้างแบบจำลองทางการเงินที่รวมต้นทุนสิ่งอำนวยความสะดวกจริงจากการติดตั้งในอุตสาหกรรมแสดง:

การแบ่งต้นทุนต่อแร็คมากกว่า 36 เดือน:

-

Hardware CapEx: $3.7-4.0M (รวมอะไหล่และเครื่องมือ) สำหรับ GB300 NVL72

-

Facility power: $310K @ $0.08/kWh ด้วยการใช้งานเฉลี่ย 85%

-

โครงสร้างพื้นฐานการระบายความร้อน: $180K (CDU, ระบบท่อ, การควบคุม)

-

พนักงานปฏิบัติการ: $240K (ต้นทุนโหลดเต็ม 0.25 FTE)

-

รวม: $4.43-4.73M เทียบกับ $4.7M cloud เทียบเท่า

Breakeven เกิดขึ้นที่อัตราการใช้งานเฉลี่ย 67% มากกว่า 18 เดือน โดยคำนึงถึงค่าเสื่อมราคา การเงิน และต้นทุนโอกาส CFO องค์กรได้รับความสามารถในการคาดการณ์งงบประมาณในขณะที่หลีกเลี่ยงการผูกมัดกับผู้ให้บริการ cloud

8. GB300 เทียบกับ GB200: การเข้าใจ Blackwell Ultra

[caption id="" align="alignnone" width="1920"] Previous gen GB200 pictured [/caption]

Previous gen GB200 pictured [/caption]

GB300 NVL72 (Blackwell Ultra) แสดงถึงการพัฒนาที่สำคัญจาก GB200 NVL72 เดิม การปรับปรุงที่สำคัญรวมถึงประสิทธิภาพการคำนวณ AI มากขึ้น 1.5 เท่า หน่วยความจำ HBM3e 288 GB ต่อ GPU (เทียบกับ 192 GB) และการเน้นที่ปรับปรุงแล้วใน test-time scaling inference สำหรับแอปพลิเคชัน AI reasoning

สถาปัตยกรรมใหม่ให้การเพิ่มขึ้น 10 เท่าใน tokens per second per user และการปรับปรุง 5 เท่าใน TPS per megawatt เมื่อเปรียบเทียบกับ Hopper ให้การเพิ่มขึ้นที่อาจเป็นไปได้ 50 เท่ารวมในเอาต์พุต AI factory ทำให้ GB300 NVL72 ได้รับการปรับให้เหมาะสำหรับยุค AI reasoning ที่เกิดขึ้นใหม่ ซึ่งโมเดลเช่น DeepSeek R1 ต้องใช้การคำนวณมากขึ้นอย่างมากระหว่าง inference เพื่อปรับปรุงความแม่นยำ

ไทม์ไลน์ความพร้อม: ระบบ GB300 NVL72 คาดว่าจะได้รับจากพันธมิตรในครึ่งหลังของปี 2025 เมื่อเปรียบเทียบกับ GB200 NVL72 ที่มีให้ตอนนี้

9. ทำไม Fortune 500s เลือกพันธมิตรการติดตั้งเฉพาะทาง

ผู้เชี่ยวชาญการติดตั้งชั้นนำได้ติดตั้ง GPU มากกว่า 100,000 ตัวในมากกว่า 850 data centers รักษา SLA 4 ชั่วโมงทั่วโลกผ่านทีมวิศวกรสนามที่กว้างขวาง อุตสาหกรรมได้ว่าจ้างใยแก้วหลายพันไมล์และโครงสร้างพื้นฐาน AI เฉพาะหลาย megawatts ตั้งแต่ 2022

เมตริกการติดตั้งล่าสุด:

-

ไทม์ไลน์การเตรียมไซต์เฉลี่ย: 6.2 สัปดาห์ (ลดลงจากเฉลี่ยอุตสาหกรรม 11 สัปดาห์)

-

อัตราความสำเร็จครั้งแรก: 97.3% สำหรับการทดสอบ power‑on

-

ปัญหาหลังการติดตั้ง: อัตราความล้มเหลวของส่วนประกอบ 0.08% ใน 90 วันแรก

OEMs จัดส่งฮาร์ดแวร์; พันธมิตรเฉพาะทางเปลี่ยนฮาร์ดแวร์เป็นโครงสร้างพื้นฐานการผลิต การมีส่วนร่วมของทีมการติดตั้งที่มีประสบการณ์ในระหว่างขั้นตอนการวางแผนสามารถลดไทม์ไลน์ลง 45% ผ่านการใช้ harnesses พลังงานประกอบสำเร็จรูป ลูปการระบายความร้อนที่จัดเตรียมไว้ล่วงหน้า และมัดไฟเบอร์ที่ terminated จากโรงงาน

ความคิดสุดท้าย

ตู้ GB300 NVL72 แสดงถึงการเปลี่ยนแปลงพื้นฐานจาก "เซิร์ฟเวอร์ในแร็ค" เป็น "data centers ในตู้" ฟิสิกส์ไม่ให้อภัย: ความหนาแน่นการคำนวณ 120 kW ต้องการความแม่นยำในทุกการเชื่อมต่อพลังงาน ลูปการระบายความร้อน และการต่อไฟเบอร์ เชี่ยวชาญพื้นฐานการวิศวกรรมในวันที่ 0 และ Blackwell Ultra จะให้ประสิทธิภาพ AI reasoning ที่เปลี่ยนแปลงมานานหลายปี

พร้อมที่จะหารือเกี่ยวกับรายละเอียดทางเทคนิคที่เราไม่สามารถใส่ลงใน 2,000 คำแล้วใช่ไหม? วิศวกรการติดตั้งของเราเติบโตจากการสนทนาเหล่านี้—กำหนดการ technical deep dive ที่ solutions@introl.com

อ้างอิง

Dell Technologies. 2024. "Dell AI Factory Transforms Data Centers with Advanced Cooling, High-Density Compute and AI Storage Innovations." Press release, October 15. Dell Technologies Newsroom

Introl. 2025. "GPU Infrastructure Deployments and Global Field Engineers." Accessed June 23. introl.com

Lambda. 2025. "AI Cloud Pricing - NVIDIA B200 Clusters." Accessed June 23. Lambda Labs Pricing

NVIDIA. 2025. "GB300 NVL72 Product Page." Accessed June 23. NVIDIA Data Center

NVIDIA. 2025. "NVIDIA Blackwell Ultra AI Factory Platform Paves Way for Age of AI Reasoning." Press release, March 18. NVIDIA News

Supermicro. 2025. "NVIDIA GB300 NVL72 SuperCluster Datasheet." February. Supermicro Datasheet

The Register. 2024. Mann, Tobias. "One Rack, 120 kW of Compute: A Closer Look at NVIDIA's DGX GB200 NVL72 Beast." March 21. The Register

การแก้ไข (9 มกราคม 2026): ข้อกำหนดการโหลดพื้นได้รับการแก้ไขจาก "14 kN/m² (2,030 psf)" เป็น "21 kN/m² (~440 psf)" — ต้นฉบับมีข้อผิดพลาดในการแปลงหน่วย นอกจากนี้ยังชี้แจงว่านี่เป็นค่าที่คำนวณจากน้ำหนักแร็คและ footprint ไม่ใช่ข้อกำหนด NVIDIA อย่างเป็นทางการ อิมพีแดนซ์ Twinax ได้รับการแก้ไขจาก 75-ohm เป็น 100-ohm differential ขอบคุณ Diana สำหรับการตรวจจับข้อผิดพลาดการโหลดพื้น