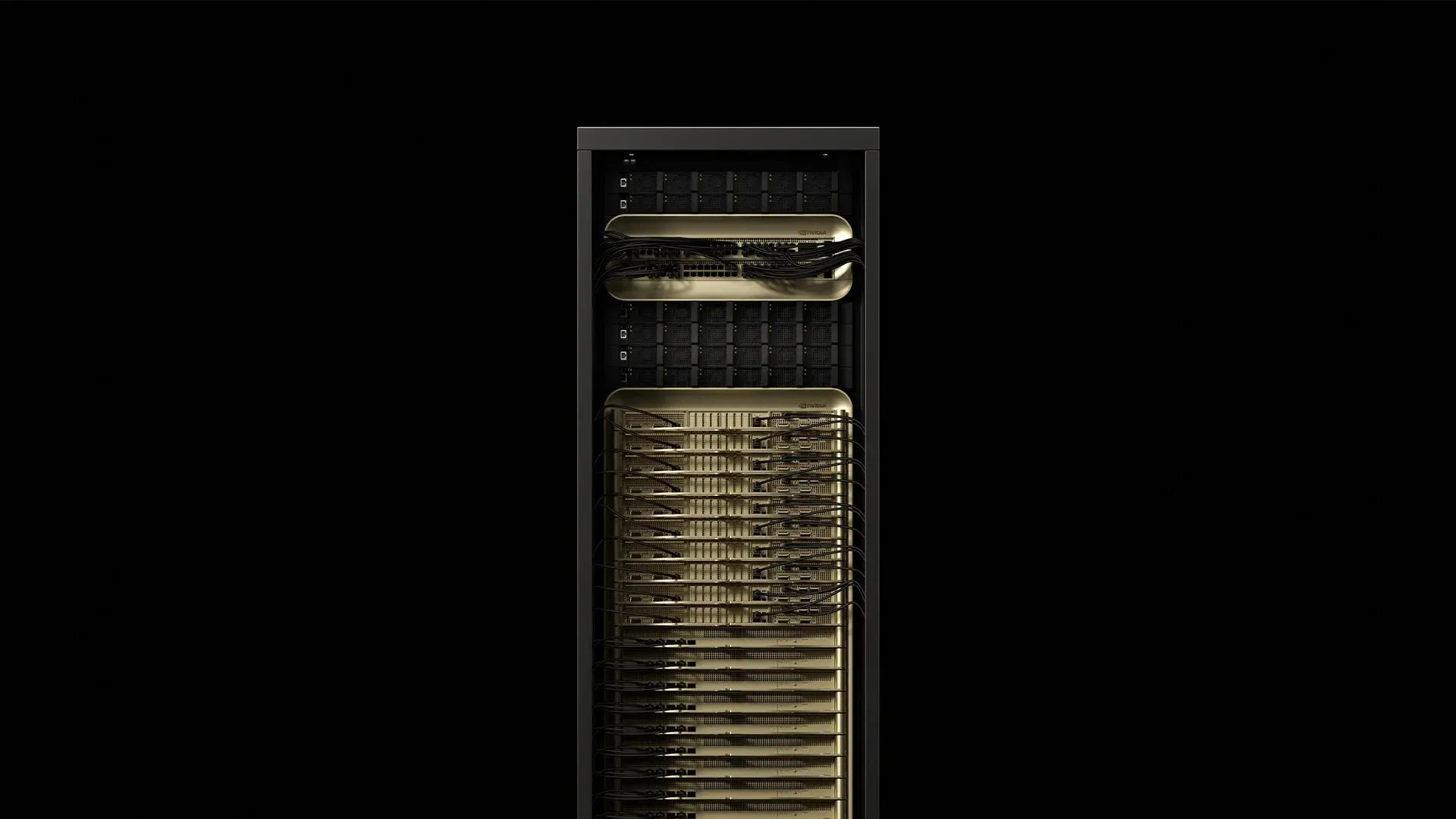

NVIDIA는 72개의 Blackwell Ultra GPU와 36개의 Grace CPU를 액체 냉각 방식의 랙 스케일 유닛으로 결합하여 약 120kW를 소비하고 FP4 연산으로 1.1 exaFLOPS를 제공하는 GB300 NVL72를 개발했습니다. 이는 기존 GB200 NVL72보다 1.5배 더 높은 AI 성능을 제공합니다[^2025]. 이 단일 캐비닛은 현대 데이터센터 내부의 전력, 냉각, 케이블링에 대한 모든 기존 가정을 바꿔놓습니다. 첫 번째 상용 GB300 NVL72 배포를 준비하면서 배포 엔지니어들이 학습하고 있는 내용을 소개합니다.

1. 랙 구조 분석

[caption id="" align="alignnone" width="1292"] 구성요소개수주요 사양전력 소비출처Grace‑Blackwell 컴퓨트 트레이18각 ~6.5kW총 117kWSupermicro 2025NVLink‑5 스위치 트레이9130TB/s 집계 패브릭총 3.6kWSupermicro 2025전원 쉘프8132kW 총 DC 출력0.8kW 오버헤드Supermicro 2025Bluefield‑3 DPU18스토리지 & 보안 오프로드컴퓨트에 포함The Register 2024 [/caption]

구성요소개수주요 사양전력 소비출처Grace‑Blackwell 컴퓨트 트레이18각 ~6.5kW총 117kWSupermicro 2025NVLink‑5 스위치 트레이9130TB/s 집계 패브릭총 3.6kWSupermicro 2025전원 쉘프8132kW 총 DC 출력0.8kW 오버헤드Supermicro 2025Bluefield‑3 DPU18스토리지 & 보안 오프로드컴퓨트에 포함The Register 2024 [/caption]

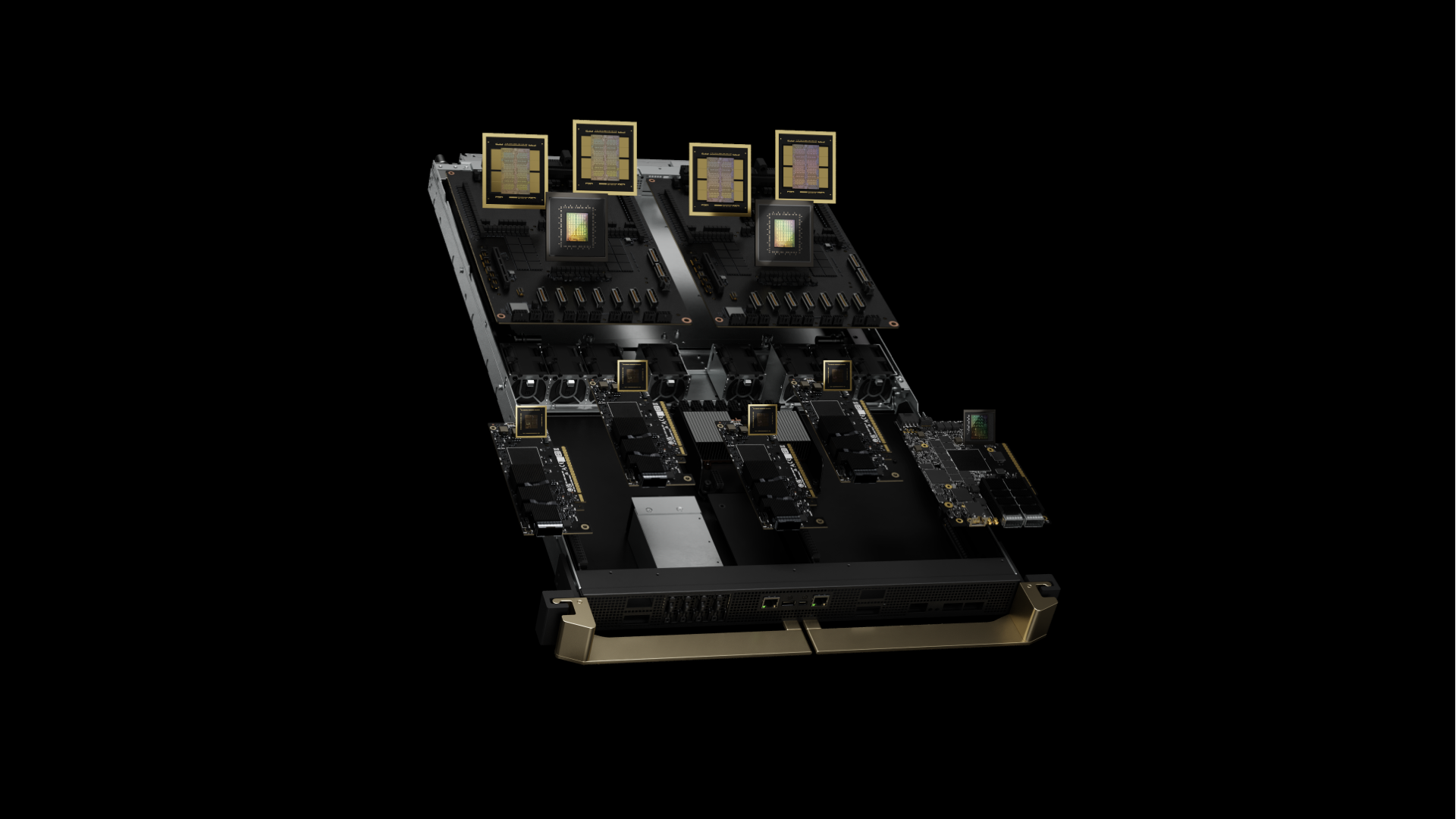

캐비닛의 무게는 약 1.36t(3,000lb)이며 기존 42U 랙과 동일한 설치 공간을 차지합니다[^2024]. GB300 NVL72는 Blackwell Ultra를 나타내며, 8-high 대신 12-high HBM3e 스택을 통해 기존 B200의 192GB보다 50% 더 많은 GPU당 288GB HBM3e 메모리를 갖춘 향상된 B300 GPU를 특징으로 합니다. 각 슈퍼칩은 이제 기존의 2-GPU 구성과 비교하여 4개의 B300 GPU를 2개의 Grace CPU와 쌍을 이룹니다. 각 Grace‑Blackwell 슈퍼칩은 2.6GHz에서 72개의 Blackwell Ultra GPU 코어를 기본 주파수 3.1GHz에서 실행되는 72코어 Arm Neoverse V2 CPU와 쌍을 이룹니다. 통합된 HBM3e 메모리는 GPU당 8TB/s, 용량 288GB를 제공합니다.

현장 인사이트: 상위 트레이에 컴퓨팅 자원이 밀도 높게 배치되어 랙의 무게중심이 표준 서버보다 18% 높습니다. 이제 모범 사례에서는 풀 로드 작동 중 관찰되는 미세 진동에 대응하기 위해 표준 케이지 너트 대신 M12 볼트로 마운팅 레일을 고정할 것을 권장합니다.

2. 전원 공급: 전력 전달

GB300 NVL72 랙은 내장 PSU 쉘프와 함께 출고되어 풀 로드에서 94.5% 효율을 제공합니다. 혼합 정밀도 훈련 워크로드 중 피크 소비량은 120.8kW에 도달합니다. 전력 품질 분석기는 일반적으로 0.97 역률을 기록합니다.

전압 토폴로지 비교:

- 208V/60Hz: 335A 라인 전류, 4/0 AWG 구리(107mm²) 필요

- 415V/50‑60Hz: 168A 라인 전류, 70mm² 구리만 필요

- 480V/60Hz: 145A 라인 전류, 북미 배포 최소

업계 모범 사례는 160A IEC 60309 커넥터를 통해 랙당 듀얼 415V 3상 피드를 프로비저닝하는 것입니다. 이 선택은 208V에 비해 I²R 손실을 75% 줄이면서 유럽 시설 표준과의 호환성을 유지합니다. 현장 측정에 따르면 차단기 패널은 일반적으로 22°C 실내에서 85% 열 등급 이하로 유지됩니다.

고조파 완화: GB300 NVL72 랙은 일반적인 AI 훈련 부하에서 4.8%의 총 고조파 왜곡을 나타냅니다. 8개 랙을 초과하는 배포는 일반적으로 IEEE 519 규정 준수를 유지하기 위해 전용 변압기에서 12-pulse 정류기가 필요합니다.

3. 냉각 플레이북: 열 엔지니어링 현실

각 Blackwell Ultra GPU 다이는 744mm²이며 콜드 플레이트 인터페이스를 통해 최대 1,000W를 방출합니다. Grace CPU는 72개 코어에서 추가로 500W를 추가합니다. Dell의 IR7000 프로그램은 액체를 Blackwell급 장비의 기본 경로로 포지셔닝하여, 폐쇄형 후면 도어 열교환기로 랙당 최대 480kW 용량을 주장합니다[^2024].

권장 열 계층:

- ≤80kW/랙: 18°C 공급 수온, 35L/min 유량의 후면 도어 열교환기

- 80–132kW/랙: DTC(Direct‑to‑chip) 루프 필수, 15°C 공급, 30L/min 최소

- 132kW/랙: 침수 냉각 또는 분할 랙 구성 필요

현장 배포에서의 DTC 사양:

- 콜드 플레이트 ΔT: 풀 로드에서 12–15°C (GPU 접합부 온도 83–87°C)

- 압력 강하: 30% 프로필렌 글리콜로 완전 루프에서 2.1bar

- 유량 분배: 모든 72개 GPU 콜드 플레이트에서 ±3% 편차

- 누수율: < 0.1mL/년

중요한 인사이트: Blackwell Ultra의 전력 전달 네트워크는 마이크로초 규모의 과도 현상을 나타내며, 기울기 동기화 중에 정상 상태 전력의 1.4배에 도달합니다. 업계 관행에서는 GPU 스로틀링 없이 이러한 열 스파이크를 처리하기 위해 정격 TDP의 110%로 냉각을 크기 조정할 것을 권장합니다.

4. 네트워크 패브릭: NVLink 5.0 및 향상된 연결성 관리

각 GB300 NVL72는 NVLink 5.0을 갖춘 72개의 Blackwell Ultra GPU를 포함하여 GPU당 1.8TB/s 대역폭과 시스템 전체에 130TB/s 총 NVLink 대역폭을 제공합니다. 5세대 NVLink는 링크당 200Gbps 신호 속도로 작동하며, GPU당 18개의 링크를 제공합니다. 9개의 NVSwitch 칩은 300나노초 스위치 지연 시간으로 이 트래픽을 라우팅하고 576방향 GPU 간 통신 패턴을 지원합니다.

랙 간 연결은 이제 GPU당 800Gb/s 네트워크 연결(이전 세대의 400Gb/s에서 두 배)을 제공하는 ConnectX-8 SuperNIC을 특징으로 하며, NVIDIA Quantum-X800 InfiniBand와 Spectrum-X Ethernet 플랫폼을 모두 지원합니다.

케이블링 아키텍처:

- 랙 내부: 1,728개의 구리 Twinax 케이블(100옴 차동 임피던스, 0.5m 길이)

- 랙 간: OM4 MMF 위에 800G 트랜시버를 통한 90개 QSFP112 포트

- 스토리지/관리: 각각 듀얼 800G 링크를 갖춘 18개 Bluefield‑3 DPU

현장 측정:

- 광학 예산: 150m OM4 스팬에 대해 1.5dB 삽입 손실 예산

- BER 성능: 10⁻¹⁵ 미만 @ 25°C 작동 온도

- 커넥터 밀도: 랙당 1,908개 터미네이션(전원 포함)

모범 사례는 APC 연마로 사전 터미네이션된 144섬유 트렁크 어셈블리를 출하하고 TIA-568 표준에 따라 삽입 손실/반사 손실 테스트로 모든 커넥터를 검증하는 것입니다. 숙련된 2인 팀은 평균 2.8시간에 GB300 NVL72 광섬유 설치를 완료할 수 있습니다. 이는 기술자가 현장에서 케이블을 제작할 때의 7.5시간에서 단축된 것입니다.

신호 무결성 인사이트: NVLink‑5는 25GBd PAM‑4 신호를 사용하여 작동합니다. 일반적인 설치에서는 Twinax 연결당 2.1dB 삽입 손실 예산을 유지하고 아이 다이어그램 마진 > 0.3UI를 달성합니다.

5. 현장 테스트된 배포 체크리스트

구조 요구사항:

- 바닥 하중: 분산 하중에 대해 ≥21kN/m²(~440psf) 인증; 0.64m² 설치 면적에서 1,360kg 랙으로부터 계산. 참고: NVIDIA는 공식 바닥 하중 사양을 발표하지 않음—특정 설치에 대해서는 구조 엔지니어와 확인하세요.

- 내진 브레이싱: Zone 4 설치는 IBC 2021에 따른 추가 X-브레이싱 필요

- 진동 절연: 격리 패드 < 5Hz 고유 주파수

전력 인프라:

- Schneider PM8000 분기 회로 모니터링을 갖춘 듀얼 415V 피드, 각 160A

- UPS 크기 조정: 온라인 이중 변환 토폴로지로 랙당 150kVA(125% 안전 여유)

- 접지: 4옴 미만 임피던스의 격리된 장비 접지

냉각 사양:

- 냉각수 품질: pH 8.5–9.5, 전도도 < 2.5μS/cm

- 필터 교체: 1,000시간마다 5μm 주름형, 2,000시간마다 1μm 최종

- 누수 감지: 0.1mL 감도의 모든 QDC 피팅에서 전도성 유체 센서

예비 부품 재고:

- NVSwitch 트레이 1개(납기: 6주)

- CDU 펌프 카트리지 2개(MTBF: 8,760시간)

- QSFP112 트랜시버 20개(현장 고장률: 연간 0.02%)

- 비상 열 인터페이스 재료(Honeywell PTM7950, 5g 튜브)

원격 핸즈 SLA: 4시간 현장 대응이 업계 표준이 되고 있습니다. 주요 배포 파트너는 99% 이상의 가동 시간으로 여러 국가에서 이 목표를 유지합니다.

6. 상용 로드에서의 성능 특성화

AI 추론 벤치마크(초기 배포 보고서에서):

- DeepSeek R1-671B 모델: 최대 1,000토큰/초 지속 처리량

- GPT‑3 175B 파라미터 모델: 평균 847토큰/초/GPU

- Stable Diffusion 2.1: 1024×1024 해상도에서 14.2이미지/초

- ResNet‑50 ImageNet 훈련: 2,340샘플/초 지속 처리량

전력 효율 확장:

- 단일 랙 사용률: 95% GPU 사용률에서 1.42GFLOPS/Watt

- 10랙 클러스터: 1.38GFLOPS/Watt(냉각 오버헤드로 효율 감소)

- 네트워크 유휴 전력: 랙당 3.2kW(NVSwitch + 트랜시버)

AI 추론 성능 향상: GB300 NVL72는 사용자당 초당 토큰에서 10배 향상, 메가와트당 TPS에서 5배 향상을 Hopper와 비교하여 제공하며, AI 팩토리 출력 성능에서 50배의 잠재적 증가를 얻습니다.

열 사이클링 효과: 2,000시간의 상용 작동 후, 초기 배포에서는 열 인터페이스 재료 펌프 아웃으로 인해 0.3%의 성능 저하를 보고합니다. 18개월 간격으로 예약된 TIM 교체는 최고 성능을 유지합니다.

7. 클라우드 vs 온프레미스 TCO 분석

Lambda는 다년 약정으로 GPU시간당 $2.99만큼 낮은 B200 GPU를 제공합니다(Lambda 2025). 업계 배포의 실제 시설 비용을 통합한 재무 모델링은 다음을 보여줍니다:

36개월 동안 랙당 비용 분석:

- 하드웨어 CapEx: GB300 NVL72에 대해 $3.7-4.0M(예비 부품 및 도구 포함)

- 시설 전력: 85% 평균 사용률로 $0.08/kWh에서 $310K

- 냉각 인프라: $180K(CDU, 배관, 제어)

- 운영 직원: $240K(0.25FTE 완전 부하 비용)

- 총계: $4.43-4.73M vs $4.7M 클라우드 동등

감가상각, 금융, 기회비용을 고려하여 18개월 동안 67% 평균 사용률에서 손익분기점이 발생합니다. 기업 CFO는 클라우드 벤더 종속을 피하면서 예산 예측 가능성을 얻습니다.

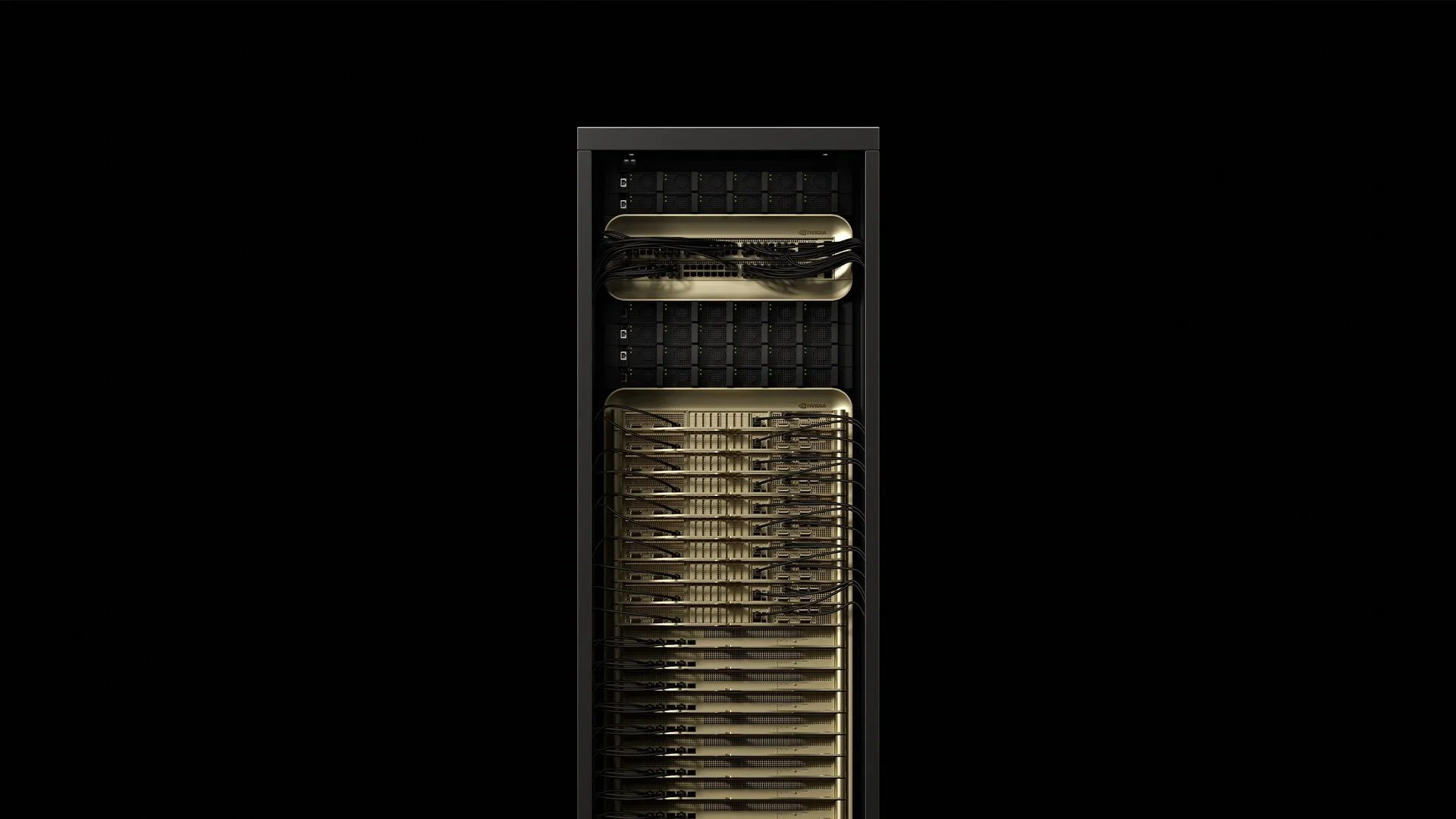

8. GB300 vs GB200: Blackwell Ultra 이해하기

[caption id="" align="alignnone" width="1920"] 이전 세대 GB200 그림 [/caption]

이전 세대 GB200 그림 [/caption]

GB300 NVL72(Blackwell Ultra)는 기존 GB200 NVL72에서 상당한 진화를 나타냅니다. 주요 개선사항으로는 1.5배 더 많은 AI 컴퓨팅 성능, GPU당 288GB HBM3e 메모리(192GB 대비), AI 추론 애플리케이션을 위한 테스트 시간 스케일링 추론에 대한 향상된 초점이 있습니다.

새로운 아키텍처는 Hopper와 비교하여 사용자당 초당 토큰에서 10배 향상, 메가와트당 TPS에서 5배 향상을 제공하여 AI 팩토리 출력에서 50배의 잠재적 증가를 달성합니다. 이는 GB300 NVL72를 DeepSeek R1과 같은 모델이 정확도 향상을 위해 추론 중에 상당히 더 많은 컴퓨팅을 필요로 하는 AI 추론의 새로운 시대에 특별히 최적화되도록 합니다.

가용성 일정: GB300 NVL72 시스템은 2025년 하반기에 파트너로부터 예상되며, 현재 이용 가능한 GB200 NVL72와 비교됩니다.

9. Fortune 500이 전문 배포 파트너를 선택하는 이유

주요 배포 전문가들은 광범위한 현장 엔지니어링 팀을 통해 4시간 글로벌 서비스 수준 계약(SLA)을 유지하면서 850개 이상의 데이터센터에 100,000개 이상의 GPU를 설치했습니다. 업계는 2022년 이후 수천 마일의 광섬유와 여러 메가와트의 전용 AI 인프라를 위탁했습니다.

최근 배포 지표:

- 평균 사이트 준비 일정: 6.2주(업계 평균 11주에서 단축)

- 첫 번째 통과 성공률: 전원 켜기 테스트에서 97.3%

- 배포 후 문제: 첫 90일 내 0.08% 구성 요소 고장률

OEM은 하드웨어를 출하합니다. 전문 파트너는 하드웨어를 상용 인프라로 변환합니다. 계획 단계에서 경험 있는 배포 팀과 협력하면 사전 제작된 전력 하네스, 사전 단계화된 냉각 루프, 공장 터미네이션 광섬유 번들 사용을 통해 일정을 45% 단축할 수 있습니다.

마무리 생각

GB300 NVL72 캐비닛은 "랙의 서버"에서 "캐비닛의 데이터센터"로의 근본적인 전환을 나타냅니다. 물리학은 용서가 없습니다: 120kW의 컴퓨팅 밀도는 모든 전원 연결, 냉각 루프, 광섬유 터미네이션에서 정밀도를 요구합니다. Day 0에서 엔지니어링 기본 원칙을 숙달하면 Blackwell Ultra는 향후 수년간 혁신적인 AI 추론 성능을 제공할 것입니다.

2,000단어에 담지 못한 기술적 세부사항을 논의할 준비가 되셨나요? 저희 배포 엔지니어들은 이러한 대화에서 전문성을 발휘합니다—solutions@introl.com에서 기술 심층 분석을 예약하세요.

참고문헌

Dell Technologies. 2024. "Dell AI Factory Transforms Data Centers with Advanced Cooling, High-Density Compute and AI Storage Innovations." Press release, October 15. Dell Technologies Newsroom

Introl. 2025. "GPU Infrastructure Deployments and Global Field Engineers." Accessed June 23. introl.com

Lambda. 2025. "AI Cloud Pricing - NVIDIA B200 Clusters." Accessed June 23. Lambda Labs Pricing

NVIDIA. 2025. "GB300 NVL72 Product Page." Accessed June 23. NVIDIA Data Center

NVIDIA. 2025. "NVIDIA Blackwell Ultra AI Factory Platform Paves Way for Age of AI Reasoning." Press release, March 18. NVIDIA News

Supermicro. 2025. "NVIDIA GB300 NVL72 SuperCluster Datasheet." February. Supermicro Datasheet

The Register. 2024. Mann, Tobias. "One Rack, 120 kW of Compute: A Closer Look at NVIDIA's DGX GB200 NVL72 Beast." March 21. The Register

정정사항 (2026년 1월 9일): 바닥 하중 사양을 "14kN/m²(2,030psf)"에서 "21kN/m²(~440psf)"로 정정—원본에 단위 변환 오류가 있었습니다. 또한 이것이 NVIDIA의 공식 사양이 아닌 랙 무게와 설치 면적을 기반으로 한 계산 값임을 명확히 했습니다. Twinax 임피던스를 75옴에서 100옴 차동으로 정정했습니다. 바닥 하중 오류를 발견해 주신 Diana에게 감사드립니다.