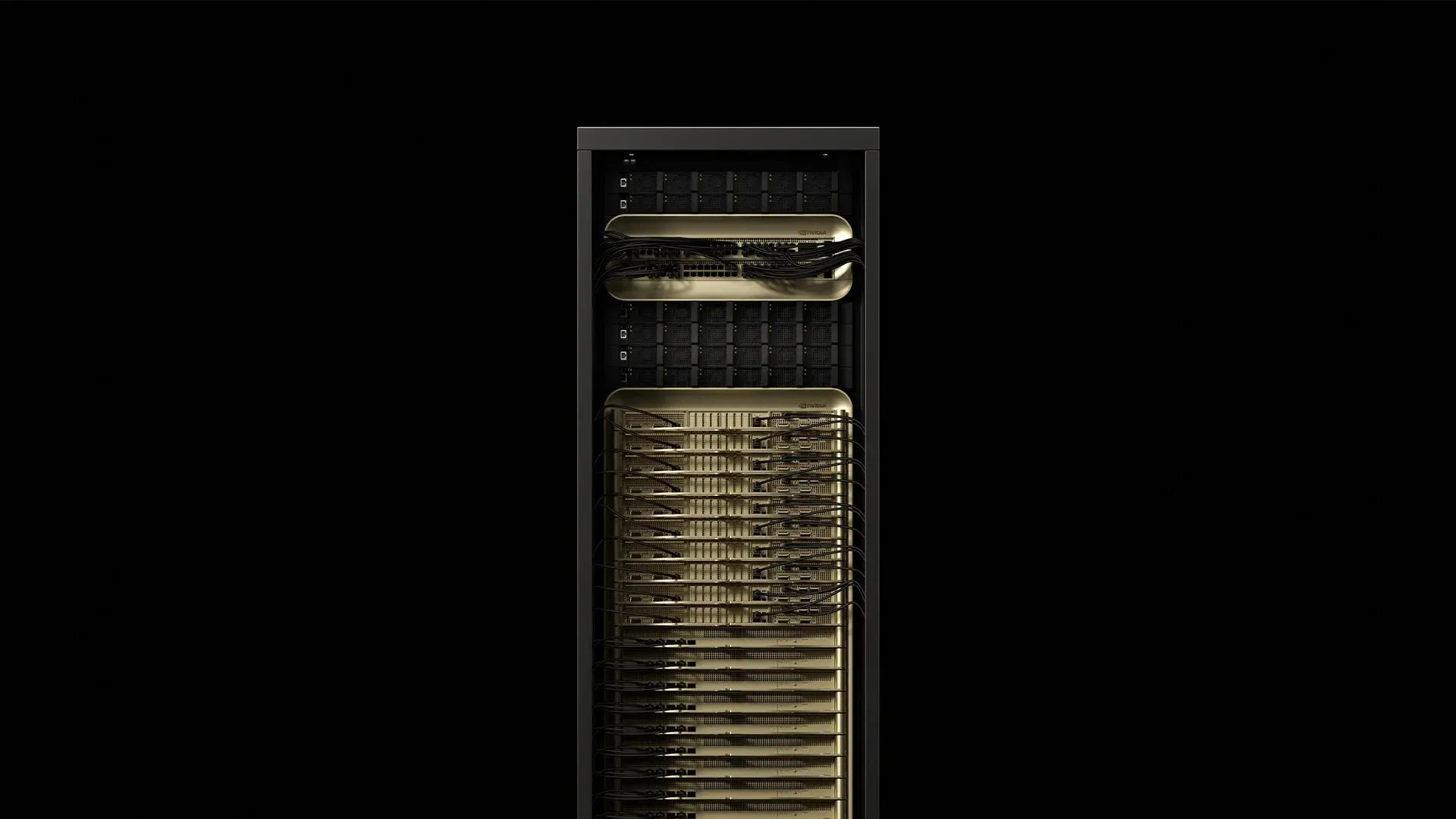

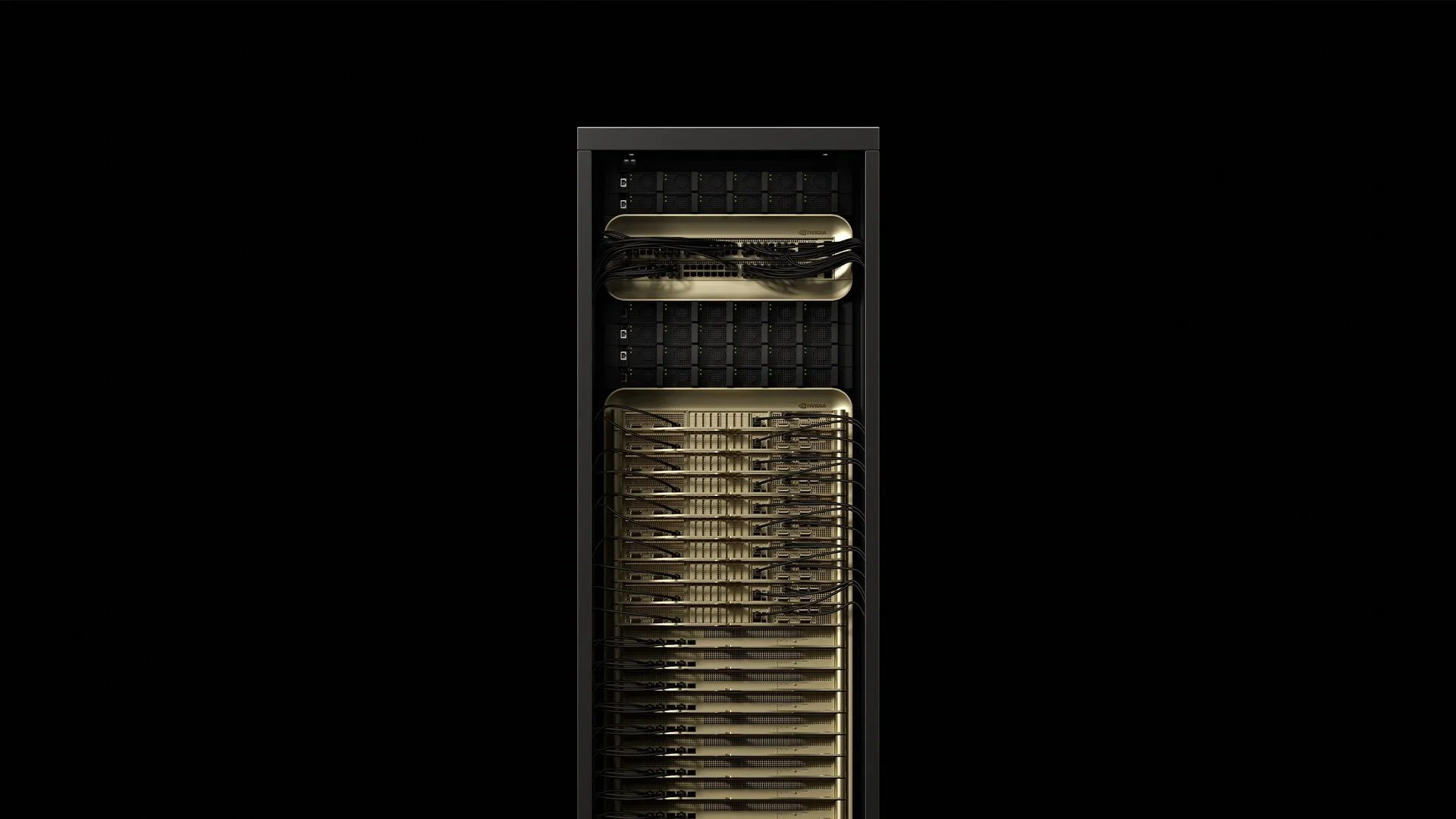

NVIDIA将72个Blackwell Ultra GPU和36个Grace CPU集成到一个液冷、机架级单元中,该单元功耗约120 kW,通过GB300 NVL72提供1.1 exaFLOPS的FP4计算能力——比原始GB200 NVL72的AI性能高出1.5倍[^2025]。这个单一机柜改变了现代数据中心内部关于电力、冷却和布线的所有假设。以下是部署工程师在为首批生产GB300 NVL72交付准备站点时所学到的经验。

1. 解析机架

[caption id="" align="alignnone" width="1292"] 组件数量关键规格功耗来源Grace‑Blackwell计算托盘18每个约6.5 kW总计117 kWSupermicro 2025NVLink‑5交换机托盘9130 TB/s聚合架构总计3.6 kWSupermicro 2025电源架构8132 kW总DC输出0.8 kW开销Supermicro 2025Bluefield‑3 DPU18存储与安全卸载包含在计算中The Register 2024 [/caption]

组件数量关键规格功耗来源Grace‑Blackwell计算托盘18每个约6.5 kW总计117 kWSupermicro 2025NVLink‑5交换机托盘9130 TB/s聚合架构总计3.6 kWSupermicro 2025电源架构8132 kW总DC输出0.8 kW开销Supermicro 2025Bluefield‑3 DPU18存储与安全卸载包含在计算中The Register 2024 [/caption]

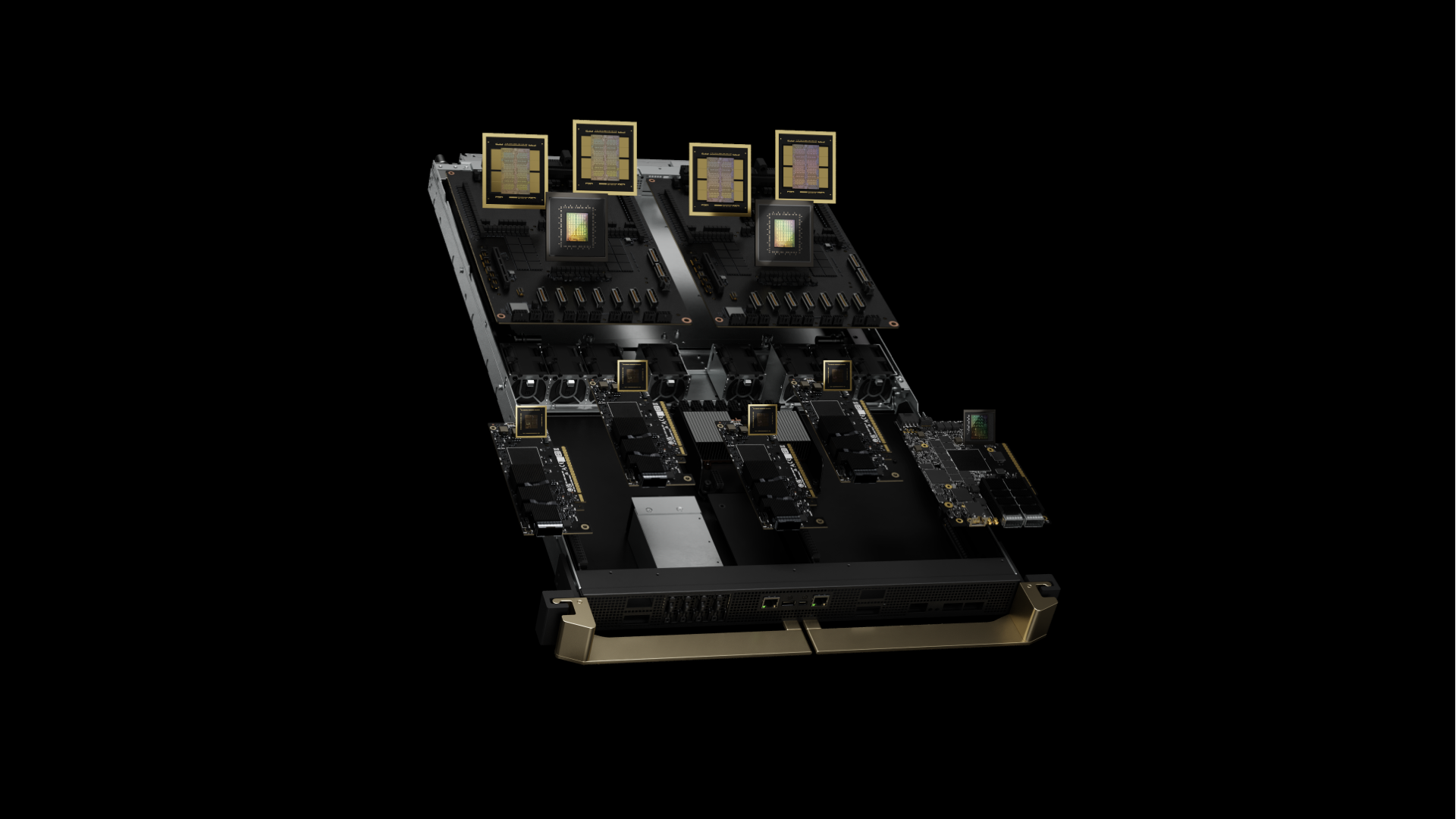

机柜重约1.36吨(3,000磅),占地面积与传统42U机架相同[^2024]。GB300 NVL72代表Blackwell Ultra,采用增强的B300 GPU,每个GPU配备288 GB HBM3e内存(比原始B200的192 GB多50%),通过12层HBM3e堆叠而非8层实现。现在每个超级芯片将四个B300 GPU与两个Grace CPU配对,而原始配置为两个GPU。每个Grace‑Blackwell超级芯片将72个运行在2.6 GHz的Blackwell Ultra GPU核心与一个运行在3.1 GHz基频的72核Arm Neoverse V2 CPU配对。集成的HBM3e内存为每个GPU提供8 TB/s带宽,容量为288 GB。

现场见解: 由于计算资源在上层托盘中的密集放置,机架重心比标准服务器高18%。最佳实践现在建议使用M12螺栓而非标准笼形螺母来固定安装导轨,以解决在满负载运行期间观察到的微振动问题。

2. 供电:电力传输

GB300 NVL72机架配备内置PSU架构,在满负载时效率达94.5%。混合精度训练工作负载期间峰值功耗达120.8 kW——电能质量分析仪通常记录0.97功率因数

电压拓扑比较:

-

208V/60Hz:335A线电流,需要4/0 AWG铜线(107mm²)

-

415V/50‑60Hz:168A线电流,仅需70mm²铜线

-

480V/60Hz:145A线电流,北美部署最少

行业最佳实践涉及通过160A IEC 60309连接器为每个机架提供双路415V三相电源。这种选择与208V相比减少75%的I²R损耗,同时保持与欧洲设施标准的兼容性。现场测量表明,断路器面板在22°C房间内通常保持在85%热降额以下。

谐波抑制: GB300 NVL72机架在典型AI训练负载下表现出4.8%的总谐波失真。超过八个机架的部署通常需要在专用变压器上使用12脉冲整流器以保持IEEE 519合规性。

3. 冷却方案:热工程现实

每个Blackwell Ultra GPU芯片尺寸为744 mm²,通过其冷板接口散发高达1,000 W。Grace CPU在其72个核心上增加另外500W。Dell的IR7000项目将液冷定位为Blackwell级设备的默认路径,声称使用封闭式后门热交换器每机架容量高达480 kW[^2024]。

推荐的热分级:

- ≤80 kW/机架:后门热交换器,18°C供水,35 L/min流量

- 80–132 kW/机架:直接到芯片(DTC)循环必需,15°C供水,最少30 L/min

- 132 kW/机架:需要浸没式冷却或分体式机架配置

来自现场部署的DTC规格:

- 冷板ΔT:满负载时12–15°C(GPU结温83–87°C)

- 压降:使用30%丙二醇的完整回路压降2.1 bar

- 流量分配:所有72个GPU冷板间±3%差异

- 泄漏率:

关键见解: Blackwell Ultra的电力传输网络表现出微秒级瞬变,在梯度同步期间达到稳态功率的1.4倍。行业实践建议将冷却系统按额定TDP的110%设计,以处理这些热峰值而不会导致GPU节流。

4. 网络架构:管理NVLink 5.0和增强连接

每个GB300 NVL72包含72个配备NVLink 5.0的Blackwell Ultra GPU,每个GPU提供1.8 TB/s带宽,系统总NVLink带宽为130 TB/s。第五代NVLink以每链路200 Gbps信号速率运行,每个GPU有18个链路。九个NVSwitch芯片以300纳秒交换延迟路由此流量,支持576路GPU到GPU通信模式。

机架间连接现在采用ConnectX-8 SuperNIC,为每个GPU提供800 Gb/s网络连接(是上一代400 Gb/s的两倍),同时支持NVIDIA Quantum-X800 InfiniBand和Spectrum-X Ethernet平台。

布线架构:

- 机架内:1,728根铜质Twinax电缆(100欧姆差分阻抗)

- 机架间:90个QSFP112端口,通过OM4 MMF上的800G收发器

- 存储/管理:18个Bluefield‑3 DPU,每个具有双800G链路

现场测量:

- 光功率预算:150m OM4跨度上1.5 dB插入损耗预算

- BER性能:

- 连接器密度:每机架1,908个端接(包括电源)

最佳实践涉及运送预端接的144芯主干组件,采用APC抛光,并根据TIA-568标准对每个连接器进行插入损耗/回波损耗测试验证。经验丰富的两人团队平均可在2.8小时内完成GB300 NVL72光纤安装——比技术人员现场制作电缆的7.5小时大幅减少。

信号完整性见解: NVLink‑5使用25 GBd PAM‑4信号。典型安装在每个Twinax连接上保持2.1 dB插入损耗预算

5. 现场测试的部署检查清单

结构要求:

- 楼面荷载:认证≥21 kN/m²(约440 psf)分布荷载;根据0.64 m²占地面积上1,360 kg机架计算。注:NVIDIA未发布官方楼面荷载规格——请与结构工程师验证您的具体安装。

- 抗震支撑:4区安装需要根据IBC 2021额外的X型支撑

- 隔振:

电力基础设施:

- 双路415V电源,每路160A,配备Schneider PM8000分支电路监控

- UPS容量:每机架150 kVA(125%安全裕度),采用在线双变换拓扑

- 接地:隔离设备接地

冷却规格:

- 冷却剂质量:

- 滤芯更换:5 µm褶皱滤芯每1,000小时,1 µm精滤每2,000小时

- 泄漏检测:所有QDC接头处的导电流体传感器,灵敏度0.1 mL

备件库存:

- 一个NVSwitch托盘(交货期:6周)

- 两个CDU泵筒(MTBF:8,760小时)

- 20个QSFP112收发器(现场故障率:年度0.02%)

- 应急导热界面材料(Honeywell PTM7950,5g管装)

远程操作SLA:4小时现场响应正成为行业标准——领先的部署合作伙伴在多个国家保持这一目标,正常运行时间>99%。

6. 生产负载下的性能特征

AI推理基准测试(来自早期部署报告):

- DeepSeek R1-671B模型:高达1,000 tokens/秒持续吞吐量

- GPT‑3 175B参数模型:平均847 tokens/秒/GPU

- Stable Diffusion 2.1:1024×1024分辨率下14.2图像/秒

- ResNet‑50 ImageNet训练:2,340样本/秒持续吞吐量

功效扩展:

- 单机架利用率:95% GPU利用率下1.42 GFLOPS/Watt

- 10机架集群:1.38 GFLOPS/Watt(冷却开销降低效率)

- 网络空闲功率:每机架3.2 kW(NVSwitch + 收发器)

AI推理性能改进: GB300 NVL72与Hopper相比,每用户tokens/秒提升10倍,每兆瓦TPS改进5倍,产生50倍AI工厂输出性能潜在增长。

热循环效应:经过2,000小时生产运行后,早期部署报告由于导热界面材料泵送效应导致0.3%性能下降。18个月间隔的计划TIM更换维持峰值性能。

7. 云端与本地TCO分析

Lambda提供B200 GPU,多年承诺低至每GPU小时$2.99(Lambda 2025)。结合来自行业部署的实际设施成本的财务建模显示:

36个月内每机架成本分解:

- 硬件CapEx:$3.7-4.0M(GB300 NVL72,包括备件和工具)

- 设施电力:$310K @ $0.08/kWh,85%平均利用率

- 冷却基础设施:$180K(CDU、管道、控制)

- 运营人员:$240K(0.25 FTE全负荷成本)

- 总计:$4.43-4.73M vs $4.7M云端等价

考虑折旧、融资和机会成本,盈亏平衡发生在18个月内67%平均利用率。企业CFO获得预算可预测性,同时避免云供应商锁定。

8. GB300 vs GB200:理解Blackwell Ultra

[caption id="" align="alignnone" width="1920"] 上一代GB200图示 [/caption]

上一代GB200图示 [/caption]

GB300 NVL72(Blackwell Ultra)代表了对原始GB200 NVL72的重大演进。关键改进包括1.5倍的AI计算性能、每GPU 288 GB HBM3e内存(vs 192 GB),以及对AI推理应用中测试时间扩展推理的增强关注。

新架构与Hopper相比提供每用户10倍tokens/秒提升和每兆瓦5倍TPS改进,产生50倍的AI工厂输出潜在增长。这使得GB300 NVL72专为新兴的AI推理时代优化,其中像DeepSeek R1这样的模型在推理期间需要大量更多计算来提高准确性。

可用性时间线: GB300 NVL72系统预计合作伙伴将在2025年下半年提供,而GB200 NVL72现在就可用。

9. 财富500强选择专业部署合作伙伴的原因

领先的部署专家已在超过850个数据中心安装了超过100,000个GPU,通过广泛的现场工程团队维持4小时全球服务级别协议(SLA)。自2022年以来,该行业已调试了数千英里光纤和多兆瓦的专用AI基础设施。

最近的部署指标:

- 平均站点准备时间线:6.2周(比11周行业平均降低)

- 首次通过成功率:电源测试97.3%

- 部署后问题:前90天0.08%组件故障率

OEM运送硬件;专业合作伙伴将硬件转化为生产基础设施。在规划阶段聘请经验丰富的部署团队可通过使用预制电力线束、预阶段冷却回路和工厂端接光纤束将时间线减少45%。

结束语

GB300 NVL72机柜代表从"机架中的服务器"到"机柜中的数据中心"的根本转变。物理定律是无情的:120 kW的计算密度需要在每个电力连接、冷却回路和光纤端接中保持精确。在第0天掌握工程基础,Blackwell Ultra将在未来几年提供变革性的AI推理性能。

准备讨论我们无法在2,000字中涵盖的技术细节?我们的部署工程师热衷于这些对话——在solutions@introl.com安排技术深入讨论。

参考文献

Dell Technologies. 2024. "Dell AI Factory Transforms Data Centers with Advanced Cooling, High-Density Compute and AI Storage Innovations." Press release, October 15. Dell Technologies Newsroom

Introl. 2025. "GPU Infrastructure Deployments and Global Field Engineers." Accessed June 23. introl.com

Lambda. 2025. "AI Cloud Pricing - NVIDIA B200 Clusters." Accessed June 23. Lambda Labs Pricing

NVIDIA. 2025. "GB300 NVL72 Product Page." Accessed June 23. NVIDIA Data Center

NVIDIA. 2025. "NVIDIA Blackwell Ultra AI Factory Platform Paves Way for Age of AI Reasoning." Press release, March 18. NVIDIA News

Supermicro. 2025. "NVIDIA GB300 NVL72 SuperCluster Datasheet." February. Supermicro Datasheet

The Register. 2024. Mann, Tobias. "One Rack, 120 kW of Compute: A Closer Look at NVIDIA's DGX GB200 NVL72 Beast." March 21. The Register

更正(2026年1月9日):楼面荷载规格从"14 kN/m²(2,030 psf)"更正为"21 kN/m²(约440 psf)"——原始数据包含单位转换错误。同时澄清这是基于机架重量和占地面积的计算值,不是NVIDIA官方规格。Twinax阻抗从75欧姆更正为100欧姆差分。感谢Diana发现楼面荷载错误。