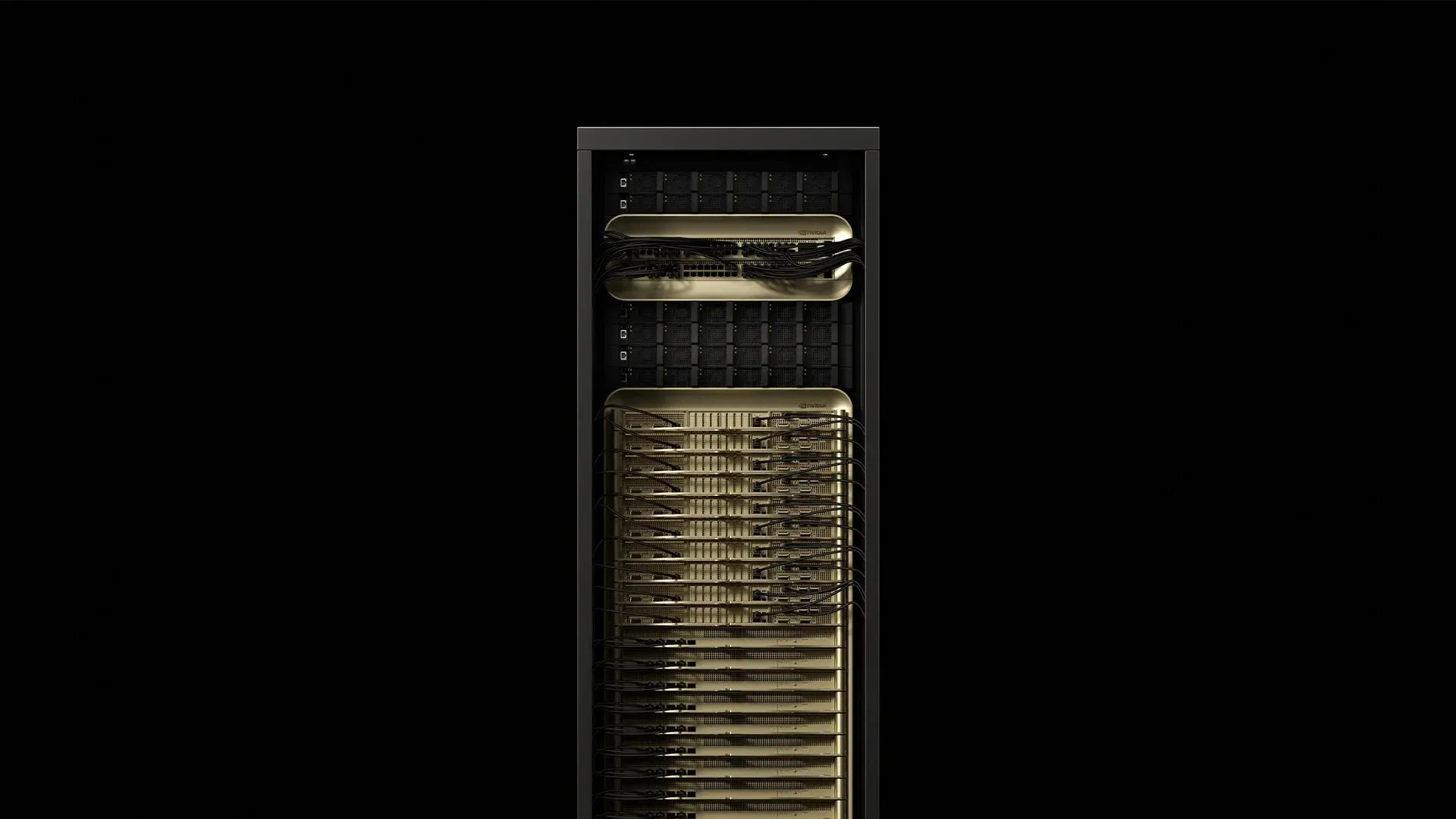

NVIDIA a assemblé 72 GPU Blackwell Ultra et 36 CPU Grace dans une unité à l'échelle du rack refroidie par liquide qui consomme environ 120 kW et délivre 1,1 exaFLOPS de calcul FP4 avec le GB300 NVL72 — 1,5x plus de performances IA que le GB200 NVL72 original (NVIDIA, 2025). Cette armoire unique change toutes les hypothèses concernant l'alimentation, le refroidissement et le câblage dans les data centers modernes. Voici ce que les ingénieurs de déploiement apprennent en préparant les sites pour les premières livraisons de production du GB300 NVL72.

1. Dissection du rack

[caption id="" align="alignnone" width="1292"] ComposantQuantitéSpécification cléConsommation électriqueSourceTrays de calcul Grace‑Blackwell18~6,5 kW chacun117 kW au totalSupermicro 2025Trays de switch NVLink‑59Fabric agrégé de 130 To/s3,6 kW au totalSupermicro 2025Étagères d'alimentation8Sortie DC totale de 132 kW0,8 kW de surchargeSupermicro 2025Bluefield‑3 DPUs18Déchargement stockage et sécuritéInclus dans le calculThe Register 2024 [/caption]

ComposantQuantitéSpécification cléConsommation électriqueSourceTrays de calcul Grace‑Blackwell18~6,5 kW chacun117 kW au totalSupermicro 2025Trays de switch NVLink‑59Fabric agrégé de 130 To/s3,6 kW au totalSupermicro 2025Étagères d'alimentation8Sortie DC totale de 132 kW0,8 kW de surchargeSupermicro 2025Bluefield‑3 DPUs18Déchargement stockage et sécuritéInclus dans le calculThe Register 2024 [/caption]

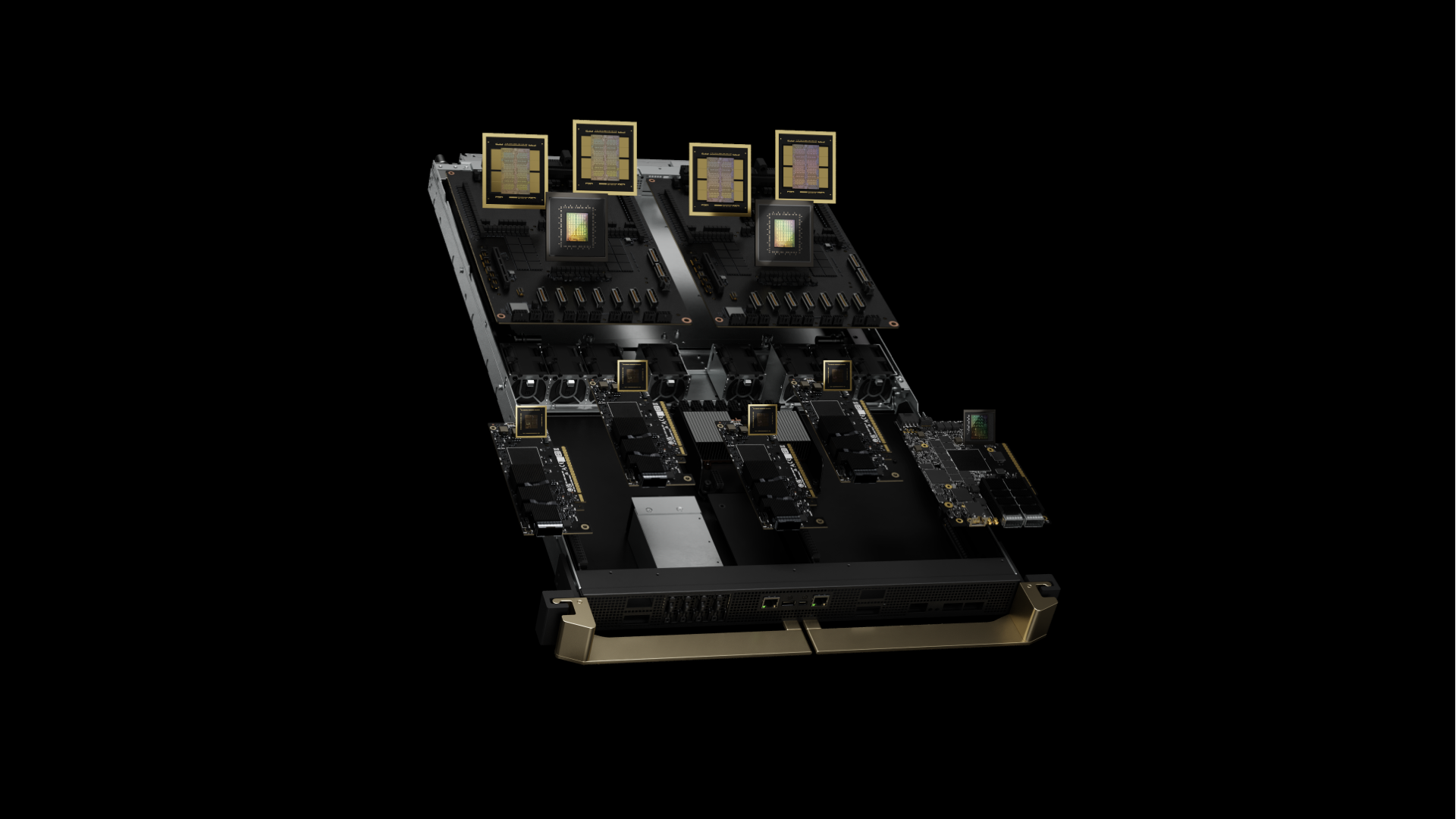

L'armoire pèse environ 1,36 t (3 000 lb) et occupe la même empreinte qu'un rack standard 42U (The Register, 2024). Le GB300 NVL72 représente Blackwell Ultra, avec des GPU B300 améliorés dotés de 288 Go de mémoire HBM3e par GPU (50 % de plus que les 192 Go du B200 original), grâce à des piles HBM3e de 12 couches au lieu de 8. Chaque superpuce associe désormais quatre GPU B300 à deux CPU Grace, contre la configuration originale à deux GPU. Chaque superpuce Grace‑Blackwell associe 72 cœurs GPU Blackwell Ultra à 2,6 GHz avec un CPU Arm Neoverse V2 à 72 cœurs fonctionnant à une fréquence de base de 3,1 GHz. La mémoire HBM3e intégrée délivre 8 To/s par GPU avec une capacité de 288 Go.

Retour terrain : Le centre de gravité du rack est situé 18 % plus haut que celui des serveurs standards en raison du placement dense des ressources de calcul dans les trays supérieurs. Les meilleures pratiques recommandent désormais d'ancrer les rails de montage avec des boulons M12, plutôt que des écrous cage standards, pour traiter les micro-vibrations observées en fonctionnement à pleine charge.

2. Alimenter la bête : distribution électrique

Un rack GB300 NVL72 est livré avec des étagères PSU intégrées, offrant une efficacité de 94,5 % à pleine charge. La consommation de pointe atteint 120,8 kW pendant les charges de travail d'entraînement en précision mixte — les analyseurs de qualité d'énergie enregistrent généralement un facteur de puissance de 0,97 avec

Comparaison des topologies de tension :

-

208V/60Hz : 335A de courant de ligne, nécessite du cuivre 4/0 AWG (107mm²)

-

415V/50‑60Hz : 168A de courant de ligne, nécessite seulement 70mm² de cuivre

-

480V/60Hz : 145A de courant de ligne, déploiement minimal en Amérique du Nord

La meilleure pratique de l'industrie implique de provisionner deux alimentations triphasées 415V par rack via des connecteurs IEC 60309 de 160A. Ce choix réduit les pertes I²R de 75 % par rapport au 208V tout en maintenant la compatibilité avec les standards des installations européennes. Les mesures terrain indiquent que les tableaux de disjoncteurs restent généralement en dessous de 85 % de déclassement thermique dans les salles à 22°C.

Atténuation des harmoniques : Les racks GB300 NVL72 présentent une distorsion harmonique totale de 4,8 % sous les charges d'entraînement IA typiques. Les déploiements dépassant huit racks nécessitent généralement des redresseurs 12 impulsions sur des transformateurs dédiés pour maintenir la conformité IEEE 519.

3. Guide du refroidissement : réalité de l'ingénierie thermique

Chaque puce GPU Blackwell Ultra mesure 744 mm² et dissipe jusqu'à 1 000 W à travers son interface de plaque froide. Le CPU Grace ajoute 500W supplémentaires sur ses 72 cœurs. Le programme IR7000 de Dell positionne le liquide comme la voie par défaut pour les équipements de classe Blackwell, revendiquant des capacités par rack jusqu'à 480 kW avec des échangeurs de chaleur à porte arrière fermée (Dell Technologies, 2024).

Hiérarchie thermique recommandée :

-

≤80 kW/rack : Échangeurs de chaleur à porte arrière avec eau d'alimentation à 18°C, débit de 35 L/min

-

80–132 kW/rack : Boucles direct-to-chip (DTC) obligatoires, alimentation à 15°C, minimum 30 L/min

-

132 kW/rack : Refroidissement par immersion ou configurations en rack divisé requises

Spécifications DTC issues des déploiements terrain :

-

ΔT de la plaque froide : 12–15°C à pleine charge (températures de jonction GPU 83–87°C)

-

Perte de charge : 2,1 bar sur la boucle complète avec 30 % de propylène glycol

-

Distribution du débit : ±3 % de variance sur les 72 plaques froides GPU

-

Taux de fuite :

Information critique : Le réseau de distribution d'alimentation de Blackwell Ultra présente des transitoires à l'échelle de la microseconde, atteignant 1,4 fois la puissance en régime permanent pendant la synchronisation des gradients. La pratique de l'industrie recommande de dimensionner le refroidissement pour 110 % du TDP nominal afin de gérer ces pics thermiques sans throttling GPU.

4. Fabric réseau : gestion de NVLink 5.0 et connectivité améliorée

Chaque GB300 NVL72 contient 72 GPU Blackwell Ultra avec NVLink 5.0, fournissant 1,8 To/s de bande passante par GPU et 130 To/s de bande passante NVLink totale sur le système. La cinquième génération de NVLink fonctionne à un taux de signalisation de 200 Gbps par lien, avec 18 liens par GPU. Les neuf puces NVSwitch routent ce trafic avec une latence de commutation de 300 nanosecondes et supportent des modèles de communication GPU-à-GPU à 576 voies.

La connectivité inter-rack dispose désormais de SuperNICs ConnectX-8 fournissant 800 Gb/s de connectivité réseau par GPU (le double des 400 Gb/s de la génération précédente), supportant les plateformes NVIDIA Quantum-X800 InfiniBand et Spectrum-X Ethernet.

Architecture de câblage :

-

Intra‑rack : 1 728 câbles Twinax cuivre (impédance 75 ohms,

-

Inter‑rack : 90 ports QSFP112 via transceivers 800G sur fibre OM4 MMF

-

Stockage/gestion : 18 DPUs Bluefield‑3 avec deux liens 800G chacun

Mesures terrain :

-

Budget optique : 1,5 dB de budget de perte d'insertion sur des portées OM4 de 150m

-

Performance BER :

-

Densité de connecteurs : 1 908 terminaisons par rack (alimentation incluse)

Les meilleures pratiques impliquent l'expédition d'assemblages de troncs pré-terminés de 144 fibres avec polissage APC et la vérification de chaque connecteur avec des tests de perte d'insertion/perte de retour selon les standards TIA-568. Des équipes expérimentées de deux personnes peuvent compléter une installation de fibre GB300 NVL72 en 2,8 heures en moyenne — contre 7,5 heures lorsque les techniciens fabriquent les câbles sur site.

Information sur l'intégrité du signal : NVLink‑5 fonctionne avec une signalisation PAM‑4 à 25 GBd. Les installations typiques maintiennent un budget de perte d'insertion de 2,1 dB par connexion Twinax et

5. Checklist de déploiement testée sur le terrain

Exigences structurelles :

-

Charge au sol : certifier ≥14 kN/m² (2 030 psf) ; le poids distribué dépasse la plupart des installations existantes

-

Contreventement sismique : les installations Zone 4 nécessitent un contreventement en X supplémentaire selon IBC 2021

-

Isolation des vibrations :

Infrastructure électrique :

-

Double alimentation 415V, 160A chacune, avec surveillance des circuits de dérivation Schneider PM8000

-

Dimensionnement UPS : 150 kVA par rack (marge de sécurité de 125 %) avec topologie double conversion en ligne

-

Mise à la terre : Terre d'équipement isolée avec

Spécifications de refroidissement :

-

Qualité du fluide caloporteur :

-

Remplacement des filtres : plissé 5 µm toutes les 1 000 heures, final 1 µm toutes les 2 000 heures

-

Détection de fuite : capteurs de fluide conductif sur tous les raccords QDC avec sensibilité de 0,1 mL

Inventaire de pièces de rechange :

-

Un tray NVSwitch (délai de livraison : 6 semaines)

-

Deux cartouches de pompe CDU (MTBF : 8 760 heures)

-

20 transceivers QSFP112 (taux de défaillance terrain : 0,02 % annuel)

-

Matériau d'interface thermique d'urgence (Honeywell PTM7950, tubes de 5g)

SLA d'intervention à distance : une réponse sur site en 4 heures devient le standard de l'industrie — les partenaires de déploiement leaders maintiennent cet objectif dans plusieurs pays avec un temps de fonctionnement >99 %.

6. Caractérisation des performances sous charges de production

Benchmarks de raisonnement IA (d'après les premiers rapports de déploiement) :

-

Modèle DeepSeek R1-671B : Jusqu'à 1 000 tokens/seconde en débit soutenu

-

Modèle GPT‑3 175B paramètres : 847 tokens/seconde/GPU en moyenne

-

Stable Diffusion 2.1 : 14,2 images/seconde à résolution 1024×1024

-

Entraînement ResNet‑50 ImageNet : 2 340 échantillons/seconde en débit soutenu

Mise à l'échelle de l'efficacité énergétique :

-

Utilisation d'un seul rack : 1,42 GFLOPS/Watt à 95 % d'utilisation GPU

-

Cluster de 10 racks : 1,38 GFLOPS/Watt (la surcharge de refroidissement réduit l'efficacité)

-

Puissance réseau au repos : 3,2 kW par rack (NVSwitch + transceivers)

Améliorations des performances de raisonnement IA : Le GB300 NVL72 offre une amélioration de 10x des tokens par seconde par utilisateur et une amélioration de 5x du TPS par mégawatt par rapport à Hopper, produisant une augmentation potentielle combinée de 50x des performances de sortie des usines d'IA.

Effets du cyclage thermique : Après 2 000 heures d'exploitation en production, les premiers déploiements rapportent une dégradation des performances de 0,3 % due au pompage du matériau d'interface thermique. Un remplacement programmé du TIM à intervalles de 18 mois maintient les performances maximales.

7. Analyse TCO cloud versus on-prem

Lambda propose des GPU B200 à partir de 2,99 $ par heure GPU avec des engagements pluriannuels (Lambda 2025). La modélisation financière intégrant les coûts réels des installations issus des déploiements de l'industrie montre :

Répartition des coûts par rack sur 36 mois :

-

CapEx matériel : 3,7-4,0 M$ (incluant pièces de rechange et outillage) pour le GB300 NVL72

-

Électricité des installations : 310 K$ @ 0,08 $/kWh avec 85 % d'utilisation moyenne

-

Infrastructure de refroidissement : 180 K$ (CDU, plomberie, contrôles)

-

Personnel d'exploitation : 240 K$ (coût 0,25 ETP chargé)

-

Total : 4,43-4,73 M$ vs équivalent cloud de 4,7 M$

Le point d'équilibre se situe à un taux d'utilisation moyen de 67 % sur 18 mois, en tenant compte de l'amortissement, du financement et des coûts d'opportunité. Les DAF d'entreprise gagnent en prévisibilité budgétaire tout en évitant la dépendance aux fournisseurs cloud.

8. GB300 vs GB200 : comprendre Blackwell Ultra

[caption id="" align="alignnone" width="1920"] GB200 de la génération précédente illustré [/caption]

GB200 de la génération précédente illustré [/caption]

Le GB300 NVL72 (Blackwell Ultra) représente une évolution significative par rapport au GB200 NVL72 original. Les améliorations clés incluent 1,5x plus de performances de calcul IA, 288 Go de mémoire HBM3e par GPU (contre 192 Go), et une orientation renforcée vers l'inférence avec scaling au moment du test pour les applications de raisonnement IA.

La nouvelle architecture offre une amélioration de 10x des tokens par seconde par utilisateur et une amélioration de 5x du TPS par mégawatt par rapport à Hopper, produisant une augmentation potentielle combinée de 50x de la sortie des usines d'IA. Cela rend le GB300 NVL72 spécifiquement optimisé pour l'ère émergente du raisonnement IA, où des modèles comme DeepSeek R1 nécessitent substantiellement plus de calcul pendant l'inférence pour améliorer la précision.

Calendrier de disponibilité : Les systèmes GB300 NVL72 sont attendus chez les partenaires au second semestre 2025, comparé au GB200 NVL72 qui est disponible maintenant.

9. Pourquoi les entreprises Fortune 500 choisissent des partenaires de déploiement spécialisés

Les spécialistes du déploiement leaders ont installé plus de 100 000 GPU dans plus de 850 data centers, maintenant des accords de niveau de service (SLA) mondiaux de 4 heures grâce à des équipes d'ingénieurs terrain étendues. L'industrie a mis en service des milliers de kilomètres de fibre et plusieurs mégawatts d'infrastructure IA dédiée depuis 2022.

Métriques de déploiement récentes :

-

Délai moyen de préparation de site : 6,2 semaines (contre 11 semaines en moyenne dans l'industrie)

-

Taux de réussite du premier essai : 97,3 % pour les tests de mise sous tension

-

Problèmes post-déploiement : 0,08 % de taux de défaillance des composants dans les 90 premiers jours

Les OEM expédient du matériel ; les partenaires spécialisés transforment le matériel en infrastructure de production. Engager des équipes de déploiement expérimentées pendant les phases de planification peut réduire les délais de 45 % grâce à l'utilisation de harnais d'alimentation préfabriqués, de boucles de refroidissement pré-positionnées et de faisceaux de fibres terminés en usine.

Réflexion finale

Une armoire GB300 NVL72 représente un changement fondamental de "serveurs dans des racks" vers "data centers dans des armoires". La physique est implacable : 120 kW de densité de calcul exige de la précision dans chaque connexion d'alimentation, boucle de refroidissement et terminaison de fibre. Maîtrisez les fondamentaux de l'ingénierie dès le Jour 0, et Blackwell Ultra délivrera des performances de raisonnement IA transformatrices pour les années à venir.

Prêt à discuter des détails techniques que nous n'avons pas pu inclure dans 2 000 mots ? Nos ingénieurs de déploiement adorent ces conversations — planifiez une discussion technique approfondie à solutions@introl.com.

Références

Dell Technologies. 2024. "Dell AI Factory Transforms Data Centers with Advanced Cooling, High-Density Compute and AI Storage Innovations." Communiqué de presse, 15 octobre. Dell Technologies Newsroom

Introl. 2025. "GPU Infrastructure Deployments and Global Field Engineers." Consulté le 23 juin. introl.com

Lambda. 2025. "AI Cloud Pricing - NVIDIA B200 Clusters." Consulté le 23 juin. Lambda Labs Pricing

NVIDIA. 2025. "GB300 NVL72 Product Page." Consulté le 23 juin. NVIDIA Data Center

NVIDIA. 2025. "NVIDIA Blackwell Ultra AI Factory Platform Paves Way for Age of AI Reasoning." Communiqué de presse, 18 mars. NVIDIA News

Supermicro. 2025. "NVIDIA GB300 NVL72 SuperCluster Datasheet." Février. Supermicro Datasheet

The Register. 2024. Mann, Tobias. "One Rack, 120 kW of Compute: A Closer Look at NVIDIA's DGX GB200 NVL72 Beast." 21 mars. The Register