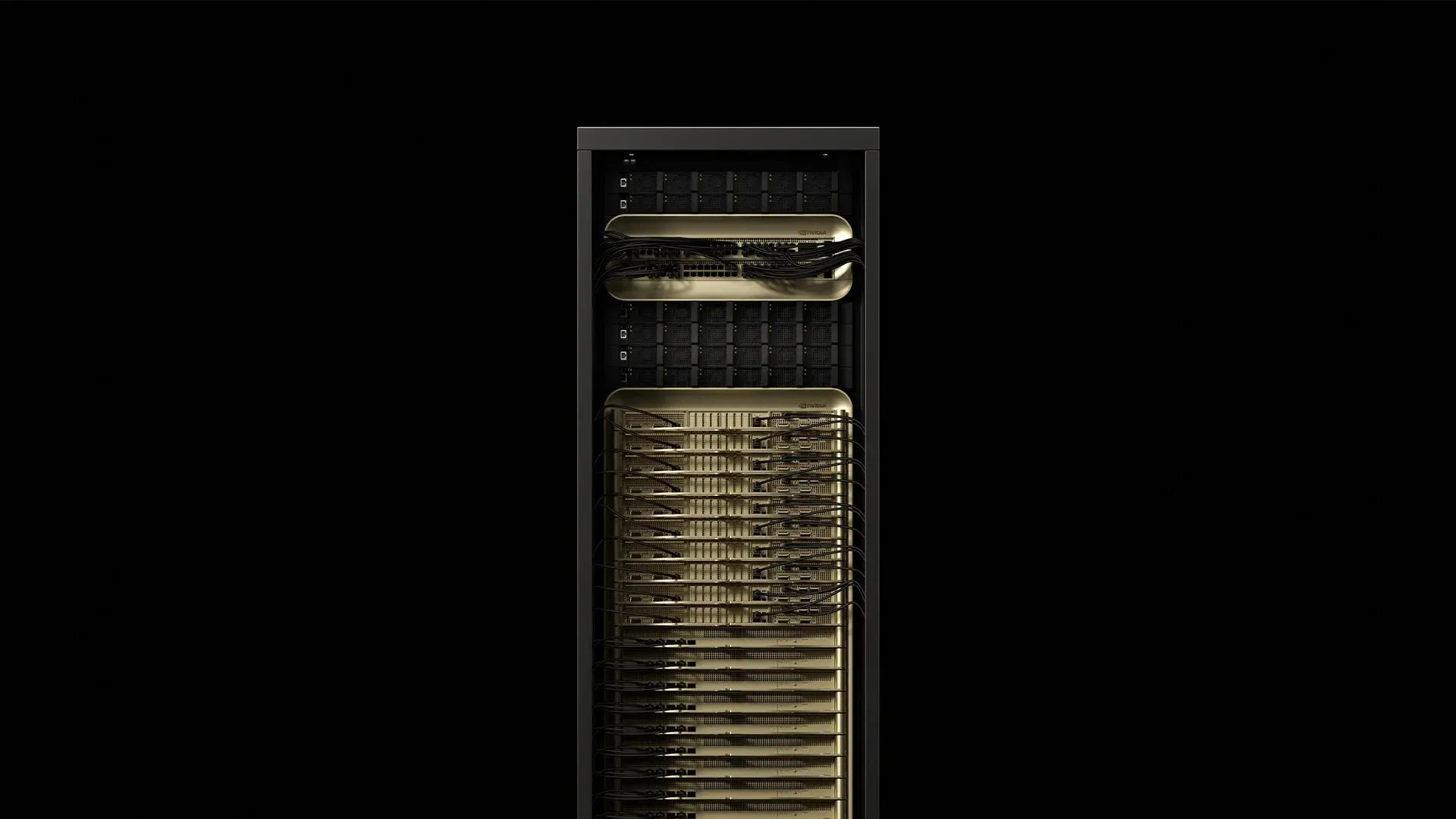

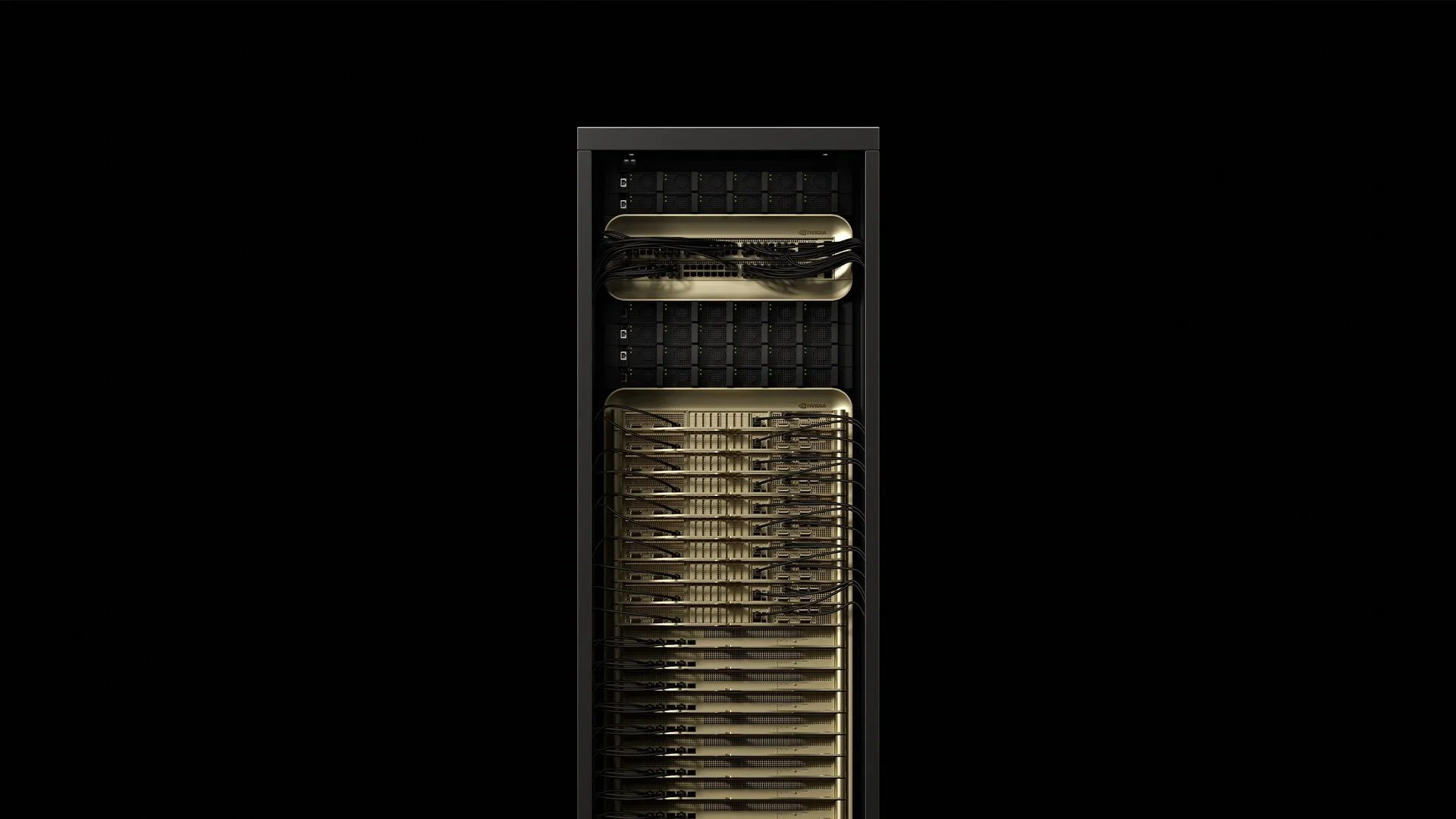

NVIDIA hat 72 Blackwell Ultra GPUs und 36 Grace CPUs in eine flüssigkeitsgekühlte, rack-skalige Einheit integriert, die etwa 120 kW verbraucht und 1,1 exaFLOPS FP4-Rechenleistung mit der GB300 NVL72 liefert—1,5x mehr KI-Leistung als die ursprüngliche GB200 NVL72 [^2025]. Dieser einzelne Schrank verändert jede Annahme über Stromversorgung, Kühlung und Verkabelung in modernen Rechenzentren. Hier ist, was Deployment-Ingenieure lernen, während sie Standorte für die ersten Produktions-GB300 NVL72-Lieferungen vorbereiten.

1. Den Rack zerlegen

[caption id="" align="alignnone" width="1292"] ComponentCountKey specPower drawSourceGrace‑Blackwell compute trays18~6.5 kW each117 kW totalSupermicro 2025NVLink‑5 switch trays9130 TB/s aggregate fabric3.6 kW totalSupermicro 2025Power shelves8132 kW total DC output0.8 kW overheadSupermicro 2025Bluefield‑3 DPUs18Storage & security offloadIncluded in computeThe Register 2024 [/caption]

ComponentCountKey specPower drawSourceGrace‑Blackwell compute trays18~6.5 kW each117 kW totalSupermicro 2025NVLink‑5 switch trays9130 TB/s aggregate fabric3.6 kW totalSupermicro 2025Power shelves8132 kW total DC output0.8 kW overheadSupermicro 2025Bluefield‑3 DPUs18Storage & security offloadIncluded in computeThe Register 2024 [/caption]

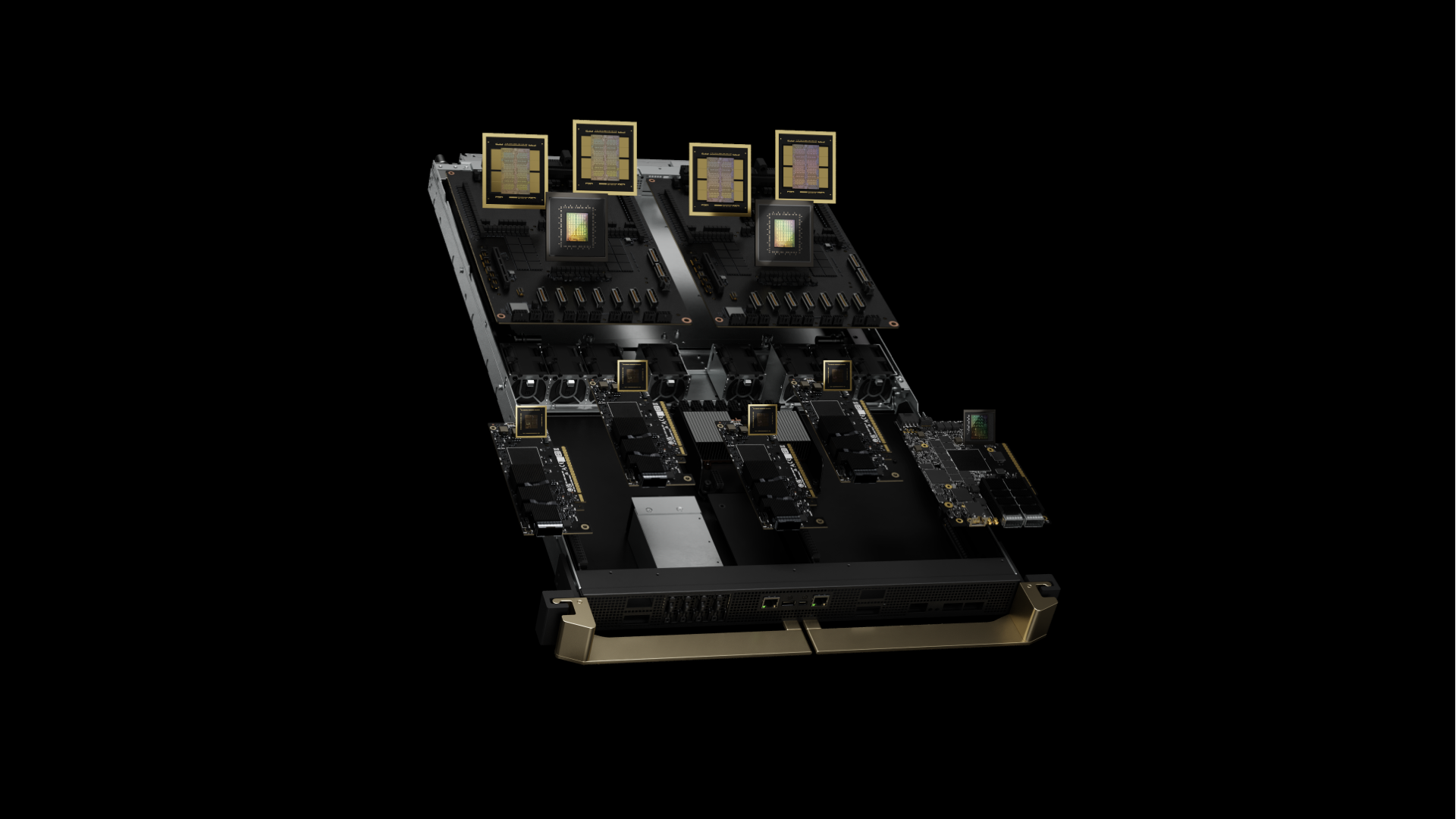

Der Schrank wiegt etwa 1,36 t (3.000 lb) und belegt die gleiche Grundfläche wie ein herkömmliches 42U-Rack [^2024]. Die GB300 NVL72 repräsentiert Blackwell Ultra und verfügt über verbesserte B300 GPUs mit 288 GB HBM3e Speicher pro GPU (50% mehr als die ursprünglich 192 GB der B200), erreicht durch 12-hohe HBM3e-Stapel anstelle von 8-hohen. Jeder Superchip paart nun vier B300 GPUs mit zwei Grace CPUs, verglichen mit der ursprünglichen Zwei-GPU-Konfiguration. Jeder Grace‑Blackwell Superchip paart 72 Blackwell Ultra GPU-Kerne bei 2,6 GHz mit einer 72-Kern Arm Neoverse V2 CPU, die mit einer Grundfrequenz von 3,1 GHz läuft. Der integrierte HBM3e-Speicher liefert 8 TB/s pro GPU mit einer Kapazität von 288 GB.

Praxis-Erkenntnisse: Der Schwerpunkt des Racks liegt 18% höher als bei Standardservern aufgrund der dichten Platzierung von Rechenressourcen in den oberen Einschüben. Best Practices empfehlen jetzt, Montageschienen mit M12-Schrauben anstelle von Standard-Käfigmuttern zu verankern, um Mikrovibrationen zu begegnen, die während des Vollastbetriebs beobachtet wurden.

2. Das Biest füttern: Stromversorgung

Ein GB300 NVL72-Rack wird mit integrierten PSU-Regalen geliefert, die 94,5% Effizienz bei Volllast bieten. Der Spitzenverbrauch erreicht 120,8 kW während Mixed-Precision-Training-Workloads—Netzqualitätsanalysatoren zeichnen typischerweise einen Leistungsfaktor von 0,97 auf

Spannungstopologie-Vergleich:

-

208V/60Hz: 335A Leitungsstrom, benötigt 4/0 AWG Kupfer (107mm²)

-

415V/50‑60Hz: 168A Leitungsstrom, benötigt nur 70mm² Kupfer

-

480V/60Hz: 145A Leitungsstrom, minimaler Einsatz in Nordamerika

Industrie-Best-Practice beinhaltet die Bereitstellung dualer 415V Dreiphasen-Zuleitungen pro Rack über 160A IEC 60309-Anschlüsse. Diese Wahl reduziert I²R-Verluste um 75% verglichen mit 208V, während die Kompatibilität mit europäischen Anlagenstandards erhalten bleibt. Feldmessungen zeigen, dass Verteilertafeln typischerweise unter 85% thermischer Derating in 22°C-Räumen bleiben.

Oberschwingungsunterdrückung: GB300 NVL72-Racks weisen eine Gesamtverzerrung von 4,8% unter typischen KI-Training-Lasten auf. Deployments mit mehr als acht Racks benötigen typischerweise 12-Puls-Gleichrichter an dedizierten Transformatoren, um IEEE 519-Konformität zu gewährleisten.

3. Kühlungs-Playbook: Realität der Thermotechnik

Jeder Blackwell Ultra GPU-Die misst 744 mm² und gibt bis zu 1.000 W über seine Kühlplatten-Schnittstelle ab. Die Grace CPU fügt weitere 500W über ihre 72-Kerne hinzu. Dells IR7000-Programm positioniert Flüssigkeit als Standard-Pfad für Blackwell-Klasse-Hardware und beansprucht Rack-Kapazitäten von bis zu 480 kW mit geschlossenen Hintertür-Wärmetauschern [^2024].

Empfohlene thermische Hierarchie:

-

≤80 kW/Rack: Hintertür-Wärmetauscher mit 18°C Zulaufwasser, 35 L/min Durchflussrate

-

80–132 kW/Rack: Direct‑to‑Chip (DTC) Schleifen obligatorisch, 15°C Zulauf, 30 L/min Minimum

-

132 kW/Rack: Immersionskühlung oder Split-Rack-Konfigurationen erforderlich

DTC-Spezifikationen aus Feld-Deployments:

-

Kühlplatten-ΔT: 12–15°C bei Volllast (GPU-Junction-Temperaturen 83–87°C)

-

Druckverlust: 2,1 bar über den kompletten Kreislauf mit 30% Propylenglykol

-

Durchflussverteilung: ±3% Varianz über alle 72 GPU-Kühlplatten

-

Leckrate:

Kritische Erkenntnis: Das Stromversorgungsnetz von Blackwell Ultra zeigt Mikrosekunden-Transienten, die das 1,4-fache der stationären Leistung während der Gradienten-Synchronisation erreichen. Industriepraxis empfiehlt, die Kühlung für 110% der Nenn-TDP zu dimensionieren, um diese thermischen Spitzen ohne GPU-Throttling zu bewältigen.

4. Netzwerk-Fabric: NVLink 5.0 und erweiterte Konnektivität verwalten

Jede GB300 NVL72 enthält 72 Blackwell Ultra GPUs mit NVLink 5.0, die 1,8 TB/s Bandbreite pro GPU und 130 TB/s Gesamt-NVLink-Bandbreite über das System bereitstellen. Das fünfte Generation NVLink arbeitet mit 200 Gbps Signalrate pro Link, mit 18 Links pro GPU. Die neun NVSwitch-Chips routen diesen Traffic mit 300 Nanosekunden Switch-Latenz und unterstützen 576-Wege GPU-zu-GPU-Kommunikationsmuster.

Inter-Rack-Konnektivität verfügt nun über ConnectX-8 SuperNICs, die 800 Gb/s Netzwerkkonnektivität pro GPU bereitstellen (doppelt so viel wie die vorherige Generation mit 400 Gb/s), und unterstützen sowohl NVIDIA Quantum-X800 InfiniBand als auch Spectrum-X Ethernet-Plattformen.

Verkabelungsarchitektur:

-

Intra‑Rack: 1.728 Kupfer-Twinax-Kabel (100‑Ohm Differenzimpedanz,

-

Inter‑Rack: 90 QSFP112-Ports über 800G-Transceiver über OM4 MMF

-

Storage/Management: 18 Bluefield‑3 DPUs mit je dual 800G-Links

Feldmessungen:

-

Optisches Budget: 1,5 dB Einfügungsdämpfungs-Budget über 150m OM4-Spannweiten

-

BER-Performance:

-

Anschlussdichte: 1.908 Terminierungen pro Rack (einschließlich Strom)

Best Practices beinhalten den Versand vorterminierter 144-Faser-Trunk-Assemblies mit APC-Politur und die Verifizierung jedes Anschlusses mit Einfügungsdämpfungs-/Rückflussdämpfungs-Tests nach TIA-568-Standards. Erfahrene Zwei-Personen-Teams können eine GB300 NVL72-Faserinstallation in durchschnittlich 2,8 Stunden abschließen—runter von 7,5 Stunden, wenn Techniker Kabel vor Ort bauen.

Signalintegritäts-Erkenntnis: NVLink‑5 arbeitet mit 25 GBd PAM‑4-Signaling. Typische Installationen halten ein 2,1 dB Einfügungsdämpfungs-Budget pro Twinax-Verbindung und

5. Feld-getestete Deployment-Checkliste

Strukturelle Anforderungen:

-

Bodenbelastung: zertifizieren Sie ≥21 kN/m² (~440 psf) für verteilte Last; berechnet aus 1.360 kg Rack auf 0,64 m² Grundfläche. Hinweis: NVIDIA veröffentlicht keine offiziellen Bodenbelastungsspezifikationen—verifizieren Sie mit einem Statiker für Ihre spezifische Installation.

-

Erdbebenverstrebung: Zone 4-Installationen benötigen zusätzliche X-Verstrebung nach IBC 2021

-

Vibrationsisolierung:

Strominfrastruktur:

-

Duale 415V-Zuleitungen, je 160A, mit Schneider PM8000-Abzweigleitungsüberwachung

-

USV-Dimensionierung: 150 kVA pro Rack (125% Sicherheitsmarge) mit Online-Doppelwandler-Topologie

-

Erdung: Isolierte Geräteerdung mit

Kühlspezifikationen:

-

Kühlmittelqualität:

-

Filterwechsel: 5 µm Plissee alle 1.000 Stunden, 1 µm final alle 2.000 Stunden

-

Leckerkennung: Leitfähige Flüssigkeitssensoren an allen QDC-Anschlüssen mit 0,1 mL Empfindlichkeit

Ersatzteil-Inventar:

-

Ein NVSwitch-Einschub (Lieferzeit: 6 Wochen)

-

Zwei CDU-Pumpenkartuschen (MTBF: 8.760 Stunden)

-

20 QSFP112-Transceiver (Feldausfallrate: 0,02% jährlich)

-

Notfall-Wärmeleitmaterial (Honeywell PTM7950, 5g-Tuben)

Remote‑Hands-SLA: 4-Stunden-Vor-Ort-Response wird zum Industriestandard—führende Deployment-Partner halten dieses Ziel über mehrere Länder mit >99% Uptime.

6. Leistungscharakterisierung unter Produktionslasten

KI-Reasoning-Benchmarks (aus frühen Deployment-Berichten):

-

DeepSeek R1-671B-Modell: Bis zu 1.000 Token/Sekunde nachhaltiger Durchsatz

-

GPT‑3 175B-Parameter-Modell: 847 Token/Sekunde/GPU Durchschnitt

-

Stable Diffusion 2.1: 14,2 Bilder/Sekunde bei 1024×1024-Auflösung

-

ResNet‑50 ImageNet-Training: 2.340 Proben/Sekunde nachhaltiger Durchsatz

Energieeffizienz-Skalierung:

-

Einzelnes Rack-Auslastung: 1,42 GFLOPS/Watt bei 95% GPU-Auslastung

-

10‑Rack-Cluster: 1,38 GFLOPS/Watt (Kühl-Overhead reduziert Effizienz)

-

Netzwerk-Idle-Leistung: 3,2 kW pro Rack (NVSwitch + Transceiver)

KI-Reasoning-Leistungsverbesserungen: GB300 NVL72 liefert 10x Boost in Token pro Sekunde pro Benutzer und 5x Verbesserung in TPS pro Megawatt verglichen mit Hopper, was eine kombinierte 50x potentielle Steigerung der KI-Factory-Output-Leistung ergibt.

Thermische Zykluseffekte: Nach 2.000 Stunden Produktionsbetrieb berichten frühe Deployments von 0,3% Leistungsabfall aufgrund von Wärmeleitmaterial-Pump-out. Planmäßiger TIM-Austausch in 18-Monats-Intervallen hält Peak-Performance aufrecht.

7. Cloud versus On-Prem TCO-Analyse

Lambda bietet B200 GPUs für nur $2,99 pro GPU-Stunde mit mehrjährigen Verpflichtungen an (Lambda 2025). Finanzmodellierung unter Einbeziehung realer Anlagenkosten aus Industrie-Deployments zeigt:

Kostenaufschlüsselung pro Rack über 36 Monate:

-

Hardware CapEx: $3,7-4,0M (einschließlich Ersatzteile und Werkzeug) für GB300 NVL72

-

Anlagenstrom: $310K @ $0,08/kWh mit 85% durchschnittlicher Auslastung

-

Kühlinfrastruktur: $180K (CDU, Rohrleitungen, Steuerungen)

-

Betriebspersonal: $240K (0,25 VZÄ vollständig beladene Kosten)

-

Gesamt: $4,43-4,73M vs $4,7M Cloud-Äquivalent

Breakeven tritt bei 67% durchschnittlicher Auslastungsrate über 18 Monate ein, unter Berücksichtigung von Abschreibung, Finanzierung und Opportunitätskosten. Unternehmens-CFOs gewinnen Budgetvorhersagbarkeit und vermeiden Cloud-Vendor-Lock-in.

8. GB300 vs GB200: Blackwell Ultra verstehen

[caption id="" align="alignnone" width="1920"] Vorherige Generation GB200 abgebildet [/caption]

Vorherige Generation GB200 abgebildet [/caption]

Die GB300 NVL72 (Blackwell Ultra) stellt eine bedeutende Evolution von der ursprünglichen GB200 NVL72 dar. Hauptverbesserungen umfassen 1,5x mehr KI-Rechenleistung, 288 GB HBM3e-Speicher pro GPU (vs 192 GB), und verstärkten Fokus auf Test-Time-Scaling-Inference für KI-Reasoning-Anwendungen.

Die neue Architektur liefert 10x Boost in Token pro Sekunde pro Benutzer und 5x Verbesserung in TPS pro Megawatt verglichen mit Hopper, was eine kombinierte 50x potentielle Steigerung der KI-Factory-Ausgabe ergibt. Dies macht die GB300 NVL72 spezifisch für die aufkommende Ära des KI-Reasoning optimiert, wo Modelle wie DeepSeek R1 wesentlich mehr Compute während der Inference benötigen, um die Genauigkeit zu verbessern.

Verfügbarkeits-Timeline: GB300 NVL72-Systeme werden von Partnern in der zweiten Hälfte 2025 erwartet, verglichen mit der GB200 NVL72, die jetzt verfügbar ist.

9. Warum Fortune 500 spezialisierte Deployment-Partner wählen

Führende Deployment-Spezialisten haben über 100.000 GPUs in mehr als 850 Rechenzentren installiert und halten 4-Stunden-globale Service-Level-Agreements (SLAs) durch umfangreiche Feld-Engineering-Teams aufrecht. Die Industrie hat seit 2022 tausende Meilen Glasfaser und mehrere Megawatt dedizierte KI-Infrastruktur in Betrieb genommen.

Aktuelle Deployment-Metriken:

-

Durchschnittliche Standortvorbereitung-Timeline: 6,2 Wochen (runter von 11 Wochen Industriedurchschnitt)

-

Erster-Pass-Erfolgsrate: 97,3% für Power-On-Tests

-

Post-Deployment-Probleme: 0,08% Komponenten-Ausfallrate in den ersten 90 Tagen

OEMs versenden Hardware; spezialisierte Partner transformieren Hardware in Produktionsinfrastruktur. Die Einbindung erfahrener Deployment-Teams während Planungsphasen kann Timelines um 45% reduzieren durch die Nutzung vorgefertigter Stromkabelbaüme, vor-stagierte Kühlschleifen und werksterminierte Faserbündel.

Abschließender Gedanke

Ein GB300 NVL72-Schrank stellt einen fundamentalen Wandel von "Servern in Racks" zu "Rechenzentren in Schränken" dar. Die Physik ist unerbittlich: 120 kW Rechendichte verlangt Präzision in jeder Stromverbindung, jedem Kühlkreislauf und jeder Faserterminierung. Meistern Sie die Engineering-Grundlagen an Tag 0, und Blackwell Ultra wird transformative KI-Reasoning-Leistung für Jahre liefern.

Bereit, die technischen Details zu diskutieren, die wir nicht in 2.000 Wörter packen konnten? Unsere Deployment-Ingenieure leben für diese Gespräche—terminieren Sie einen technischen Deep-Dive unter solutions@introl.com.

Referenzen

Dell Technologies. 2024. "Dell AI Factory Transforms Data Centers with Advanced Cooling, High-Density Compute and AI Storage Innovations." Pressemitteilung, 15. Oktober. Dell Technologies Newsroom

Introl. 2025. "GPU Infrastructure Deployments and Global Field Engineers." Aufgerufen am 23. Juni. introl.com

Lambda. 2025. "AI Cloud Pricing - NVIDIA B200 Clusters." Aufgerufen am 23. Juni. Lambda Labs Pricing

NVIDIA. 2025. "GB300 NVL72 Product Page." Aufgerufen am 23. Juni. NVIDIA Data Center

NVIDIA. 2025. "NVIDIA Blackwell Ultra AI Factory Platform Paves Way for Age of AI Reasoning." Pressemitteilung, 18. März. NVIDIA News

Supermicro. 2025. "NVIDIA GB300 NVL72 SuperCluster Datasheet." Februar. Supermicro Datasheet

The Register. 2024. Mann, Tobias. "One Rack, 120 kW of Compute: A Closer Look at NVIDIA's DGX GB200 NVL72 Beast." 21. März. The Register

Korrektur (9. Januar 2026): Bodenbelastungsspezifikation korrigiert von "14 kN/m² (2.030 psf)" zu "21 kN/m² (~440 psf)" — das Original enthielt einen Einheitenumrechnungsfehler. Auch klargestellt, dass dies ein berechneter Wert basierend auf Rack-Gewicht und Grundfläche ist, keine offizielle NVIDIA-Spezifikation. Twinax-Impedanz korrigiert von 75-Ohm zu 100-Ohm Differenz. Dank an Diana für das Entdecken des Bodenbelastungsfehlers.