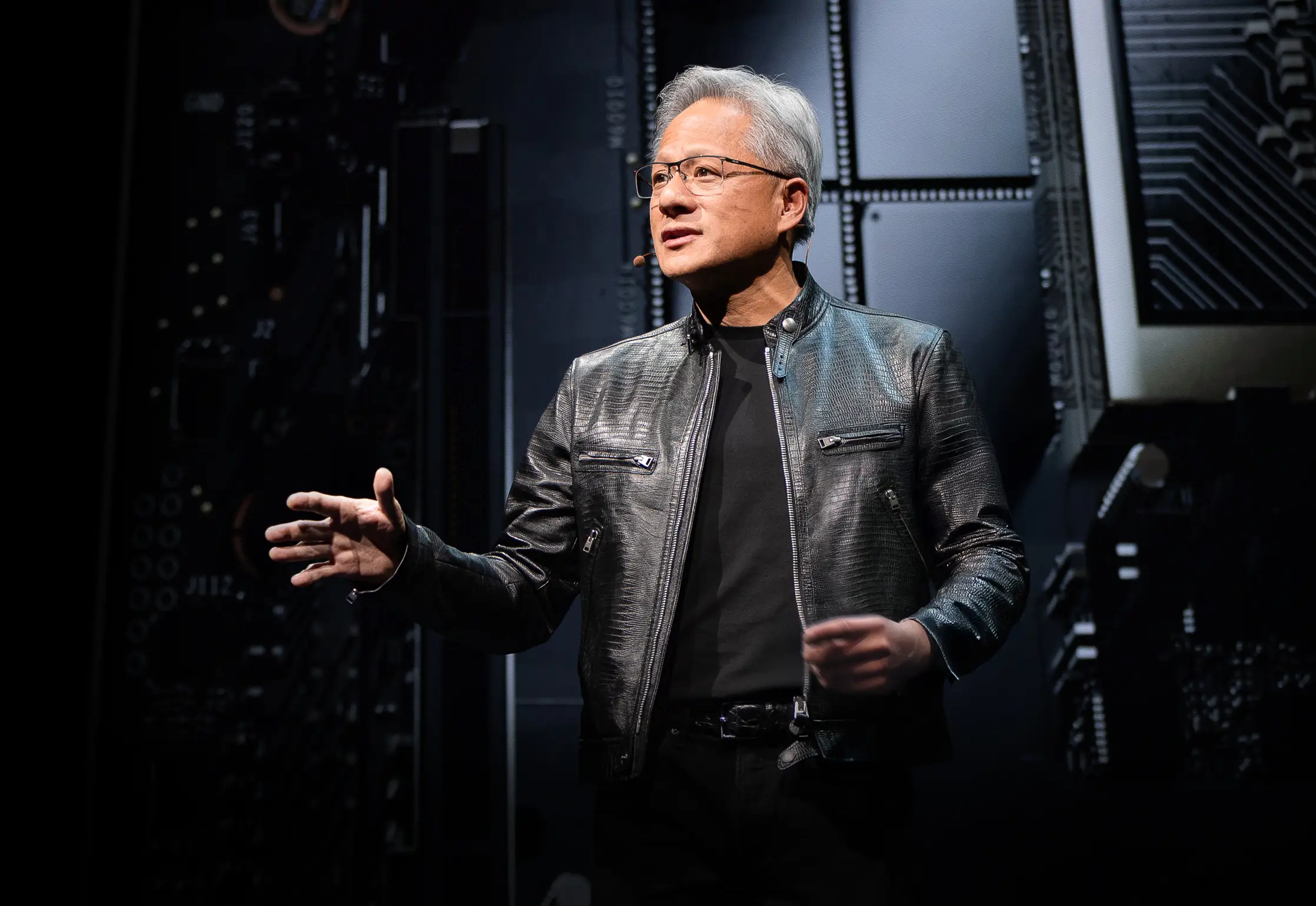

NVIDIA CEOのJensen Huangが、トレードマークのレザージャケットを着てComputex 2025のステージに登壇し、新しいハードウェアと完全に再構想されたコンピューティングパラダイムを発表しました。この半導体大手は、AI インフラ企業へと決定的に変貌を遂げ、Huang氏が「知性のインフラ」と呼ぶもの—電気とインターネットに続く第三の主要インフラ革命—の基盤を構築しています。

この基調講演は単なる製品発表ではありませんでした。Jensen氏がコンピューティング業界の展望を再構築するNVIDIAの青写真を提示したのです。彼が明かした技術的飛躍、戦略的転換、そして市場戦略は、今回のComputexを今後何年も参照され続ける記念すべきイベントにすることでしょう。完全版はComputex 2025 Nvidia基調講演をご覧ください。

NVIDIAの戦略的進化:グラフィックスカードからインフラプロバイダーへ

NVIDIAの変貌の物語は驚異的です。1993年、Jensen氏は「3億ドルのチップ市場の機会」を見出しました—当時としては相当な市場でした。それから現在まで早送りすると、彼は1兆ドル規模のAIインフラの巨大企業を指揮しています。このような爆発的成長は偶然には起こりません—NVIDIAはその過程で何度も根本的に自らを再発明してきました。

基調講演でJensen氏は、今日のNVIDIAを可能にした転換点を強調しました:

-

2006年:CUDAが登場し、並列コンピューティングを根本から変革しました。突然、GPUを汎用コンピューティングに使用することを考えたことがなかった開発者たちが、従来のCPUでは不可能だったアプリケーションを構築するようになりました。

-

2016年:DGX1がNVIDIA初の妥協なきAI専用システムとして登場しました。今振り返ると不気味なほど予見的だったことですが、Jensen氏は最初のユニットをOpenAIに寄贈し、現在のAI革命につながる計算基盤を実質的に提供しました。

-

2019年:Mellanoxの買収により、NVIDIAはデータセンターを統合されたコンピューティングユニットとして再構想できるようになりました

この変革は、NVIDIAの現在の「不可欠なインフラ企業」としての地位に結実しており、Huang氏は前例のない5年間のパブリックロードマップを強調し、AI展開のための世界的なインフラ計画を可能にしています。

パフォーマンス指標の再定義:トークンエコノミー

NVIDIAは計算出力の測定方法に根本的な変革をもたらしました。FLOPsや秒間演算数といった従来の指標ではなく、Huang氏はAIデータセンターを「トークン」—計算インテリジェンスの単位—を生産する工場として位置づけました:

「企業は先四半期に何トークン生産したか、先月に何トークン生産したかを語り始めています。間もなく、すべての工場がそうするように、時間当たりに何トークン生産するかを議論するようになるでしょう。」

この再フレーミングは、計算投資と事業成果を直接結びつけ、AIインフラを従来の産業フレームワークと整合させます。このモデルは、計算効率が事業能力に直接転換される新しい経済パラダイムの中心にNVIDIAを位置づけています。

Blackwellアーキテクチャのアップグレード:GB300の仕様とパフォーマンス指標

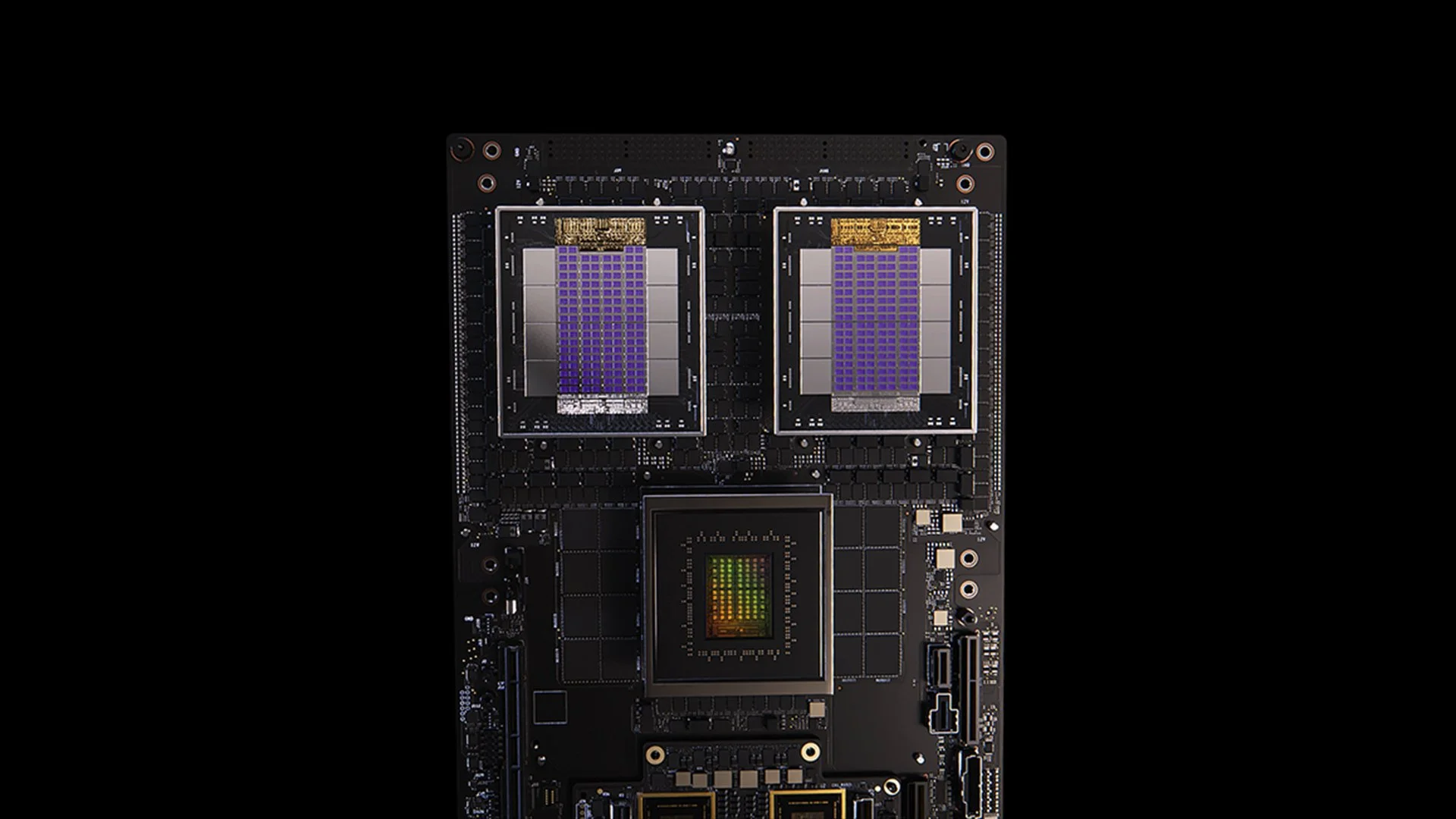

[caption id="" align="alignnone" width="1280"] GB200システム [/caption]

GB200システム [/caption]

BlackwellアーキテクチャのGB300アップデートは、NVIDIAの絶え間ないパフォーマンス改善サイクルの典型例です。2025年第3四半期に予定されているGB300は以下を実現します:

- GB200と比較して1.5倍の推論性能向上

- 1.5倍のHBMメモリ容量増加

- 2倍のネットワーク帯域幅改善

- 完全液冷設計

- 既存のシャーシおよびシステムとの完全な後方互換性

各GB300ノードは約40ペタフロップスを提供し、18,000個のVolta GPUを要求していた全Sierraスーパーコンピューター(2018年頃)を実質的に置き換えます。この6年間での4,000倍のパフォーマンス向上は、従来のムーアの法則のスケーリングを大幅に上回り、アーキテクチャ、ソフトウェア、相互接続の革新を通じたNVIDIAの多面的なパフォーマンス加速アプローチを実証しています。

MVLink:相互接続技術の再定義

MVLinkは、NVLinkの導入以来最も重要なGPU相互接続技術の進歩を表しています。このシステムは、ラック全体にわたるコンピュートリソースの完全な分散を可能にし、72個のGPU(144個のGPUダイ)を単一の巨大な計算ユニットに変換します。

技術仕様は驚異的です:

- 個別MVLinkスイッチ:7.2 TB/s帯域幅

- MVLinkスパイン:130 TB/s all-to-all帯域幅

- 物理実装:5,000本の精密に長さが調整された同軸ケーブル(総延長約2マイル)

- 電力密度:ラック当たり120キロワット(液冷が必須)

参考として、Huang氏は、インターネット全体のピークトラフィックが約900テラビット/秒(112.5 TB/s)であると述べており、単一のMVLinkスパインがピーク時の世界のインターネット全体よりも多くのトラフィックを処理できることになります。

MVLink Fusion:オープンなAIインフラエコシステムの創造

MVLink Fusionは、NVIDIAがここ数年で行った最も革新的なエコシステム戦略かもしれません。パートナーにNVIDIAハードウェアへのオールインを強制するのではなく、企業がNVIDIAユニバースに接続したセミカスタムAIシステムを構築できるようアーキテクチャを開放しています。

このアプローチは驚くほど柔軟です:

-

カスタムASIC統合:専用アクセラレーターをお持ちですか?問題ありません。パートナーはMVLinkチップレットを使用して、カスタムシリコンをNVIDIAエコシステムに接続できます。これはNVIDIAが「どんな専用ハードウェアでも構築してください—ただし、我々のものと通信できるようにしてください」と言っているようなものです。

-

カスタムCPU統合:CPUベンダーも除外されていません。彼らはMVLinkのチップ間インターフェースを直接実装でき、自社のプロセッサーとBlackwell GPU(または次期Rubenアーキテクチャ)の間に直接の高速道路を作成できます。MVLinkは特定のCPUアーキテクチャに投資している企業にとって重要です。

パートナー発表は半導体業界全体に及んでいます:

- シリコン実装パートナー:LCHIP、Astera Labs、Marll、MediaTek

- CPUベンダー:Fujitsu、Qualcomm

- EDAプロバイダー:Cadence、Synopsis

このアプローチは、顧客が展開する特定のハードウェアミックスに関係なく、NVIDIAが価値を獲得できるよう戦略的に位置づけており、Huang氏の率直な発言を反映しています:「皆さんがNVIDIAからすべてを購入してくれること以上に私を喜ばせるものはありません。そのことを皆さんに知っていただきたい。しかし、皆さんがNVIDIAから何かを購入してくれることも大いに私を喜ばせます。」

エンタープライズAI展開:RTX Pro EnterpriseとOmniverseサーバー

RTX Pro EnterpriseとOmniverseサーバーは、従来のIT環境にAI機能を統合するために特別に設計された、NVIDIAの最も重要なエンタープライズ向けコンピュート製品です:

- 完全なx86互換アーキテクチャ

- 従来のハイパーバイザー(VMware、Red Hat、Nanix)のサポート

- 馴染みのあるワークロード オーケストレーションのためのKubernetes統合

- Blackwell RTX Pro 6000s GPU(サーバー当たり8個)

- 800 Gb/s帯域幅を提供するCX8ネットワーキングチップ

- Hopper H100と比較して1.7倍のパフォーマンス向上

- Deepseek R1などの最適化されたモデルで4倍のパフォーマンス

このシステムは、スループット(トークン/秒)と応答性(ユーザー当たりトークン/秒)の二軸フレームワークで測定されるAI推論の新しいパフォーマンス エンベロープを確立します。これらはHuang氏が「推論時間スケーリング」または「思考AI」の時代と呼ぶものにとって重要な指標です。

AIデータプラットフォーム:非構造化データ向けストレージの再構想

NVIDIAのAIデータプラットフォームは、エンタープライズストレージに対する根本的に異なるアプローチを導入します:

「人間はSQLのような構造化データベースにクエリを実行します...しかしAIは非構造化データにクエリを実行したがります。彼らは意味論を求めます。意味を求めます。そのため、我々は新しいタイプのストレージプラットフォームを作成する必要があります。」

主要コンポーネントには以下が含まれます:

- NVIDIA AIQ(またはIQ):意味論的クエリレイヤー

- 従来のCPU中心アーキテクチャに代わるGPUアクセラレーテッド ストレージノード

- 透明な学習データ来歴を持つポストトレーニング済みAIモデル

- 既存ソリューションと比較して15倍高速なクエリと50%改善された結果

このアーキテクチャを実装するストレージ業界パートナーには、Dell、Hitachi、IBM、NetApp、Vastが含まれ、包括的なエンタープライズAIデータ管理エコシステムを構築しています。

AI運用とロボティクス:インテリジェント企業向けソフトウェアフレームワーク

基調講演では2つの重要なソフトウェアフレームワークが紹介されました:

-

AI運用(AIOps):データキュレーション、モデルファインチューニング、評価、ガードレール、セキュリティを含む、エンタープライズ環境でAIエージェントを管理するための包括的なスタック。パートナーにはCrowdstrike、Data IQ、Data Robots、Elastic、Newonix、Red Hat、Trend Microが含まれます。

-

Isaac Grootプラットフォーム N1.5:以下を含むオープンソースのロボティクス開発エコシステム:

Newton物理エンジン(Google DeepMindおよびDisney Researchとの共同開発) - Jetson Thorロボティクスプロセッサー - NVIDIA Isaac オペレーティングシステム - 合成軌道データ生成のためのGroot Dreams設計図

ロボティクスイニシアチブは重要な課題に対処しています:「ロボティクスを実現するには、AIが必要です。しかしAIを教えるには、AIが必要です。」この再帰的最適化パターンは、生成AIを活用して限られた人間のデモンストレーションデータを包括的なロボティクス学習セットに拡張します。

AI製造革命における台湾の戦略的地位

基調講演の大部分は、AI技術の生産と実装の両方における台湾の極めて重要な役割を強調しました:

-

台湾の製造企業(TSMC、Foxconn、Wistron、Pegatron、Delta Electronics、Quanta、Wiiwin、Gigabyte)は、デジタルツイン実装にNVIDIA Omniverseを展開しています。

-

TSMCはCUDA上のAIパワードツールを使用してファブレイアウトと配管システムを最適化しています

-

製造パートナーは仮想計画と予測保全、そしてロボティクスシステムを訓練する「ロボットジム」としてデジタルツインを使用しています。

-

Foxconn、TSMC、台湾政府、およびNVIDIAは台湾初の大規模AIスーパーコンピューターを構築しています。

Huang氏は台北に新しい本社施設「NVIDIA Constellation」の建設計画を発表することで、この地域へのNVIDIAのコミットメントをさらに強化しました。

技術分析:エンタープライズAI戦略にとっての意味

これらの発表は総合的にエンタープライズコンピューティングの包括的な再構想を表しており、いくつかの戦略的含意があります:

-

計算スケール要件:「推論AI」およびエージェンティックシステムの推論時性能要求は、初期の大規模言語モデル展開よりもはるかに高い計算要件を推進し、大規模なスケールアップとスケールアウト機能のためのアーキテクチャ計画を必要とします。

-

エンタープライズAIの分散化:MVLink Fusionエコシステムは、異種AIシステム構築における前例のない柔軟性を可能にし、相互接続技術を通じてNVIDIAのエコシステム内での地位を維持しながら、専用AIアクセラレーターの採用を潜在的に加速します。

-

データセンターからAIファクトリーへのシフト:インフラ投資の価値の測定方法を完全に再考する必要があります。生の計算力やストレージ容量が全体像を物語る時代は終わりました。今重要なのはトークン生産—システムが秒当たり、ワット当たり、ドル当たりにどれだけのAI出力単位を生成できるかです。Jensen氏が企業が間もなくトークン生産を製造指標として報告するようになると言ったのは冗談ではありません。AIファクトリーへのシフトは、AI インフラの展開と投資正当化の経済学を根本的に書き換えるでしょう。

-

デジタルツイン統合:すべての主要台湾メーカーがOmniverseデジタルツインを構築しているという事実は、すべてを物語っています—これはもはや単なるクールな技術デモではありません。デジタルツインは最適化に真剣に取り組む企業にとって不可欠なインフラになりました。特に興味深いのは、これがフィードバックループを作り出すことです:企業は物理プロセスを最適化するためにデジタルツインを構築し、次に同じ環境を使用してAIとロボティクスを訓練し、物理世界をさらに改善します。これは継続的に加速する継続的改善サイクルです。

-

ロボット労働力計画:エージェンティックAIと物理ロボティクスの収束は、組織が統合されたデジタルおよび物理自動化戦略を開発すべきことを示唆し、労働力計画と施設設計に重要な含意をもたらします。

-

ソフトウェア定義インフラ:ハードウェア発表にもかかわらず、ライブラリとソフトウェアフレームワークに対するNVIDIAの継続的な強調は、AIにおける競争優位性が生のハードウェア機能と同程度にソフトウェア最適化からもたらされることを強化しています。

AIファクトリー移行のナビゲート

従来のデータセンターをAIファクトリーに変革するには、ハードウェア展開、ソフトウェア最適化、アーキテクチャ設計を橋渡しする専門知識が必要です。Introlでは、AIファーストコンピューティングへの飛躍を目指す企業に向けて、これらの先進的なGPUインフラソリューションを実装してきました。我々のチームのNVIDIAエコシステムに関する豊富な経験—複雑なMVLink展開からOmniverseデジタルツイン実装まで—は、組織が最先端インフラに通常伴う急峻な学習曲線なしにこのパラダイムシフトをナビゲートするのを支援します。推論AI機能のスケールアップでも、初回のAIファクトリーフロア構築でも、専門家との提携により、この急速に進化する環境での価値実現までの時間を劇的に加速できます。実現の準備はできていますか?今すぐ相談の予約を取りましょう。

結論:コンピューティングの第三の時代が到来

Computexは単にNVIDIAがより高速なチップを披露したのではありません。Jensen氏が示したものは、我々が慣れ切った通常の「昨年より20%向上」という発表を超越しました。彼はコンピューターの根本的な目的を再フレーミングしています。我々は数十年にわたって、数値を処理しデータを移動するマシンを構築してきました。今、NVIDIAは知能を製造することを主要な出力とするシステムを構築しています。これはファイリングキャビネットと脳を比較するようなものです。どちらも情報を蓄積しますが、一方はただそこに座っているだけで、もう一方は新しいアイデアを創造します。このシフトは意味論のように聞こえるかもしれませんが、コンピューティングシステムの構築、展開、測定方法のすべてを変える意味があることに気づくまでは。

「我々が共に過ごしたすべての時間で初めて、次世代のITを創造しているだけでなく、PCからインターネット、クラウド、モバイルクラウドまで、我々はそれを何度も行ってきました。しかし今回は、次世代のITを創造するだけでなく、全く新しい産業を創造しています。」

この移行は、パーソナルコンピューティング革命とインターネット/クラウド時代に続く第三の主要コンピューティングパラダイムシフトを表しています。これらのAIインフラ機能を統合する組織は、業界を超えて克服困難な競争優位性を確立する可能性があります。

計算インテリジェンスの工場は今日建設中です。もはや問題は、AIがビジネスを変革するかどうかではありません—計算インテリジェンスがビジネス運営にとって電気と同じくらい基本的になる世界で競争力を維持するためのインフラを、あなたの組織が構築しているかどうかです。

参考文献と追加リソース

-

NVIDIA公式Blackwellアーキテクチャ概要:https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

-

NVIDIA MVLink技術文書:https://developer.nvidia.com/mvlink

-

NVIDIA Omniverseプラットフォーム:https://www.nvidia.com/en-us/omniverse/

-

Isaacロボティクスプラットフォーム:https://developer.nvidia.com/isaac-ros

-

NVIDIA AI Enterprise:https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

-

NVIDIA Computex 2025公式プレス資料:https://nvidianews.nvidia.com/news/computex-2025

-

NVIDIA CUDA-Xライブラリ概要:https://developer.nvidia.com/gpu-accelerated-libraries

-

NVIDIA DGXシステム:https://www.nvidia.com/en-us/data-center/dgx-systems/