NVIDIA CEO Jensen Huang betrad het podium van Computex 2025 in zijn kenmerkende leren jack en onthulde nieuwe hardware en een volledig heruitgevonden computerparadigma. De halfgeleidergigant heeft zich definitief getransformeerd tot een AI-infrastructuurbedrijf en bouwt de fundamenten voor wat Huang "de infrastructuur van intelligentie" noemt—de derde grote infrastructuurrevolutie na elektriciteit en het internet.

Deze keynote was niet zomaar weer een productaankondiging—het was Jensen die NVIDIA's blauwdruk voor het hervormen van het computerlandschap uiteenzette. De technische sprongen, strategische koerswijzigingen en marktspellen die hij onthulde, maken dit waarschijnlijk de Computex waar we nog jaren naar zullen verwijzen. Bekijk de volledige Computex 2025 Nvidia keynote.

NVIDIA's Strategische Evolutie: Van Grafische Kaarten naar Infrastructuurprovider

NVIDIA's transformatieverhaal is adembenemend. In 1993 zag Jensen een "$300 miljoen chip-kans"—een aanzienlijke markt. Snel vooruit naar vandaag, en hij leidt een triljoenen dollar AI-infrastructuur mastodont. Dat soort explosieve groei gebeurt niet zomaar—NVIDIA heeft zichzelf meerdere keren fundamenteel opnieuw uitgevonden onderweg.

Tijdens zijn keynote belichtte Jensen de keerpunten die het huidige NVIDIA mogelijk maakten:

-

2006: CUDA landde en gooide parallel computing compleet overhoop. Plotseling bouwden ontwikkelaars die nooit hadden overwogen GPU's te gebruiken voor algemene computing applicaties die onmogelijk waren geweest op traditionele CPU's.

-

2016: De DGX1 kwam naar voren als NVIDIA's eerste compromisloze, AI-gerichte systeem. In wat nu lijkt op een bijna griezelig stukje voortekenen, doneerde Jensen de eerste unit aan OpenAI, waarmee hij ze effectief de computationele basis gaf die uiteindelijk zou leiden tot onze huidige AI-revolutie.

-

2019: De overname van Mellanox, waardoor NVIDIA datacenters kon herconceptualiseren als uniforme computingunits

Deze transformatie culmineert in NVIDIA's huidige positie als "een essentieel infrastructuurbedrijf"—een status die Huang benadrukte door de ongekende vijfjarige publieke roadmaps te benadrukken, die wereldwijde infrastructuurplanning voor AI-implementatie mogelijk maken.

Prestatiemetrieken Herdefiniëren: De Token-Economie

NVIDIA heeft een fundamentele verschuiving geïntroduceerd in hoe we computationele output meten. In plaats van traditionele metrieken zoals FLOPs of operaties per seconde, positioneerde Huang AI-datacenters als fabrieken die "tokens" produceren—eenheden van computationele intelligentie:

"Bedrijven beginnen te praten over hoeveel tokens ze vorig kwartaal hebben geproduceerd en hoeveel tokens ze vorige maand hebben geproduceerd. Zeer binnenkort zullen we bespreken hoeveel tokens we elk uur produceren, net zoals elke fabriek doet."

Deze herframing verbindt computationele investering en bedrijfsoutput direct, en stemt AI-infrastructuur af op traditionele industriële frameworks. Het model positioneert NVIDIA in het epicentrum van een nieuw economisch paradigma waarbij computationele efficiëntie direct vertaalt naar bedrijfscapaciteit.

Blackwell Architectuur Upgrades: GB300 Specificaties en Prestatiemetrieken

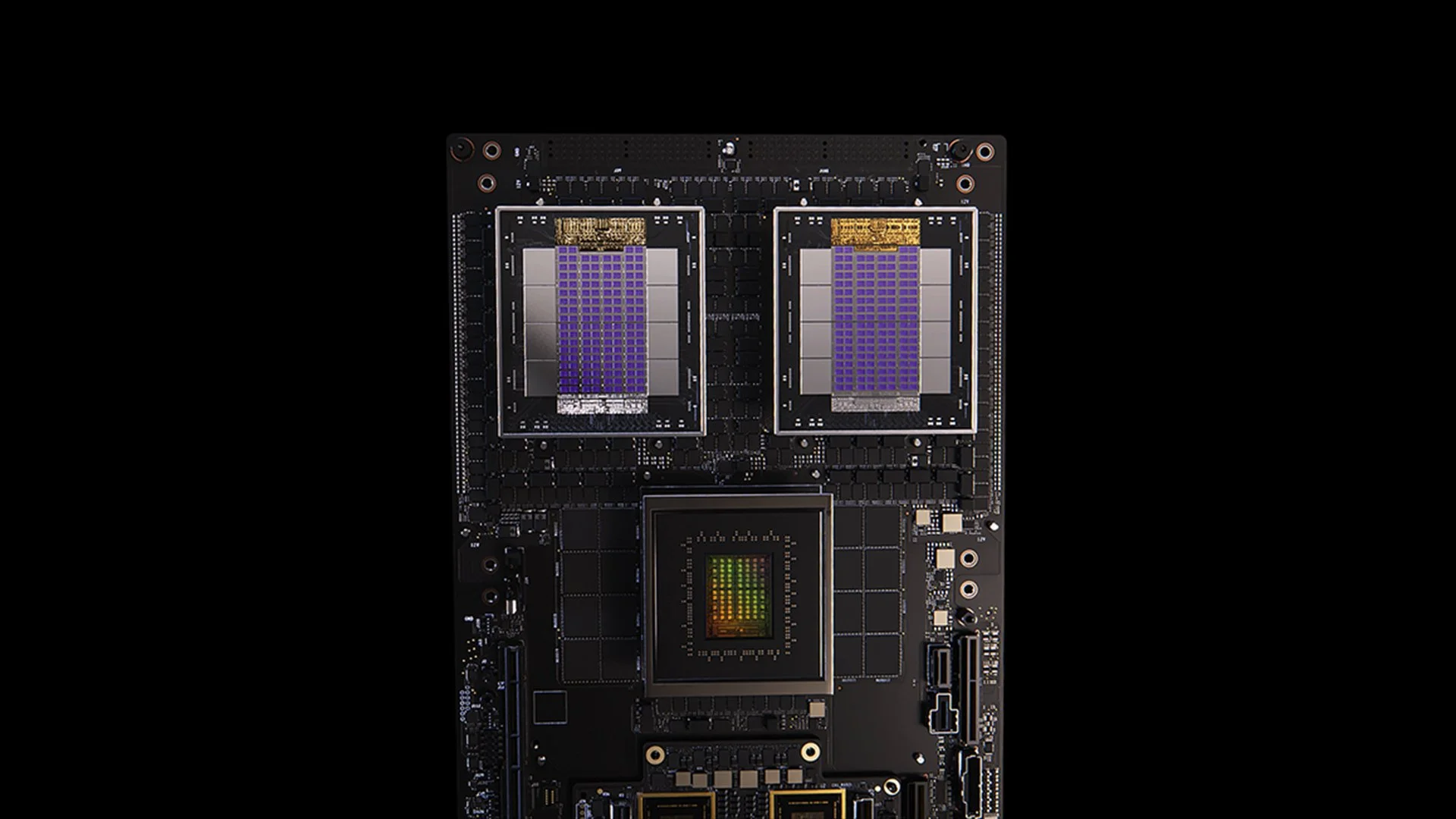

[caption id="" align="alignnone" width="1280"] GB200 systeem [/caption]

GB200 systeem [/caption]

De GB300-update van de Blackwell-architectuur toont NVIDIA's meedogenloze prestatieverbetering cyclus. Gepland voor Q3 2025, levert de GB300:

- 1,5x inference prestatieverbetering ten opzichte van GB200

- 1,5x HBM geheugencapaciteit verhoging

- 2x netwerk bandbreedte verbetering

- Volledig vloeistofgekoeld ontwerp

- Achterwaarts compatibel met bestaande chassis en systemen

Elke GB300 node levert ongeveer 40 petaflops—effectief ter vervanging van de hele Sierra supercomputer (circa 2018), die 18.000 Volta GPU's vereiste. Deze 4.000x prestatieverbetering binnen zes jaar overtreft traditionele Moore's Law scaling ruimschoots, en toont NVIDIA's veelzijdige benadering van prestatieversnelling door architectuur, software en interconnect innovaties.

MVLink: Interconnect-Technologie Herdefiniëren

MVLink vertegenwoordigt de meest significante vooruitgang in GPU-interconnect technologie sinds de introductie van NVLink. Het systeem maakt complete disaggregatie van computerresources over een hele rack mogelijk, waardoor 72 GPU's (144 GPU dies) één massieve computationele eenheid worden.

De technische specificaties zijn verbijsterend:

- Individuele MVLink switches: 7,2 TB/s bandbreedte

- MVLink spine: 130 TB/s all-to-all bandbreedte

- Fysieke implementatie: 5.000 precies lengtegematchte coaxiale kabels (ongeveer 3,2 kilometer totaal)

- Vermogensdichtheid: 120 kilowatt per rack (vloeistofkoeling noodzakelijk)

Voor context, Huang merkte op dat het piekverkeer van het hele internet ongeveer 900 terabits per seconde (112,5 TB/s) is, waardoor een enkele MVLink spine meer verkeer aankan dan het wereldwijde internet op piekcapaciteit.

MVLink Fusion: Een Open AI-Infrastructuur Ecosysteem Creëren

MVLink Fusion is mogelijk de meest innovatieve ecosysteemzet die NVIDIA in jaren heeft gemaakt. In plaats van partners te dwingen volledig in NVIDIA hardware te investeren, openen ze de architectuur om bedrijven semi-custom AI-systemen te laten bouwen die nog steeds aansluiten op het NVIDIA universum.

De benadering is verrassend flexibel:

-

Custom ASIC Integratie: Heb je je gespecialiseerde accelerator? Geen probleem. Partners kunnen MVLink chiplets inzetten om hun custom silicium te verbinden met NVIDIA's ecosysteem. Het is alsof NVIDIA zegt: "Bouw welke gespecialiseerde hardware je ook wilt—zorg er alleen voor dat het kan praten met onze spullen."

-

Custom CPU Integratie: CPU-leveranciers worden ook niet buitengesloten. Ze kunnen MVLink's chip-to-chip interfaces direct implementeren, waardoor een directe snelweg ontstaat tussen hun processors en Blackwell GPU's (of de aankomende Ruben architectuur). MVLink is enorm voor bedrijven die geïnvesteerd zijn in specifieke CPU-architecturen.

Partner aankondigingen bestrijken de halfgeleiderindustrie:

- Silicium implementatiepartners: LCHIP, Astera Labs, Marll, MediaTek

- CPU-leveranciers: Fujitsu, Qualcomm

- EDA-providers: Cadence, Synopsis

Deze benadering positioneert NVIDIA strategisch om waarde vast te leggen ongeacht de specifieke hardwaremix die klanten implementeren, wat Huang's openhartige uitspraak weergeeft: "Niets geeft me meer vreugde dan wanneer je alles van NVIDIA koopt. Ik wil dat jullie dat weten. Maar het geeft me enorme vreugde als je iets van NVIDIA koopt."

Enterprise AI Implementatie: RTX Pro Enterprise en Omniverse Server

De RTX Pro Enterprise en Omniverse server vertegenwoordigen NVIDIA's meest significante enterprise-gerichte compute-aanbod, specifiek ontworpen om AI-mogelijkheden te integreren in traditionele IT-omgevingen:

- Volledig x86-compatibele architectuur

- Ondersteuning voor traditionele hypervisors (VMware, Red Hat, Nanix)

- Kubernetes integratie voor vertrouwde workload orchestratie

- Blackwell RTX Pro 6000s GPU's (8 per server)

- CX8 networking chip die 800 Gb/s bandbreedte biedt

- 1,7x prestatieverbetering versus Hopper H100

- 4x prestatie op geoptimaliseerde modellen zoals Deepseek R1

Het systeem stelt een nieuwe prestatie-envelop vast voor AI-inference, gemeten in een dual-axis framework van throughput (tokens per seconde) en responsiviteit (tokens per seconde per gebruiker)—kritieke metrieken voor wat Huang het tijdperk van "inference time scaling" of "thinking AI" noemt.

AI Data Platform: Storage Heruitvinden voor Ongestructureerde Data

NVIDIA's AI Data Platform introduceert een fundamenteel andere benadering van enterprise storage:

"Mensen bevragen gestructureerde databases zoals SQL... Maar AI wil ongestructureerde data bevragen. Ze willen semantiek. Ze willen betekenis. En dus moeten we een nieuw type storage platform creëren."

Belangrijke componenten omvatten:

- NVIDIA AIQ (of IQ): Een semantische query layer

- GPU-versnelde storage nodes ter vervanging van traditionele CPU-centrische architecturen

- Post-trained AI modellen met transparante training data herkomst

- 15x sneller bevragen met 50% betere resultaten vergeleken met bestaande oplossingen

Storage industry partners die deze architectuur implementeren zijn onder andere Dell, Hitachi, IBM, NetApp en Vast, wat een uitgebreid enterprise AI data management ecosysteem creëert.

AI Operations en Robotica: Software Frameworks voor de Intelligente Enterprise

De keynote introduceerde twee cruciale software frameworks:

-

AI Operations (AIOps): Een uitgebreide stack voor het beheren van AI agents in enterprise contexten, inclusief data curatie, model fine-tuning, evaluatie, guardrails en beveiliging. Partners zijn onder andere Crowdstrike, Data IQ, Data Robots, Elastic, Newonix, Red Hat en Trend Micro.

-

Isaac Groot Platform N1.5: Een open-sourced robotica ontwikkeling ecosysteem inclusief:

Newton physics engine (ontwikkeld met Google DeepMind en Disney Research)

- Jetson Thor robotica processor

- NVIDIA Isaac besturingssysteem

- Groot Dreams blueprint voor synthetische trajectorie data generatie

Het robotica-initiatief pakt een kritieke uitdaging aan: "Voor robotica moet je AI hebben. Maar om de AI te onderwijzen, heb je AI nodig." Dit recursieve optimalisatiepatroon benut generatieve AI om beperkte menselijke demonstratiedata uit te breiden tot uitgebreide robotica training sets.

Taiwan's Strategische Positie in de AI Manufacturing Revolutie

Een significant deel van de keynote belichtte Taiwan's cruciale rol in zowel het produceren als implementeren van AI-technologieën:

- Taiwanese productiebedrijven (TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, Wiiwin, Gigabyte) implementeren NVIDIA Omniverse voor digital twin implementaties.

- TSMC gebruikt AI-aangedreven tools op CUDA om fab layouts en leidingsystemen te optimaliseren

- Productiepartners gebruiken digital twins voor virtuele planning en predictive maintenance en als "robot gyms" voor het trainen van robotische systemen.

- Foxconn, TSMC, de Taiwanese regering en NVIDIA bouwen Taiwan's eerste grootschalige AI supercomputer.

Huang versterkte NVIDIA's commitment aan de regio verder door plannen aan te kondigen voor "NVIDIA Constellation," een nieuwe hoofdkantoor faciliteit in Taipei.

Technische Analyse: Wat Dit Betekent voor Enterprise AI Strategie

Deze aankondigingen vertegenwoordigen gezamenlijk een uitgebreide heruitvinding van enterprise computing met verschillende strategische implicaties:

-

Computationele Schaalvereisten: De inference-time prestatievereisten van "reasoning AI" en agentische systemen zullen significant hogere compute vereisten aandrijven dan initiële large language model implementaties, wat architecturale planning noodzakelijk maakt voor massieve scale-up en scale-out mogelijkheden.

-

Disaggregatie van Enterprise AI: Het MVLink Fusion ecosysteem maakt ongekende flexibiliteit mogelijk in het bouwen van heterogene AI-systemen, wat mogelijk de adoptie van gespecialiseerde AI-accelerators versnelt terwijl NVIDIA's positie in het ecosysteem behouden blijft door interconnect technologie.

-

Verschuiving van Datacenters naar AI Fabrieken: We moeten volledig herdenken hoe we de waarde van onze infrastructuur investeringen meten. Voorbij zijn de dagen dat ruwe compute of storage capaciteit het hele verhaal vertelde. Nu gaat het allemaal om token productie—hoeveel eenheden AI output kunnen jouw systemen genereren per seconde, per watt, en dollar? Jensen maakte geen grapje toen hij zei dat bedrijven binnenkort hun token productie zouden rapporteren, zoals manufacturing metrieken. De verschuiving naar AI fabrieken zal de economie van hoe we AI-infrastructuur uitgaven implementeren en rechtvaardigen fundamenteel herschrijven.

-

Digital Twin Integratie: Het feit dat elke grote Taiwanese fabrikant Omniverse digital twins bouwt vertelt ons alles wat we moeten weten—dit is geen coole tech demo meer. Digital twins zijn essentiële infrastructuur geworden voor bedrijven die serieus zijn over optimalisatie. Wat bijzonder fascinerend is, is hoe dit een feedback loop creëert: bedrijven bouwen digital twins om fysieke processen te optimaliseren, gebruiken diezelfde omgevingen dan om AI en robotica te trainen, wat de fysieke wereld verder verbetert. Het is een continue verbeteringscyclus die blijft versnellen.

-

Robotische Personeelsplanning: De convergentie van agentische AI en fysieke robotica suggereert dat organisaties geïntegreerde digitale en fysieke automatiseringsstrategieën moeten ontwikkelen, met significante implicaties voor personeelsplanning en faciliteitsontwerp.

-

Software-Gedefinieerde Infrastructuur: Ondanks de hardware aankondigingen, versterkt NVIDIA's voortdurende nadruk op libraries en software frameworks dat concurrentievoordeel in AI net zoveel zal komen van software optimalisatie als van ruwe hardware mogelijkheden.

Navigeren van de AI Factory Transitie

Het transformeren van traditionele datacenters naar AI fabrieken vereist gespecialiseerde expertise die hardware implementatie, software optimalisatie en architecturaal ontwerp verbindt. Bij Introl hebben we deze geavanceerde GPU infrastructuur oplossingen geïmplementeerd voor enterprises die de sprong maken naar AI-first computing. Ons team's diepe ervaring met NVIDIA's ecosysteem—van complexe MVLink implementaties tot Omniverse digital twin implementaties—helpt organisaties deze paradigmaverschuiving navigeren zonder de steile leercurve die typisch geassocieerd wordt met cutting-edge infrastructuur. Of je nu reasoning AI mogelijkheden opschaalt of je eerste AI factory floor opbouwt, samenwerken met specialisten kan je time-to-value in dit snel evoluerende landschap dramatisch versnellen. Klaar om **het gedaan te krijgen? Plan vandaag een gesprek.

Conclusie: Computing's Derde Era is Gearriveerd

Computex was niet gewoon NVIDIA die snellere chips toonde. Wat Jensen uiteenzette ging voorbij de gebruikelijke "20% beter dan vorig jaar" aankondigingen waar we gevoelloos voor zijn geworden. Hij herformuleert fundamenteel waarvoor computers zijn. We hebben decennia besteed aan het bouwen van machines die nummers verwerken en data verplaatsen. Nu bouwt NVIDIA systemen die intelligentie fabriceren als hun primaire output. Het is als het vergelijken van een archiefdossier met een brein. Zeker, beide slaan informatie op, maar de ene zit daar terwijl de andere nieuwe ideeën creëert. De verschuiving klinkt misschien als semantiek totdat je realiseert dat het alles verandert over hoe we computing systemen bouwen, implementeren en meten.

"Voor de eerste keer in al onze tijd samen, niet alleen creëren we de volgende generatie van IT, maar we hebben dat al meerdere keren gedaan, van PC naar internet naar cloud naar mobile cloud. We hebben dat meerdere keren gedaan. Maar deze keer, niet alleen creëren we de volgende generatie van IT, we creëren een hele nieuwe industrie."

Deze transitie vertegenwoordigt de derde grote computing paradigma verschuiving, volgend op de personal computing revolutie en het internet/cloud tijdperk. Organisaties die deze AI-infrastructuur mogelijkheden integreren zullen waarschijnlijk onoverwinnelijke concurrentievoordelen vestigen over industrieën.

De fabrieken van computationele intelligentie worden vandaag gebouwd. De vraag is niet langer of AI business zal transformeren—het is of jouw organisatie de infrastructuur bouwt om competitief te blijven in een wereld waarin computationele intelligentie net zo fundamenteel wordt voor bedrijfsoperaties als elektriciteit.

Referenties en Aanvullende Bronnen

-

NVIDIA Officiële Blackwell Architectuur Overzicht: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

-

NVIDIA MVLink Technische Documentatie: https://developer.nvidia.com/mvlink

-

NVIDIA Omniverse Platform: https://www.nvidia.com/en-us/omniverse/

-

Isaac Robotics Platform: https://developer.nvidia.com/isaac-ros

-

NVIDIA AI Enterprise: https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

-

NVIDIA Computex 2025 Officiële Persmateriaal: https://nvidianews.nvidia.com/news/computex-2025

-

NVIDIA CUDA-X Libraries Overzicht: https://developer.nvidia.com/gpu-accelerated-libraries

-

NVIDIA DGX Systemen: https://www.nvidia.com/en-us/data-center/dgx-systems/