CEO NVIDIA Jensen Huang tampil di panggung Computex 2025 mengenakan jaket kulit khasnya dan memperkenalkan hardware baru serta paradigma komputasi yang benar-benar baru. Raksasa semikonduktor ini secara tegas telah bertransformasi menjadi perusahaan infrastruktur AI, membangun fondasi untuk apa yang Huang sebut sebagai "infrastruktur kecerdasan"—revolusi infrastruktur besar ketiga setelah listrik dan internet.

Keynote ini bukan sekedar pengumuman produk biasa—ini adalah Jensen yang memaparkan blueprint NVIDIA untuk membentuk kembali lanskap komputasi. Lompatan teknis, pivot strategis, dan strategi pasar yang dia ungkapkan kemungkinan akan membuat ini menjadi Computex yang akan kita rujuk selama bertahun-tahun. Tonton keynote Computex 2025 Nvidia secara lengkap.

Evolusi Strategis NVIDIA: Dari Kartu Grafis ke Penyedia Infrastruktur

Kisah transformasi NVIDIA sangat menakjubkan. Pada 1993, Jensen melihat "peluang chip $300 juta"—pasar yang substansial. Maju ke hari ini, dan dia memimpin raksasa infrastruktur AI bernilai triliunan dolar. Pertumbuhan eksplosif seperti itu tidak terjadi begitu saja—NVIDIA secara fundamental menciptakan ulang dirinya beberapa kali sepanjang perjalanan.

Selama keynote-nya, Jensen menyoroti titik-titik balik yang membuat NVIDIA hari ini menjadi mungkin:

-

2006: CUDA hadir dan mengubah komputasi paralel secara total. Tiba-tiba, developer yang tidak pernah mempertimbangkan menggunakan GPU untuk komputasi umum mulai membangun aplikasi yang tidak mungkin dilakukan pada CPU tradisional.

-

2016: DGX1 muncul sebagai sistem pertama NVIDIA yang tanpa kompromi dan berfokus pada AI. Dalam apa yang sekarang terlihat seperti firasat yang hampir menyeramkan, Jensen menyumbangkan unit pertama ke OpenAI, secara efektif memberi mereka fondasi komputasi yang akhirnya mengarah ke revolusi AI kita saat ini.

-

2019: Akuisisi Mellanox, memungkinkan NVIDIA untuk merekonceptualisasi data center sebagai unit komputasi terpadu

Transformasi ini berujung pada posisi NVIDIA saat ini sebagai "perusahaan infrastruktur esensial"—status yang Huang tekankan dengan menyoroti roadmap publik lima tahun yang belum pernah ada, yang memungkinkan perencanaan infrastruktur global untuk deployment AI.

Mendefinisikan Ulang Metrik Performa: Ekonomi Token

NVIDIA telah memperkenalkan perubahan fundamental dalam cara kita mengukur output komputasi. Daripada metrik tradisional seperti FLOPs atau operasi per detik, Huang memposisikan data center AI sebagai pabrik yang memproduksi "token"—unit kecerdasan komputasi:

"Perusahaan mulai membicarakan berapa banyak token yang mereka produksi kuartal lalu dan berapa banyak token yang mereka produksi bulan lalu. Segera, kita akan membahas berapa banyak token yang kita produksi setiap jam, seperti yang dilakukan setiap pabrik."

Reframing ini secara langsung menghubungkan investasi komputasi dan output bisnis, menyelaraskan infrastruktur AI dengan kerangka kerja industri tradisional. Model ini memposisikan NVIDIA di pusat paradigma ekonomi baru di mana efisiensi komputasi langsung diterjemahkan menjadi kemampuan bisnis.

Upgrade Arsitektur Blackwell: Spesifikasi dan Metrik Performa GB300

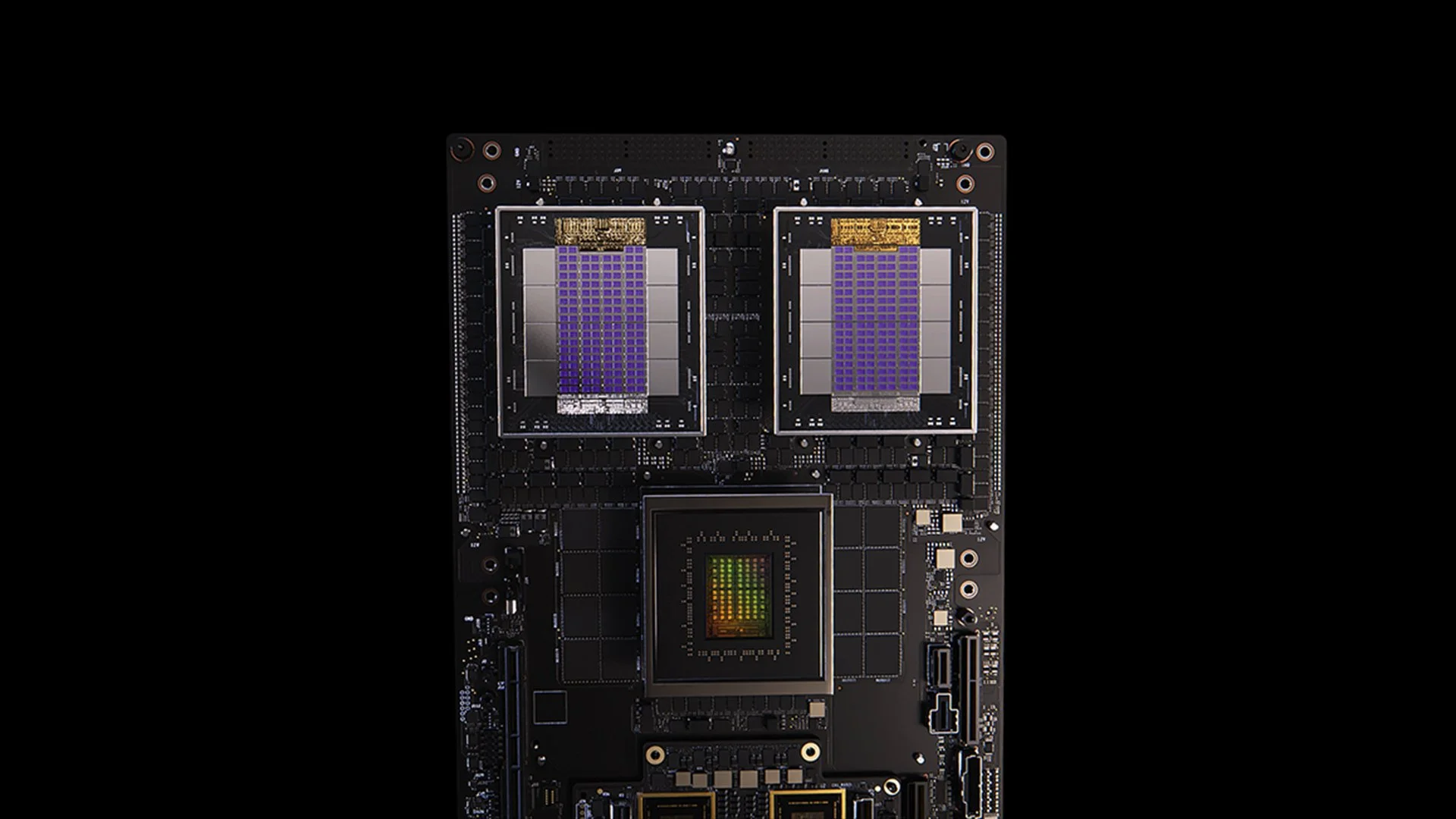

[caption id="" align="alignnone" width="1280"] Sistem GB200 [/caption]

Sistem GB200 [/caption]

Update GB300 untuk arsitektur Blackwell mencontohkan siklus peningkatan performa tanpa henti NVIDIA. Dijadwalkan untuk Q3 2025, GB300 memberikan:

- 1.5x peningkatan performa inference dibanding GB200

- 1.5x peningkatan kapasitas memori HBM

- 2x peningkatan bandwidth networking

- Desain full liquid-cooled

- Kompatibel mundur dengan chassis dan sistem yang ada

Setiap node GB300 memberikan sekitar 40 petaflops—secara efektif menggantikan seluruh superkomputer Sierra (circa 2018), yang membutuhkan 18.000 GPU Volta. Gain performa 4.000x dalam enam tahun ini sangat melampaui scaling Moore's Law tradisional, mendemonstrasikan pendekatan multi-faceted NVIDIA untuk akselerasi performa melalui inovasi arsitektur, software, dan interconnect.

MVLink: Mendefinisikan Ulang Teknologi Interconnect

MVLink merupakan kemajuan paling signifikan dalam teknologi interconnect GPU sejak diperkenalkannya NVLink. Sistem ini memungkinkan disagregasi lengkap sumber daya komputasi di seluruh rack, mengubah 72 GPU (144 die GPU) menjadi satu unit komputasi masif.

Spesifikasi teknisnya menakjubkan:

- Switch MVLink individual: bandwidth 7.2 TB/s

- MVLink spine: bandwidth all-to-all 130 TB/s

- Implementasi fisik: 5.000 kabel koaksial dengan panjang yang disesuaikan dengan presisi (total sekitar 2 mil)

- Kepadatan daya: 120 kilowatt per rack (memerlukan liquid cooling)

Sebagai konteks, Huang mencatat bahwa traffic puncak seluruh internet sekitar 900 terabit per detik (112.5 TB/s), membuat satu MVLink spine mampu menangani lebih banyak traffic daripada internet global pada kapasitas puncak.

MVLink Fusion: Menciptakan Ekosistem Infrastruktur AI Terbuka

MVLink Fusion mungkin merupakan strategi ekosistem paling inovatif yang NVIDIA buat dalam bertahun-tahun. Alih-alih memaksa mitra untuk sepenuhnya menggunakan hardware NVIDIA, mereka membuka arsitektur untuk memungkinkan perusahaan membangun sistem AI semi-custom yang tetap terhubung ke universe NVIDIA.

Pendekatannya sangat fleksibel:

-

Integrasi ASIC Custom: Punya accelerator khusus Anda? Tidak masalah. Mitra dapat memasang chiplet MVLink untuk menghubungkan silicon custom mereka ke ekosistem NVIDIA. Ini seperti NVIDIA berkata, "Bangun hardware khusus apa pun yang Anda inginkan—pastikan saja bisa berkomunikasi dengan barang kami."

-

Integrasi CPU Custom: Vendor CPU juga tidak ketinggalan. Mereka dapat langsung mengimplementasikan interface chip-to-chip MVLink, menciptakan jalan raya langsung antara prosesor mereka dan GPU Blackwell (atau arsitektur Ruben yang akan datang). MVLink sangat besar untuk perusahaan yang berinvestasi dalam arsitektur CPU spesifik.

Pengumuman mitra mencakup industri semikonduktor:

- Mitra implementasi silicon: LCHIP, Astera Labs, Marll, MediaTek

- Vendor CPU: Fujitsu, Qualcomm

- Penyedia EDA: Cadence, Synopsis

Pendekatan ini secara strategis memposisikan NVIDIA untuk menangkap nilai terlepas dari mix hardware spesifik yang di-deploy pelanggan, mencerminkan pernyataan jujur Huang: "Tidak ada yang membuat saya lebih senang daripada ketika Anda membeli segalanya dari NVIDIA. Saya ingin kalian tahu itu. Tapi saya sangat senang jika Anda membeli sesuatu dari NVIDIA."

Deployment AI Enterprise: RTX Pro Enterprise dan Omniverse Server

RTX Pro Enterprise dan server Omniverse merupakan penawaran komputasi paling signifikan yang berfokus pada enterprise dari NVIDIA, dirancang khusus untuk mengintegrasikan kemampuan AI ke dalam lingkungan IT tradisional:

- Arsitektur fully x86-compatible

- Dukungan untuk hypervisor tradisional (VMware, Red Hat, Nanix)

- Integrasi Kubernetes untuk orkestrasi workload yang familiar

- GPU Blackwell RTX Pro 6000s (8 per server)

- Chip networking CX8 memberikan bandwidth 800 Gb/s

- 1.7x peningkatan performa versus Hopper H100

- 4x performa pada model yang dioptimalkan seperti Deepseek R1

Sistem ini menetapkan envelope performa baru untuk inference AI, diukur dalam kerangka kerja dual-axis throughput (token per detik) dan responsiveness (token per detik per user)—metrik kritis untuk apa yang Huang sebut sebagai era "inference time scaling" atau "thinking AI."

Platform Data AI: Menggambarkan Ulang Storage untuk Data Tidak Terstruktur

Platform Data AI NVIDIA memperkenalkan pendekatan yang secara fundamental berbeda untuk storage enterprise:

"Manusia melakukan query database terstruktur seperti SQL... Tapi AI ingin melakukan query data tidak terstruktur. Mereka ingin semantik. Mereka ingin makna. Dan jadi kita harus menciptakan tipe platform storage baru."

Komponen kunci meliputi:

- NVIDIA AIQ (atau IQ): Layer query semantik

- Node storage yang dipercepat GPU menggantikan arsitektur tradisional yang berpusat pada CPU

- Model AI post-trained dengan provenance data training yang transparan

- Query 15x lebih cepat dengan hasil 50% lebih baik dibandingkan solusi existing

Mitra industri storage yang mengimplementasikan arsitektur ini termasuk Dell, Hitachi, IBM, NetApp, dan Vast, menciptakan ekosistem manajemen data AI enterprise yang komprehensif.

Operasi AI dan Robotika: Framework Software untuk Intelligent Enterprise

Keynote memperkenalkan dua framework software penting:

-

AI Operations (AIOps): Stack komprehensif untuk mengelola agent AI dalam konteks enterprise, termasuk kurasi data, fine-tuning model, evaluasi, guardrails, dan keamanan. Mitra termasuk Crowdstrike, Data IQ, Data Robots, Elastic, Newonix, Red Hat, dan Trend Micro.

-

Isaac Groot Platform N1.5: Ekosistem pengembangan robotika open-source termasuk:

Engine fisika Newton (dikembangkan dengan Google DeepMind dan Disney Research)

- Prosesor robotika Jetson Thor

- Sistem operasi NVIDIA Isaac

- Blueprint Groot Dreams untuk generasi data trajektori sintetis

Inisiatif robotika ini mengatasi tantangan kritis: "Agar robotika terjadi, Anda memerlukan AI. Tapi untuk mengajar AI, Anda memerlukan AI." Pola optimisasi rekursif ini memanfaatkan generative AI untuk memperluas data demonstrasi manusia yang terbatas menjadi set training robotika yang komprehensif.

Posisi Strategis Taiwan dalam Revolusi Manufaktur AI

Bagian signifikan dari keynote menyoroti peran penting Taiwan dalam memproduksi dan mengimplementasikan teknologi AI:

- Perusahaan manufaktur Taiwan (TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, Wiiwin, Gigabyte) men-deploy NVIDIA Omniverse untuk implementasi digital twin.

- TSMC menggunakan tools bertenaga AI pada CUDA untuk mengoptimalkan layout fab dan sistem piping

- Mitra manufaktur menggunakan digital twin untuk perencanaan virtual dan predictive maintenance serta sebagai "robot gym" untuk melatih sistem robotika.

- Foxconn, TSMC, pemerintah Taiwan, dan NVIDIA membangun superkomputer AI skala besar pertama Taiwan.

Huang semakin memperkuat komitmen NVIDIA terhadap wilayah ini dengan mengumumkan rencana untuk "NVIDIA Constellation," fasilitas kantor pusat baru di Taipei.

Analisis Teknis: Apa Artinya untuk Strategi AI Enterprise

Pengumuman ini secara kolektif merepresentasikan reimaginasi komprehensif komputasi enterprise dengan beberapa implikasi strategis:

-

Persyaratan Skala Komputasi: Tuntutan performa inference-time dari "reasoning AI" dan sistem agentic akan mendorong persyaratan komputasi yang secara signifikan lebih tinggi daripada deployment large language model awal, mengharuskan perencanaan arsitektur untuk kemampuan scale-up dan scale-out masif.

-

Disagregasi AI Enterprise: Ekosistem MVLink Fusion memungkinkan fleksibilitas yang belum pernah ada dalam membangun sistem AI heterogen, berpotensi mempercepat adopsi accelerator AI khusus sambil mempertahankan posisi NVIDIA dalam ekosistem melalui teknologi interconnect.

-

Pergeseran dari Data Center ke AI Factory: Kita perlu benar-benar memikirkan ulang cara mengukur nilai investasi infrastruktur kita. Sudah berlalu hari-hari ketika kapasitas komputasi atau storage mentah menceritakan seluruh cerita. Sekarang semuanya tentang produksi token—berapa banyak unit output AI yang dapat dihasilkan sistem Anda per detik, per watt, dan dolar? Jensen tidak bercanda ketika dia berkata perusahaan akan segera melaporkan produksi token mereka, seperti metrik manufaktur. Pergeseran ke AI factory akan secara fundamental menulis ulang ekonomi bagaimana kita men-deploy dan membenarkan pengeluaran infrastruktur AI.

-

Integrasi Digital Twin: Fakta bahwa setiap manufaktur besar Taiwan membangun digital twin Omniverse memberi tahu kita segalanya yang perlu kita ketahui—ini bukan lagi demo tech yang keren. Digital twin telah menjadi infrastruktur esensial untuk perusahaan yang serius tentang optimisasi. Yang sangat menarik adalah bagaimana ini menciptakan feedback loop: perusahaan membangun digital twin untuk mengoptimalkan proses fisik, kemudian menggunakan lingkungan yang sama untuk melatih AI dan robotika, lebih jauh meningkatkan dunia fisik. Ini adalah siklus peningkatan berkelanjutan yang terus berakselerasi.

-

Perencanaan Tenaga Kerja Robotik: Konvergensi AI agentic dan robotika fisik menunjukkan organisasi harus mengembangkan strategi otomatisasi digital dan fisik yang terintegrasi, dengan implikasi signifikan untuk perencanaan tenaga kerja dan desain fasilitas.

-

Infrastruktur Software-Defined: Meskipun ada pengumuman hardware, penekanan berkelanjutan NVIDIA pada library dan framework software memperkuat bahwa keunggulan kompetitif dalam AI akan berasal dari optimisasi software sebanyak kemampuan hardware mentah.

Menavigasi Transisi AI Factory

Mentransformasi data center tradisional menjadi AI factory memerlukan keahlian khusus yang menjembatani deployment hardware, optimisasi software, dan desain arsitektur. Di Introl, kami telah mengimplementasikan solusi infrastruktur GPU canggih ini untuk enterprise yang melompat ke komputasi AI-first. Pengalaman mendalam tim kami dengan ekosistem NVIDIA—dari deployment MVLink yang kompleks hingga implementasi digital twin Omniverse—membantu organisasi menavigasi pergeseran paradigma ini tanpa kurva pembelajaran yang curam yang biasanya dikaitkan dengan infrastruktur cutting-edge. Baik scaling up kemampuan reasoning AI atau membangun lantai AI factory pertama Anda, bermitra dengan spesialis dapat secara dramatis mempercepat time-to-value Anda dalam lanskap yang berevolusi cepat ini. Siap untuk **menyelesaikannya? Jadwalkan panggilan hari ini.

Kesimpulan: Era Ketiga Komputasi Telah Tiba

Computex bukan hanya NVIDIA memamerkan chip yang lebih cepat. Apa yang Jensen paparkan melampaui pengumuman "20% lebih baik dari tahun lalu" yang biasa kita dengar. Dia secara fundamental mereframe untuk apa komputer digunakan. Kita telah menghabiskan dekade membangun mesin yang memproses angka dan memindahkan data. Sekarang, NVIDIA membangun sistem yang memproduksi kecerdasan sebagai output utama mereka. Ini seperti membandingkan lemari arsip dengan otak. Tentu, keduanya menyimpan informasi, tapi yang satu diam saja sementara yang lain menciptakan ide baru. Pergeseran ini mungkin terdengar seperti semantik sampai Anda menyadari ini mengubah segalanya tentang bagaimana kita membangun, men-deploy, dan mengukur sistem komputasi.

"Untuk pertama kalinya dalam semua waktu kita bersama, tidak hanya kita menciptakan generasi berikutnya dari IT, tapi kita juga telah melakukan itu beberapa kali, dari PC ke internet ke cloud ke mobile cloud. Kita telah melakukan itu beberapa kali. Tapi kali ini, tidak hanya kita menciptakan generasi berikutnya dari IT, kita menciptakan seluruh industri baru."

Transisi ini merepresentasikan pergeseran paradigma komputasi besar ketiga, mengikuti revolusi personal computing dan era internet/cloud. Organisasi yang mengintegrasikan kemampuan infrastruktur AI ini kemungkinan akan menetapkan keunggulan kompetitif yang tak tergoyahkan di berbagai industri.

Pabrik kecerdasan komputasi sedang dibangun hari ini. Pertanyaannya bukan lagi apakah AI akan mentransformasi bisnis—tapi apakah organisasi Anda membangun infrastruktur untuk tetap kompetitif dalam dunia di mana kecerdasan komputasi menjadi fundamental bagi operasi bisnis seperti listrik.

Referensi dan Sumber Daya Tambahan

-

NVIDIA Official Blackwell Architecture Overview: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

-

NVIDIA MVLink Technical Documentation: https://developer.nvidia.com/mvlink

-

NVIDIA Omniverse Platform: https://www.nvidia.com/en-us/omniverse/

-

Isaac Robotics Platform: https://developer.nvidia.com/isaac-ros

-

NVIDIA AI Enterprise: https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

-

NVIDIA Computex 2025 Official Press Materials: https://nvidianews.nvidia.com/news/computex-2025

-

NVIDIA CUDA-X Libraries Overview: https://developer.nvidia.com/gpu-accelerated-libraries

-

NVIDIA DGX Systems: https://www.nvidia.com/en-us/data-center/dgx-systems/