Генеральний директор NVIDIA Jensen Huang вийшов на сцену Computex 2025 у своїй фірмовій шкіряній куртці та представив нове обладнання і повністю переосмислену парадигму комп'ютерних обчислень. Гігант напівпровідникової індустрії рішуче трансформувався в компанію AI-інфраструктури, будуючи фундамент для того, що Huang називає "інфраструктурою інтелекту" — третьою великою інфраструктурною революцією після електрики та інтернету.

Ця презентація була не просто черговим анонсом продуктів — це Jensen виклав план NVIDIA для перебудови комп'ютерного ландшафту. Технічні стрибки, стратегічні повороти та ринкові ходи, які він розкрив, швидше за все зроблять цей Computex тим, на який ми будемо посилатися роками. Дивіться повну презентацію Computex 2025 Nvidia.

Стратегічна еволюція NVIDIA: від відеокарт до провайдера інфраструктури

Історія трансформації NVIDIA вражає. У 1993 році Jensen побачив "можливість чипу на 300 мільйонів доларів" — суттєвий ринок. Перенесемося до сьогодення, і він керує трильйонним джаггернаутом AI-інфраструктури. Таке вибухове зростання не просто трапляється — NVIDIA кардинально переосмислювала себе кілька разів на цьому шляху.

Під час своєї презентації Jensen підкреслив поворотні моменти, які зробили сьогоднішню NVIDIA можливою:

-

2006: CUDA з'явилася і перевернула паралельні обчислення з ніг на голову. Раптом розробники, які ніколи не розглядали використання GPU для загальних обчислень, будували додатки, які були б неможливими на традиційних CPU.

-

2016: DGX1 з'явилася як перша безкомпромісна система NVIDIA, орієнтована на AI. У тому, що зараз виглядає майже моторошним передбаченням, Jensen подарував перший пристрій OpenAI, фактично надавши їм обчислювальний фундамент, що врешті привів до нашої поточної AI революції.

-

2019: Придбання Mellanox, що дозволило NVIDIA переосмислити центри обробки даних як єдині обчислювальні одиниці

Ця трансформація кульмінує в поточній позиції NVIDIA як "важливої інфраструктурної компанії" — статусу, який Huang підкреслив, виділивши свої безпрецедентні п'ятирічні публічні дорожні карти, які дозволяють глобальне інфраструктурне планування для розгортання AI.

Переосмислення метрик продуктивності: токенна економіка

NVIDIA представила фундаментальний зрушення в тому, як ми вимірюємо обчислювальний вихід. Замість традиційних метрик як FLOP або операцій за секунду, Huang позиціонував центри обробки даних AI як фабрики, що виробляють "токени" — одиниці обчислювального інтелекту:

"Компанії починають говорити про те, скільки токенів вони виробили минулого кварталу і скільки токенів вони виробили минулого місяця. Дуже скоро ми будемо обговорювати, скільки токенів ми виробляємо щогодини, точно як це робить кожна фабрика."

Це переосмислення прямо пов'язує обчислювальні інвестиції та бізнес-результат, узгоджуючи AI-інфраструктуру з традиційними промисловими рамками. Модель позиціонує NVIDIA в епіцентрі нової економічної парадигми, де обчислювальна ефективність прямо переходить у бізнес-можливості.

Оновлення архітектури Blackwell: специфікації GB300 та метрики продуктивності

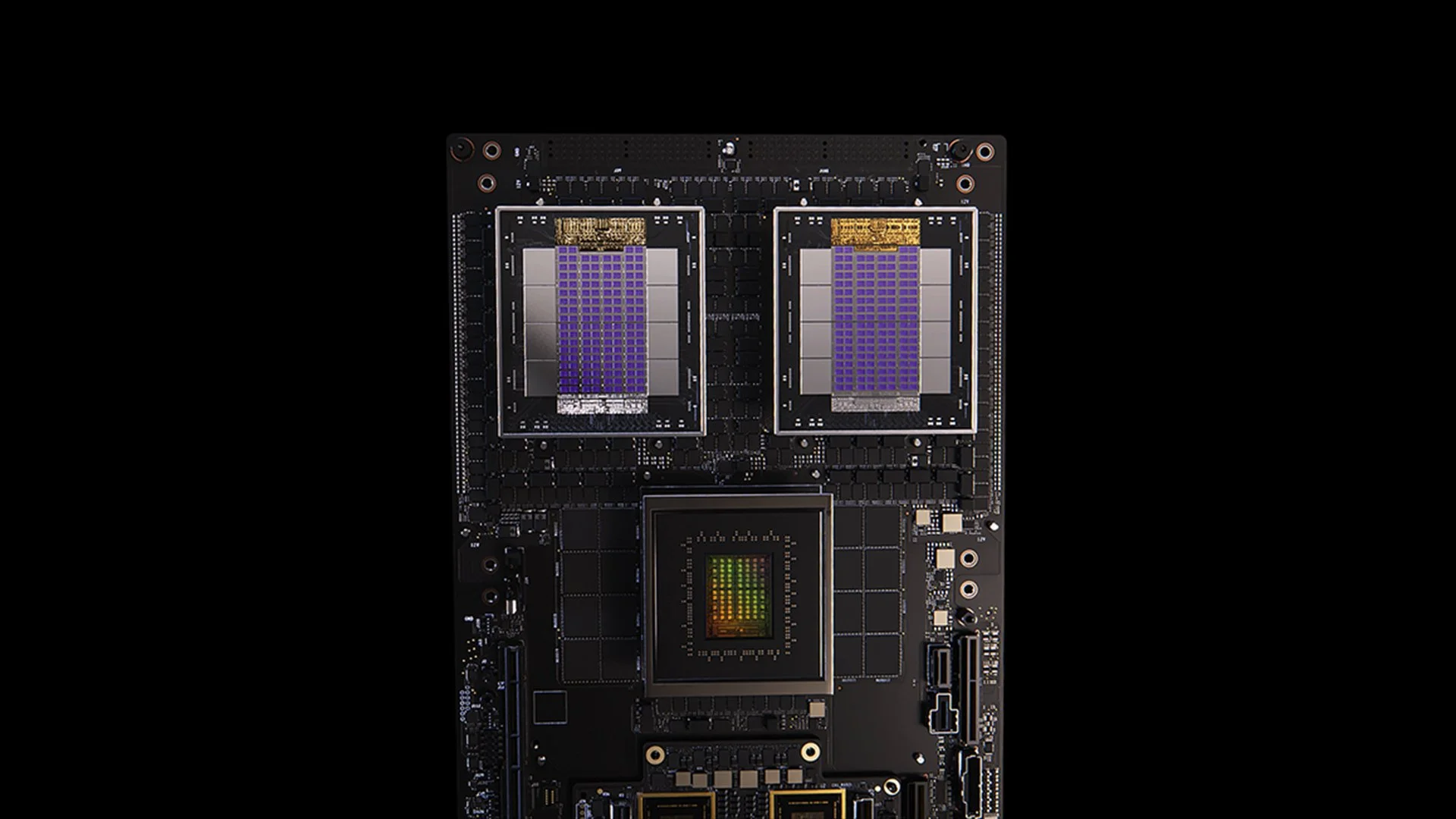

[caption id="" align="alignnone" width="1280"] Система GB200 [/caption]

Система GB200 [/caption]

Оновлення GB300 архітектури Blackwell демонструє невпинний цикл покращення продуктивності NVIDIA. Заплановане на третій квартал 2025 року, GB300 забезпечує:

- 1.5x підвищення продуктивності висновків порівняно з GB200

- 1.5x збільшення ємності пам'яті HBM

- 2x покращення пропускної здатності мережі

- Повністю рідинне охолодження

- Зворотна сумісність з існуючими шасі та системами

Кожен вузол GB300 забезпечує приблизно 40 петафлопів — фактично замінюючи весь суперкомп'ютер Sierra (близько 2018 року), який потребував 18,000 GPU Volta. Це покращення продуктивності в 4,000 разів за шість років значно перевершує традиційне масштабування закону Мура, демонструючи багатогранний підхід NVIDIA до прискорення продуктивності через інновації архітектури, програмного забезпечення та взаємозв'язків.

MVLink: переосмислення технології взаємозв'язків

MVLink представляє найзначніший прогрес у технології взаємозв'язків GPU з моменту впровадження NVLink. Система дозволяє повну дисагрегацію обчислювальних ресурсів у всій стійці, перетворюючи 72 GPU (144 кристали GPU) в одну масивну обчислювальну одиницю.

Технічні специфікації вражають:

- Індивідуальні перемикачі MVLink: пропускна здатність 7.2 ТБ/с

- Хребет MVLink: пропускна здатність 130 ТБ/с all-to-all

- Фізична реалізація: 5,000 точно узгоджених за довжиною коаксіальних кабелів (загалом приблизно 2 милі)

- Щільність потужності: 120 кіловат на стійку (потребує рідинного охолодження)

Для контексту, Huang зазначив, що піковий трафік всього інтернету становить приблизно 900 терабіт за секунду (112.5 ТБ/с), роблячи один хребет MVLink здатним обробляти більше трафіку, ніж глобальний інтернет на піковій потужності.

MVLink Fusion: створення відкритої екосистеми AI-інфраструктури

MVLink Fusion може бути найінноваційнішим екосистемним ходом NVIDIA за останні роки. Замість того, щоб змушувати партнерів повністю переходити на обладнання NVIDIA, вони відкривають архітектуру, дозволяючи компаніям будувати напівкастомні AI-системи, які все ще прив'язані до всесвіту NVIDIA.

Підхід дивовижно гнучкий:

-

Інтеграція кастомних ASIC: Маєте свій спеціалізований прискорювач? Без проблем. Партнери можуть додавати чіплети MVLink для підключення свого кастомного кремнію до екосистеми NVIDIA. Це ніби NVIDIA каже: "Будуйте будь-яке спеціалізоване обладнання, яке хочете — просто переконайтеся, що воно може спілкуватися з нашими речами."

-

Інтеграція кастомних CPU: Постачальники CPU теж не залишені осторонь. Вони можуть безпосередньо впроваджувати інтерфейси chip-to-chip MVLink, створюючи прямий шлях між своїми процесорами та GPU Blackwell (або майбутньою архітектурою Ruben). MVLink — це величезна можливість для компаній, що інвестували в конкретні архітектури CPU.

Анонси партнерів охоплюють всю напівпровідникову індустрію:

- Партнери з реалізації кремнію: LCHIP, Astera Labs, Marll, MediaTek

- Постачальники CPU: Fujitsu, Qualcomm

- Постачальники EDA: Cadence, Synopsis

Цей підхід стратегічно позиціонує NVIDIA для захоплення вартості незалежно від конкретного обладнання, яке розгортають клієнти, відображаючи відверте заяву Huang: "Ніщо не приносить мені більше радості, ніж коли ви купуєте все від NVIDIA. Хочу, щоб ви, хлопці, це знали. Але мені приносить величезну радість, якщо ви купуєте щось від NVIDIA."

Розгортання корпоративного AI: RTX Pro Enterprise та Omniverse Server

RTX Pro Enterprise та сервер Omniverse представляють найзначнішу корпоративну обчислювальну пропозицію NVIDIA, спеціально розроблену для інтеграції AI-можливостей у традиційні IT-середовища:

- Повністю x86-сумісна архітектура

- Підтримка традиційних гіпервізорів (VMware, Red Hat, Nanix)

- Інтеграція Kubernetes для знайомої оркестрації робочих навантажень

- GPU Blackwell RTX Pro 6000s (8 на сервер)

- Мережевий чіп CX8, що забезпечує пропускну здатність 800 Гб/с

- 1.7x підвищення продуктивності порівняно з Hopper H100

- 4x продуктивність на оптимізованих моделях як Deepseek R1

Система встановлює новий рівень продуктивності для AI-висновків, вимірюваний у двовимірній структурі пропускної здатності (токенів за секунду) та відповідальності (токенів за секунду на користувача) — критичні метрики для того, що Huang описує як ера "масштабування часу висновків" або "мислячого AI".

Платформа AI-даних: переосмислення зберігання для неструктурованих даних

Платформа AI-даних NVIDIA представляє принципово інший підхід до корпоративного зберігання:

"Люди запитують структуровані бази даних як SQL... Але AI хоче запитувати неструктуровані дані. Вони хочуть семантику. Вони хочуть значення. І тому ми повинні створити новий тип платформи зберігання."

Ключові компоненти включають:

- NVIDIA AIQ (або IQ): семантичний шар запитів

- Вузли зберігання з прискоренням GPU, що замінюють традиційні CPU-центричні архітектури

- Пост-тренованi AI-моделі з прозорим походженням тренувальних даних

- 15x швидші запити з 50% покращеними результатами порівняно з існуючими рішеннями

Партнери індустрії зберігання, що впроваджують цю архітектуру, включають Dell, Hitachi, IBM, NetApp та Vast, створюючи комплексну екосистему управління корпоративними AI-даними.

AI-операції та робототехніка: програмні фреймворки для інтелектуального підприємства

Презентація представила два важливі програмні фреймворки:

-

AI-операції (AIOps): комплексний стек для управління AI-агентами в корпоративних контекстах, включаючи курацію даних, тонке налаштування моделей, оцінку, захисні механізми та безпеку. Партнери включають Crowdstrike, Data IQ, Data Robots, Elastic, Newonix, Red Hat та Trend Micro.

-

Платформа Isaac Groot N1.5: екосистема розробки робототехніки з відкритим кодом, включаючи:

Фізичний двигун Newton (розроблений з Google DeepMind та Disney Research)

- Процесор робототехніки Jetson Thor

- Операційна система NVIDIA Isaac

- Blueprint NVIDIA Groot Dreams для генерації синтетичних даних траєкторії

Ініціатива робототехніки вирішує критичний виклик: "Щоб робототехніка відбулася, потрібен AI. Але щоб навчити AI, потрібен AI." Цей рекурсивний шаблон оптимізації використовує генеративний AI для розширення обмежених даних людських демонстрацій у комплексні тренувальні набори робототехніки.

Стратегічна позиція Тайваню в AI-виробничій революції

Значна частина презентації підкреслила ключову роль Тайваню як у виробництві, так і у впровадженні AI-технологій:

- Тайванські виробничі компанії (TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, Wiiwin, Gigabyte) розгортають NVIDIA Omniverse для впровадження цифрових двійників.

- TSMC використовує AI-інструменти на CUDA для оптимізації планування fab та систем трубопроводів

- Виробничі партнери використовують цифрові двійники для віртуального планування та прогнозного обслуговування, а також як "спортзали роботів" для тренування робототехнічних систем.

- Foxconn, TSMC, тайванський уряд та NVIDIA будують перший великомасштабний AI-суперкомп'ютер Тайваню.

Huang далі зміцнив зобов'язання NVIDIA щодо регіону, анонсувавши плани для "NVIDIA Constellation," нового комплексу штаб-квартири в Тайбеї.

Технічний аналіз: що це означає для корпоративної AI-стратегії

Ці анонси в сукупності представляють комплексне переосмислення корпоративних обчислень з кількома стратегічними наслідками:

-

Вимоги обчислювального масштабу: вимоги продуктивності inference-time "міркуючого AI" та агентських систем будуть стимулювати значно вищі обчислювальні вимоги, ніж початкові розгортання великих мовних моделей, що потребує архітектурного планування для масивних можливостей scale-up та scale-out.

-

Дисагрегація корпоративного AI: екосистема MVLink Fusion дозволяє безпрецедентну гнучкість у побудові гетерогенних AI-систем, потенційно прискорюючи прийняття спеціалізованих AI-прискорювачів, зберігаючи при цьому позицію NVIDIA в екосистемі через технології взаємозв'язків.

-

Зрушення від центрів обробки даних до AI-фабрик: нам потрібно повністю переосмислити, як ми вимірюємо вартість наших інвестицій в інфраструктуру. Минули дні, коли сировинна обчислювальна потужність або ємність зберігання розповідали всю історію. Тепер все про виробництво токенів — скільки одиниць AI-виходу можуть генерувати ваші системи за секунду, за ват та долар? Jensen не жартував, коли сказав, що компанії скоро будуть звітувати про своє виробництво токенів, як виробничі метрики. Зрушення до AI-фабрик кардинально перепише економіку того, як ми розгортаємо та виправдовуємо витрати на AI-інфраструктуру.

-

Інтеграція цифрових двійників: той факт, що кожен великий тайванський виробник будує цифрових двійників Omniverse, говорить нам все, що потрібно знати — це вже не просто крута технічна демонстрація. Цифрові двійники стали важливою інфраструктурою для компаній, серйозних щодо оптимізації. Особливо захоплююче те, як це створює петлю зворотного зв'язку: компанії будують цифрових двійників для оптимізації фізичних процесів, потім використовують ті самі середовища для тренування AI та робототехніки, далі покращуючи фізичний світ. Це цикл безперервного покращення, який продовжує прискорюватися.

-

Планування робототехнічної робочої сили: конвергенція агентського AI та фізичної робототехніки передбачає, що організації повинні розробити інтегровані стратегії цифрової та фізичної автоматизації з значними наслідками для планування робочої сили та проектування приміщень.

-

Програмно-визначена інфраструктура: незважаючи на анонси обладнання, постійний акцент NVIDIA на бібліотеках та програмних фреймворках підтверджує, що конкурентна перевага в AI буде надходити від оптимізації програмного забезпечення так само, як від сировинних апаратних можливостей.

Навігація переходу до AI-фабрики

Трансформація традиційних центрів обробки даних у AI-фабрики потребує спеціалізованої експертизи, що поєднує розгортання обладнання, оптимізацію програмного забезпечення та архітектурне проектування. В Introl ми впроваджуємо ці передові рішення GPU-інфраструктури для підприємств, що стрибають у AI-first обчислення. Глибокий досвід нашої команди з екосистемою NVIDIA — від складних розгортань MVLink до впроваджень цифрових двійників Omniverse — допомагає організаціям навігувати цей парадигмальний зсув без крутої кривої навчання, зазвичай пов'язаної з передовою інфраструктурою. Чи то масштабування можливостей міркуючого AI, чи побудова вашої першої підлоги AI-фабрики, партнерство зі спеціалістами може драматично прискорити ваш time-to-value у цьому швидко розвиваючомуся ландшафті. Готові **зробити це? Налаштуйте дзвінок сьогодні.

Висновок: третя ера обчислень прибула

Computex був не просто показом швидших чіпів від NVIDIA. Те, що виклав Jensen, вийшло за межі звичних анонсів "на 20% краще за минулий рік", до яких ми заніміли. Він кардинально переосмислює, для чого призначені комп'ютери. Ми провели десятиліття, будуючи машини, що обробляють числа та переміщують дані. Тепер NVIDIA будує системи, що виробляють інтелект як їх основний вихід. Це як порівнювати картотеку з мозком. Звісно, обидва зберігають інформацію, але один просто сидить там, поки інший створює нові ідеї. Зсув може звучати як семантика, поки ви не зрозумієте, що це змінює все про те, як ми будуємо, розгортаємо та вимірюємо обчислювальні системи.

"Вперше за весь наш спільний час ми не тільки створюємо наступне покоління IT, а ми це робили кілька разів, від PC до інтернету до хмари до мобільної хмари. Ми робили це кілька разів. Але цього разу ми не тільки створюємо наступне покоління IT, ми створюємо цілком нову індустрію."

Цей перехід представляє третій великий парадигмальний зсув у обчисленнях, слідуючи за революцією персональних комп'ютерів та ерою інтернету/хмари. Організації, що інтегрують ці можливості AI-інфраструктури, швидше за все встановлять непереборні конкурентні переваги у всіх галузях.

Фабрики обчислювального інтелекту будуються сьогодні. Питання вже не в тому, чи трансформує AI бізнес — а в тому, чи будує ваша організація інфраструктуру для збереження конкурентоспроможності у світі, де обчислювальний інтелект стає таким же фундаментальним для бізнес-операцій, як електрика.

Посилання та додаткові ресурси

-

Офіційний огляд архітектури NVIDIA Blackwell: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

-

Технічна документація NVIDIA MVLink: https://developer.nvidia.com/mvlink

-

Платформа NVIDIA Omniverse: https://www.nvidia.com/en-us/omniverse/

-

Платформа робототехніки Isaac: https://developer.nvidia.com/isaac-ros

-

NVIDIA AI Enterprise: https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

-

Офіційні прес-матеріали NVIDIA Computex 2025: https://nvidianews.nvidia.com/news/computex-2025

-

Огляд бібліотек NVIDIA CUDA-X: https://developer.nvidia.com/gpu-accelerated-libraries

-

Системи NVIDIA DGX: https://www.nvidia.com/en-us/data-center/dgx-systems/