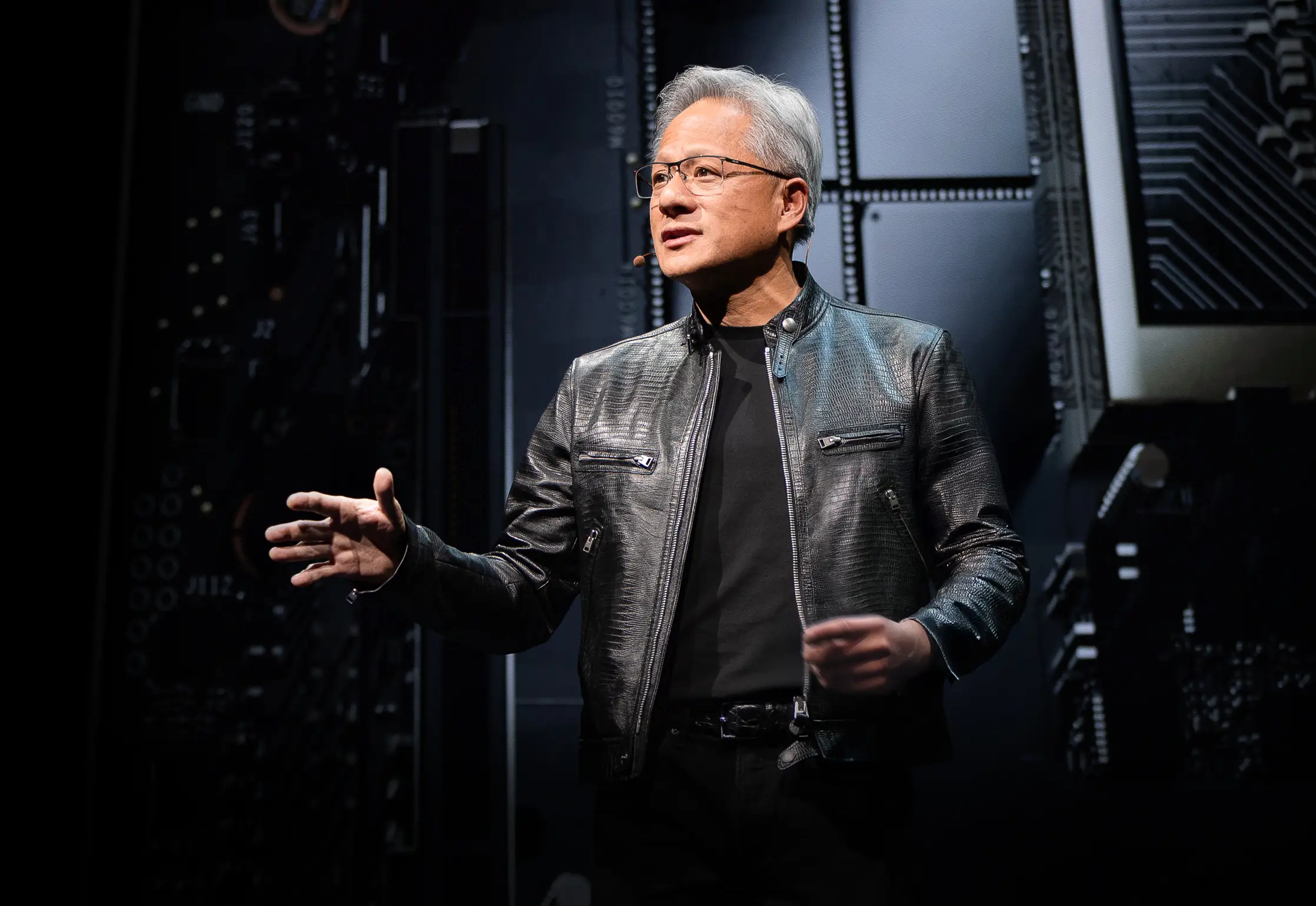

O CEO da NVIDIA Jensen Huang subiu ao palco da Computex 2025 vestindo sua característica jaqueta de couro e revelou novos hardwares e um paradigma de computação completamente reimaginado. A gigante de semicondutores se transformou decisivamente em uma empresa de infraestrutura de AI, construindo as fundações para o que Huang chama de "a infraestrutura da inteligência" — a terceira grande revolução de infraestrutura após a eletricidade e a internet.

Este keynote não foi apenas mais um anúncio de produto — foi Jensen apresentando o blueprint da NVIDIA para reformular o cenário da computação. Os saltos técnicos, mudanças estratégicas e jogadas de mercado que ele revelou provavelmente farão desta a Computex que referenciaremos por anos. Assista o keynote completo da Nvidia na Computex 2025.

Evolução Estratégica da NVIDIA: De Placas Gráficas a Provedora de Infraestrutura

A história de transformação da NVIDIA é impressionante. Em 1993, Jensen viu uma "oportunidade de chip de $300 milhões" — um mercado substancial. Avançando para hoje, ele comanda um gigante de infraestrutura de AI de um trilhão de dólares. Esse tipo de crescimento explosivo não acontece por acaso — a NVIDIA se reinventou fundamentalmente várias vezes ao longo do caminho.

Durante seu keynote, Jensen destacou os pontos de virada que tornaram possível a NVIDIA de hoje:

-

2006: CUDA chegou e revolucionou a computação paralela. De repente, desenvolvedores que nunca consideraram usar GPUs para computação geral estavam construindo aplicações que teriam sido impossíveis em CPUs tradicionais.

-

2016: O DGX1 surgiu como o primeiro sistema da NVIDIA sem compromissos, focado em AI. No que agora parece uma premonição quase assombrada, Jensen doou a primeira unidade para a OpenAI, efetivamente dando a eles a fundação computacional que eventualmente levaria à nossa atual revolução de AI.

-

2019: A aquisição da Mellanox, permitindo à NVIDIA reconceitualizar data centers como unidades computacionais unificadas

Esta transformação culmina na posição atual da NVIDIA como "uma empresa de infraestrutura essencial" — um status que Huang enfatizou ao destacar seus roadmaps públicos de cinco anos sem precedentes, que permitem planejamento global de infraestrutura para deployment de AI.

Redefinindo Métricas de Performance: A Economia dos Tokens

A NVIDIA introduziu uma mudança fundamental na forma como medimos saída computacional. Em vez de métricas tradicionais como FLOPs ou operações por segundo, Huang posicionou data centers de AI como fábricas produzindo "tokens" — unidades de inteligência computacional:

"Empresas estão começando a falar sobre quantos tokens elas produziram no último trimestre e quantos tokens elas produziram no mês passado. Muito em breve, discutiremos quantos tokens produzimos a cada hora, assim como toda fábrica faz."

Esta reformulação conecta diretamente investimento computacional e saída de negócio, alinhando infraestrutura de AI com frameworks industriais tradicionais. O modelo posiciona a NVIDIA no epicentro de um novo paradigma econômico onde eficiência computacional se traduz diretamente em capacidade de negócio.

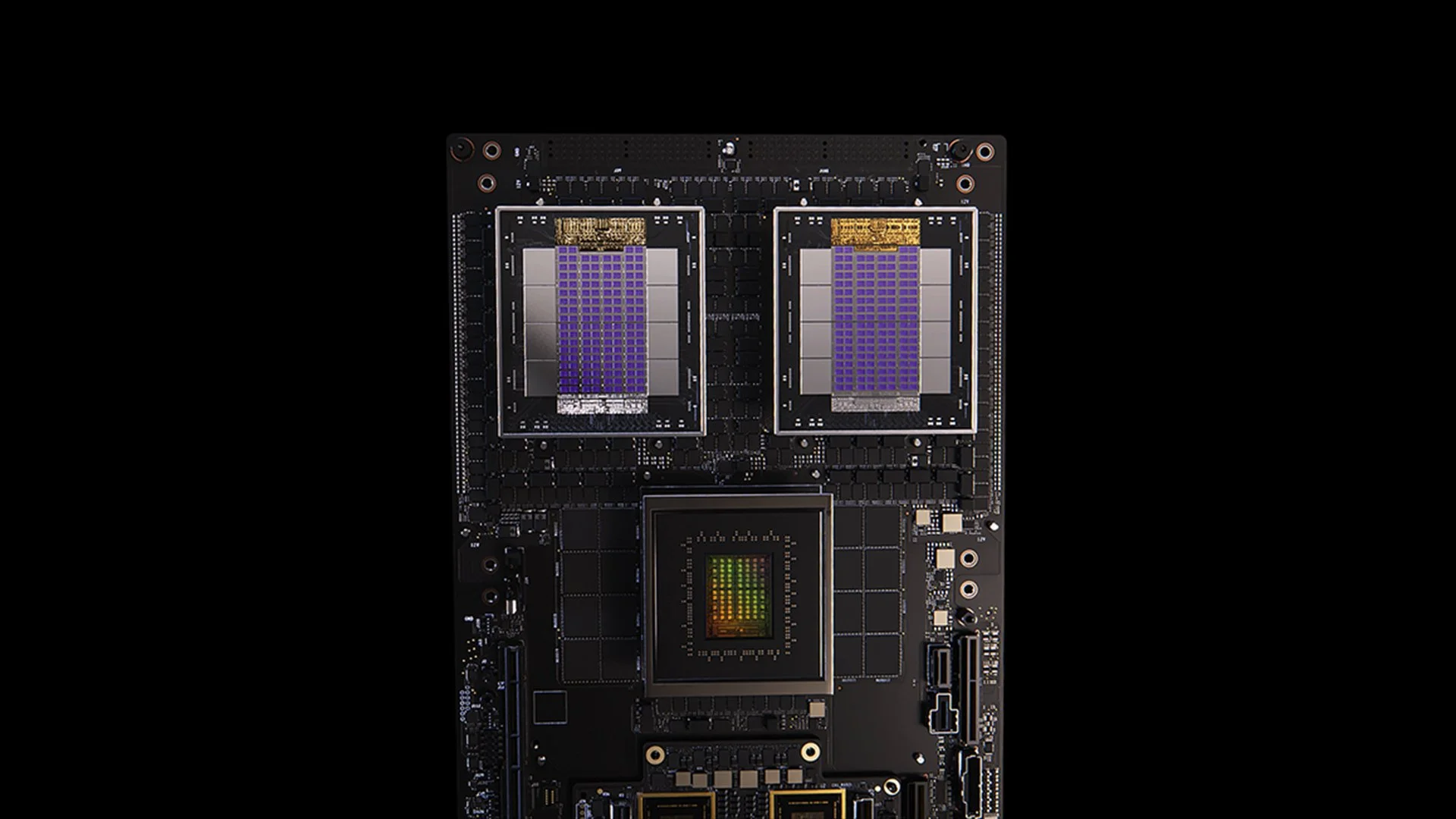

Atualizações da Arquitetura Blackwell: Especificações e Métricas de Performance do GB300

[caption id="" align="alignnone" width="1280"] Sistema GB200 [/caption]

Sistema GB200 [/caption]

A atualização GB300 da arquitetura Blackwell exemplifica o ciclo implacável de melhoria de performance da NVIDIA. Programado para Q3 2025, o GB300 entrega:

-

1.5x boost de performance de inferência sobre o GB200

-

1.5x aumento de capacidade de memória HBM

-

2x melhoria na largura de banda de rede

-

Design totalmente resfriado a líquido

-

Totalmente compatível com chassis e sistemas existentes

Cada nó GB300 entrega aproximadamente 40 petaflops — efetivamente substituindo todo o supercomputador Sierra (circa 2018), que requeria 18.000 GPUs Volta. Este ganho de performance de 4.000x em seis anos supera vastamente o escalonamento tradicional da Lei de Moore, demonstrando a abordagem multifacetada da NVIDIA para aceleração de performance através de arquitetura, software e inovações de interconexão.

MVLink: Redefinindo a Tecnologia de Interconexão

MVLink representa o avanço mais significativo na tecnologia de interconexão de GPU desde a introdução do NVLink. O sistema permite desagregação completa de recursos computacionais em um rack inteiro, transformando 72 GPUs (144 dies de GPU) em uma única unidade computacional massiva.

As especificações técnicas são impressionantes:

-

Switches MVLink individuais: largura de banda de 7.2 TB/s

-

Spine MVLink: largura de banda all-to-all de 130 TB/s

-

Implementação física: 5.000 cabos coaxiais precisamente ajustados em comprimento (aproximadamente 2 milhas no total)

-

Densidade de energia: 120 quilowatts por rack (necessitando resfriamento líquido)

Para contexto, Huang notou que o tráfego de pico de toda a internet é aproximadamente 900 terabits por segundo (112.5 TB/s), fazendo um único spine MVLink capaz de lidar com mais tráfego que toda a internet global na capacidade de pico.

MVLink Fusion: Criando um Ecossistema Aberto de Infraestrutura de AI

MVLink Fusion pode ser a jogada de ecossistema mais inovadora que a NVIDIA fez em anos. Em vez de forçar parceiros a apostar tudo no hardware NVIDIA, eles estão abrindo a arquitetura para deixar empresas construírem sistemas de AI semi-customizados que ainda se conectam ao universo NVIDIA.

A abordagem é surpreendentemente flexível:

-

Integração de ASIC Customizado: Tem seu acelerador especializado? Sem problema. Parceiros podem colocar chiplets MVLink para conectar seu silício customizado ao ecossistema da NVIDIA. É como se a NVIDIA estivesse dizendo: "Construam qualquer hardware especializado que quiserem — apenas certifiquem-se de que pode falar com nossos produtos."

-

Integração de CPU Customizada: Fornecedores de CPU também não ficam de fora. Eles podem implementar diretamente as interfaces chip-to-chip do MVLink, criando uma rodovia direta entre seus processadores e GPUs Blackwell (ou a arquitetura Ruben que vem por aí). MVLink é enorme para empresas investidas em arquiteturas de CPU específicas.

Anúncios de parceiros abrangem a indústria de semicondutores:

-

Parceiros de implementação de silício: LCHIP, Astera Labs, Marll, MediaTek

-

Fornecedores de CPU: Fujitsu, Qualcomm

-

Provedores de EDA: Cadence, Synopsis

Esta abordagem posiciona estrategicamente a NVIDIA para capturar valor independentemente do mix específico de hardware que clientes implementem, refletindo a declaração franca de Huang: "Nada me dá mais alegria do que quando vocês compram tudo da NVIDIA. Quero que vocês saibam disso. Mas me dá tremenda alegria se vocês compram algo da NVIDIA."

Deployment de AI Empresarial: RTX Pro Enterprise e Omniverse Server

O RTX Pro Enterprise e servidor Omniverse representam a oferta computacional mais significativa focada em empresas da NVIDIA, projetada especificamente para integrar capacidades de AI em ambientes de TI tradicionais:

-

Arquitetura totalmente compatível com x86

-

Suporte para hypervisors tradicionais (VMware, Red Hat, Nanix)

-

Integração Kubernetes para orquestração familiar de workloads

-

GPUs Blackwell RTX Pro 6000s (8 por servidor)

-

Chip de rede CX8 fornecendo largura de banda de 800 Gb/s

-

1.7x aumento de performance versus Hopper H100

-

4x performance em modelos otimizados como Deepseek R1

O sistema estabelece um novo envelope de performance para inferência de AI, medido em um framework de eixo duplo de throughput (tokens por segundo) e responsividade (tokens por segundo por usuário) — métricas críticas para o que Huang descreve como a era do "escalonamento de tempo de inferência" ou "AI pensante."

Plataforma de Dados de AI: Reimaginando Armazenamento para Dados Não Estruturados

A Plataforma de Dados de AI da NVIDIA introduz uma abordagem fundamentalmente diferente para armazenamento empresarial:

"Humanos fazem queries em bancos de dados estruturados como SQL... Mas AI quer fazer query em dados não estruturados. Eles querem semântico. Eles querem significado. E então temos que criar um novo tipo de plataforma de armazenamento."

Componentes principais incluem:

-

NVIDIA AIQ (ou IQ): Uma camada de query semântica

-

Nós de armazenamento acelerados por GPU substituindo arquiteturas tradicionais centradas em CPU

-

Modelos de AI pós-treinados com proveniência transparente de dados de treinamento

-

15x consultas mais rápidas com 50% melhores resultados comparado a soluções existentes

Parceiros da indústria de armazenamento implementando esta arquitetura incluem Dell, Hitachi, IBM, NetApp e Vast, criando um ecossistema empresarial abrangente de gerenciamento de dados de AI.

Operações de AI e Robótica: Frameworks de Software para a Empresa Inteligente

O keynote introduziu dois frameworks de software cruciais:

-

Operações de AI (AIOps): Uma stack abrangente para gerenciar agentes de AI em contextos empresariais, incluindo curadoria de dados, fine-tuning de modelos, avaliação, guardrails e segurança. Parceiros incluem Crowdstrike, Data IQ, Data Robots, Elastic, Newonix, Red Hat e Trend Micro.

-

Plataforma Isaac Groot N1.5: Um ecossistema de desenvolvimento robótico open-source incluindo:

Motor de física Newton (desenvolvido com Google DeepMind e Disney Research)

-

Processador robótico Jetson Thor

-

Sistema operacional NVIDIA Isaac

-

Blueprint Groot Dreams para geração de dados de trajetória sintética

A iniciativa robótica aborda um desafio crítico: "Para robótica acontecer, você precisa de AI. Mas para ensinar a AI, você precisa de AI." Este padrão de otimização recursiva aproveita AI generativa para expandir dados limitados de demonstração humana em conjuntos abrangentes de treinamento robótico.

Posição Estratégica de Taiwan na Revolução de Manufatura de AI

Uma porção significativa do keynote destacou o papel fundamental de Taiwan tanto na produção quanto na implementação de tecnologias de AI:

-

Empresas manufatureiras taiwanesas (TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, Wiiwin, Gigabyte) estão implementando NVIDIA Omniverse para implementações de gêmeo digital.

-

TSMC está usando ferramentas alimentadas por AI em CUDA para otimizar layouts de fábrica e sistemas de tubulação

-

Parceiros de manufatura usam gêmeos digitais para planejamento virtual e manutenção preditiva e como "academias de robôs" para treinar sistemas robóticos.

-

Foxconn, TSMC, o governo taiwanês e NVIDIA estão construindo o primeiro supercomputador de AI em larga escala de Taiwan.

Huang cimentou ainda mais o comprometimento da NVIDIA com a região ao anunciar planos para "NVIDIA Constellation," uma nova instalação de sede em Taipei.

Análise Técnica: O Que Isto Significa para Estratégia de AI Empresarial

Estes anúncios representam coletivamente uma reimaginação abrangente da computação empresarial com várias implicações estratégicas:

-

Requisitos de Escala Computacional: As demandas de performance de tempo de inferência de "AI de raciocínio" e sistemas agênticos dirigirão requisitos de computação significativamente maiores que deployments iniciais de modelos de linguagem grandes, necessitando planejamento arquitetural para capacidades massivas de scale-up e scale-out.

-

Desagregação de AI Empresarial: O ecossistema MVLink Fusion permite flexibilidade sem precedentes na construção de sistemas de AI heterogêneos, potencialmente acelerando a adoção de aceleradores de AI especializados enquanto mantém a posição da NVIDIA no ecossistema através de tecnologia de interconexão.

-

Mudança de Data Centers para Fábricas de AI: Precisamos repensar completamente como medimos o valor de nossos investimentos em infraestrutura. Acabaram os dias quando capacidade bruta de computação ou armazenamento contava toda a história. Agora é tudo sobre produção de tokens — quantas unidades de saída de AI seus sistemas podem gerar por segundo, por watt e por dólar? Jensen não estava brincando quando disse que empresas logo reportariam sua produção de tokens, como métricas de manufatura. A mudança para fábricas de AI reescreverá fundamentalmente a economia de como implementamos e justificamos gastos de infraestrutura de AI.

-

Integração de Gêmeo Digital: O fato de que todos os principais fabricantes taiwaneses estão construindo gêmeos digitais Omniverse nos diz tudo o que precisamos saber — isso não é mais apenas uma demonstração tecnológica legal. Gêmeos digitais se tornaram infraestrutura essencial para empresas sérias sobre otimização. O que é particularmente fascinante é como isso cria um loop de feedback: empresas constroem gêmeos digitais para otimizar processos físicos, então usam esses mesmos ambientes para treinar AI e robótica, melhorando ainda mais o mundo físico. É um ciclo de melhoria contínua que continua acelerando.

-

Planejamento de Força de Trabalho Robótica: A convergência de AI agêntica e robótica física sugere que organizações devem desenvolver estratégias integradas de automação digital e física, com implicações significativas para planejamento de força de trabalho e design de instalações.

-

Infraestrutura Definida por Software: Apesar dos anúncios de hardware, a ênfase contínua da NVIDIA em bibliotecas e frameworks de software reforça que vantagem competitiva em AI virá da otimização de software tanto quanto de capacidades brutas de hardware.

Navegando a Transição da Fábrica de AI

Transformar data centers tradicionais em fábricas de AI requer expertise especializada que conecta deployment de hardware, otimização de software e design arquitetural. Na Introl, temos implementado essas soluções avançadas de infraestrutura de GPU para empresas saltando para computação AI-first. A experiência profunda da nossa equipe com o ecossistema da NVIDIA — de deployments complexos de MVLink a implementações de gêmeos digitais Omniverse — ajuda organizações a navegar esta mudança de paradigma sem a curva de aprendizado íngreme tipicamente associada com infraestrutura de ponta. Seja escalando capacidades de AI de raciocínio ou construindo seu primeiro chão de fábrica de AI, fazer parceria com especialistas pode acelerar dramaticamente seu tempo-para-valor nesta paisagem em rápida evolução. Pronto para **fazer acontecer? Agende uma call hoje.

Conclusão: A Terceira Era da Computação Chegou

A Computex não foi apenas a NVIDIA mostrando chips mais rápidos. O que Jensen apresentou foi além dos usuais anúncios de "20% melhor que o ano passado" aos quais nos acostumamos. Ele está fundamentalmente reformulando para que servem os computadores. Passamos décadas construindo máquinas que processam números e movem dados. Agora, a NVIDIA está construindo sistemas que manufaturam inteligência como sua saída primária. É como comparar um arquivo a um cérebro. Claro, ambos armazenam informação, mas um fica parado enquanto o outro cria novas ideias. A mudança pode soar como semântica até você perceber que muda tudo sobre como construímos, implementamos e medimos sistemas computacionais.

"Pela primeira vez em todo o nosso tempo juntos, não apenas estamos criando a próxima geração de TI, mas também fizemos isso várias vezes, de PC para internet para nuvem para nuvem móvel. Fizemos isso várias vezes. Mas desta vez, não apenas estamos criando a próxima geração de TI, estamos criando uma indústria completamente nova."

Esta transição representa a terceira grande mudança de paradigma computacional, seguindo a revolução da computação pessoal e a era internet/nuvem. Organizações integrando essas capacidades de infraestrutura de AI provavelmente estabelecerão vantagens competitivas insuperáveis através de indústrias.

As fábricas de inteligência computacional estão sendo construídas hoje. A questão não é mais se a AI transformará negócios — é se sua organização está construindo a infraestrutura para permanecer competitiva em um mundo onde inteligência computacional se torna tão fundamental para operações de negócio quanto eletricidade.

Referências e Recursos Adicionais

-

Visão Geral Oficial da Arquitetura Blackwell da NVIDIA: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

-

Documentação Técnica NVIDIA MVLink: https://developer.nvidia.com/mvlink

-

Plataforma NVIDIA Omniverse: https://www.nvidia.com/en-us/omniverse/

-

Plataforma Isaac Robotics: https://developer.nvidia.com/isaac-ros

-

NVIDIA AI Enterprise: https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

-

Materiais de Imprensa Oficiais NVIDIA Computex 2025: https://nvidianews.nvidia.com/news/computex-2025

-

Visão Geral das Bibliotecas NVIDIA CUDA-X: https://developer.nvidia.com/gpu-accelerated-libraries

-

Sistemas NVIDIA DGX: https://www.nvidia.com/en-us/data-center/dgx-systems/