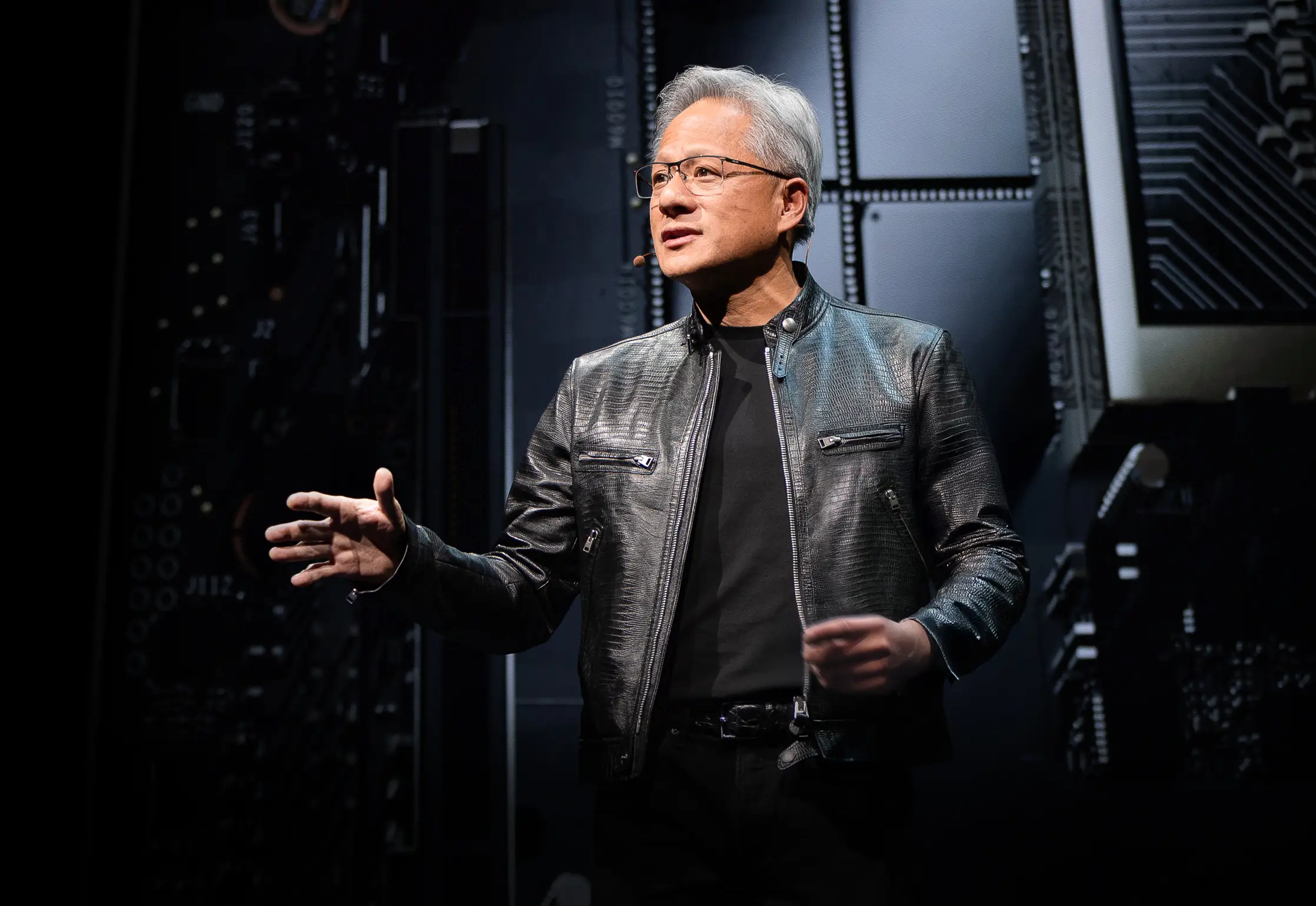

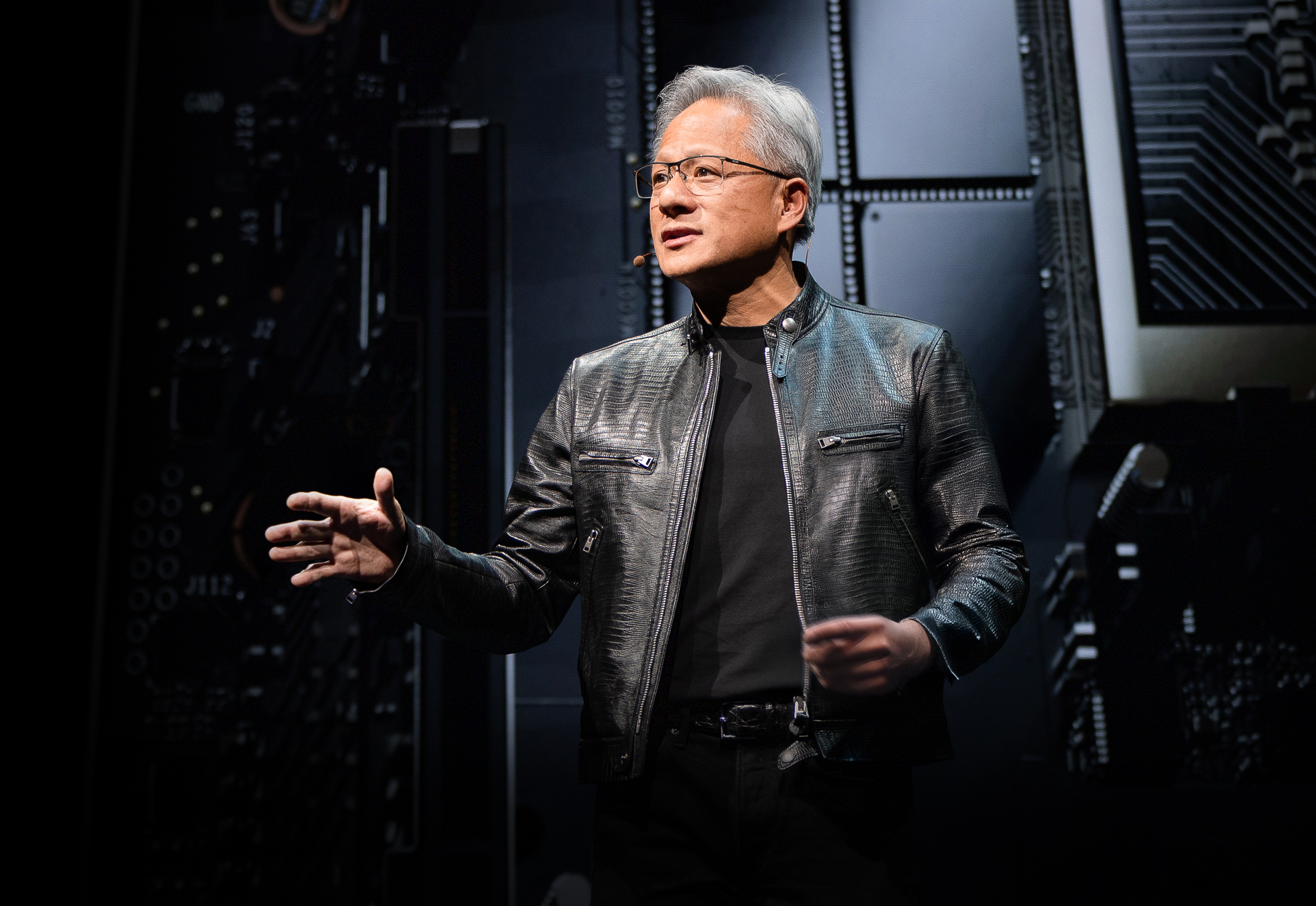

CEO ของ NVIDIA Jensen Huang ขึ้นเวทีในงาน Computex 2025 ในเสื้อแจ็คเก็ตหนังลายเซ็นของเขา และเปิดตัวฮาร์ดแวร์ใหม่พร้อมกับกระบวนทัศน์คอมพิวเตอร์ที่ได้รับการออกแบบใหม่อย่างสิ้นเชิง บริษัทยักษ์ใหญ่ด้านเซมิคอนดักเตอร์ได้เปลี่ยนผ่านอย่างเด็ดขาดเป็นบริษัทโครงสร้างพื้นฐาน AI โดยสร้างรากฐานสำหรับสิ่งที่ Huang เรียกว่า "โครงสร้างพื้นฐานของสติปัญญา"—การปฏิวัติโครงสร้างพื้นฐานครั้งใหญ่ครั้งที่สาม รองจากไฟฟ้าและอินเทอร์เน็ต

งานนำเสนอครั้งนี้ไม่ใช่แค่การประกาศผลิตภัณฑ์ใหม่อีกครั้ง—แต่เป็น Jensen ที่วางแผนพิมพ์เขียวของ NVIDIA เพื่อปรับโฉมภูมิทัศน์คอมพิวเตอร์ การก้าวกระโดดทางเทคนิค การหมุนเวียนเชิงกลยุทธ์ และการเคลื่อนไหวในตลาดที่เขาเปิดเผยนั้นมีแนวโน้มที่จะทำให้งาน Computex นี้เป็นงานที่เราจะอ้างอิงเป็นปีๆ ดูการนำเสนอฉบับเต็ม Computex 2025 Nvidia keynote

วิวัฒนาการเชิงกลยุทธ์ของ NVIDIA: จากการ์ดกราฟิกสู่ผู้ให้บริการโครงสร้างพื้นฐาน

เรื่องราวการเปลี่ยนแปลงของ NVIDIA น่าทึ่งมาก ในปี 1993 Jensen เห็น "โอกาสชิป 300 ล้านดอลลาร์"—ตลาดที่มีขนาดใหญ่พอสมควร มาถึงปัจจุบัน และเขากำลังควบคุมจักรกลโครงสร้างพื้นฐาน AI มูลค่าล้านล้านดอลลาร์ การเติบโตแบบระเบิดนี้ไม่ได้เกิดขึ้นเอง—NVIDIA ได้คิดค้นตัวเองใหม่หลายครั้งระหว่างทาง

ในระหว่างการนำเสนอ Jensen เน้นจุดหักเหที่ทำให้ NVIDIA ในวันนี้เป็นไปได้:

-

2006: CUDA เปิดตัวและเปลี่ยนการประมวลผลแบบขนานอย่างสิ้นเชิง ทันใดนั้นนักพัฒนาที่ไม่เคยพิจารณาใช้ GPU สำหรับการประมวลผลทั่วไปก็สร้างแอปพลิเคชันที่เป็นไปไม่ได้บน CPU แบบดั้งเดิม

-

2016: DGX1 ปรากฏเป็นระบบที่เน้น AI โดยไม่มีการประนีประนอมครั้งแรกของ NVIDIA ในสิ่งที่ดูเหมือนการทำนายอนาคตที่แทบน่าขนลุก Jensen บริจาคเครื่องแรกให้กับ OpenAI โดยเท่านั้นให้พวกเขามีรากฐานการประมวลผลที่จะนำไปสู่การปฏิวัติ AI ในปัจจุบัน

-

2019: การซื้อกิจการ Mellanox ซึ่งทำให้ NVIDIA สามารถมองเซิร์ฟเวอร์เซ็นเตอร์ใหม่เป็นหน่วยประมวลผลแบบรวมเป็นหนึ่ง

การเปลี่ยนแปลงนี้สิ้นสุดด้วยตำแหน่งปัจจุบันของ NVIDIA ในฐานะ "บริษัทโครงสร้างพื้นฐานที่จำเป็น"—สถานะที่ Huang เน้นย้ำโดยเน้นแผนงานสาธารณะห้าปีที่ไม่เคยมีมาก่อน ซึ่งช่วยให้สามารถวางแผนโครงสร้างพื้นฐานระดับโลกสำหรับการปรับใช้ AI

การกำหนดดัชนีประสิทธิภาพใหม่: เศรษฐกิจโทเค็น

NVIDIA ได้แนะนำการเปลี่ยนแปลงพื้นฐานในวิธีที่เราวัดผลผลิตการประมวลผล แทนที่จะใช้ดัชนีแบบดั้งเดิมเช่น FLOPs หรือการดำเนินการต่อวินาที Huang วางตำแหน่งเซิร์ฟเวอร์เซ็นเตอร์ AI เป็นโรงงานที่ผลิต "โทเค็น"—หน่วยของสติปัญญาการประมวลผล:

"บริษัทต่างๆ เริ่มพูดถึงจำนวนโทเค็นที่พวกเขาผลิตไตรมาสที่แล้ว และจำนวนโทเค็นที่พวกเขาผลิตเดือนที่แล้ว ในไม่ช้าเราจะพูดถึงจำนวนโทเค็นที่เราผลิตทุกชั่วโมง เหมือนที่ทุกโรงงานทำ"

การทำนองใหม่นี้เชื่อมโยงการลงทุนด้านการประมวลผลและผลผลิตทางธุรกิจโดยตรง โดยจัดโครงสร้างพื้นฐาน AI ให้สอดคล้องกับกรอบอุตสาหกรรมแบบดั้งเดิม โมเดลนี้วาง NVIDIA ให้อยู่ในจุดศูนย์กลางของกระบวนทัศน์เศรษฐกิจใหม่ที่ประสิทธิภาพการประมวลผลแปลงเป็นความสามารถทางธุรกิจโดยตรง

อัปเกรดสถาปัตยกรรม Blackwell: ข้อมูลจำเพาะและดัชนีประสิทธิภาพ GB300

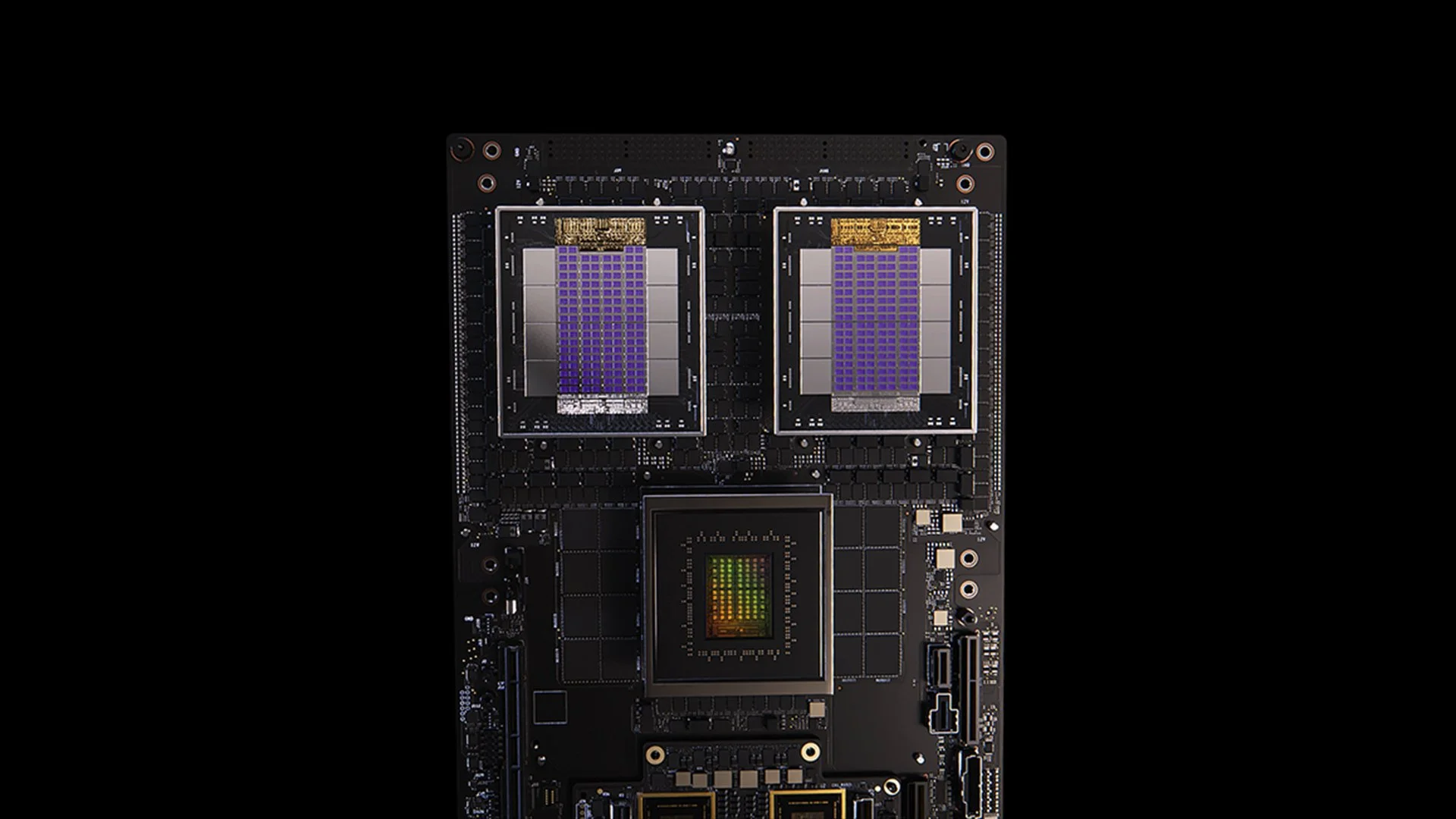

[caption id="" align="alignnone" width="1280"] ระบบ GB200 [/caption]

ระบบ GB200 [/caption]

การอัปเดต GB300 สำหรับสถาปัตยกรรม Blackwell แสดงให้เห็นถึงวงจรการปรับปรุงประสิทธิภาพอย่างไม่หยุดยั้งของ NVIDIA โดยกำหนดการในไตรมาสที่ 3 ปี 2025 GB300 ให้:

- เพิ่มประสิทธิภาพ inference 1.5 เท่าเมื่อเทียบกับ GB200

- เพิ่มความจุหน่วยความจำ HBM 1.5 เท่า

- ปรับปรุงแบนด์วิดธ์เครือข่าย 2 เท่า

- ออกแบบระบายความร้อนด้วยของเหลวทั้งหมด

- ใช้งานร่วมกับแชสซิสและระบบเดิมได้

แต่ละโหนด GB300 ให้ประมาณ 40 petaflops—ซึ่งมีประสิทธิภาพเทียบเท่าการแทนที่ซูเปอร์คอมพิวเตอร์ Sierra ทั้งหมด (ประมาณปี 2018) ซึ่งต้องการ Volta GPU 18,000 ตัว การเพิ่มประสิทธิภาพ 4,000 เท่าภายในหกปีนี้เร็วกว่า Moore's Law แบบดั้งเดิมมาก แสดงให้เห็นถึงแนวทางหลายแง่มุมของ NVIDIA ในการเร่งประสิทธิภาพผ่านสถาปัตยกรรม ซอฟต์แวร์ และนวัตกรรมการเชื่อมต่อ

MVLink: การกำหนดเทคโนโลยีเชื่อมต่อใหม่

MVLink แสดงถึงความก้าวหน้าที่สำคัญที่สุดในเทคโนโลยีเชื่อมต่อ GPU นับตั้งแต่การแนะนำ NVLink ระบบนี้ช่วยให้สามารถแยกทรัพยากรการประมวลผลอย่างสมบูรณ์ทั่วทั้งแร็ค โดยเปลี่ยน GPU 72 ตัว (144 GPU dies) ให้เป็นหน่วยประมวลผลขนาดใหญ่เครื่องเดียว

ข้อมูลจำเพาะทางเทคนิคน่าทึ่ง:

- สวิตช์ MVLink แต่ละตัว: แบนด์วิดธ์ 7.2 TB/s

- MVLink spine: แบนด์วิดธ์ all-to-all 130 TB/s

- การดำเนินการทางกายภาพ: สายโคแอกเซียลที่จับคู่ความยาวอย่างแม่นยำ 5,000 เส้น (รวมประมาณ 2 ไมล์)

- ความหนาแน่นของพลังงาน: 120 กิโลวัตต์ต่อแร็ค (จำเป็นต้องระบายความร้อนด้วยของเหลว)

สำหรับบริบท Huang ระบุว่าการจราจรสูงสุดของอินเทอร์เน็ททั้งหมดอยู่ที่ประมาณ 900 เทราบิตต่อวินาที (112.5 TB/s) ทำให้ MVLink spine เดียวสามารถจัดการการจราจรมากกว่าอินเทอร์เน็ตโลกในช่วงความจุสูงสุด

MVLink Fusion: การสร้างระบบนิเวศโครงสร้างพื้นฐาน AI แบบเปิด

MVLink Fusion อาจเป็นการเล่นระบบนิเวศที่เป็นนวัตกรรมมากที่สุดที่ NVIDIA เคยทำในหลายปี แทนที่จะบังคับให้พาร์ทเนอร์ลงทุนกับฮาร์ดแวร์ NVIDIA ทั้งหมด พวกเขาเปิดสถาปัตยกรรมให้บริษัทต่างๆ สร้างระบบ AI แบบกึ่งกำหนดเองที่ยังคงเชื่อมโยงกับจักรวาล NVIDIA

แนวทางนี้มีความยืดหยุ่นอย่างน่าแปลกใจ:

-

การรวม ASIC แบบกำหนดเอง: มีเครื่องเร่งเฉพาะของคุณเองไหม ไม่เป็นไร พาร์ทเนอร์สามารถใส่ chiplets MVLink เพื่อเชื่อมต่อซิลิคอนแบบกำหนดเองกับระบบนิเวศ NVIDIA เหมือน NVIDIA บอกว่า "สร้างฮาร์ดแวร์เฉพาะอะไรก็ได้ที่คุณต้องการ—แค่ให้แน่ใจว่ามันสามารถสื่อสารกับของเราได้"

-

การรวม CPU แบบกำหนดเอง: ผู้จำหน่าย CPU ก็ไม่ถูกทิ้งไว้เช่นกัน พวกเขาสามารถใช้อินเทอร์เฟซชิป-ต่อ-ชิปของ MVLink โดยตรง สร้างทางด่วนตรงระหว่างโปรเซสเซอร์ของพวกเขาและ Blackwell GPU (หรือสถาปัตยกรรม Ruben ที่กำลังจะมาถึง) MVLink มีความสำคัญอย่างมากสำหรับบริษัทที่ลงทุนในสถาปัตยกรรม CPU เฉพาะ

การประกาศพาร์ทเนอร์ครอบคลุมอุตสาหกรรมเซมิคอนดักเตอร์:

- พาร์ทเนอร์การใช้งานซิลิคอน: LCHIP, Astera Labs, Marll, MediaTek

- ผู้จำหน่าย CPU: Fujitsu, Qualcomm

- ผู้ให้บริการ EDA: Cadence, Synopsis

แนวทางนี้วาง NVIDIA ในตำแหน่งเชิงกลยุทธ์เพื่อจับค่าความสำคัญโดยไม่คำนึงถึงการผสมฮาร์ดแวร์เฉพาะที่ลูกค้าใช้งาน ซึ่งสะท้อนถึงคำพูดตรงไปตรงมาของ Huang: "ไม่มีอะไรให้ฉันมีความสุขมากไปกว่าตอนที่คุณซื้อทุกอย่างจาก NVIDIA ฉันอยากให้พวกคุณรู้เรื่องนั้น แต่มันให้ฉันมีความสุขอย่างมากถ้าคุณซื้ออะไรบางอย่างจาก NVIDIA"

การปรับใช้ AI สำหรับองค์กร: RTX Pro Enterprise และ Omniverse Server

RTX Pro Enterprise และเซิร์ฟเวอร์ Omniverse แสดงถึงข้อเสนอการประมวลผลที่เน้นองค์กรที่สำคัญที่สุดของ NVIDIA ที่ออกแบบมาเฉพาะเพื่อรวมความสามารถ AI เข้ากับสิ่งแวดล้อม IT แบบดั้งเดิม:

- สถาปัตยกรรมที่เข้ากันได้กับ x86 อย่างสมบูรณ์

- รองรับไฮเปอร์ไวเซอร์แบบดั้งเดิม (VMware, Red Hat, Nanix)

- การรวม Kubernetes สำหรับการจัดการ workload ที่คุ้นเคย

- Blackwell RTX Pro 6000s GPU (8 ตัวต่อเซิร์ฟเวอร์)

- ชิป CX8 networking ให้แบนด์วิดธ์ 800 Gb/s

- ปรับปรุงประสิทธิภาพ 1.7 เท่าเมื่อเทียบกับ Hopper H100

- ประสิทธิภาพ 4 เท่าบนโมเดลที่ได้รับการปรับแต่งเช่น Deepseek R1

ระบบนี้สร้างขอบเขตประสิทธิภาพใหม่สำหรับ AI inference โดยวัดในกรอบสองแกนของ throughput (โทเค็นต่อวินาที) และ responsiveness (โทเค็นต่อวินาทีต่อผู้ใช้)—ดัชนีสำคัญสำหรับสิ่งที่ Huang อธิบายเป็นยุคของ "inference time scaling" หรือ "thinking AI"

แพลตฟอร์มข้อมูล AI: การจินตนาการการจัดเก็บข้อมูลใหม่สำหรับข้อมูลที่ไม่มีโครงสร้าง

แพลตฟอร์มข้อมูล AI ของ NVIDIA แนะนำแนวทางที่แตกต่างพื้นฐานต่อการจัดเก็บขององค์กร:

"มนุษย์ค้นหาฐานข้อมูลที่มีโครงสร้างเช่น SQL... แต่ AI ต้องการค้นหาข้อมูลที่ไม่มีโครงสร้าง พวกเขาต้องการความหมาย พวกเขาต้องการความหมาย และดังนั้นเราต้องสร้างแพลตฟอร์มการจัดเก็บประเภทใหม่"

องค์ประกอบสำคัญรวมถึง:

- NVIDIA AIQ (หรือ IQ): เลเยอร์ query เชิงความหมาย

- โหนดจัดเก็บที่เร่งด้วย GPU แทนสถาปัตยกรรมที่เน้น CPU แบบดั้งเดิม

- โมเดล AI ที่ผ่านการฝึกอบรมแล้วพร้อมความโปร่งใสของข้อมูลฝึกอบรม

- การค้นหาเร็วขึ้น 15 เท่า พร้อมผลลัพธ์ที่ดีขึ้น 50% เมื่อเทียบกับโซลูชันที่มีอยู่

พาร์ทเนอร์อุตสาหกรรมการจัดเก็บที่ใช้สถาปัตยกรรมนี้รวมถึง Dell, Hitachi, IBM, NetApp และ Vast ซึ่งสร้างระบบนิเวศการจัดการข้อมูล AI สำหรับองค์กรอย่างครอบคลุม

การปฏิบัติการ AI และหุ่นยนต์: กรอบซอฟต์แวร์สำหรับองค์กรอัจฉริยะ

การนำเสนอได้แนะนำกรอบซอฟต์แวร์สำคัญสองตัว:

-

AI Operations (AIOps): สแต็คที่ครอบคลุมสำหรับการจัดการเอเจนต์ AI ในบริบทองค์กร รวมถึงการจัดการข้อมูล การปรับแต่งโมเดล การประเมิน การป้องกัน และความปลอดภัย พาร์ทเนอร์รวมถึง Crowdstrike, Data IQ, Data Robots, Elastic, Newonix, Red Hat และ Trend Micro

-

แพลตฟอร์ม Isaac Groot N1.5: ระบบนิเวศการพัฒนาหุ่นยนต์แบบเปิดแหล่งรวมถึง:

เอ็นจิน Newton physics (พัฒนาร่วมกับ Google DeepMind และ Disney Research)

- โปรเซสเซอร์หุ่นยนต์ Jetson Thor

- ระบบปฏิบัติการ NVIDIA Isaac

- พิมพ์เขียว Groot Dreams สำหรับการสร้างข้อมูลวิถีสังเคราะห์

ความคิดริเริ่มด้านหุ่นยนต์แก้ไขความท้าทายที่สำคัญ: "สำหรับหุ่นยนต์ที่จะเกิดขึ้น คุณต้องมี AI แต่เพื่อสอน AI คุณต้องมี AI" รูปแบบการปรับแต่งแบบเรียกซ้ำนี้ใช้ประโยชน์จาก generative AI เพื่อขยายข้อมูลการสาธิตของมนุษย์ที่จำกัดให้เป็นชุดข้อมูลฝึกอบรมหุ่นยนต์ที่ครอบคลุม

ตำแหน่งเชิงกลยุทธ์ของไต้หวันในการปฏิวัติการผลิต AI

ส่วนสำคัญของการนำเสนอเน้นบทบาทสำคัญของไต้หวันในทั้งการผลิตและการใช้เทคโนโลยี AI:

- บริษัทผลิตของไต้หวัน (TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, Wiiwin, Gigabyte) กำลังใช้งาน NVIDIA Omniverse สำหรับการใช้งาน digital twin

- TSMC ใช้เครื่องมือที่ขับเคลื่อนด้วย AI บน CUDA เพื่อปรับแต่งเลย์เอาต์โรงงานและระบบท่อ

- พาร์ทเนอร์การผลิตใช้ digital twins สำหรับการวางแผนเสมือนและการบำรุงรักษาเชิงพยากรณ์ และเป็น "ยิมหุ่นยนต์" สำหรับการฝึกอบรมระบบหุ่นยนต์

- Foxconn, TSMC, รัฐบาลไต้หวัน และ NVIDIA กำลังสร้างซูเปอร์คอมพิวเตอร์ AI ขนาดใหญ่เครื่องแรกของไต้หวัน

Huang ยืนยันความมุ่งมั่นของ NVIDIA ต่อภูมิภาคโดยประกาศแผนสำหรับ "NVIDIA Constellation" อาคารสำนักงานใหญ่แห่งใหม่ในไทเป

การวิเคราะห์เทคนิค: ความหมายต่อกลยุทธ์ AI ขององค์กร

การประกาศเหล่านี้รวมกันแสดงถึงการจินตนาการใหม่ที่ครอบคลุมของการประมวลผลขององค์กรพร้อมผลกระทบเชิงกลยุทธ์หลายประการ:

-

ความต้องการขนาดการประมวลผล: ความต้องการประสิทธิภาพ inference-time ของ "reasoning AI" และระบบ agentic จะขับเคลื่อนความต้องการการประมวลผลที่สูงกว่าการใช้งานโมเดลภาษาขนาดใหญ่ครั้งแรกอย่างมาก ซึ่งจำเป็นต้องมีการวางแผนสถาปัตยกรรมสำหรับความสามารถ scale-up และ scale-out ขนาดใหญ่

-

การแยก AI ขององค์กร: ระบบนิเวศ MVLink Fusion ช่วยให้มีความยืดหยุ่นที่ไม่เคยมีมาก่อนในการสร้างระบบ AI แบบผสมผสาน ซึ่งอาจเร่งการรับเอาเครื่องเร่ง AI เฉพาะในขณะที่ยังคงตำแหน่งของ NVIDIA ในระบบนิเวศผ่านเทคโนโลยีเชื่อมต่อ

-

การเปลี่ยนจากเซิร์ฟเวอร์เซ็นเตอร์สู่โรงงาน AI: เราต้องคิดใหม่ทั้งหมดเกี่ยวกับวิธีการวัดมูลค่าของการลงทุนโครงสร้างพื้นฐานของเรา หมดยุคที่ความจุการประมวลผลหรือการจัดเก็บดิบเล่าเรื่องทั้งหมดได้ ตอนนี้เป็นเรื่องของการผลิตโทเค็น—หน่วยผลผลิต AI กี่หน่วยที่ระบบของคุณสามารถสร้างต่อวินาที ต่อวัตต์ และดอลลาร์? Jensen ไม่ได้เล่นตลกเมื่อเขาบอกว่าบริษัทต่างๆ จะรายงานการผลิตโทเค็นเร็วๆ นี้ เช่นเดียวกับดัชนีการผลิต การเปลี่ยนไปสู่โรงงาน AI จะเขียนเศรษฐศาสตร์ของวิธีการปรับใช้และจัดการการใช้จ่ายโครงสร้างพื้นฐาน AI ใหม่โดยพื้นฐาน

-

การรวม Digital Twin: ความจริงที่ว่าผู้ผลิตชั้นนำของไต้หวันทุกรายกำลังสร้าง digital twins ของ Omniverse บอกเราทุกอย่างที่เราต้องรู้—นี่ไม่ใช่แค่การสาธิตเทคโนโลยีเจ๋งๆ อีกต่อไป Digital twins กลายเป็นโครงสร้างพื้นฐานที่จำเป็นสำหรับบริษัทที่จริงจังเกี่ยวกับการปรับแต่ง สิ่งที่น่าสนใจเป็นพิเศษคือวิธีที่สิ่งนี้สร้างลูปป้อนกลับ: บริษัทสร้าง digital twins เพื่อปรับแต่งกระบวนการทางกายภาพ จากนั้นใช้สภาพแวดล้อมเดียวกันนั้นเพื่อฝึก AI และหุ่นยนต์ ปรับปรุงโลกกายภาพต่อไป เป็นวงจรการปรับปรุงอย่างต่อเนื่องที่เร่งตัวต่อไป

-

การวางแผนกำลังคนหุ่นยนต์: การบรรจบกันของ agentic AI และหุ่นยนต์ทางกายภาพแนะนำให้องค์กรพัฒนากลยุทธ์อัตโนมัติดิจิทัลและกายภาพแบบบูรณาการ พร้อมผลกระทบที่สำคัญต่อการวางแผนกำลังคนและการออกแบบสิ่งอำนวยความสะดวก

-

โครงสร้างพื้นฐานที่กำหนดด้วยซอฟต์แวร์: แม้จะมีการประกาศฮาร์ดแวร์ แต่การเน้นย้ำของ NVIDIA ต่อไลบรารีและกรอบซอฟต์แวร์ยืนยันว่าความได้เปรียบทางการแข่งขันใน AI จะมาจากการปรับแต่งซอฟต์แวร์มากเท่าๆ กับความสามารถฮาร์ดแวร์ดิบ

การนำทางการเปลี่ยนผ่านโรงงาน AI

การเปลี่ยนแปลงเซิร์ฟเวอร์เซ็นเตอร์แบบดั้งเดิมเป็นโรงงาน AI ต้องการความเชี่ยวชาญเฉพาะที่เชื่อมโยงการปรับใช้ฮาร์ดแวร์ การปรับแต่งซอฟต์แวร์ และการออกแบบสถาปัตยกรรม ที่ Introl เราได้ใช้งานโซลูชันโครงสร้างพื้นฐาน GPU ขั้นสูงเหล่านี้สำหรับองค์กรที่ก้าวเข้าสู่การประมวลผลที่เน้น AI เป็นอันดับแรก ประสบการณ์อันลึกซึ้งของทีมเรากับระบบนิเวศของ NVIDIA—ตั้งแต่การปรับใช้ MVLink ที่ซับซ้อนไปจนถึงการใช้งาน digital twin ของ Omniverse—ช่วยให้องค์กรนำทางการเปลี่ยนแปลงกระบวนทัศน์นี้โดยไม่มีเส้นโค้งการเรียนรู้ที่ชันซึ่งมักเกี่ยวข้องกับโครงสร้างพื้นฐานที่ล้ำสมัย ไม่ว่าจะขยายความสามารถ reasoning AI หรือสร้างพื้นโรงงาน AI แห่งแรกของคุณ การเป็นพาร์ทเนอร์กับผู้เชี่ยวชาญสามารถเร่งเวลาสร้างมูลค่าของคุณในภูมิทัศน์ที่พัฒนาอย่างรวดเร็วนี้ได้อย่างมาก พร้อมที่จะ **ทำให้สำเร็จแล้วใช่ไหม? นัดหมายโทรศัพท์วันนี้

บทสรุป: ยุคที่สามของการประมวลผลมาถึงแล้ว

Computex ไม่ใช่แค่ NVIDIA โชว์ชิปที่เร็วขึ้น สิ่งที่ Jensen วางออกมาผ่านการประกาศ "ดีกว่าปีที่แล้ว 20%" ตามปกติที่เราเริ่มชินแล้ว เขากำลังเปลี่ยนกรอบพื้นฐานของสิ่งที่คอมพิวเตอร์มีไว้เพื่อ เราใช้เวลาหลายสิบปีสร้างเครื่องจักรที่ประมวลผลตัวเลขและย้ายข้อมูลไปมา ตอนนี้ NVIDIA กำลังสร้างระบบที่ผลิตสติปัญญาเป็นผลผลิตหลัก เหมือนการเปรียบเทียบตู้เอกสารกับสมอง แน่นอนทั้งคู่เก็บข้อมูล แต่อันหนึ่งอยู่นิ่งๆ ในขณะที่อีกอันสร้างความคิดใหม่ การเปลี่ยนแปลงอาจฟังดูเหมือนวาทศาสตร์จนกว่าคุณจะรู้ว่ามันเปลี่ยนทุกอย่างเกี่ยวกับวิธีที่เราสร้าง ปรับใช้ และวัดระบบการประมวลผล

"เป็นครั้งแรกในช่วงเวลาที่เราอยู่ด้วยกันทั้งหมด ไม่เพียงแต่เรากำลังสร้าง IT รุ่นต่อไป แต่เราได้ทำแบบนั้นหลายครั้งแล้ว จาก PC สู่อินเทอร์เน็ต สู่คลาวด์ สู่มือถือคลาวด์ เราได้ทำแบบนั้นหลายครั้ง แต่คราวนี้ ไม่เพียงแต่เรากำลังสร้าง IT รุ่นต่อไป เรากำลังสร้างอุตสาหกรรมใหม่ทั้งหมด"

การเปลี่ยนผ่านนี้แสดงถึงการเปลี่ยนแปลงกระบวนทัศน์การประมวลผลครั้งใหญ่ครั้งที่สาม รองจากการปฏิวัติคอมพิวเตอร์ส่วนบุคคลและยุคอินเทอร์เน็ต/คลาวด์ องค์กรที่รวมความสามารถโครงสร้างพื้นฐาน AI เหล่านี้มีแนวโน้มที่จะสร้างความได้เปรียบทางการแข่งขันที่ไม่สามารถเอาชนะได้ในทุกอุตสาหกรรม

โรงงานสติปัญญาการประมวลผลอยู่ระหว่างการก่อสร้างในวันนี้ คำถามไม่ใช่ว่า AI จะเปลี่ยนธุรกิจหรือไม่—แต่คือว่าองค์กรของคุณกำลังสร้างโครงสร้างพื้นฐานเพื่อรักษาความสามารถในการแข่งขันในโลกที่สติปัญญาการประมวลผลกลายเป็นพื้นฐานของการปฏิบัติงานทางธุรกิจเหมือนไฟฟ้าหรือไม่

อ้างอิงและทรัพยากรเพิ่มเติม

-

ภาพรวมสถาปัตยกรรม Blackwell อย่างเป็นทางการของ NVIDIA: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

-

เอกสารทางเทคนิค NVIDIA MVLink: https://developer.nvidia.com/mvlink

-

แพลตฟอร์ม NVIDIA Omniverse: https://www.nvidia.com/en-us/omniverse/

-

แพลตฟอร์มหุ่นยนต์ Isaac: https://developer.nvidia.com/isaac-ros

-

NVIDIA AI Enterprise: https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

-

เอกสารแถลงข่าวอย่างเป็นทางการ NVIDIA Computex 2025: https://nvidianews.nvidia.com/news/computex-2025

-

ภาพรวมไลบรารี NVIDIA CUDA-X: https://developer.nvidia.com/gpu-accelerated-libraries

-

ระบบ NVIDIA DGX: https://www.nvidia.com/en-us/data-center/dgx-systems/