NVIDIA के CEO Jensen Huang ने Computex 2025 में अपनी विशिष्ट लेदर जैकेट पहनकर मंच पर आए और नए हार्डवेयर और पूर्णतः नए रूप से कल्पित कंप्यूटिंग प्रतिमान का अनावरण किया। इस सेमीकंडक्टर दिग्गज कंपनी ने निर्णायक रूप से एक AI इंफ्रास्ट्रक्चर कंपनी में रूपांतरण कर लिया है, जिसे Huang "बुद्धिमत्ता का इंफ्रास्ट्रक्चर" कहते हैं—बिजली और इंटरनेट के बाद तीसरी प्रमुख इंफ्रास्ट्रक्चर क्रांति की नींव बना रही है।

यह मुख्य भाषण केवल एक और उत्पाद घोषणा नहीं था—यह Jensen द्वारा कंप्यूटिंग परिदृश्य को नया आकार देने के लिए NVIDIA की योजना प्रस्तुत करना था। उन्होंने जो तकनीकी छलांगें, रणनीतिक बदलाव और बाजारी चालें प्रकट कीं, वे संभवतः इसे वह Computex बना देंगी जिसका हम वर्षों तक संदर्भ देंगे। पूरा Computex 2025 Nvidia keynote देखें।

NVIDIA का रणनीतिक विकास: ग्राफिक्स कार्ड्स से इंफ्रास्ट्रक्चर प्रदाता तक

NVIDIA की रूपांतरण की कहानी अविश्वसनीय है। 1993 में, Jensen ने एक "$300 मिलियन चिप अवसर" देखा था—एक महत्वपूर्ण बाजार। आज तक आते-आते, वह एक ट्रिलियन डॉलर AI इंफ्रास्ट्रक्चर दिग्गज का नेतृत्व कर रहे हैं। इस प्रकार की विस्फोटक वृद्धि केवल ऐसे ही नहीं होती—NVIDIA ने रास्ते में कई बार खुद को मूलभूत रूप से पुनर्निर्मित किया है।

अपने मुख्य भाषण के दौरान, Jensen ने उन महत्वपूर्ण मोड़ों को उजागर किया जिन्होंने आज के NVIDIA को संभव बनाया:

-

2006: CUDA का आगमन हुआ और इसने समानांतर कंप्यूटिंग को पूर्णतः बदल दिया। अचानक, वे डेवलपर्स जिन्होंने कभी सामान्य कंप्यूटिंग के लिए GPU का उपयोग करने पर विचार नहीं किया था, वे ऐसे एप्लिकेशन बना रहे थे जो पारंपरिक CPU पर असंभव होते।

-

2016: DGX1 NVIDIA के पहले बिना समझौता, AI-केंद्रित सिस्टम के रूप में उभरा। जो अब लगभग रहस्यमय भविष्यवाणी जैसा लगता है, Jensen ने पहली यूनिट OpenAI को दान कर दी, प्रभावी रूप से उन्हें वह कंप्यूटेशनल नींव दी जो अंततः हमारी वर्तमान AI क्रांति का कारण बनी।

-

2019: Mellanox का अधिग्रहण, जिससे NVIDIA को डेटा सेंटर्स को एकीकृत कंप्यूटिंग यूनिट्स के रूप में पुनर्कल्पित करना संभव हुआ।

यह रूपांतरण NVIDIA की वर्तमान स्थिति में परिणत होता है "एक आवश्यक इंफ्रास्ट्रक्चर कंपनी" के रूप में—एक स्थिति जिसे Huang ने अपने अभूतपूर्व पांच वर्षीय सार्वजनिक रोडमैप को उजागर करके जोर दिया, जो AI तैनाती के लिए वैश्विक इंफ्रास्ट्रक्चर योजना को सक्षम बनाता है।

प्रदर्शन मेट्रिक्स को पुनर्परिभाषित करना: टोकन अर्थव्यवस्था

NVIDIA ने कंप्यूटेशनल आउटपुट को मापने के तरीके में मौलिक बदलाव किया है। FLOPs या ऑपरेशन्स प्रति सेकंड जैसे पारंपरिक मेट्रिक्स के बजाय, Huang ने AI डेटा सेंटर्स को "टोकन्स" उत्पादन करने वाली फैक्ट्रियों के रूप में स्थापित किया—कंप्यूटेशनल बुद्धिमत्ता की इकाइयां:

"कंपनियां बात करना शुरू कर रही हैं कि उन्होंने पिछली तिमाही में कितने टोकन्स बनाए और पिछले महीने कितने टोकन्स बनाए। बहुत जल्द, हम इस बारे में चर्चा करेंगे कि हम हर घंटे कितने टोकन्स बनाते हैं, जैसा कि हर फैक्ट्री करती है।"

यह पुनर्निर्देशन कंप्यूटेशनल निवेश और व्यावसायिक आउटपुट को सीधे जोड़ता है, AI इंफ्रास्ट्रक्चर को पारंपरिक औद्योगिक ढांचों के साथ संरेखित करता है। यह मॉडल NVIDIA को एक नए आर्थिक प्रतिमान के केंद्र में स्थापित करता है जहां कंप्यूटेशनल दक्षता सीधे व्यावसायिक क्षमता में तब्दील होती है।

Blackwell Architecture अपग्रेड: GB300 स्पेसिफिकेशन्स और प्रदर्शन मेट्रिक्स

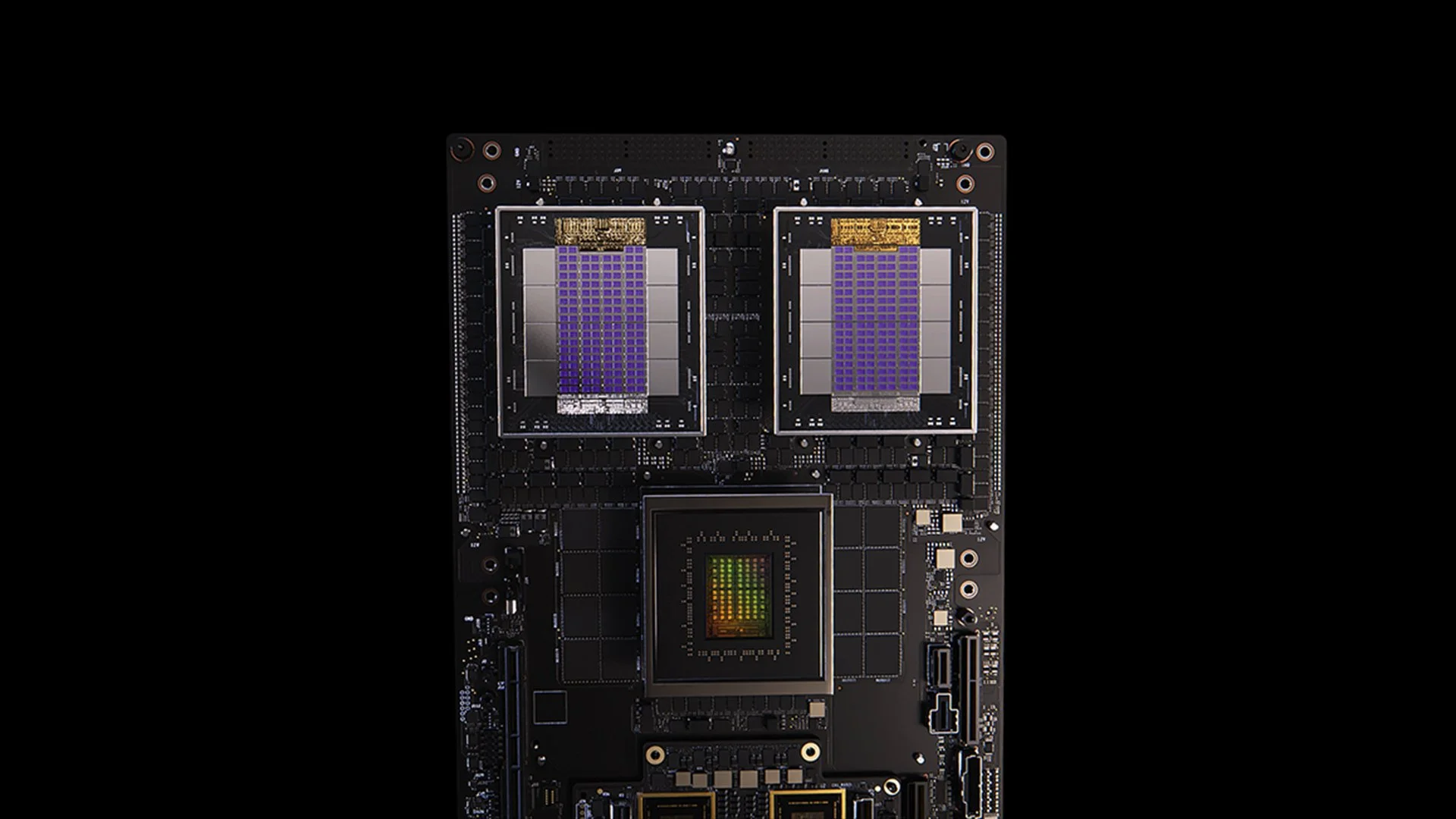

[caption id="" align="alignnone" width="1280"] GB200 system [/caption]

GB200 system [/caption]

Blackwell architecture के GB300 अपडेट NVIDIA के अथक प्रदर्शन सुधार चक्र का उदाहरण है। Q3 2025 के लिए निर्धारित, GB300 प्रदान करता है:

- GB200 से 1.5x inference प्रदर्शन बूस्ट

- 1.5x HBM मेमोरी क्षमता वृद्धि

- 2x नेटवर्किंग बैंडविड्थ सुधार

- पूर्णतः liquid-cooled डिज़ाइन

- मौजूदा chassis और सिस्टम्स के साथ पूर्ण संगतता

प्रत्येक GB300 नोड लगभग 40 petaflops प्रदान करता है—प्रभावी रूप से पूरे Sierra supercomputer (circa 2018) को बदल देता है, जिसमें 18,000 Volta GPU की आवश्यकता थी। छह वर्षों के भीतर यह 4,000x प्रदर्शन लाभ पारंपरिक Moore's Law scaling से कहीं अधिक है, architecture, software, और interconnect नवाचारों के माध्यम से प्रदर्शन त्वरण के लिए NVIDIA के बहुआयामी दृष्टिकोण को प्रदर्शित करता है।

MVLink: Interconnect Technology को पुनर्परिभाषित करना

MVLink, NVLink के परिचय के बाद से GPU interconnect technology में सबसे महत्वपूर्ण प्रगति है। यह सिस्टम पूरे rack में कंप्यूट संसाधनों के पूर्ण विघटन को सक्षम बनाता है, 72 GPU (144 GPU dies) को एक विशाल कंप्यूटेशनल यूनिट में बदल देता है।

तकनीकी विशिष्टताएं चौंकाने वाली हैं:

- व्यक्तिगत MVLink switches: 7.2 TB/s bandwidth

- MVLink spine: 130 TB/s all-to-all bandwidth

- भौतिक कार्यान्वयन: 5,000 सटीक रूप से length-matched coaxial cables (कुल लगभग 2 miles)

- Power density: 120 kilowatts प्रति rack (liquid cooling आवश्यक)

संदर्भ के लिए, Huang ने नोट किया कि पूरे इंटरनेट का peak traffic लगभग 900 terabits प्रति सेकंड (112.5 TB/s) है, जो एक MVLink spine को peak capacity पर वैश्विक इंटरनेट से अधिक traffic संभालने में सक्षम बनाता है।

MVLink Fusion: एक खुले AI Infrastructure Ecosystem का निर्माण

MVLink Fusion संभवतः NVIDIA की वर्षों की सबसे नवाचारी ecosystem रणनीति है। Partners को NVIDIA हार्डवेयर पर पूरी तरह निर्भर होने पर मजबूर करने के बजाय, वे architecture को खोल रहे हैं ताकि कंपनियां अर्द्ध-कस्टम AI सिस्टम बना सकें जो अभी भी NVIDIA universe से जुड़े रहें।

यह दृष्टिकोण आश्चर्यजनक रूप से लचीला है:

-

Custom ASIC Integration: आपका विशेषीकृत accelerator है? कोई समस्या नहीं। Partners अपने custom silicon को NVIDIA के ecosystem से जोड़ने के लिए MVLink chiplets का उपयोग कर सकते हैं। यह ऐसा है जैसे NVIDIA कह रहा हो, "जो भी विशेषीकृत हार्डवेयर आप चाहते हैं बनाएं—बस सुनिश्चित करें कि यह हमारे सिस्टम से बात कर सकता है।"

-

Custom CPU Integration: CPU vendors भी छूटे नहीं हैं। वे सीधे MVLink के chip-to-chip interfaces implement कर सकते हैं, अपने processors और Blackwell GPU (या आगामी Ruben architecture) के बीच सीधा highway बना सकते हैं। MVLink विशिष्ट CPU architectures में निवेशित कंपनियों के लिए महत्वपूर्ण है।

Partner घोषणाएं सेमीकंडक्टर उद्योग में फैली हैं:

- Silicon implementation partners: LCHIP, Astera Labs, Marll, MediaTek

- CPU vendors: Fujitsu, Qualcomm

- EDA providers: Cadence, Synopsis

यह दृष्टिकोण रणनीतिक रूप से NVIDIA को customers के विशिष्ट हार्डवेयर mix की परवाह किए बिना value capture करने की स्थिति में रखता है, जो Huang के स्पष्ट बयान को दर्शाता है: "जब आप NVIDIA से सब कुछ खरीदते हैं तो मुझे इससे अधिक खुशी कुछ नहीं देती। मैं चाहता हूं कि आप लोग यह जानें। लेकिन अगर आप NVIDIA से कुछ खरीदते हैं तो मुझे जबरदस्त खुशी होती है।"

Enterprise AI Deployment: RTX Pro Enterprise और Omniverse Server

RTX Pro Enterprise और Omniverse server NVIDIA की सबसे महत्वपूर्ण enterprise-focused कंप्यूट पेशकश है, जो विशेष रूप से पारंपरिक IT environments में AI क्षमताओं को एकीकृत करने के लिए डिज़ाइन की गई है:

- पूर्णतः x86-compatible architecture

- पारंपरिक hypervisors के लिए समर्थन (VMware, Red Hat, Nanix)

- परिचित workload orchestration के लिए Kubernetes integration

- Blackwell RTX Pro 6000s GPU (8 प्रति server)

- CX8 नेटवर्किंग चिप जो 800 Gb/s bandwidth प्रदान करती है

- Hopper H100 के मुकाबले 1.7x प्रदर्शन उत्थान

- Deepseek R1 जैसे optimized models पर 4x प्रदर्शन

यह सिस्टम AI inference के लिए एक नया प्रदर्शन आवरण स्थापित करता है, throughput (tokens प्रति सेकंड) और responsiveness (tokens प्रति सेकंड प्रति user) के dual-axis ढांचे में मापा जाता है—जो Huang द्वारा "inference time scaling" या "thinking AI" के युग के रूप में वर्णित critical metrics हैं।

AI Data Platform: अनस्ट्रक्चर्ड डेटा के लिए Storage को पुनर्कल्पित करना

NVIDIA का AI Data Platform enterprise storage के लिए मौलिक रूप से अलग दृष्टिकोण प्रस्तुत करता है:

"मनुष्य SQL जैसे structured databases को query करते हैं... लेकिन AI unstructured data को query करना चाहती है। वे semantic चाहते हैं। वे अर्थ चाहते हैं। और इसलिए हमें एक नए प्रकार का storage platform बनाना होगा।"

मुख्य घटकों में शामिल हैं:

- NVIDIA AIQ (या IQ): एक semantic query layer

- पारंपरिक CPU-centric architectures को बदलने वाले GPU-accelerated storage nodes

- पारदर्शी training data provenance के साथ Post-trained AI models

- मौजूदा समाधानों की तुलना में 50% बेहतर परिणामों के साथ 15x तेज querying

इस architecture को implement करने वाले storage industry partners में Dell, Hitachi, IBM, NetApp, और Vast शामिल हैं, जो एक व्यापक enterprise AI data management ecosystem बनाते हैं।

AI Operations और Robotics: Intelligent Enterprise के लिए Software Frameworks

Keynote ने दो महत्वपूर्ण software frameworks प्रस्तुत किए:

-

AI Operations (AIOps): Enterprise contexts में AI agents के प्रबंधन के लिए एक व्यापक stack, जिसमें data curation, model fine-tuning, evaluation, guardrails, और security शामिल है। Partners में Crowdstrike, Data IQ, Data Robots, Elastic, Newonix, Red Hat, और Trend Micro शामिल हैं।

-

Isaac Groot Platform N1.5: एक open-sourced robotics development ecosystem जिसमें शामिल है:

Newton physics engine (Google DeepMind और Disney Research के साथ विकसित)

- Jetson Thor robotics processor

- NVIDIA Isaac operating system

- synthetic trajectory data generation के लिए Groot Dreams blueprint

Robotics पहल एक महत्वपूर्ण चुनौती का समाधान करती है: "Robotics के लिए, आपको AI की आवश्यकता है। लेकिन AI को सिखाने के लिए, आपको AI की आवश्यकता है।" यह recursive optimization pattern सीमित human demonstration data को व्यापक robotics training sets में विस्तारित करने के लिए generative AI का लाभ उठाता है।

AI Manufacturing Revolution में Taiwan की रणनीतिक स्थिति

Keynote का एक महत्वपूर्ण हिस्सा AI technologies के उत्पादन और कार्यान्वयन दोनों में Taiwan की महत्वपूर्ण भूमिका को उजागर करता है:

- Taiwanese manufacturing companies (TSMC, Foxconn, Wistron, Pegatron, Delta Electronics, Quanta, Wiiwin, Gigabyte) digital twin implementations के लिए NVIDIA Omniverse deploy कर रही हैं।

- TSMC fab layouts और piping systems को optimize करने के लिए CUDA पर AI-powered tools का उपयोग कर रहा है

- Manufacturing partners virtual planning और predictive maintenance के लिए digital twins का उपयोग करते हैं और robotic systems को training देने के लिए "robot gyms" के रूप में करते हैं।

- Foxconn, TSMC, Taiwanese government, और NVIDIA Taiwan का पहला large-scale AI supercomputer बना रहे हैं।

Huang ने Taipei में "NVIDIA Constellation," एक नई headquarters facility की योजना की घोषणा करके इस क्षेत्र के प्रति NVIDIA की प्रतिबद्धता को और मजबूत किया।

Technical Analysis: Enterprise AI Strategy के लिए इसका क्या अर्थ है

ये घोषणाएं सामूहिक रूप से enterprise computing की व्यापक पुनर्कल्पना का प्रतिनिधित्व करती हैं जिसके कई रणनीतिक निहितार्थ हैं:

-

Computational Scale Requirements: "reasoning AI" और agentic systems की inference-time प्रदर्शन आवश्यकताएं प्रारंभिक large language model deployments की तुलना में काफी अधिक compute requirements को बढ़ावा देंगी, massive scale-up और scale-out क्षमताओं के लिए architectural planning आवश्यक बनाती हैं।

-

Enterprise AI का Disaggregation: MVLink Fusion ecosystem heterogeneous AI systems बनाने में अभूतपूर्व लचीलापन प्रदान करता है, interconnect technology के माध्यम से NVIDIA की ecosystem में स्थिति बनाए रखते हुए विशेषीकृत AI accelerators के adoption को तेज़ करने की संभावना है।

-

Data Centers से AI Factories में बदलाव: हमें अपने infrastructure investments के मूल्य को मापने के तरीके पर पूर्णतः पुनर्विचार करने की आवश्यकता है। वे दिन गए जब raw compute या storage capacity पूरी कहानी बताती थी। अब यह token production के बारे में है—आपके systems प्रति सेकंड, प्रति watt, और dollar कितनी AI output units generate कर सकते हैं? Jensen मजाक नहीं कर रहे थे जब उन्होंने कहा कि कंपनियां जल्द ही अपनी token production को manufacturing metrics के रूप में report करेंगी। AI factories में बदलाव fundamentally rewrite करेगा कि हम AI infrastructure spending को कैसे deploy और justify करते हैं।

-

Digital Twin Integration: यह तथ्य कि हर प्रमुख Taiwanese manufacturer Omniverse digital twins बना रहा है, हमें सब कुछ बताता है जो हमें जानना चाहिए—यह अब कोई cool tech demo नहीं है। Digital twins optimization के बारे में गंभीर companies के लिए essential infrastructure बन गए हैं। विशेष रूप से दिलचस्प यह है कि यह एक feedback loop कैसे बनाता है: companies physical processes को optimize करने के लिए digital twins बनाती हैं, फिर उन्हीं environments का उपयोग AI और robotics को train करने के लिए करती हैं, physical world को और बेहतर बनाती हैं। यह एक continuous improvement cycle है जो accelerating रहता है।

-

Robotic Workforce Planning: Agentic AI और physical robotics का convergence सुझाता है कि organizations को integrated digital और physical automation strategies विकसित करनी चाहिए, workforce planning और facility design के लिए महत्वपूर्ण निहितार्थों के साथ।

-

Software-Defined Infrastructure: Hardware announcements के बावजूद, libraries और software frameworks पर NVIDIA का निरंतर जोर इस बात को दृढ़ करता है कि AI में competitive advantage raw hardware capabilities के जितना software optimization से आएगा।

AI Factory Transition को Navigate करना

Traditional data centers को AI factories में transform करने के लिए विशेषज्ञ expertise की आवश्यकता होती है जो hardware deployment, software optimization, और architectural design को bridge करती है। Introl में, हम AI-first computing में leap लगाने वाले enterprises के लिए इन advanced GPU infrastructure solutions को implement कर रहे हैं। NVIDIA के ecosystem के साथ हमारी team का गहरा अनुभव—complex MVLink deployments से Omniverse digital twin implementations तक—organizations को cutting-edge infrastructure के साथ आने वाले steep learning curve के बिना इस paradigm shift को navigate करने में मदद करता है। चाहे reasoning AI capabilities को scale up करना हो या अपना पहला AI factory floor बनाना हो, specialists के साथ partnership इस तेजी से evolving landscape में आपके time-to-value को dramatically accelerate कर सकती है। **काम पूरा करने के लिए तैयार हैं? आज ही call set up करें।

निष्कर्ष: Computing का तीसरा युग आ गया है

Computex केवल NVIDIA के तेज़ chips दिखाने के बारे में नहीं था। Jensen ने जो कुछ प्रस्तुत किया, वह सामान्य "पिछले साल से 20% बेहतर" announcements से कहीं आगे निकल गया जिनसे हम सुन्न हो गए हैं। वह fundamentally reframe कर रहे हैं कि computers किसके लिए हैं। हमने दशकों तक ऐसी machines बनाने में बिताए हैं जो numbers crunch करती हैं और data को इधर-उधर move करती हैं। अब, NVIDIA ऐसे systems बना रहा है जो अपने primary output के रूप में intelligence manufacture करते हैं। यह एक filing cabinet और brain की तुलना करने जैसा है। निश्चित रूप से, दोनों information store करते हैं, लेकिन एक बैठा रहता है जबकि दूसरा नए ideas बनाता है। यह बदलाव semantics जैसा लग सकता है जब तक आप realize नहीं करते कि यह computing systems के बनाने, deploy करने, और measure करने के तरीके को बदल देता है।

"हमारे साथ के सारे समय में पहली बार, हम न केवल IT की अगली generation बना रहे हैं, बल्कि हमने यह कई बार किया है, PC से internet से cloud से mobile cloud तक। हमने यह कई बार किया है। लेकिन इस बार, हम न केवल IT की अगली generation बना रहे हैं, बल्कि हम एक पूरी नई industry बना रहे हैं।"

यह transition तीसरे प्रमुख computing paradigm shift का प्रतिनिधित्व करता है, personal computing revolution और internet/cloud era के बाद। Organizations जो इन AI infrastructure capabilities को integrate करती हैं, वे संभवतः industries में insurmountable competitive advantages स्थापित करेंगी।

Computational intelligence की factories आज construction में हैं। सवाल अब यह नहीं है कि क्या AI business को transform करेगा—सवाल यह है कि क्या आपका organization उस दुनिया में competitive रहने के लिए infrastructure बना रहा है जहां computational intelligence business operations के लिए electricity जितनी ही fundamental हो जाएगी।

References और Additional Resources

-

NVIDIA Official Blackwell Architecture Overview: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

-

NVIDIA MVLink Technical Documentation: https://developer.nvidia.com/mvlink

-

NVIDIA Omniverse Platform: https://www.nvidia.com/en-us/omniverse/

-

Isaac Robotics Platform: https://developer.nvidia.com/isaac-ros

-

NVIDIA AI Enterprise: https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

-

NVIDIA Computex 2025 Official Press Materials: https://nvidianews.nvidia.com/news/computex-2025

-

NVIDIA CUDA-X Libraries Overview: https://developer.nvidia.com/gpu-accelerated-libraries

-

NVIDIA DGX Systems: https://www.nvidia.com/en-us/data-center/dgx-systems/