NVIDIA CEO Jensen Huang身穿标志性皮夹克在Computex 2025上登台,发布了全新硬件和完全重新构想的计算范式。这家半导体巨头已决定性地转型为AI基础设施公司,为Huang所称的"智能基础设施"奠定基础——这是继电力和互联网之后的第三次重大基础设施革命。

这次主题演讲不仅仅是又一次产品发布会——它是Jensen为重塑计算格局而制定的NVIDIA蓝图。他所披露的技术飞跃、战略转向和市场布局很可能使这届Computex成为我们未来多年将要参考的标杆。观看完整Computex 2025 Nvidia主题演讲。

NVIDIA的战略演进:从显卡到基础设施提供商

NVIDIA的转型故事令人震撼。1993年,Jensen看到了一个"3亿美元芯片机遇"——那是个巨大的市场。快进到今天,他正在掌控一个价值万亿美元的AI基础设施巨头。这种爆炸性增长不是偶然发生的——NVIDIA在这一过程中多次从根本上重新发明了自己。

在主题演讲中,Jensen强调了造就今天NVIDIA的转折点:

-

2006年:CUDA面世,彻底颠覆了并行计算。突然间,从未考虑过将GPU用于通用计算的开发者开始构建在传统CPU上不可能实现的应用程序。

-

2016年:DGX1作为NVIDIA首个不妥协的专注AI系统问世。在现在看来几乎有些诡异的预言中,Jensen将第一台设备捐赠给了OpenAI,有效地为他们提供了最终引领当前AI革命的计算基础。

-

2019年:收购Mellanox,使NVIDIA能够将数据中心重新构思为统一计算单元

这一转型的顶点是NVIDIA目前作为"关键基础设施公司"的地位——Huang通过强调其前所未有的五年公开路线图来强调这一地位,这使得全球AI部署的基础设施规划成为可能。

重新定义性能指标:Token经济

NVIDIA引入了衡量计算输出方式的根本转变。Huang将AI数据中心定位为生产"token"——计算智能单位的工厂,而不是传统的FLOPs或每秒操作数等指标:

"公司开始谈论他们上个季度产生了多少token,上个月产生了多少token。很快,我们将讨论每小时产生多少token,就像每个工厂一样。"

这种重新框架直接连接了计算投资和业务产出,将AI基础设施与传统工业框架保持一致。该模型将NVIDIA定位在新经济范式的中心,在这里计算效率直接转化为业务能力。

Blackwell架构升级:GB300规格和性能指标

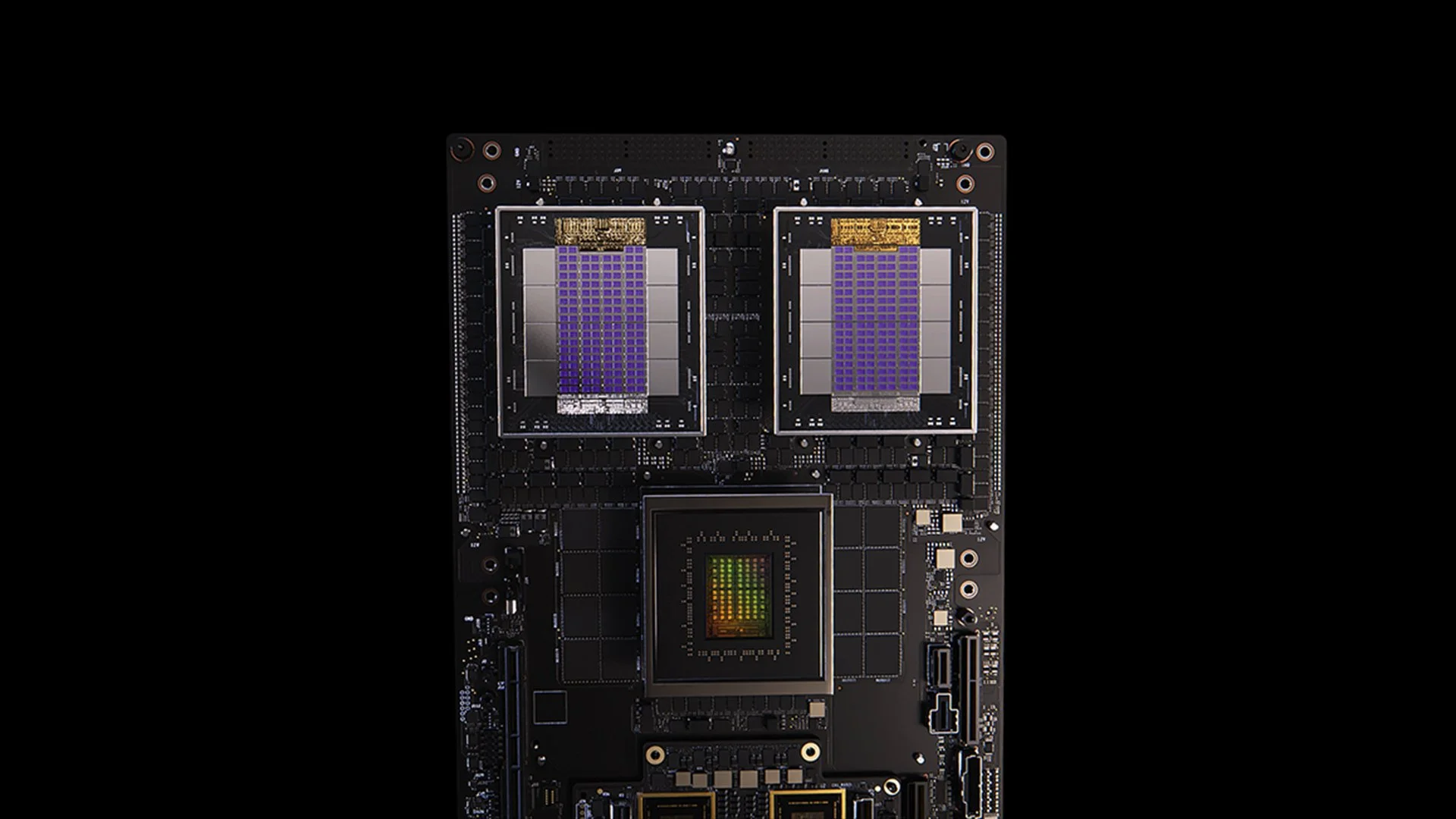

[caption id="" align="alignnone" width="1280"] GB200系统[/caption]

GB200系统[/caption]

GB300对Blackwell架构的更新体现了NVIDIA不懈的性能提升周期。计划于2025年第三季度发布,GB300提供:

- 相比GB200推理性能提升1.5倍

- HBM内存容量增加1.5倍

- 网络带宽提升2倍

- 全液冷设计

- 与现有机箱和系统完全向后兼容

每个GB300节点提供约40 petaflops——有效地替代了整个Sierra超级计算机(约2018年),该超级计算机需要18,000个Volta GPU。这种六年内4,000倍的性能提升远远超过了传统摩尔定律的扩展,展示了NVIDIA通过架构、软件和互连创新实现性能加速的多方面方法。

MVLink:重新定义互连技术

MVLink代表了自NVLink推出以来GPU互连技术最重要的进步。该系统实现了整个机架计算资源的完全解耦,将72个GPU(144个GPU芯片)转变为单一庞大的计算单元。

技术规格令人震撼:

- 单个MVLink交换机:7.2 TB/s带宽

- MVLink主干:130 TB/s全对全带宽

- 物理实现:5,000根精确长度匹配的同轴电缆(总长度约2英里)

- 功率密度:每机架120千瓦(需要液冷)

作为对比,Huang指出整个互联网的峰值流量约为每秒900太比特(112.5 TB/s),使单个MVLink主干能够处理超过全球互联网峰值容量的流量。

MVLink Fusion:创建开放AI基础设施生态系统

MVLink Fusion可能是NVIDIA多年来最创新的生态系统布局。他们没有强迫合作伙伴完全采用NVIDIA硬件,而是开放架构,让公司能够构建仍然与NVIDIA生态系统相连的半定制AI系统。

这种方法出人意料地灵活:

-

定制ASIC集成:有专门的加速器?没问题。合作伙伴可以采用MVLink芯片组来将他们的定制硅连接到NVIDIA生态系统。这就像NVIDIA在说:"构建任何你想要的专门硬件——只要确保它能与我们的产品通信。"

-

定制CPU集成:CPU厂商也没有被排除在外。他们可以直接实现MVLink的芯片到芯片接口,在他们的处理器和Blackwell GPU(或即将推出的Ruben架构)之间创建直接高速通道。MVLink对投资特定CPU架构的公司来说意义重大。

合作伙伴公告涵盖整个半导体行业:

- 硅实现合作伙伴:LCHIP、Astera Labs、Marll、MediaTek

- CPU厂商:Fujitsu、Qualcomm

- EDA提供商:Cadence、Synopsis

这种方法战略性地定位NVIDIA,无论客户部署何种特定硬件组合都能获取价值,反映了Huang坦率的声明:"当你从NVIDIA购买一切时,没有什么比这更让我高兴的了。我想让你们知道这一点。但如果你从NVIDIA购买某些东西,这也会给我带来巨大的快乐。"

企业AI部署:RTX Pro Enterprise和Omniverse Server

RTX Pro Enterprise和Omniverse服务器代表NVIDIA最重要的企业级计算产品,专门设计用于将AI能力集成到传统IT环境中:

- 完全x86兼容架构

- 支持传统虚拟机管理程序(VMware、Red Hat、Nanix)

- Kubernetes集成,提供熟悉的工作负载编排

- Blackwell RTX Pro 6000s GPU(每台服务器8个)

- CX8网络芯片提供800 Gb/s带宽

- 相比Hopper H100性能提升1.7倍

- 在Deepseek R1等优化模型上性能提升4倍

该系统为AI推理建立了新的性能包络,在吞吐量(每秒token数)和响应性(每用户每秒token数)的双轴框架中测量——这是Huang所描述的"推理时间扩展"或"思考AI"时代的关键指标。

AI数据平台:为非结构化数据重新构想存储

NVIDIA的AI数据平台引入了企业存储的根本不同方法:

"人类查询结构化数据库如SQL...但AI想要查询非结构化数据。他们想要语义。他们想要意义。因此我们必须创建新型存储平台。"

关键组件包括:

- NVIDIA AIQ(或IQ):语义查询层

- GPU加速存储节点替代传统的以CPU为中心的架构

- 具有透明训练数据来源的后训练AI模型

- 相比现有解决方案查询速度提升15倍,结果改善50%

实施此架构的存储行业合作伙伴包括Dell、Hitachi、IBM、NetApp和Vast,创建了全面的企业AI数据管理生态系统。

AI运维和机器人:智能企业的软件框架

主题演讲介绍了两个关键软件框架:

-

AI运维(AIOps):用于在企业环境中管理AI代理的综合堆栈,包括数据管理、模型微调、评估、护栏和安全。合作伙伴包括Crowdstrike、Data IQ、Data Robots、Elastic、Newonix、Red Hat和Trend Micro。

-

Isaac Groot平台N1.5:开源机器人开发生态系统,包括:

- Newton物理引擎(与Google DeepMind和Disney Research共同开发)

- Jetson Thor机器人处理器

- NVIDIA Isaac操作系统

- Groot Dreams合成轨迹数据生成蓝图

机器人倡议解决了一个关键挑战:"机器人的实现需要AI。但要教会AI,你需要AI。"这种递归优化模式利用生成式AI将有限的人类演示数据扩展为全面的机器人训练集。

台湾在AI制造革命中的战略地位

主题演讲的很大一部分强调了台湾在生产和实施AI技术方面的关键作用:

- 台湾制造公司(TSMC、Foxconn、Wistron、Pegatron、Delta Electronics、Quanta、Wiiwin、Gigabyte)正在部署NVIDIA Omniverse进行数字孪生实施。

- TSMC正在使用基于CUDA的AI驱动工具来优化晶圆厂布局和管道系统

- 制造合作伙伴使用数字孪生进行虚拟规划和预测性维护,并作为训练机器人系统的"机器人训练场"。

- Foxconn、TSMC、台湾政府和NVIDIA正在建设台湾首个大规模AI超级计算机。

Huang通过宣布在台北建立"NVIDIA Constellation"新总部设施的计划,进一步巩固了NVIDIA对该地区的承诺。

技术分析:这对企业AI战略意味着什么

这些公告共同代表了企业计算的全面重新构想,具有几个战略含义:

-

计算规模要求:"推理AI"和代理系统的推理时间性能需求将驱动比最初大语言模型部署显著更高的计算要求,需要大规模扩展和横向扩展能力的架构规划。

-

企业AI的解耦:MVLink Fusion生态系统在构建异构AI系统方面实现了前所未有的灵活性,可能会加速专用AI加速器的采用,同时通过互连技术维持NVIDIA在生态系统中的地位。

-

从数据中心到AI工厂的转变:我们需要完全重新思考如何衡量基础设施投资的价值。原始计算或存储容量能说明全部情况的日子已经过去了。现在一切都关于token生产——你的系统每秒、每瓦特、每美元能产生多少AI输出单位?Jensen说公司很快就会报告他们的token生产时不是在开玩笑,这如同制造指标一样。向AI工厂的转变将从根本上重写我们部署和证明AI基础设施支出的经济学。

-

数字孪生集成:每个主要台湾制造商都在构建Omniverse数字孪生这一事实告诉我们一切——这不再只是酷炫的技术演示。数字孪生已成为认真优化的公司的基础设施。特别有趣的是这如何创造反馈循环:公司构建数字孪生来优化物理过程,然后使用相同环境来训练AI和机器人,进一步改善物理世界。这是一个不断加速的持续改进循环。

-

机器人劳动力规划:代理AI和物理机器人的融合表明组织应该制定综合的数字和物理自动化策略,对劳动力规划和设施设计具有重大影响。

-

软件定义基础设施:尽管有硬件公告,NVIDIA对库和软件框架的持续强调强化了AI竞争优势将来自软件优化,就像原始硬件能力一样重要。

导航AI工厂转型

将传统数据中心转型为AI工厂需要桥接硬件部署、软件优化和架构设计的专业知识。在Introl,我们一直在为跃入AI优先计算的企业实施这些先进的GPU基础设施解决方案。我们团队在NVIDIA生态系统方面的深度经验——从复杂的MVLink部署到Omniverse数字孪生实施——帮助组织在没有通常与前沿基础设施相关的陡峭学习曲线的情况下导航这种范式转变。无论是扩展推理AI能力还是构建您的第一个AI工厂,与专家合作都能显著加速您在这个快速发展景观中的价值实现时间。准备好**完成任务?立即安排通话。

结论:计算的第三个时代已经到来

Computex不仅仅是NVIDIA展示更快芯片。Jensen所阐述的远远超过了我们已经麻木的常见"比去年好20%"的公告。他从根本上重新框架了计算机的用途。我们花了几十年构建处理数字和移动数据的机器。现在,NVIDIA正在构建以制造智能作为主要输出的系统。这就像比较文件柜和大脑。当然,两者都存储信息,但一个只是坐在那里,而另一个创造新想法。这种转变可能听起来像语义学,直到你意识到它改变了我们构建、部署和衡量计算系统的一切。

"在我们共同度过的所有时间里,这是第一次,我们不仅在创造下一代IT,我们已经做过几次了,从PC到互联网到云到移动云。我们做过几次。但这次,我们不仅在创造下一代IT,我们正在创造一个全新的行业。"

这种转型代表了继个人计算革命和互联网/云时代之后的第三次重大计算范式转变。整合这些AI基础设施能力的组织很可能在各个行业中建立不可逾越的竞争优势。

计算智能工厂今天正在建设中。问题不再是AI是否会改变商业——而是你的组织是否在构建基础设施以在计算智能变得像电力一样成为商业运营基础的世界中保持竞争力。

参考资料和其他资源

-

NVIDIA官方Blackwell架构概述:https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

-

NVIDIA MVLink技术文档:https://developer.nvidia.com/mvlink

-

NVIDIA Omniverse平台:https://www.nvidia.com/en-us/omniverse/

-

Isaac机器人平台:https://developer.nvidia.com/isaac-ros

-

NVIDIA AI Enterprise:https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

-

NVIDIA Computex 2025官方新闻材料:https://nvidianews.nvidia.com/news/computex-2025

-

NVIDIA CUDA-X库概述:https://developer.nvidia.com/gpu-accelerated-libraries

-

NVIDIA DGX系统:https://www.nvidia.com/en-us/data-center/dgx-systems/