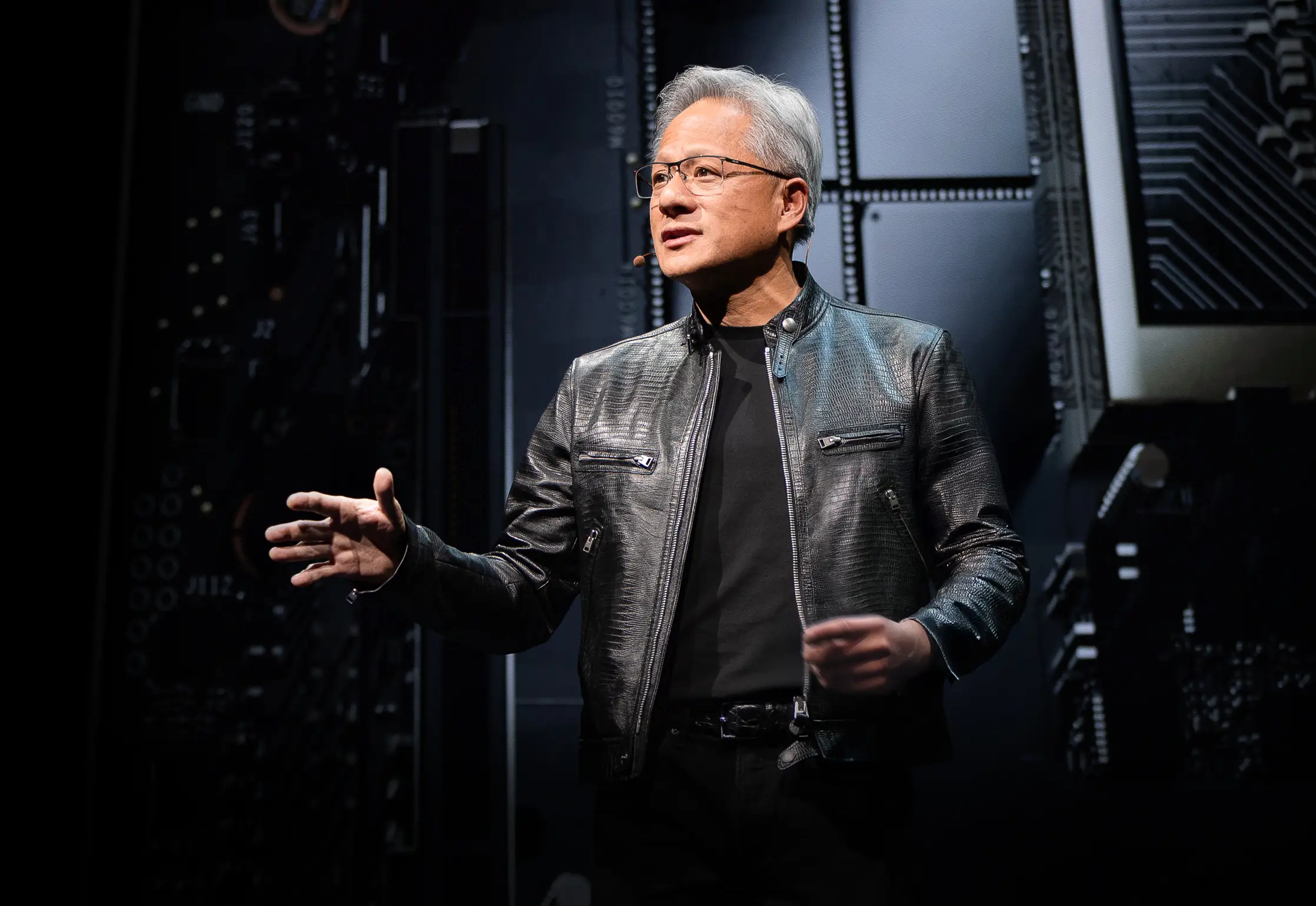

صعد الرئيس التنفيذي لشركة NVIDIA جينسن هوانغ إلى المنصة في معرض Computex 2025 مرتدياً سترته الجلدية المميزة وكشف عن أجهزة جديدة ونموذج حوسبي مُعاد تصوره بالكامل. لقد تحولت عملاقة أشباه الموصلات بشكل حاسم إلى شركة بنية تحتية للذكاء الاصطناعي، حيث تبني أسس ما يسميه هوانغ "البنية التحتية للذكاء" - الثورة الثالثة الكبرى في البنية التحتية بعد الكهرباء والإنترنت.

لم يكن هذا الخطاب الرئيسي مجرد إعلان منتج آخر - بل كان جينسن يضع مخطط NVIDIA لإعادة تشكيل المشهد الحاسوبي. القفزات التقنية والتحولات الاستراتيجية واللعبات السوقية التي كشف عنها ستجعل على الأرجح من هذا معرض Computex الذي سنعود للإشارة إليه لسنوات قادمة. شاهد الخطاب الرئيسي الكامل لـ Nvidia في Computex 2025.

التطور الاستراتيجي لـ NVIDIA: من بطاقات الرسوميات إلى مزود البنية التحتية

قصة تحول NVIDIA مذهلة. في عام 1993، رأى جينسن "فرصة شريحة بقيمة 300 مليون دولار" - سوق كبير. والآن، بعد التقدم السريع إلى اليوم، يقود عملاق بنية تحتية AI بتريليون دولار. هذا النوع من النمو المتفجر لا يحدث فقط - فقد أعادت NVIDIA اختراع نفسها جوهرياً عدة مرات على طول الطريق.

خلال خطابه الرئيسي، أبرز جينسن نقاط التحول التي جعلت NVIDIA اليوم ممكنة:

-

2006: وصلت CUDA وقلبت الحوسبة المتوازية رأساً على عقب. فجأة، أصبح المطورون الذين لم يفكروا أبداً في استخدام GPUs للحوسبة العامة يبنون تطبيقات كان من المستحيل تحقيقها على CPUs التقليدية.

-

2016: ظهر DGX1 كأول نظام لـ NVIDIA بدون تنازلات ومركز على AI. فيما يبدو الآن كتنبؤ مخيف تقريباً، تبرع جينسن بالوحدة الأولى لـ OpenAI، مما أعطاهم فعلياً الأساس الحاسوبي الذي أدى في النهاية إلى ثورة AI الحالية.

-

2019: استحواذ Mellanox، مما مكّن NVIDIA من إعادة تصور مراكز البيانات كوحدات حاسوبية موحدة

يتوج هذا التحول بموقع NVIDIA الحالي كـ "شركة بنية تحتية أساسية" - وهو وضع أكده هوانغ بتسليط الضوء على خرائط الطريق العامة غير المسبوقة لخمس سنوات، والتي تمكن التخطيط العالمي للبنية التحتية لنشر AI.

إعادة تعريف مقاييس الأداء: اقتصاد الرموز المميزة

قدمت NVIDIA تحولاً جوهرياً في كيفية قياسنا للإخراج الحاسوبي. بدلاً من المقاييس التقليدية مثل FLOPs أو العمليات في الثانية، وضع هوانغ مراكز بيانات AI كمصانع تنتج "رموز مميزة" - وحدات من الذكاء الحاسوبي:

"بدأت الشركات تتحدث عن كم رمز مميز أنتجوا الربع الماضي وكم رمز مميز أنتجوا الشهر الماضي. قريباً جداً، سنناقش كم رمز مميز ننتج كل ساعة، تماماً كما يفعل كل مصنع."

هذا الإطار الجديد يربط مباشرة الاستثمار الحاسوبي بالإخراج التجاري، محاذياً بنية AI التحتية مع الأطر الصناعية التقليدية. يضع النموذج NVIDIA في مركز نموذج اقتصادي جديد حيث تترجم الكفاءة الحاسوبية مباشرة إلى قدرة تجارية.

ترقيات معمارية Blackwell: مواصفات GB300 ومقاييس الأداء

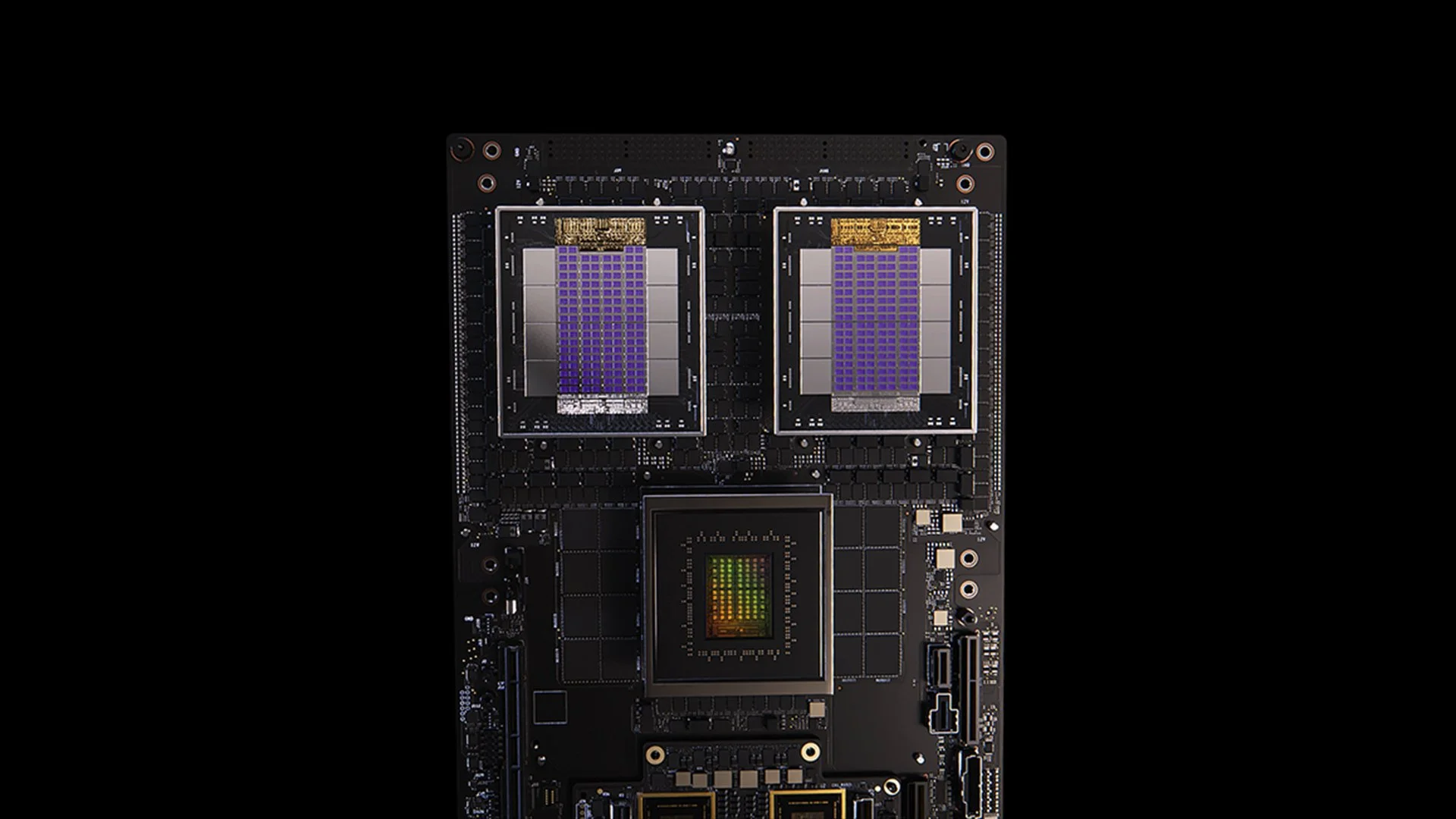

[caption id="" align="alignnone" width="1280"] نظام GB200[/caption]

نظام GB200[/caption]

تجسد ترقية GB300 لمعمارية Blackwell دورة تحسين الأداء المستمرة لـ NVIDIA. مجدولة للربع الثالث من 2025، تقدم GB300:

-

تحسن أداء الاستدلال بـ 1.5x مقارنة بـ GB200

-

زيادة سعة ذاكرة HBM بـ 1.5x

-

تحسن عرض نطاق الشبكة بـ 2x

-

تصميم مبرد بالسائل بالكامل

-

متوافقة مع الخلف مع الهياكل والأنظمة الحالية

تقدم كل عقدة GB300 حوالي 40 بيتافلوب - فعلياً تحل محل حاسوب Sierra الفائق بالكامل (حوالي 2018)، والذي تطلب 18,000 من GPUs فولتا. هذا التحسن في الأداء بـ 4,000x خلال ست سنوات يفوق بكثير قياس قانون مور التقليدي، مظهراً نهج NVIDIA متعدد الجوانب لتسريع الأداء من خلال المعمارية والبرمجيات وابتكارات الربط البيني.

MVLink: إعادة تعريف تقنية الربط البيني

يمثل MVLink أهم تقدم في تقنية الربط البيني لـ GPU منذ إدخال NVLink. يمكن النظام من الفصل الكامل لموارد الحوسبة عبر رف كامل، محولاً 72 GPU (144 شريحة GPU) إلى وحدة حاسوبية ضخمة واحدة.

المواصفات التقنية مذهلة:

-

مفاتيح MVLink الفردية: عرض نطاق 7.2 TB/s

-

العمود الفقري لـ MVLink: عرض نطاق شامل 130 TB/s

-

التنفيذ الفيزيائي: 5,000 كابل محوري مطابق الطول بدقة (حوالي 2 ميل إجمالي)

-

كثافة الطاقة: 120 كيلوواط لكل رف (يتطلب التبريد السائل)

للسياق، أشار هوانغ أن ذروة حركة مرور الإنترنت بالكامل هي حوالي 900 تيرابت في الثانية (112.5 TB/s)، مما يجعل عمود MVLink الفقري الواحد قادر على التعامل مع حركة مرور أكثر من الإنترنت العالمي في ذروة السعة.

MVLink Fusion: إنشاء نظام بيئي مفتوح لبنية AI التحتية

قد يكون MVLink Fusion أكثر لعبة نظام بيئي مبتكرة قامت بها NVIDIA في سنوات. بدلاً من إجبار الشركاء على الاستثمار الكامل في أجهزة NVIDIA، يفتحون المعمارية للسماح للشركات ببناء أنظمة AI شبه مخصصة ما زالت ترتبط بعالم NVIDIA.

النهج مرن بشكل مدهش:

-

تكامل ASIC مخصص: لديك المسرع المتخصص؟ لا مشكلة. يمكن للشركاء إدراج شرائح MVLink لربط السيليكون المخصص بنظام NVIDIA البيئي. إنه مثل NVIDIA تقول، "ابن أي أجهزة متخصصة تريد - فقط تأكد من أنها تستطيع التحدث مع أشيائنا."

-

تكامل CPU مخصص: بائعو CPU غير مستبعدين أيضاً. يمكنهم تنفيذ واجهات شريحة إلى شريحة MVLink مباشرة، إنشاء طريق سريع مباشر بين معالجاتهم وGPUs Blackwell (أو معمارية Ruben القادمة). MVLink ضخم للشركات المستثمرة في معماريات CPU محددة.

إعلانات الشركاء تمتد عبر صناعة أشباه الموصلات:

-

شركاء تنفيذ السيليكون: LCHIP، Astera Labs، Marll، MediaTek

-

بائعو CPU: Fujitsu، Qualcomm

-

مزودو EDA: Cadence، Synopsis

يضع هذا النهج NVIDIA استراتيجياً لالتقاط القيمة بغض النظر عن خليط الأجهزة المحدد الذي ينشره العملاء، مما يعكس تصريح هوانغ الصريح: "لا شيء يمنحني فرحة أكثر من عندما تشترون كل شيء من NVIDIA. أريدكم يا رفاق أن تعرفوا ذلك. ولكن يمنحني فرحة هائلة إذا اشتريتم شيئاً من NVIDIA."

نشر AI المؤسسي: RTX Pro Enterprise و Omniverse Server

يمثل RTX Pro Enterprise وخادم Omniverse أهم عرض حاسوبي مركز على المؤسسات من NVIDIA، مصمم خصيصاً لدمج قدرات AI في بيئات IT التقليدية:

-

معمارية متوافقة تماماً مع x86

-

دعم للمشرفين التقليديين (VMware، Red Hat، Nanix)

-

تكامل Kubernetes لتنسيق أحمال العمل المألوف

-

GPUs Blackwell RTX Pro 6000s (8 لكل خادم)

-

شريحة شبكة CX8 توفر عرض نطاق 800 Gb/s

-

تحسن أداء بـ 1.7x مقابل Hopper H100

-

أداء 4x على النماذج المحسنة مثل Deepseek R1

يؤسس النظام مغلف أداء جديد لاستدلال AI، مقاس في إطار محور مزدوج من الإنتاجية (رموز مميزة في الثانية) والاستجابة (رموز مميزة في الثانية لكل مستخدم) - مقاييس حرجة لما يصفه هوانغ بعصر "قياس وقت الاستدلال" أو "AI المفكر".

منصة بيانات AI: إعادة تخيل التخزين للبيانات غير المنظمة

تقدم منصة بيانات AI من NVIDIA نهجاً مختلفاً جوهرياً لتخزين المؤسسات:

"البشر يستعلمون قواعد البيانات المنظمة مثل SQL... لكن AI يريد الاستعلام عن البيانات غير المنظمة. يريدون الدلالة. يريدون المعنى. لذا علينا إنشاء نوع جديد من منصة التخزين."

المكونات الرئيسية تشمل:

-

NVIDIA AIQ (أو IQ): طبقة استعلام دلالية

-

عقد تخزين مسرعة بـ GPU تحل محل معماريات مركزة على CPU التقليدية

-

نماذج AI مدربة لاحقاً مع نسب بيانات التدريب الشفافة

-

استعلام أسرع بـ 15x مع تحسن النتائج بـ 50% مقارنة بالحلول الحالية

شركاء صناعة التخزين التي تنفذ هذه المعمارية تشمل Dell، Hitachi، IBM، NetApp، و Vast، مما ينشئ نظام بيئي شامل لإدارة بيانات AI المؤسسية.

عمليات AI والروبوتات: أطر برمجية للمؤسسة الذكية

قدم الخطاب الرئيسي إطارين برمجيين حاسمين:

-

عمليات AI (AIOps): مجموعة شاملة لإدارة وكلاء AI في السياقات المؤسسية، تشمل تنظيم البيانات، وضبط النماذج، التقييم، الضمانات، والأمان. الشركاء يشملون Crowdstrike، Data IQ، Data Robots، Elastic، Newonix، Red Hat، و Trend Micro.

-

منصة Isaac Groot N1.5: نظام بيئي مفتوح المصدر لتطوير الروبوتات يشمل:

محرك فيزياء Newton (مطور مع Google DeepMind و Disney Research)

-

معالج روبوتات Jetson Thor

-

نظام تشغيل NVIDIA Isaac

-

مخطط Groot Dreams لتوليد بيانات المسار الاصطناعي

تتناول مبادرة الروبوتات تحدٍ حرج: "لحدوث الروبوتات، تحتاج AI. ولكن لتعليم AI، تحتاج AI." هذا النمط التحسيني المتكرر يستغل AI التوليدي لتوسيع بيانات العرض البشري المحدودة إلى مجموعات تدريب روبوتات شاملة.

الموقع الاستراتيجي لتايوان في ثورة تصنيع AI

خصص جزء كبير من الخطاب الرئيسي لإبراز دور تايوان المحوري في إنتاج وتنفيذ تقنيات AI:

-

شركات التصنيع التايوانية (TSMC، Foxconn، Wistron، Pegatron، Delta Electronics، Quanta، Wiiwin، Gigabyte) تنشر NVIDIA Omniverse لتنفيذ التوأم الرقمي.

-

TSMC تستخدم أدوات مدعومة بـ AI على CUDA لتحسين تخطيطات المصنع وأنظمة الأنابيب

-

شركاء التصنيع يستخدمون التوائم الرقمية للتخطيط الافتراضي والصيانة التنبؤية وكـ "صالات رياضية للروبوتات" لتدريب الأنظمة الروبوتية.

-

Foxconn، TSMC، الحكومة التايوانية، و NVIDIA تبني أول حاسوب فائق AI واسع النطاق في تايوان.

عزز هوانغ التزام NVIDIA بالمنطقة أكثر بإعلان خطط لـ "NVIDIA Constellation"، منشأة مقر جديد في تايبيه.

التحليل التقني: ما يعنيه هذا لاستراتيجية AI المؤسسية

هذه الإعلانات مجتمعة تمثل إعادة تصور شاملة للحوسبة المؤسسية مع عدة تداعيات استراتيجية:

-

متطلبات النطاق الحاسوبي: متطلبات أداء وقت الاستدلال لـ "AI المنطقي" والأنظمة الوكيلة ستدفع متطلبات حاسوبية أعلى بكثير من نشر نماذج اللغة الكبيرة الأولية، مما يتطلب تخطيط معماري لقدرات توسع هائلة للأعلى والخارج.

-

تفكيك AI المؤسسي: نظام MVLink Fusion البيئي يمكّن من مرونة غير مسبوقة في بناء أنظمة AI متجانسة، مما يحتمل تسريع اعتماد مسرعات AI المتخصصة مع الحفاظ على موقع NVIDIA في النظام البيئي من خلال تقنية الربط البيني.

-

التحول من مراكز البيانات إلى مصانع AI: نحتاج إلى إعادة تفكير كامل في كيفية قياس قيمة استثمارات البنية التحتية. ولت أيام عندما كانت سعة الحوسبة أو التخزين الخام تحكي القصة كاملة. الآن الأمر كله حول إنتاج الرموز المميزة - كم وحدة من إخراج AI يمكن لأنظمتك توليدها لكل ثانية، لكل واط، ودولار؟ لم يكن جينسن يمزح عندما قال أن الشركات ستبلغ قريباً عن إنتاج رموزها المميزة، مثل مقاييس التصنيع. التحول إلى مصانع AI سيعيد كتابة اقتصاديات كيفية نشر وتبرير إنفاق بنية AI التحتية جوهرياً.

-

تكامل التوأم الرقمي: حقيقة أن كل مصنع تايواني رئيسي يبني توائم رقمية Omniverse تخبرنا بكل ما نحتاج معرفته - هذا لم يعد مجرد عرض تقني رائع بعد الآن. أصبحت التوائم الرقمية بنية تحتية أساسية للشركات الجادة حول التحسين. ما هو رائع بشكل خاص كيف ينشئ هذا حلقة تغذية راجعة: الشركات تبني توائم رقمية لتحسين العمليات الفيزيائية، ثم تستخدم نفس البيئات لتدريب AI والروبوتات، محسنة العالم الفيزيائي أكثر. إنها دورة تحسين مستمر تستمر في التسارع.

-

تخطيط القوى العاملة الروبوتية: تقارب AI الوكيل والروبوتات الفيزيائية يقترح أن المنظمات يجب أن تطور استراتيجيات أتمتة رقمية وفيزيائية متكاملة، مع تداعيات كبيرة لتخطيط القوى العاملة وتصميم المنشآت.

-

البنية التحتية المعرفة بالبرمجيات: رغم إعلانات الأجهزة، التأكيد المستمر لـ NVIDIA على المكتبات وأطر البرمجيات يعزز أن الميزة التنافسية في AI ستأتي من تحسين البرمجيات بقدر ما تأتي من قدرات الأجهزة الخام.

التنقل في انتقال مصنع AI

تحويل مراكز البيانات التقليدية إلى مصانع AI يتطلب خبرة متخصصة تجسر نشر الأجهزة، تحسين البرمجيات، والتصميم المعماري. في Introl، كنا ننفذ هذه حلول بنية GPU التحتية المتقدمة للمؤسسات القافزة إلى الحوسبة الأولى بـ AI. خبرة فريقنا العميقة مع نظام NVIDIA البيئي - من نشر MVLink المعقد إلى تنفيذ التوأم الرقمي Omniverse - تساعد المنظمات على التنقل في هذا التحول النموذجي دون منحنى التعلم الحاد المرتبط عادة بالبنية التحتية المتطورة. سواء توسيع قدرات AI المنطقي أو بناء أول أرضية مصنع AI، الشراكة مع المتخصصين يمكن أن تسرع بشكل كبير وقتك للقيمة في هذا المشهد المتطور بسرعة. مستعد لـ **إنجاز الأمر؟ حدد مكالمة اليوم.

الخلاصة: العصر الثالث للحوسبة قد وصل

لم يكن Computex مجرد NVIDIA تظهر شرائح أسرع. ما وضعه جينسن تجاوز إعلانات "أفضل بـ 20% من العام الماضي" المعتادة التي أصبحنا نشعر بالخدر تجاهها. يعيد تأطير ما الحاسوبات من أجله جوهرياً. أمضينا عقود في بناء آلات تطحن الأرقام وتنقل البيانات. الآن، NVIDIA تبني أنظمة تصنع الذكاء كإخراجها الأساسي. إنه مثل مقارنة خزانة ملفات بدماغ. بالتأكيد، كلاهما يخزن المعلومات، لكن واحد يجلس هناك بينما الآخر ينشئ أفكار جديدة. التحول قد يبدو مثل دلالات حتى تدرك أنه يغير كل شيء حول كيفية بناء، نشر، وقياس أنظمة الحوسبة.

"لأول مرة في كل وقتنا معاً، ليس فقط ننشئ الجيل التالي من IT، لكننا فعلنا ذلك عدة مرات، من PC إلى الإنترنت إلى السحابة إلى السحابة المحمولة. فعلنا ذلك عدة مرات. لكن هذه المرة، ليس فقط ننشئ الجيل التالي من IT، ننشئ صناعة جديدة كاملة."

يمثل هذا الانتقال التحول النموذجي الحاسوبي الثالث الرئيسي، بعد ثورة الحوسبة الشخصية وعصر الإنترنت/السحابة. المنظمات التي تدمج قدرات بنية AI التحتية هذه ستؤسس على الأرجح مزايا تنافسية لا يمكن التغلب عليها عبر الصناعات.

مصانع الذكاء الحاسوبي تحت الإنشاء اليوم. السؤال لم يعد ما إذا كان AI سيحول الأعمال - بل ما إذا كانت منظمتك تبني البنية التحتية للبقاء تنافسية في عالم حيث يصبح الذكاء الحاسوبي أساسياً لعمليات الأعمال مثل الكهرباء.

المراجع والموارد الإضافية

-

نظرة عامة رسمية على معمارية Blackwell من NVIDIA: https://www.nvidia.com/en-us/data-center/technologies/blackwell-architecture/

-

الوثائق التقنية لـ NVIDIA MVLink: https://developer.nvidia.com/mvlink

-

منصة NVIDIA Omniverse: https://www.nvidia.com/en-us/omniverse/

-

منصة Isaac للروبوتات: https://developer.nvidia.com/isaac-ros

-

NVIDIA AI Enterprise: https://www.nvidia.com/en-us/data-center/products/ai-enterprise/

-

المواد الصحفية الرسمية لـ NVIDIA Computex 2025: https://nvidianews.nvidia.com/news/computex-2025

-

نظرة عامة على مكتبات NVIDIA CUDA-X: https://developer.nvidia.com/gpu-accelerated-libraries

-

أنظمة NVIDIA DGX: https://www.nvidia.com/en-us/data-center/dgx-systems/