为什么AI数据中心与两年前相比已经面目全非

NVIDIA的功率平滑技术将电网需求降低30%。液冷系统可处理1,600W GPU。明智的公司看到350% ROI,而其他公司面临80%的失败率。

关于 GPU 基础设施、AI 和数据中心的深度洞察。

NVIDIA的功率平滑技术将电网需求降低30%。液冷系统可处理1,600W GPU。明智的公司看到350% ROI,而其他公司面临80%的失败率。

随着AI工作负载将机架密度推至100千瓦以上,数据中心必须掌握用于数据流的结构化布线和用于散热的液冷技术。了解如何设计能够让GPU保持峰值性能运行的基础设施。

数据中心为我们的数字世界提供动力,但消耗大量资源。了解可持续设计的成熟策略——从液体冷却和节水到智能选址和绿色建设——既能降低成本又能实现ESG目标。

英伟达的GB300 NVL72采用72个Blackwell Ultra GPU,每个GPU配备288 GB内存,NVLink带宽达130 TB/s,AI性能比GB200提升1.5倍。以下是部署工程师需要了解的关于这些120千瓦AI数据中心机柜的电力、冷却和布线信息。

AI热潮正在推动对数据中心基础设施前所未有的需求,但超过一半的运营商面临着威胁产能增长的严重人员短缺。Introl的劳动力即服务模式在数天内——而非数月——提供认证技术人员,使超大规模站点能够以最快速度启动。

当您的50,000 GPU集群在新加坡时间凌晨3点崩溃时,4小时响应和24小时响应之间的差异相当于数月的研究损失。了解Introl的257个全球站点如何将地理覆盖转化为AI基础设施部署的竞争优势。

NVIDIA的H100、H200和B200 GPU各自满足不同的AI基础设施需求——从久经考验的H100主力产品到内存丰富的H200,再到突破性的B200。我们分析真实世界的性能、成本和功耗要求,帮助您为特定工作负载和预算选择合适的GPU

了解预测性故障分析和远程技术支持合同如何帮助企业每小时节省高达50万美元的宕机成本。通过详细案例研究发现保护AI和HPC投资的ROI策略,展示20%的回报率。

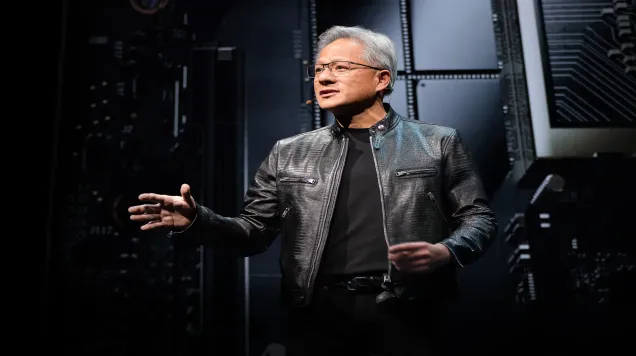

NVIDIA首席执行官黄仁勋在Computex 2025上的主题演讲不仅仅是又一次产品发布——这是计算领域第三次重大革命的蓝图。随着数据中心转型为生产token的"AI工厂",NVIDIA在网络、企业AI和机器人技术方面的最新创新正在为未来奠定基础

停用HPC数据中心不仅仅是拔掉服务器电源那么简单——这是一项需要手术般精确操作和军事级规划的高风险作业。从清理关键任务数据到提取价值超过豪华汽车的组件,本指南将带您了解整个停用流程

运营国际网络基础设施?你正在玩一场高风险的监管扑克游戏,每个国家都在使用不同的牌组。这份务实的指南帮你理清跨境合规要求的混乱局面,为网络架构师提供经过实战检验的策略

随着AI在全球范围内推动数据中心需求达到前所未有的水平,创新的"绿色互换"概念为平衡技术进步与气候目标提供了解决方案。这一突破性的金融工具可能会改变资本流向发展中经济体清洁能源项目的方式,创

告诉我们您的项目需求,我们将在72小时内回复。

感谢您的咨询。我们的团队将审核您的请求并在72小时内回复。